GPUX

Vue d'ensemble de GPUX

Qu'est-ce que GPUX ?

GPUX est une plateforme d'inférence serverless GPU de pointe conçue spécifiquement pour les charges de travail d'IA et d'apprentissage automatique. La plateforme révolutionne la façon dont les développeurs et les organisations déploient et exécutent des modèles d'IA en offrant des temps de démarrage à froid sans précédent de 1 seconde, ce qui la rend idéale pour les environnements de production où la vitesse et la réactivité sont critiques.

Comment fonctionne GPUX ?

Infrastructure Serverless GPU

GPUX fonctionne sur une architecture serverless qui élimine le besoin pour les utilisateurs de gérer l'infrastructure sous-jacente. La plateforme provisionne automatiquement les ressources GPU à la demande, évoluant de manière transparente pour gérer des charges de travail variables sans intervention manuelle.

Technologie d'Optimisation du Démarrage à Froid

L'exploitation révolutionnaire de la plateforme est sa capacité à atteindre des démarrages à froid de 1 seconde à partir d'un état complètement inactif. Ceci est particulièrement significatif pour les charges de travail d'inférence IA qui souffraient traditionnellement de temps d'initialisation longs.

Capacités P2P

GPUX intègre une technologie peer-to-peer qui permet aux organisations de partager et monétiser de manière sécurisée leurs modèles d'IA privés. Cette fonctionnalité permet aux propriétaires de modèles de vendre des requêtes d'inférence à d'autres organisations tout en conservant un contrôle total sur leur propriété intellectuelle.

Fonctionnalités et Capacités Principales

⚡ Inférence Ultra-Rapide

- Démarrages à froid de 1 seconde depuis un état complètement inactif

- Performance optimisée pour les modèles d'IA populaires

- Temps de réponse à faible latence pour les charges de travail de production

🎯 Modèles d'IA Supportés

GPUX supporte actuellement plusieurs modèles d'IA leaders incluant :

- StableDiffusion et StableDiffusionXL pour la génération d'images

- ESRGAN pour la super-résolution et l'amélioration d'images

- AlpacaLLM pour le traitement du langage naturel

- Whisper pour la reconnaissance et la transcription vocale

🔧 Fonctionnalités Techniques

- Volumes Lecture/Écriture pour le stockage persistant de données

- Partage de Modèles P2P pour la distribution sécurisée de modèles

- Accès API basé sur curl pour une intégration facile

- Compatibilité multiplateforme (Windows 10, Linux OS)

Références de Performance

La plateforme a démontré des améliorations de performance remarquables, rendant notamment StableDiffusionXL 50% plus rapide sur matériel RTX 4090. Cette optimisation montre la capacité de GPUX à extraire les performances maximales des ressources matérielles disponibles.

Comment utiliser GPUX ?

Intégration API Simple

Les utilisateurs peuvent accéder aux capacités de GPUX via des commandes curl simples :

curl https://i.gpux.ai/gpux/sdxl?prompt=sword

Cette approche directe élimine les procédures de configuration complexes et permet une intégration rapide dans les workflows existants.

Options de Déploiement

- Application Web accès via la plateforme GPUX

- Disponibilité GitHub pour les développeurs cherchant des composants open-source

- Support multiplateforme pour divers environnements opérationnels

Public Cible et Cas d'Usage

Utilisateurs Principaux

- Chercheurs en IA ayant besoin d'un déploiement rapide de modèles

- Startups nécessitant des ressources GPU rentables

- Entreprises cherchant à monétiser des modèles d'IA propriétaires

- Développeurs recherchant une infrastructure d'inférence IA simplifiée

Applications Idéales

- Génération et manipulation d'images en temps réel

- Services de transcription parole-texte

- Applications de traitement du langage naturel

- Prototypage de recherche et développement

- Services d'IA de production nécessitant une inférence fiable

Pourquoi choisir GPUX ?

Avantages Compétitifs

- Performance de démarrage à froid incomparable - initialisation de 1 seconde

- Architecture serverless - aucune gestion d'infrastructure requise

- Opportunités de monétisation - capacités de partage de modèles P2P

- Optimisation matérielle - utilisation GPU maximisée

- Convivial pour les développeurs - intégration API simple

Valeur Business

GPUX aborde le défi fondamental de l'allocation des ressources GPU pour les charges de travail d'IA, un peu comme comment les chaussures spécialisées abordent les différences anatomiques. La plateforme fournit "la bonne taille" pour les charges de travail d'apprentissage automatique, garantissant une performance optimale et une efficacité des coûts.

Contexte de l'Entreprise

GPUX Inc. a son siège à Toronto, Canada, avec une équipe distribuée incluant :

- Annie - Marketing basée à Krakow

- Ivan - Technologie basé à Toronto

- Henry - Opérations basé à Hefei

L'entreprise maintient un blog actif couvrant des sujets techniques incluant la technologie IA, des études de cas, des guides pratiques et des notes de version.

Pour Commencer

Les utilisateurs peuvent accéder à GPUX via plusieurs canaux :

- Application web (V2 actuellement disponible)

- Dépôt GitHub pour les composants open-source

- Contact direct avec l'équipe fondatrice

La plateforme continue d'évoluer, avec des mises à jour régulières et des améliorations de performance documentées à travers leurs notes de version et publications techniques de blog.

Outils de Recherche et de Papiers en IA Outils d'Apprentissage Machine et Profond Jeux de Données et API d'IA Entraînement et Déploiement de Modèles IA

Meilleurs outils alternatifs à "GPUX"

Baseten est une plateforme pour déployer et mettre à l'échelle des modèles d'IA en production. Il offre des runtimes de modèles performants, une haute disponibilité inter-cloud et des flux de travail de développeur transparents, alimentés par Baseten Inference Stack.

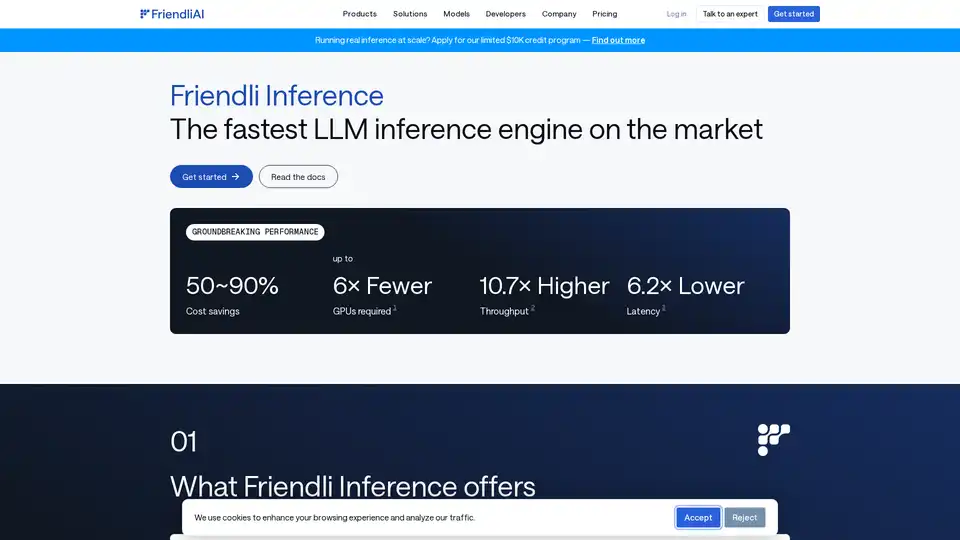

Friendli Inference est le moteur d'inférence LLM le plus rapide, optimisé pour la vitesse et la rentabilité, réduisant les coûts GPU de 50 à 90 % tout en offrant un débit élevé et une faible latence.

Cirrascale AI Innovation Cloud accélère le développement de l'IA, la formation et les charges de travail d'inférence. Testez et déployez sur les principaux accélérateurs d'IA avec un débit élevé et une faible latence.

Explorez les API NVIDIA NIM pour l'inférence optimisée et le déploiement des principaux modèles d'IA. Créez des applications d'IA générative d'entreprise avec des API sans serveur ou un auto-hébergement sur votre infrastructure GPU.