Baseten

Vue d'ensemble de Baseten

Qu'est-ce que Baseten ?

Baseten est une plateforme conçue pour simplifier le déploiement et la mise à l'échelle des modèles d'AI en production. Elle fournit l'infrastructure, les outils et l'expertise nécessaires pour commercialiser rapidement les produits d'AI.

Comment fonctionne Baseten ?

La plateforme de Baseten est construite autour de la Baseten Inference Stack, qui comprend une recherche de pointe en matière de performances, une infrastructure native du cloud et une expérience de développeur conçue pour l'inférence.

Voici une ventilation des principaux composants :

- Model APIs: Testez rapidement de nouvelles charges de travail, des prototypes de produits et évaluez les derniers modèles avec des performances de niveau production.

- Training on Baseten: Entraînez des modèles à l'aide d'une infrastructure optimisée pour l'inférence sans restrictions ni surcharge.

- Applied Performance Research: Utilisez des noyaux personnalisés, des techniques de décodage et une mise en cache avancée pour optimiser les performances des modèles.

- Cloud-Native Infrastructure: Mettez à l'échelle les charges de travail sur n'importe quelle région et cloud (Baseten Cloud ou le vôtre), avec des démarrages à froid rapides et une disponibilité élevée.

- Developer Experience (DevEx): Déployez, optimisez et gérez des modèles et des solutions d'AI composées grâce à une expérience de développeur prête pour la production.

Principales caractéristiques et avantages

- Dedicated Deployments: Conçu pour les charges de travail à grande échelle, vous permettant de servir des modèles d'AI open source, personnalisés et affinés sur une infrastructure conçue pour la production.

- Multi-Cloud Capacity Management: Exécutez des charges de travail sur Baseten Cloud, en auto-hébergement ou en flex à la demande. La plateforme est compatible avec n'importe quel fournisseur de cloud.

- Custom Model Deployment: Déployez n'importe quel modèle personnalisé ou propriétaire avec des optimisations de performances prêtes à l'emploi.

- Support for Gen AI: Optimisations de performances personnalisées adaptées aux applications Gen AI.

- Model Library: Explorez et déployez facilement des modèles prédéfinis.

Applications spécifiques

Baseten s'adresse à un éventail d'applications d'AI, notamment :

- Image Generation: Servez des modèles personnalisés ou des flux de travail ComfyUI, affinez-les pour votre cas d'utilisation ou déployez n'importe quel modèle open source en quelques minutes.

- Transcription: Utilise un modèle Whisper personnalisé pour une transcription rapide, précise et rentable.

- Text-to-Speech: Prend en charge la diffusion audio en temps réel pour les appels téléphoniques AI à faible latence, les agents vocaux, la traduction, etc.

- Large Language Models (LLMs): Obtenez un débit plus élevé et une latence plus faible pour les modèles tels que DeepSeek, Llama et Qwen avec Dedicated Deployments.

- Embeddings: Offre Baseten Embeddings Inference (BEI) avec un débit plus élevé et une latence plus faible par rapport aux autres solutions.

- Compound AI: Permet un matériel granulaire et une mise à l'échelle automatique pour l'AI composée, améliorant l'utilisation du GPU et réduisant la latence.

Pourquoi choisir Baseten ?

Voici plusieurs raisons pour lesquelles Baseten se distingue :

- Performance: Infrastructure optimisée pour des temps d'inférence rapides.

- Scalability: Mise à l'échelle transparente dans le cloud de Baseten ou le vôtre.

- Developer Experience: Outils et flux de travail conçus pour les environnements de production.

- Flexibility: Prend en charge divers modèles, y compris les modèles open source, personnalisés et affinés.

- Cost-Effectiveness: Optimise l'utilisation des ressources pour réduire les coûts.

À qui s'adresse Baseten ?

Baseten est idéal pour :

- Machine Learning Engineers: Rationalisez le déploiement et la gestion des modèles.

- AI Product Teams: Accélérez la mise sur le marché des produits d'AI.

- Companies: À la recherche d'une infrastructure d'AI évolutive et fiable.

Témoignages de clients

- Nathan Sobo, Co-founder : Baseten a fourni la meilleure expérience possible aux utilisateurs et à l'entreprise.

- Sahaj Garg, Co-founder et CTO : A gagné beaucoup de contrôle sur le pipeline d'inférence et a optimisé chaque étape avec l'équipe de Baseten.

- Lily Clifford, Co-founder et CEO : La latence et la disponibilité de pointe de Rime sont le fruit d'une attention commune aux fondamentaux avec Baseten.

- Isaiah Granet, CEO et Co-founder : A permis d'atteindre des chiffres de revenus insensés sans se soucier des GPU et de la mise à l'échelle.

- Waseem Alshikh, CTO et Co-founder de Writer : A obtenu un service de modèles rentable et performant pour les LLM personnalisés sans surcharger les équipes d'ingénierie internes.

Baseten fournit une solution complète pour le déploiement et la mise à l'échelle des modèles d'AI en production, offrant des performances élevées, une flexibilité et une expérience de développeur conviviale. Que vous travailliez avec la génération d'images, la transcription, les LLM ou les modèles personnalisés, Baseten vise à rationaliser l'ensemble du processus.

Outils de Recherche et de Papiers en IA Outils d'Apprentissage Machine et Profond Jeux de Données et API d'IA Entraînement et Déploiement de Modèles IA

Meilleurs outils alternatifs à "Baseten"

Cloudflare Workers AI vous permet d’exécuter des tâches d’inférence d’IA sans serveur sur des modèles d’apprentissage automatique pré-entraînés sur le réseau mondial de Cloudflare, offrant une variété de modèles et une intégration transparente avec d’autres services Cloudflare.

GPUX est une plateforme d'inférence GPU sans serveur permettant des démarrages à froid en 1 seconde pour des modèles IA comme StableDiffusionXL, ESRGAN et AlpacaLLM avec des performances optimisées et des capacités P2P.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.

BrainHost VPS propose des serveurs virtuels KVM haute performance avec stockage NVMe, idéal pour l'inférence IA, les sites web et le e-commerce. Provisionnement en 30s à Hong Kong et US West pour un accès global fiable.

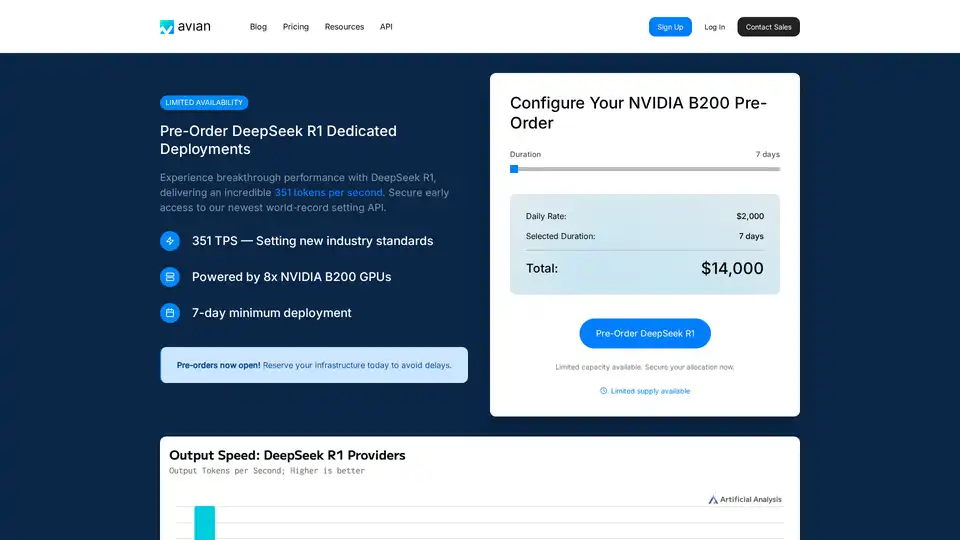

Avian API offre l’inférence d’IA la plus rapide pour les LLM open source, atteignant 351 TPS sur DeepSeek R1. Déployez n’importe quel LLM HuggingFace à une vitesse 3 à 10 fois supérieure grâce à une API compatible OpenAI. Performances et confidentialité de niveau entreprise.