Friendli Inference

Vue d'ensemble de Friendli Inference

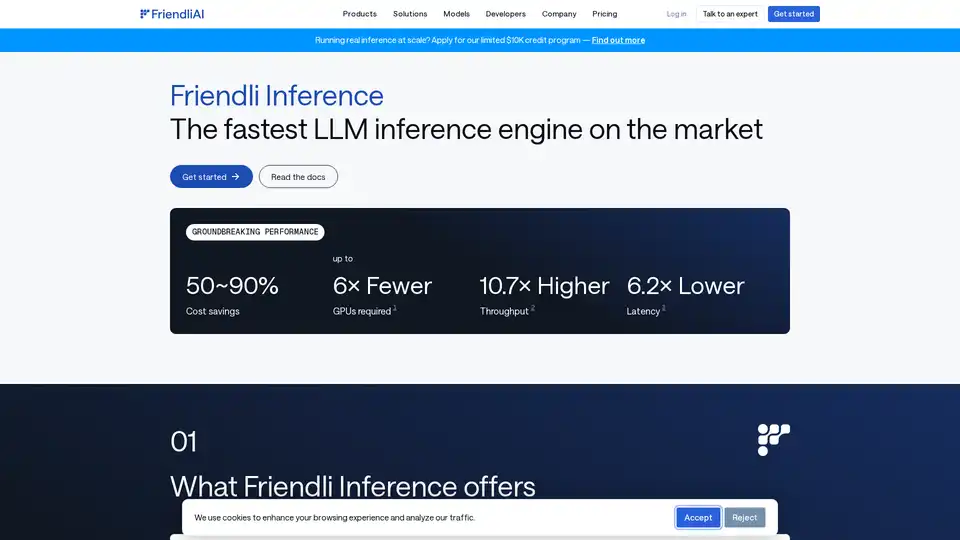

Friendli Inference : Le moteur d’inférence LLM le plus rapide

Qu’est-ce que Friendli Inference ?

Friendli Inference est un moteur hautement optimisé conçu pour accélérer le service des grands modèles linguistiques (LLM), réduisant considérablement les coûts de 50 à 90 %. Il s’impose comme le moteur d’inférence LLM le plus rapide du marché, surpassant vLLM et TensorRT-LLM lors des tests de performance.

Comment fonctionne Friendli Inference ?

Friendli Inference atteint ses performances remarquables grâce à plusieurs technologies clés :

- Batching d’itération: Cette technologie de batching innovante gère efficacement les requêtes de génération simultanées, atteignant un débit d’inférence LLM jusqu’à dix fois supérieur à celui du batching conventionnel tout en maintenant les mêmes exigences de latence. Elle est protégée par des brevets aux États-Unis, en Corée et en Chine.

- Bibliothèque DNN: La bibliothèque DNN Friendli comprend un ensemble de noyaux GPU optimisés spécialement conçus pour l’IA générative. Cette bibliothèque permet une inférence LLM plus rapide pour différentes formes de tenseurs et types de données, prend en charge la quantification, Mixture of Experts (MoE) et les adaptateurs LoRA.

- Friendli TCache: Ce système de mise en cache intelligent identifie et stocke les résultats de calcul fréquemment utilisés, réduisant la charge de travail sur les GPU en exploitant les résultats mis en cache.

- Décodage spéculatif: Friendli Inference prend en charge nativement le décodage spéculatif, une technique d’optimisation qui accélère l’inférence LLM/LMM en faisant des suppositions éclairées sur les jetons futurs en parallèle tout en générant le jeton actuel. Cela garantit des sorties de modèle identiques en une fraction du temps d’inférence.

Principales caractéristiques et avantages

- Réduction significative des coûts: Réduisez les coûts de service LLM de 50 à 90 %.

- Service multi-LoRA: Prend en charge simultanément plusieurs modèles LoRA sur moins de GPU, même un seul GPU.

- Prise en charge étendue des modèles: Prend en charge une large gamme de modèles d’IA générative, y compris les modèles quantifiés et MoE.

- Performances révolutionnaires:

- Jusqu’à 6 fois moins de GPU nécessaires.

- Jusqu’à 10,7 fois plus de débit.

- Jusqu’à 6,2 fois moins de latence.

Points forts

- Exécution de Mixtral 8x7B quantifié sur un seul GPU: Friendli Inference peut exécuter un modèle Mixtral-7x8B-instruct v0.1 quantifié sur un seul GPU NVIDIA A100 80 Go, atteignant un temps de réponse au moins 4,1 fois plus rapide et un débit de jetons de 3,8x à 23,8x supérieur à celui d’un système vLLM de base.

- Llama 2 70B quantifié sur un seul GPU: Exécutez en toute transparence les LLM AWQ, tels que Llama 2 70B 4 bits, sur un seul GPU A100 80 Go, permettant un déploiement LLM efficace et des gains d’efficacité remarquables sans sacrifier la précision.

- TTFT encore plus rapide avec Friendli TCache: Friendli TCache optimise le délai d’affichage du premier jeton (TTFT) en réutilisant les calculs récurrents, offrant un TTFT 11,3x à 23x plus rapide par rapport à vLLM.

Comment utiliser Friendli Inference

Friendli Inference offre trois façons d’exécuter des modèles d’IA générative :

- Points de terminaison dédiés Friendli: Créez et exécutez des modèles d’IA générative en pilote automatique.

- Conteneur Friendli: Diffusez les inférences LLM et LMM avec Friendli Inference dans votre environnement privé.

- Points de terminaison sans serveur Friendli: Appelez l’API rapide et abordable pour les modèles d’IA générative open source.

Pourquoi choisir Friendli Inference ?

Friendli Inference est la solution idéale pour les organisations qui cherchent à optimiser les performances et la rentabilité de leurs charges de travail d’inférence LLM. Ses technologies innovantes et sa large gamme de fonctionnalités en font un outil puissant pour le déploiement et la mise à l’échelle de modèles d’IA générative.

À qui s’adresse Friendli Inference ?

Friendli Inference convient aux :

- Entreprises déployant de grands modèles linguistiques.

- Chercheurs travaillant avec l’IA générative.

- Développeurs créant des applications basées sur l’IA.

Quelle est la meilleure façon d’optimiser l’inférence LLM ?

La meilleure façon d’optimiser l’inférence LLM est d’utiliser Friendli Inference, qui offre des économies de coûts importantes, un débit élevé et une faible latence par rapport aux autres solutions.

Assistant de Programmation par IA Complétion Automatique de Code Révision et Optimisation du Code par IA Développement Low-Code et No-Code par IA

Meilleurs outils alternatifs à "Friendli Inference"

Xander est une plateforme de bureau open source qui permet l'entraînement de modèles IA sans code. Décrivez les tâches en langage naturel pour des pipelines automatisés en classification de texte, analyse d'images et fine-tuning LLM, assurant la confidentialité et les performances sur votre machine locale.

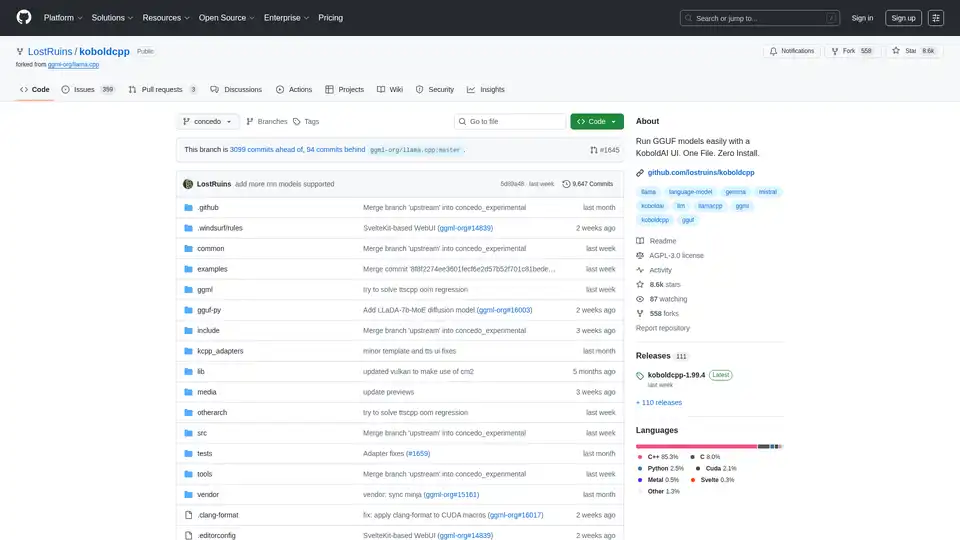

KoboldCpp : Exécutez facilement des modèles GGUF pour la génération de texte et d'images IA avec une interface utilisateur KoboldAI. Fichier unique, installation zéro. Prend en charge CPU/GPU, STT, TTS et Stable Diffusion.

LM Studio est une application de bureau conviviale pour exécuter et télécharger localement des grands modèles de langage (LLM) open source comme LLaMa et Gemma. Elle offre une interface de chat intégrée et un serveur compatible OpenAI pour une interaction IA hors ligne, rendant l'IA accessible sans compétences en programmation.

Nebius est une plateforme cloud IA conçue pour démocratiser l'infrastructure IA, offrant une architecture flexible, des performances testées et une valeur à long terme avec des GPU NVIDIA et des clusters optimisés pour l'entraînement et l'inférence.