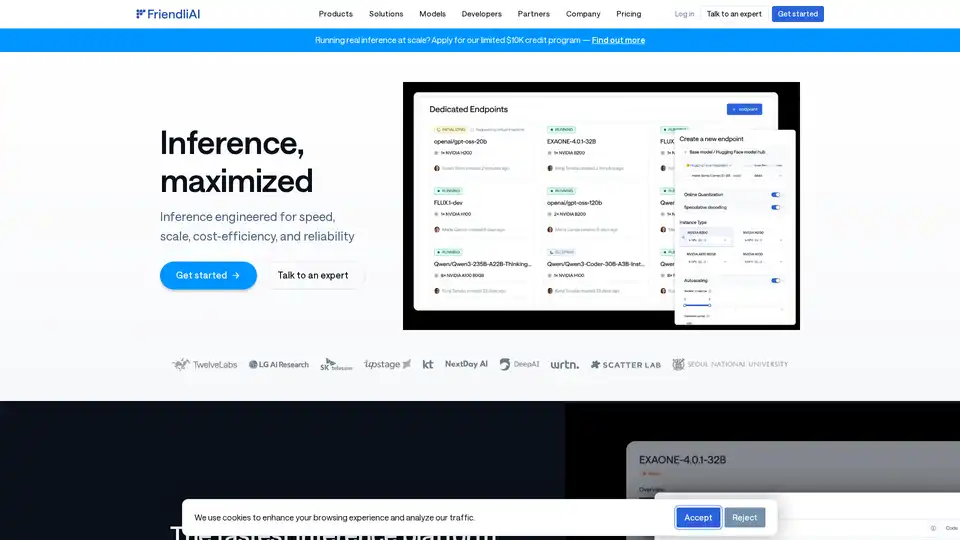

FriendliAI 概述

FriendliAI: 生成式AI基础设施公司

FriendliAI 是一家专注于生成式AI基础设施的公司,提供一个为AI推理的速度、规模、成本效益和可靠性而设计的平台。 它的目标是最大限度地提高AI模型的性能,为希望大规模部署AI的企业提供解决方案。

什么是 FriendliAI?

FriendliAI 是一个旨在提供快速可靠的AI模型部署的推理平台。它通过提供一个专门构建的堆栈而脱颖而出,该堆栈提供 2 倍以上的更快推理,将模型级别的突破与基础设施级别的优化相结合。

FriendliAI 如何工作?

FriendliAI 通过以下几个关键特性实现高性能:

- 自定义 GPU 内核: 优化AI模型在 GPU 上的执行。

- 智能缓存: 有效地存储和检索常用数据。

- 连续批处理: 将多个请求分组在一起以提高吞吐量。

- 推测解码: 通过预测下一个token来加速文本生成。

- 并行推理: 将工作负载分配到多个 GPU 上。

- 高级缓存: 进一步增强缓存机制,以实现更快的数据访问。

- 多云扩展: 支持跨不同云提供商进行扩展,以实现灵活性和冗余。

主要特性和优势

- 高速: 降低延迟,以提供竞争优势。

- 有保障的可靠性: 通过异地分布式基础设施提供 99.99% 的正常运行时间 SLA。

- 成本效益: 通过优化 GPU 使用率实现显著的成本节约。

- 可扩展性: 在丰富的 GPU 资源中无缝扩展。

- 易于使用: 支持一键部署 459,400+ Hugging Face 模型。

- 自定义模型支持: 允许用户携带他们自己微调的或专有的模型。

为什么选择 FriendliAI?

- 无与伦比的吞吐量: 提供高吞吐量,用于处理大量数据。

- 超低延迟: 确保实时应用程序的快速响应时间。

- 全球可用性: 在全球区域提供可靠的性能。

- 企业级容错能力: 确保AI通过流量高峰保持在线和响应。

- 内置监控和合规性: 提供监控工具和符合法规的架构。

FriendliAI 适用于谁?

FriendliAI 适用于:

- 扩展AI应用程序的企业。

- 部署AI模型的开发者。

- 寻求具有成本效益的AI推理的组织。

- 需要可靠AI性能的企业。

如何使用 FriendliAI?

要开始使用 FriendliAI:

- 注册: 在 FriendliAI 平台上创建一个帐户。

- 部署模型: 从 459,400+ Hugging Face 模型中选择一个或携带您自己的模型。

- 配置设置: 调整用于扩展和性能的设置。

- 监控性能: 使用内置监控工具跟踪正常运行时间和延迟。

实际价值和用例

FriendliAI 支持各种各样的模型,从语言到音频和视觉。 列出的示例模型包括:

- Llama-3.2-11B-Vision (Meta)

- whisper-small-wolof (M9and2M)

- Qwen2.5-VL-7B-Instruct-Android-Control (OfficerChul)

- 跨不同模态的更多模型

这些模型突出了 FriendliAI 平台在处理各种类型的AI任务中的多样适用性。

坚如磐石的可靠性和成本节约

用户报告了显著的收益:

- 自定义模型 API 在大约一天内启动,并具有内置监控。

- Token 处理扩展到数万亿,使用的 GPU 减少了 50%。

- 由于自动缩放,可以毫不担心地处理波动的流量。

结论

FriendliAI 为AI推理提供了一个全面的解决方案,专注于速度、可靠性和成本效益。 它的平台支持各种各样的模型,并提供大规模部署AI所需的工具,使其成为希望有效利用AI技术的企业的宝贵资源。

"FriendliAI"的最佳替代工具

GPUX是一个无服务器GPU推理平台,可为StableDiffusionXL、ESRGAN和AlpacaLLM等AI模型实现1秒冷启动,具有优化的性能和P2P功能。

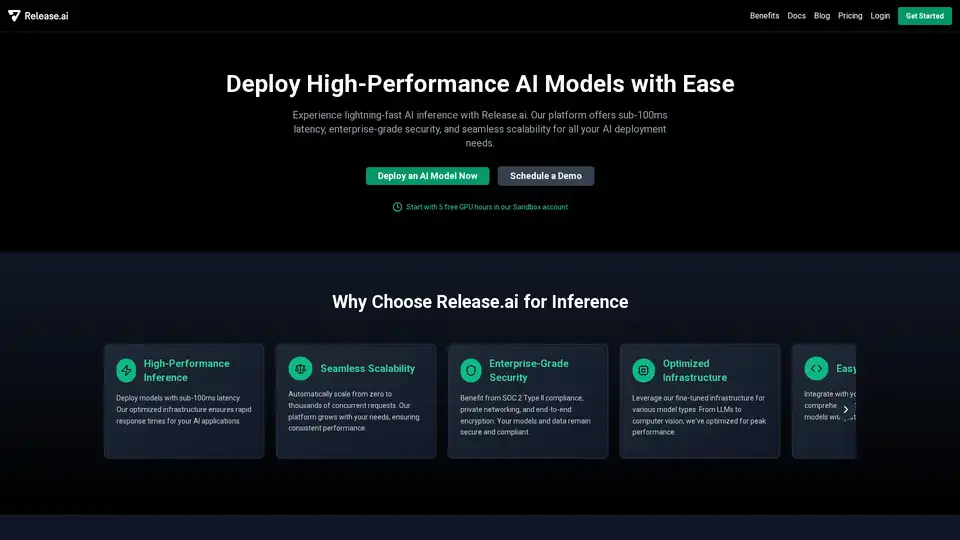

Release.ai简化了AI模型部署,具有低于100毫秒的延迟、企业级安全性以及无缝可扩展性。在几分钟内部署生产就绪的AI模型,并通过实时监控优化性能。

Nebius 是一个旨在普及 AI 基础设施的 AI 云平台,提供灵活的架构、经过测试的性能和长期价值,配备 NVIDIA GPU 和优化的集群,用于训练和推理。

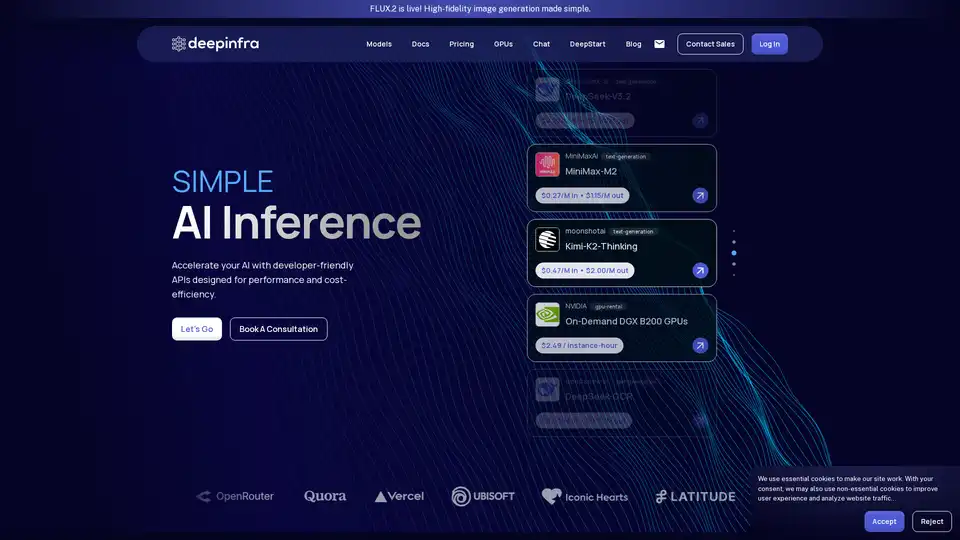

Deep Infra 是一个低成本、可扩展的 AI 推理平台,支持 100 多个 ML 模型,如 DeepSeek-V3.2、Qwen 和 OCR 工具。提供开发者友好 API、GPU 租赁、零数据保留和美国安全基础设施,用于生产 AI 工作负载。