Friendli Inference 概述

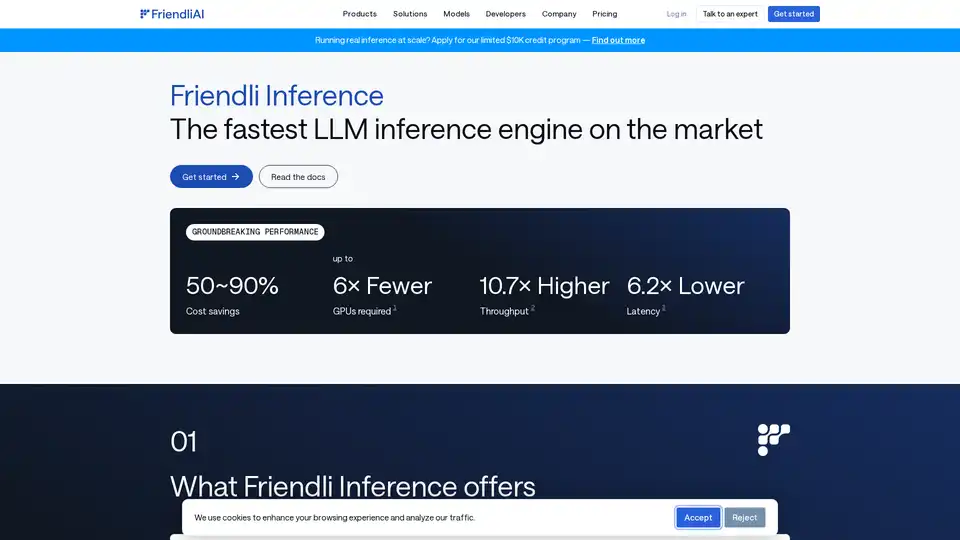

Friendli Inference: 最快的 LLM 推理引擎

什么是 Friendli Inference?

Friendli Inference 是一款高度优化的引擎,旨在加速大型语言模型 (LLM) 的服务,从而显著降低 50-90% 的成本。它以市场上最快的 LLM 推理引擎著称,在性能测试中优于 vLLM 和 TensorRT-LLM。

Friendli Inference 如何工作?

Friendli Inference 通过以下几项关键技术实现了其卓越的性能:

- 迭代批处理 (Iteration Batching): 这种创新的批处理技术有效地处理并发生成请求,与传统的批处理相比,LLM 推理吞吐量提高了多达数十倍,同时保持了相同的延迟要求。它受到美国、韩国和中国的专利保护。

- DNN 库: Friendli DNN 库包含一组专门为生成式 AI 设计的优化 GPU 内核。该库支持各种张量形状和数据类型的更快的 LLM 推理,并支持量化、专家混合 (MoE) 和 LoRA 适配器。

- Friendli TCache: 这种智能缓存系统识别并存储常用的计算结果,通过利用缓存的结果来减少 GPU 上的工作负载。

- 推测解码 (Speculative Decoding): Friendli Inference 原生支持推测解码,这是一种优化技术,通过在生成当前 token 的同时并行地对未来的 token 进行有根据的猜测,从而加速 LLM/LMM 推理。这确保了以一小部分推理时间获得相同的模型输出。

主要特性和优势

- 显著的成本节省: 降低 50-90% 的 LLM 服务成本。

- 多 LoRA 服务: 在更少的 GPU 上(甚至单个 GPU 上)同时支持多个 LoRA 模型。

- 广泛的模型支持: 支持各种生成式 AI 模型,包括量化模型和 MoE。

- 突破性的性能:

- 所需的 GPU 数量最多减少 6 倍。

- 吞吐量最多提高 10.7 倍。

- 延迟最多降低 6.2 倍。

亮点

- 在单个 GPU 上运行量化的 Mixtral 8x7B: Friendli Inference 可以在单个 NVIDIA A100 80GB GPU 上运行量化的 Mixtral-7x8B-instruct v0.1 模型,与基线 vLLM 系统相比,响应时间至少快 4.1 倍,token 吞吐量高 3.8 倍 ~ 23.8 倍。

- 在单个 GPU 上量化 Llama 2 70B: 在单个 A100 80 GB GPU 上无缝运行 AWQ-ed LLM,例如 Llama 2 70B 4-bit,从而实现高效的 LLM 部署和卓越的效率提升,而不会牺牲准确性。

- 使用 Friendli TCache 实现更快的 TTFT: Friendli TCache 通过重用重复计算来优化首次 token 时间 (TTFT),与 vLLM 相比,TTFT 速度提高了 11.3 倍到 23 倍。

如何使用 Friendli Inference

Friendli Inference 提供三种运行生成式 AI 模型的方式:

- Friendli 专用端点: 在自动驾驶仪上构建和运行生成式 AI 模型。

- Friendli 容器: 在您的私有环境中通过 Friendli Inference 提供 LLM 和 LMM 推理服务。

- Friendli Serverless 端点: 调用快速且经济实惠的 API 来获取开源生成式 AI 模型。

为什么选择 Friendli Inference?

对于希望优化其 LLM 推理工作负载的性能和成本效益的组织而言,Friendli Inference 是理想的解决方案。其创新技术和广泛的功能使其成为部署和扩展生成式 AI 模型的强大工具。

Friendli Inference 适合哪些人?

Friendli Inference 适用于:

- 部署大型语言模型的企业。

- 从事生成式 AI 研究的研究人员。

- 构建 AI 驱动应用程序的开发人员。

优化 LLM 推理的最佳方法?

优化 LLM 推理的最佳方法是使用 Friendli Inference,与其他解决方案相比,它可以显著节省成本、提高吞吐量并降低延迟。

"Friendli Inference"的最佳替代工具

暂无图片

暂无图片

Xander是一个开源桌面平台,支持无代码AI模型训练。只需用自然语言描述任务,即可自动化文本分类、图像分析和LLM微调流程,在本地机器上确保隐私和性能。

无代码ML

模型训练

LLM微调

暂无图片

HUMAIN 提供全栈 AI 解决方案,涵盖基础设施、数据、模型和应用。借助 HUMAIN 的 AI 原生平台,加速进步并大规模释放现实世界的影响。

全栈 AI

AI 基础设施

暂无图片

mistral.rs 是一个用 Rust 编写的极速 LLM 推理引擎,支持多模态工作流程和量化。提供 Rust、Python 和 OpenAI 兼容的 HTTP 服务器 API。

LLM 推理引擎

Rust