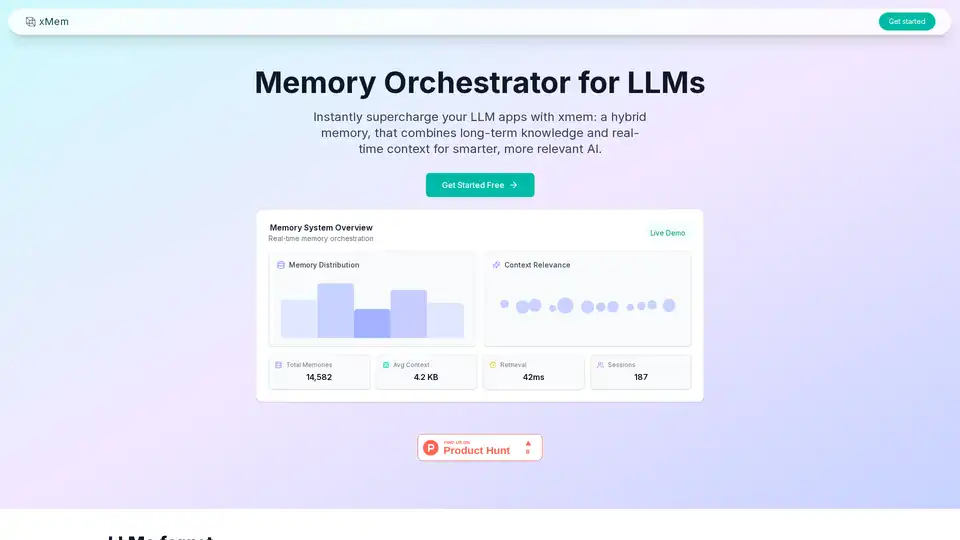

xMem

Visão geral de xMem

O que é xMem?

xMem é um orquestrador de memória para LLMs (Grandes Modelos de Linguagem) que combina conhecimento de longo prazo e contexto em tempo real para criar aplicativos de IA mais inteligentes e relevantes.

Como usar xMem?

Integre xMem em seu aplicativo LLM usando a API ou o painel. xMem monta automaticamente o melhor contexto para cada chamada LLM, eliminando a necessidade de ajuste manual.

const orchestrator = new xmem({

vectorStore: chromadb,

sessionStore: in-memory,

llmProvider: mistral

});

const response = await orchestrator.query({

input: "Tell me about our previous discussion"

});

Por que xMem é importante?

Os LLMs geralmente esquecem informações entre as sessões, levando a uma má experiência do usuário. xMem resolve isso, fornecendo memória persistente para cada usuário, garantindo que a IA seja sempre relevante, precisa e atualizada.

Características principais:

- Memória de longo prazo: Armazene e recupere conhecimento, notas e documentos com pesquisa vetorial.

- Memória de sessão: Rastreie chats, instruções e contexto recentes para atualidade e personalização.

- Orquestração RAG: Monte automaticamente o melhor contexto para cada chamada LLM. Não é necessário ajuste manual.

- Gráfico de conhecimento: Visualize conexões entre conceitos, fatos e contexto do usuário em tempo real.

Benefícios:

- Nunca perca conhecimento ou contexto entre as sessões.

- Aumente a precisão do LLM com contexto orquestrado.

- Funciona com qualquer LLM de código aberto e banco de dados vetorial.

- API e painel fáceis para integração e monitoramento perfeitos.

Gestão de Tarefas e Projetos com IA Resumo de Documentos e Leitura com IA Pesquisa Inteligente com IA Análise de Dados com IA Fluxo de Trabalho Automatizado

Melhores ferramentas alternativas para "xMem"

Supermemory é uma API de memória e roteador rápidos que adiciona memória de longo prazo aos seus aplicativos LLM. Armazene, recorde e personalize em milissegundos usando Supermemory SDK e MCP.

Marvin é um framework Python poderoso para construir aplicações de IA com modelos de linguagem grandes (LLM). Simplifica o gerenciamento de estados, coordenação de agentes e saídas estruturadas para desenvolvedores que criam apps inteligentes.

vLLM é um mecanismo de inferência e serviço de alto rendimento e com eficiência de memória para LLMs, apresentando PagedAttention e processamento em lote contínuo para desempenho otimizado.

Agents-Flex é um framework de desenvolvimento de aplicações LLM simples e leve desenvolvido em Java, semelhante ao LangChain.