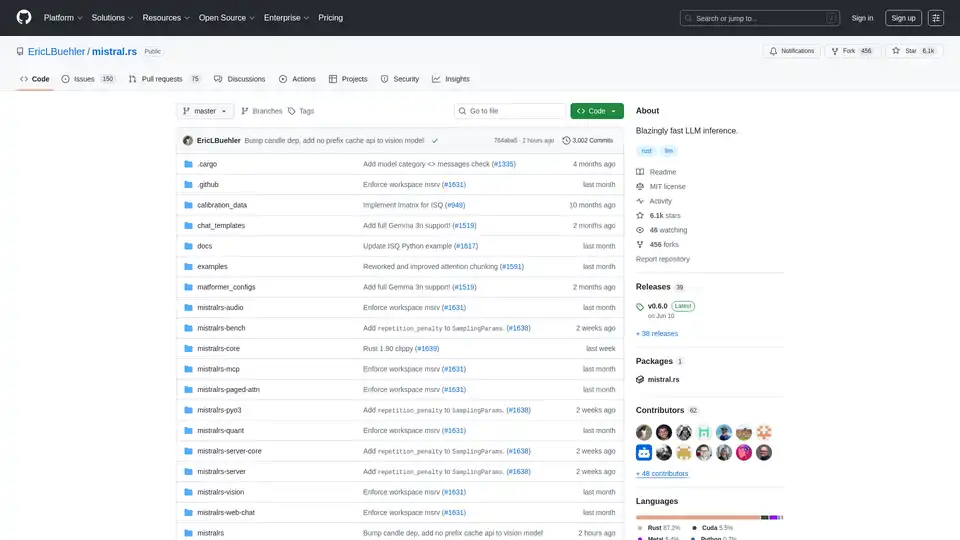

mistral.rs 개요

mistral.rs란 무엇인가요?

Mistral.rs는 Rust로 작성된 크로스 플랫폼의 매우 빠른 대규모 언어 모델(LLM) 추론 엔진입니다. 다양한 플랫폼과 하드웨어 구성에서 높은 성능과 유연성을 제공하도록 설계되었습니다. 멀티모달 워크플로우를 지원하며 텍스트, 비전, 이미지 생성 및 음성을 처리합니다.

주요 특징 및 장점

- 멀티모달 워크플로우: 텍스트↔텍스트, 텍스트+비전↔텍스트, 텍스트+비전+오디오↔텍스트, 텍스트→음성, 텍스트→이미지를 지원합니다.

- API: 다양한 환경에 쉽게 통합할 수 있도록 Rust, Python 및 OpenAI HTTP 서버 API(Chat Completions, Responses API 포함)를 제공합니다.

- MCP 클라이언트: 파일 시스템, 웹 검색, 데이터베이스 및 기타 API와 같은 외부 도구 및 서비스에 자동으로 연결됩니다.

- 성능: 최적화된 성능을 위해 ISQ(In-place quantization), PagedAttention 및 FlashAttention과 같은 기술을 활용합니다.

- 사용 편의성: 자동 장치 매핑(다중 GPU, CPU), 채팅 템플릿 및 토크나이저 자동 감지와 같은 기능이 포함되어 있습니다.

- 유연성: 가중치 병합이 있는 LoRA 및 X-LoRA 어댑터, 모든 기본 모델에서 MoE 모델을 생성하기 위한 AnyMoE 및 사용자 정의 가능한 양자화를 지원합니다.

mistral.rs는 어떻게 작동하나요?

Mistral.rs는 몇 가지 주요 기술을 활용하여 높은 성능을 달성합니다.

- In-place Quantization (ISQ): 모델 가중치를 양자화하여 메모리 공간을 줄이고 추론 속도를 향상시킵니다.

- PagedAttention & FlashAttention: 주의 메커니즘 동안 메모리 사용량과 계산 효율성을 최적화합니다.

- 자동 장치 매핑: 여러 GPU 및 CPU를 포함하여 사용 가능한 하드웨어 리소스에 모델을 자동으로 분산합니다.

- MCP (Model Context Protocol): 도구 호출을 위한 표준화된 프로토콜을 제공하여 외부 도구 및 서비스와의 원활한 통합을 가능하게 합니다.

mistral.rs를 사용하는 방법

설치: 공식 문서에 제공된 설치 지침을 따르세요. 일반적으로 Rust를 설치하고 mistral.rs 리포지토리를 복제하는 과정이 포함됩니다.

모델 획득: 원하는 LLM 모델을 획득하세요. Mistral.rs는 Hugging Face 모델, GGUF 및 GGML을 포함한 다양한 모델 형식을 지원합니다.

API 사용: Rust, Python 또는 OpenAI 호환 HTTP 서버 API를 활용하여 추론 엔진과 상호 작용하세요. 각 API에 대한 예제 및 설명서가 제공됩니다.

- Python API:

pip install mistralrs - Rust API:

mistralrs = { git = "https://github.com/EricLBuehler/mistral.rs.git" }를Cargo.toml에 추가하세요.

- Python API:

서버 실행: 적절한 구성 옵션을 사용하여 mistralrs-server를 실행하세요. 모델 경로, 양자화 방법 및 기타 매개변수를 지정하는 과정이 포함될 수 있습니다.

./mistralrs-server --port 1234 run -m microsoft/Phi-3.5-MoE-instruct

사용 사례

Mistral.rs는 다음을 포함한 광범위한 응용 분야에 적합합니다.

- 챗봇 및 대화형 AI: 고성능 추론으로 대화형 및 매력적인 챗봇을 강화하세요.

- 텍스트 생성: 콘텐츠 생성 및 요약과 같은 다양한 목적을 위해 현실적이고 일관성 있는 텍스트를 생성하세요.

- 이미지 및 비디오 분석: 통합된 비전 기능으로 시각 데이터를 처리하고 분석하세요.

- 음성 인식 및 합성: 오디오 처리를 지원하여 음성 기반 상호 작용을 가능하게 하세요.

- 도구 호출 및 자동화: 자동화된 워크플로우를 위해 외부 도구 및 서비스와 통합하세요.

mistral.rs는 누구를 위한 것인가요?

Mistral.rs는 다음을 위해 설계되었습니다.

- 개발자: 애플리케이션에 빠르고 유연한 LLM 추론 엔진이 필요한 분.

- 연구원: 자연어 처리 분야에서 새로운 모델과 기술을 탐색하는 분.

- 조직: 제품 및 서비스에 고성능 AI 기능이 필요한 조직.

왜 mistral.rs를 선택해야 할까요?

- 성능: ISQ, PagedAttention 및 FlashAttention과 같은 기술을 통해 매우 빠른 추론 속도를 제공합니다.

- 유연성: 광범위한 모델, 양자화 방법 및 하드웨어 구성을 지원합니다.

- 사용 편의성: 쉬운 통합을 위해 간단한 API 및 자동 구성 옵션을 제공합니다.

- 확장성: MCP 프로토콜을 통해 외부 도구 및 서비스와 통합할 수 있습니다.

지원되는 가속기

Mistral.rs는 다양한 가속기를 지원합니다.

- NVIDIA GPU (CUDA):

cuda,flash-attn및cudnn기능 플래그를 사용합니다. - Apple Silicon GPU (Metal):

metal기능 플래그를 사용합니다. - CPU (Intel):

mkl기능 플래그를 사용합니다. - CPU (Apple Accelerate):

accelerate기능 플래그를 사용합니다. - 일반 CPU (ARM/AVX): 기본적으로 활성화됩니다.

기능을 활성화하려면 Cargo에 전달하세요.

cargo build --release --features "cuda flash-attn cudnn"

커뮤니티 및 지원

결론

Mistral.rs는 매우 빠른 성능, 광범위한 유연성 및 원활한 통합 기능을 제공하는 강력하고 다재다능한 LLM 추론 엔진으로 두드러집니다. 크로스 플랫폼 특성과 멀티모달 워크플로우 지원은 다양한 응용 분야에서 대규모 언어 모델의 힘을 활용하려는 개발자, 연구원 및 조직에게 훌륭한 선택입니다. 고급 기능과 API를 활용하여 사용자는 혁신적이고 영향력 있는 AI 솔루션을 쉽게 만들 수 있습니다.

AI 인프라를 최적화하고 LLM의 잠재력을 최대한 활용하려는 사람들에게 mistral.rs는 연구 및 생산 환경 모두에 적합한 강력하고 효율적인 솔루션을 제공합니다.

"mistral.rs"의 최고의 대체 도구

Spice.ai는 엔터프라이즈 데이터를 기반으로 SQL 쿼리 페더레이션, 가속화, 검색 및 검색을 통해 AI 앱을 구축하기 위한 오픈 소스 데이터 및 AI 추론 엔진입니다.

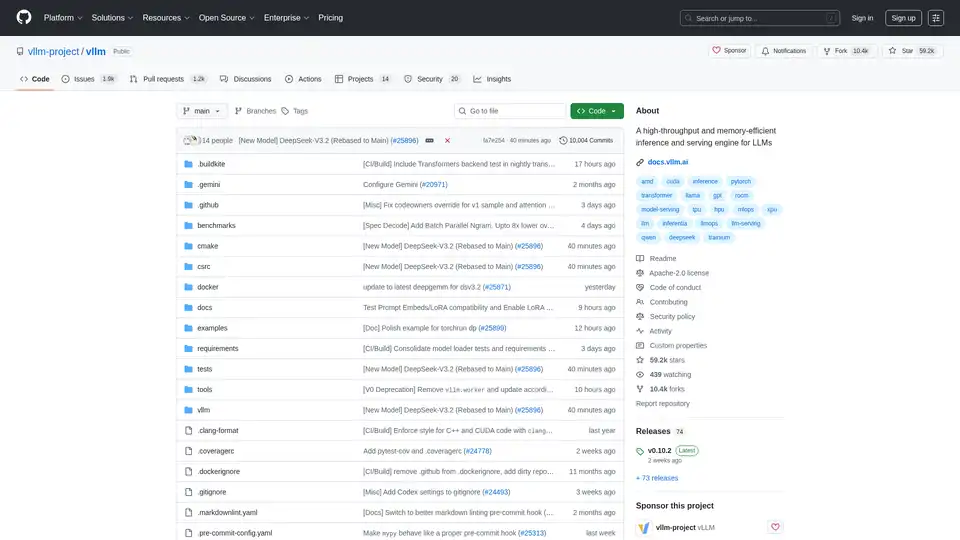

vLLM은 최적화된 성능을 위해 PagedAttention 및 지속적인 일괄 처리를 특징으로 하는 LLM을 위한 고처리량 및 메모리 효율적인 추론 및 서비스 엔진입니다.

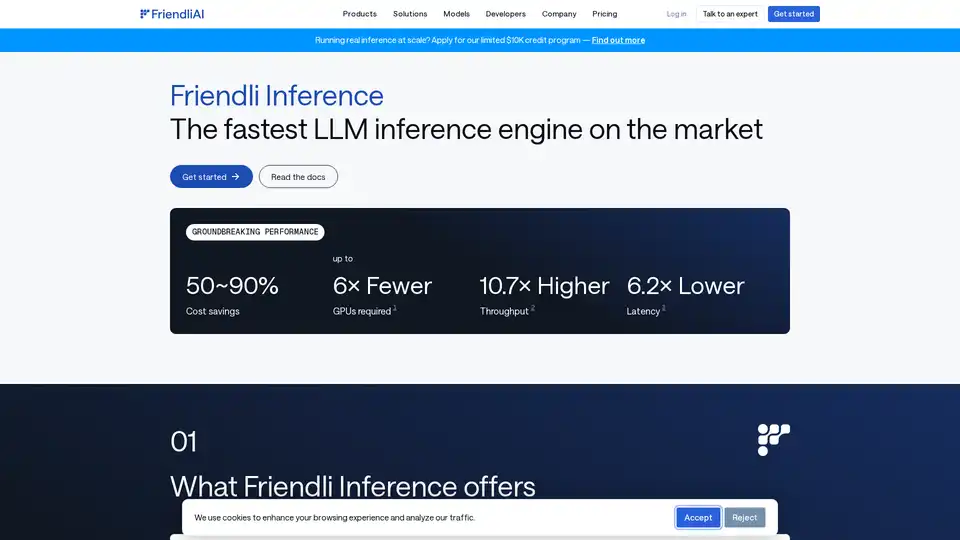

Friendli Inference는 가장 빠른 LLM 추론 엔진으로, 속도와 비용 효율성을 위해 최적화되어 높은 처리량과 짧은 대기 시간을 제공하면서 GPU 비용을 50~90% 절감합니다.

개발자를 위한 번개처럼 빠른 AI 플랫폼. 간단한 API로 200개 이상의 최적화된 LLM과 멀티모달 모델 배포, 미세 조정 및 실행 - SiliconFlow.