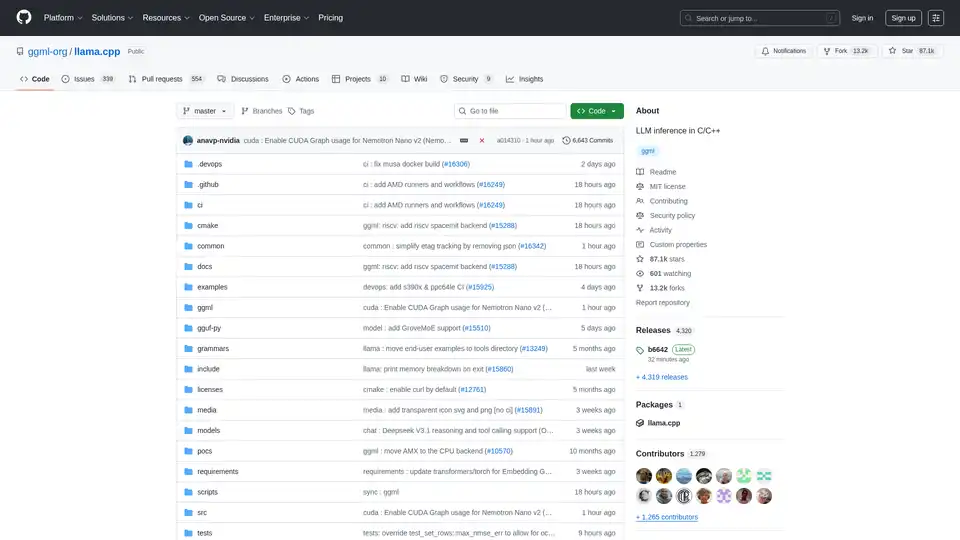

llama.cpp 개요

llama.cpp: C/C++에서 LLM 추론을 위한 최고의 라이브러리

lama.cpp는 C/C++를 사용하여 효율적인 대규모 언어 모델(LLM) 추론을 가능하게 하도록 설계된 강력한 오픈 소스 라이브러리입니다. 로컬 머신에서 클라우드 배포에 이르기까지 광범위한 하드웨어에 최적화되어 있으며 최소한의 설정과 최첨단 성능으로 두각을 나타냅니다.

llama.cpp란 무엇입니까?

lama.cpp는 C/C++에서 LLM 추론을 수행하는 데 중점을 둔 프로젝트입니다. 최소한의 종속성으로 다양한 하드웨어 구성에서 뛰어난 성능을 제공하도록 설계되었습니다.

주요 기능 및 이점

- 일반 C/C++ 구현: 외부 종속성을 제거하여 배포를 단순화합니다.

- Apple Silicon 최적화: Apple 장치에서 최고의 성능을 위해 ARM NEON, Accelerate 및 Metal 프레임워크를 활용합니다.

- x86 아키텍처 지원: x86 CPU에서 최적화된 성능을 위해 AVX, AVX2, AVX512 및 AMX 지원을 포함합니다.

- 양자화: 메모리 사용량을 줄이고 추론을 가속화하는 1.5비트에서 8비트 정수 양자화를 지원합니다.

- GPU 가속: 사용자 정의 CUDA 커널은 NVIDIA GPU에서 효율적인 LLM 실행을 제공합니다. 또한 HIP를 통해 AMD GPU를 지원하고 MUSA를 통해 Moore Threads GPU도 지원합니다.

- 하이브리드 CPU+GPU 추론: CPU와 GPU 간에 워크로드를 분산하여 사용 가능한 VRAM보다 큰 모델을 쉽게 사용할 수 있습니다.

- 여러 백엔드: Metal, BLAS, BLIS, SYCL, MUSA, CUDA, HIP, Vulkan, CANN, OpenCL, IBM zDNN 및 WebGPU(진행 중)를 지원합니다.

llama.cpp는 어떻게 작동합니까?

lama.cpp는 LLM 추론을 C/C++에서 직접 구현하여 작동합니다. 이 접근 방식은 오버헤드를 줄이고 하드웨어 리소스를 세밀하게 제어할 수 있도록 합니다. 이 라이브러리는 모듈식으로 설계되었으며 다양한 하드웨어 플랫폼에 최적화된 다양한 백엔드가 있습니다. 양자화와 같은 기술을 사용하여 모델의 메모리 공간을 줄여 리소스가 제한된 장치에서 대규모 모델을 실행할 수 있습니다.

llama.cpp 사용 방법

설치:

- 패키지 관리자 사용: brew, nix 또는 winget을 통해 설치합니다.

- Docker: 제공된 Docker 이미지를 사용합니다.

- 미리 빌드된 바이너리: 릴리스 페이지에서 바이너리를 다운로드합니다.

- 소스에서 빌드: 리포지토리를 복제하고 빌드 가이드를 따릅니다.

모델 얻기:

- Hugging Face 또는 기타 모델 호스팅 사이트에서 GGUF 모델을 다운로드합니다.

- 제공된 Python 스크립트를 사용하여 모델을 GGUF 형식으로 변환합니다.

추론 실행:

- 실험에는

llama-cli도구를 사용합니다. - OpenAI API 호환성을 위해

llama-server를 사용하여 로컬 HTTP 서버를 배포합니다.

- 실험에는

예제 명령:

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

llama.cpp는 누구를 위한 것입니까?

lama.cpp는 다음에 적합합니다.

- 개발자: C/C++를 사용하여 LLM 기반 응용 프로그램을 구현합니다.

- 연구원: 다양한 하드웨어 플랫폼에서 LLM을 실험합니다.

- 애호가: 개인용 컴퓨터 및 장치에서 LLM을 실행합니다.

- 조직: 최소한의 오버헤드로 프로덕션 환경에 LLM을 배포합니다.

llama.cpp의 실제 응용 프로그램

lama.cpp는 다음과 같은 다양한 시나리오에서 사용할 수 있습니다.

- 로컬 LLM 추론: 클라우드 서비스에 의존하지 않고 개인용 컴퓨터에서 모델을 실행합니다.

- 에지 컴퓨팅: 낮은 대기 시간 응용 프로그램을 위해 에지 장치에 LLM을 배포합니다.

- 모바일 응용 프로그램: 장치 내 처리를 위해 LLM을 모바일 앱에 통합합니다.

- 사용자 정의 AI 솔루션: 특정 하드웨어 및 소프트웨어 환경에 맞게 조정된 사용자 정의 AI 솔루션을 구축합니다.

llama.cpp를 선택하는 이유

lama.cpp는 성능, 유연성 및 사용 용이성의 고유한 조합을 제공하여 LLM 추론에 탁월한 선택입니다. 주요 이점은 다음과 같습니다.

- 최적화된 성능: 광범위한 하드웨어에서 최고의 성능을 위해 설계되었습니다.

- 최소한의 종속성: 배포를 단순화하고 충돌 위험을 줄입니다.

- 양자화 지원: 리소스가 제한된 장치에서 대규모 모델을 사용할 수 있습니다.

- 활성 커뮤니티: 지속적인 개발 및 커뮤니티 지원의 혜택을 누립니다.

- 다용도 도구: 다양한 사용 사례를 위한

llama-cli,llama-server,llama-perplexity및llama-bench와 같은 도구가 포함되어 있습니다.

지원되는 백엔드

lama.cpp는 광범위한 장치를 대상으로 하는 여러 백엔드를 지원합니다.

| 백엔드 | 대상 장치 |

|---|---|

| Metal | Apple Silicon |

| BLAS | 모두 |

| BLIS | 모두 |

| SYCL | Intel 및 Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | 모두 (진행 중) |

| RPC | 모두 |

llama.cpp에 기여하는 방법

lama.cpp에 대한 기여를 환영합니다! 다음 방법으로 기여할 수 있습니다.

- 버그 수정 또는 새로운 기능이 포함된 풀 요청을 엽니다.

- 기존 문제 및 프로젝트에서 협업합니다.

- 문제, PR 및 프로젝트 관리를 지원합니다.

- 문서 및 예제를 개선합니다.

GGUF란 무엇입니까?

GGUF는 모델을 저장하기 위해 llama.cpp에 필요한 파일 형식입니다. 리포지토리의 convert_*.py Python 스크립트를 사용하여 다른 데이터 형식의 모델을 GGUF로 변환할 수 있습니다.

결론

lama.cpp는 광범위한 청중이 LLM 추론에 액세스할 수 있도록 하는 다재다능하고 강력한 라이브러리입니다. 개발자, 연구원 또는 애호가이든 llama.cpp는 선택한 하드웨어에서 LLM의 강력한 기능을 활용하는 데 필요한 도구와 유연성을 제공합니다. 성능, 사용 용이성 및 커뮤니티 지원에 중점을 둔 llama.cpp는 빠르게 진화하는 AI 추론 환경에서 핵심 플레이어로 남을 것으로 예상됩니다.

자세한 내용은 llama.cpp GitHub 리포지토리를 방문하십시오.

"llama.cpp"의 최고의 대체 도구

Lampi AI는 금융 전문가를 위한 AI 에이전트를 제공하여 복잡한 금융 워크플로를 몇 분 안에 구조화되고 고품질 분석으로 변환합니다. M&A, 투자 은행, 사모 펀드 및 법률 부문에 이상적입니다.

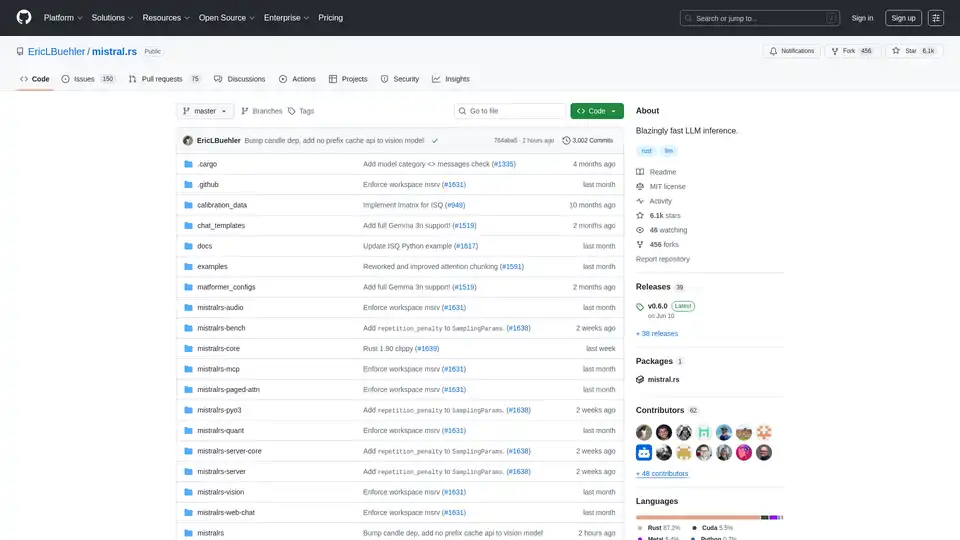

mistral.rs는 Rust로 작성된 매우 빠른 LLM 추론 엔진으로, 멀티모달 워크플로우와 양자화를 지원합니다. Rust, Python 및 OpenAI 호환 HTTP 서버 API를 제공합니다.

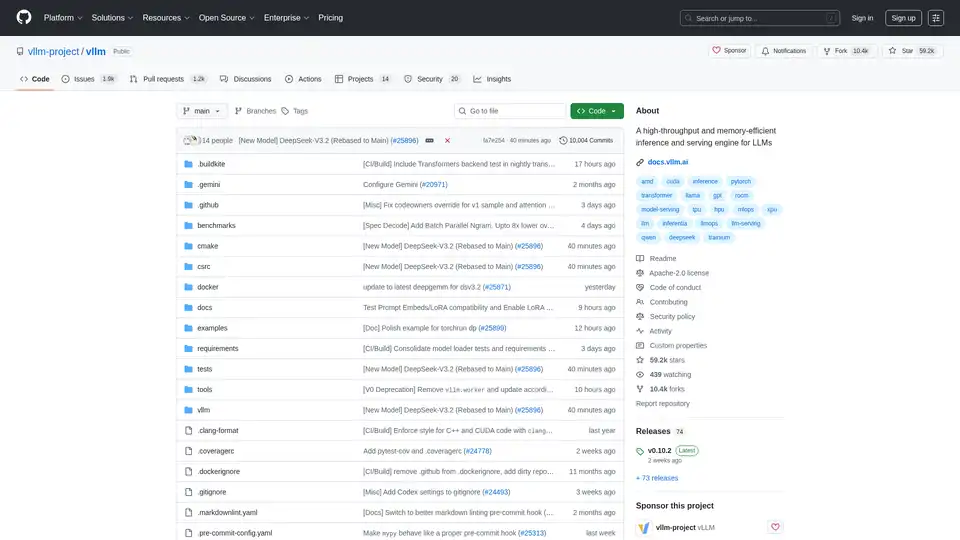

vLLM은 최적화된 성능을 위해 PagedAttention 및 지속적인 일괄 처리를 특징으로 하는 LLM을 위한 고처리량 및 메모리 효율적인 추론 및 서비스 엔진입니다.