Velvet の概要

Velvet: AI機能分析のための開発者ゲートウェイ (現在はArizeの一部)

Velvetとは? Velvetは、AIを活用した機能を分析、評価、監視するために設計された開発者向けゲートウェイでした。開発者は、AIモデルのパフォーマンスと動作をリアルタイムで把握することができました。

Arizeによる買収

2025年、VelvetはAIの評価と可観測性に焦点を当てたエンタープライズプラットフォームであるArizeに買収されました。この買収により、Velvetの開発者中心のアプローチとArizeの堅牢なプラットフォームが統合され、Arizeの統一AIプラットフォームの採用を加速することを目指しています。Velvetの創設者であるEmmaとChrisは、買収の一環としてArizeに入社しました。

Arize: AIのための統一された可観測性と評価プラットフォーム

Arizeとは? Arizeは、AIアプリケーションとエージェントの開発を加速させ、本番環境でそれらを完成させるのに役立つ包括的なプラットフォームです。統一された可観測性と評価機能を提供し、AIモデルが最適に機能することを保証します。

Arizeの主な機能:

- AI評価: AIモデルのパフォーマンスを評価し、精度と信頼性を確保します。

- 可観測性: AIモデルをリアルタイムで監視し、発生する可能性のある問題を特定して対処します。

- 統一プラットフォーム: すべてのAI評価と可観測性のニーズに対応する単一のプラットフォーム。

Arizeを選ぶ理由?

Arizeは、AIの評価と可観測性のための統一されたソリューションを提供し、チームが開発を加速し、モデルのパフォーマンスを向上させ、本番環境での信頼性を確保するのに役立ちます。

Arizeはどのように機能しますか?

Arizeのプラットフォームは、次のツールを提供します。

- モデル監視: モデルのパフォーマンス指標をリアルタイムで追跡します。

- 根本原因分析: モデルのパフォーマンス問題の根本原因を特定するためのツール。

- パフォーマンス評価: さまざまな指標にわたるモデルのパフォーマンスの包括的な評価。

Phoenix: オープンソースのLLMトレースと評価

Phoenixとは? Phoenixは、LLM (大規模言語モデル) のトレースと評価のためのオープンソースツールです。AIアプリケーションのシームレスな評価、実験、および最適化をリアルタイムで提供することにより、開発者がAI開発を加速できるように設計されています。

Phoenixの主な機能:

- LLMトレース: LLMの動作を追跡して、情報の処理方法を理解します。

- 評価: LLMのパフォーマンスを評価し、精度と信頼性を確保します。

- オープンソース: 自由に使用および変更できるコミュニティ主導のツール。

LiteLLM: LLMゲートウェイ

LiteLLMとは? LiteLLMは、100以上のLLMにわたるモデルアクセス、フォールバック、および支出追跡を提供するLLMゲートウェイです。OpenAI形式を使用し、プラットフォームとして使用することも、オープンソースでデプロイすることもできます。

LiteLLMの主な機能:

- モデルアクセス: 単一のゲートウェイを介して幅広いLLMにアクセスできます。

- フォールバック: あるモデルが失敗した場合でも、AIアプリケーションが引き続き利用できるように自動的にフォールバックします。

- 支出追跡: さまざまなLLMにわたる支出を追跡して、コストを最適化します。

LiteLLMのユースケース:

- AIアプリケーション開発: 幅広いLLMへのアクセスを提供することで、AIアプリケーションの構築プロセスを簡素化します。

- コスト最適化: さまざまなLLMにわたる支出を追跡することで、コストを最適化します。

Arizeは誰のためですか?

Arizeは、本番環境でAIモデルを評価および監視する必要があるデータサイエンティスト、機械学習エンジニア、およびAI開発者向けです。AIの評価と可観測性のための統一されたプラットフォームを提供し、チームが開発を加速し、モデルのパフォーマンスを向上させ、信頼性を確保するのに役立ちます。

AIモデルを監視する最良の方法?

AIモデルを監視する最良の方法は、モデルのパフォーマンスのリアルタイム追跡、根本原因分析ツール、およびパフォーマンス評価指標を提供するArizeのような包括的なプラットフォームを使用することです。PhoenixやLiteLLMのようなオープンソースツールは、LLMのトレースと管理のためのより焦点を絞った機能を提供します。

"Velvet" のベストな代替ツール

WhyLabsは、AIの可観測性、LLMセキュリティ、モデル監視を提供します。リアルタイムで生成AIアプリケーションを保護し、リスクを軽減します。

Future AGI は、AI アプリケーション向けの統一された LLM 可観測性と AI エージェント評価プラットフォームを提供し、開発から生産まで正確で責任ある AI を保証します。

Arize AIは、開発から生産まで、AIアプリケーション向けの統一されたLLM可観測性およびエージェント評価プラットフォームを提供します。プロンプトの最適化、エージェントの追跡、AIパフォーマンスのリアルタイム監視を行います。

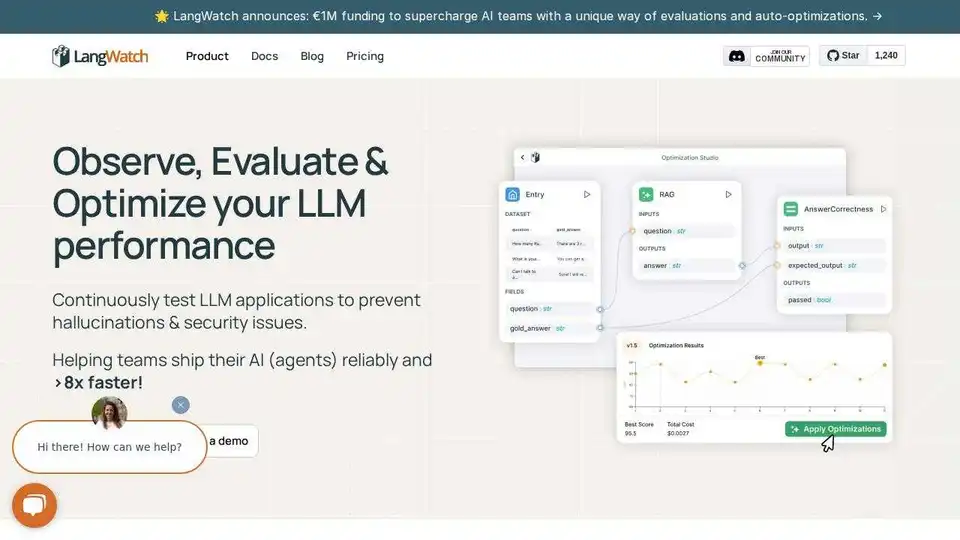

LangWatchは、AIエージェントのテスト、LLM評価、およびLLM可観測性プラットフォームです。エージェントをテストし、回帰を防ぎ、問題をデバッグします。