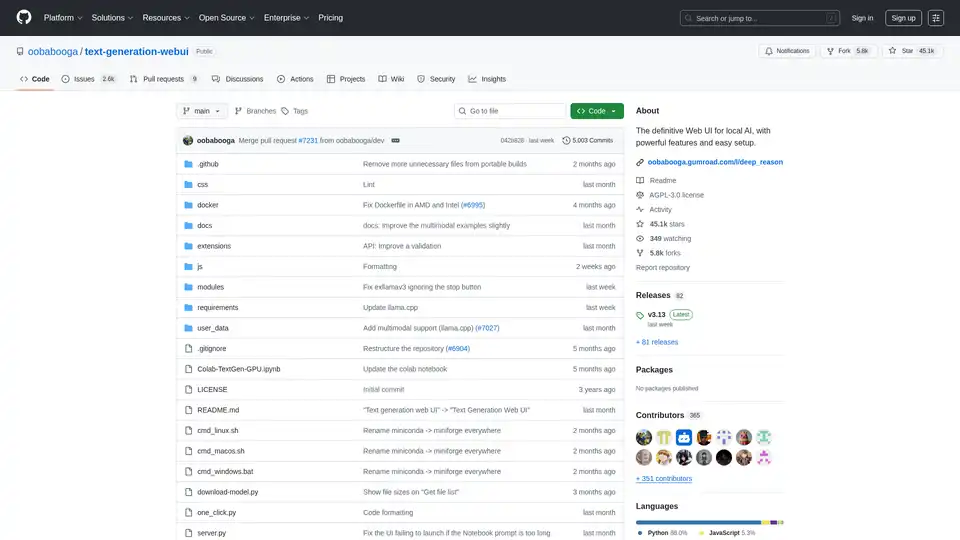

Text Generation Web UI の概要

Text Generation Web UI: ローカルAIのための究極のWebインターフェース

Text Generation Web UIとは?

Text Generation Web UI(oobabooga/text-generation-webuiとしても知られています)は、ローカルで大規模言語モデル(LLM)と対話するために設計された、ユーザーフレンドリーで機能豊富なGradio Webインターフェースです。これは、プライバシーと制御を確保しながら、独自のマシン上でAIテキスト生成のパワーを活用するための包括的なツールと機能のセットを提供します。

Text Generation Web UIの仕組み

このWeb UIは、ユーザーとさまざまなローカルテキスト生成バックエンドの間の橋渡しとして機能します。llama.cpp、Transformers、ExLlamaV3、ExLlamaV2、TensorRT-LLMなどの複数のバックエンドをサポートしています。UIを使用すると、次のことができます。

- 好みのバックエンドを選択: ハードウェアとモデルの要件に合ったバックエンドを選択します。

- モデルのロードと管理: アプリケーションを再起動せずに、さまざまなLLMを簡単にロードして切り替えることができます。

- 生成パラメータの設定: さまざまなサンプリングパラメータと生成オプションを使用して、テキスト生成プロセスを微調整します。

- モデルとの対話: 直感的なチャットインターフェースまたは自由形式のノートブックタブを使用して、モデルと対話します。

Text Generation Web UIを選ぶ理由

- プライバシー: すべての処理はローカルで行われるため、データはプライベートに保たれます。

- オフライン機能: インターネット接続は不要で、いつでもどこでもツールを使用できます。

- 汎用性: 複数のバックエンドとモデルタイプをサポートし、柔軟性とカスタマイズを提供します。

- 拡張性: 新しい機能を追加するための拡張サポートを提供します。

- 使いやすさ: ダークおよびライトテーマ、構文の強調表示、LaTeXレンダリングを備えたユーザーフレンドリーなインターフェース。

主な機能:

- 複数のバックエンドのサポート:

llama.cpp、Transformers、ExLlamaV3、ExLlamaV2、TensorRT-LLMとシームレスに統合。 - 簡単なセットアップ: セットアップが不要なWindows / Linux / macOS用のポータブルビルドと、自己完結型環境用のワンクリックインストーラーを提供します。

- オフラインおよびプライベート: テレメトリ、外部リソース、リモート更新リクエストなしで100%オフラインで動作します。

- ファイルの添付: テキストファイル、PDFドキュメント、および.docxファイルをアップロードして、AIとコンテンツについて話し合うことができます。

- ビジョン(マルチモーダルモデル): 視覚的な理解のために画像をメッセージに添付することをサポートします(チュートリアル)。

- ウェブ検索: オプションでLLMで生成されたクエリを使用してインターネットを検索し、会話にコンテキストを追加できます。

- 美しいUI: ダークおよびライトテーマを備えた、クリーンで魅力的なユーザーインターフェースを備えています。

- 構文の強調表示とLaTeXレンダリング: コードブロックの構文の強調表示と、数式用のLaTeXレンダリングを提供します。

- 指示およびチャットモード: 指示に従うための指示モードと、カスタムキャラクターと対話するためのチャットモードが含まれています。

- 自動プロンプトフォーマット: Jinja2テンプレートを使用して、自動プロンプトフォーマットを行います。

- メッセージの編集と会話の分岐: メッセージの編集、バージョン間の移動、および会話の分岐を可能にします。

- 複数のサンプリングパラメータ: さまざまなサンプリングパラメータと生成オプションを使用して、テキスト生成を高度に制御できます。

- モデルの切り替え: 再起動せずに、UIで異なるモデルを切り替えることができます。

- 自動GPUレイヤー: NVIDIA GPU上のGGUFモデルのGPUレイヤーを自動的に構成します。

- 自由形式のテキスト生成: チャットターンの制限なしに、自由形式のテキスト生成のためのノートブックタブを提供します。

- OpenAI互換API: ツール呼び出しのサポートを含む、チャットおよび完了エンドポイントを備えたOpenAI互換APIが含まれています。

- 拡張機能のサポート: 多数の組み込みおよびユーザー提供の拡張機能をサポートしています。

Text Generation Web UIのインストール方法:

- ポータブルビルド(クイックスタートに推奨):

- リリースページからポータブルビルドをダウンロードします。

- ダウンロードしたファイルを解凍します。

- 実行可能ファイルを実行します。

- venvを使用した手動ポータブルインストール:

git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv # On Windows: venv\Scripts\activate # On macOS/Linux: source venv/bin/activate pip install -r requirements/portable/requirements.txt --upgrade python server.py --portable --api --auto-launch deactivate - ワンクリックインストーラー(上級ユーザー向け):

- リポジトリをクローンするか、ソースコードをダウンロードします。

- OSのスタートアップスクリプト(start_windows.bat、start_linux.sh、またはstart_macos.sh)を実行します。

- プロンプトが表示されたら、GPUベンダーを選択します。

- インストール後、ブラウザで

http://127.0.0.1:7860を開きます。

モデルのダウンロード:

モデルはtext-generation-webui/user_data/modelsフォルダーに配置する必要があります。GGUFモデルはこのフォルダーに直接配置し、他のモデルタイプはサブフォルダーに配置する必要があります。

例:

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

UIを使用してHugging Faceからモデルを自動的にダウンロードするか、コマンドラインツールを使用することもできます。

python download-model.py organization/model

python download-model.py --helpを実行して、すべてのオプションを表示します。

Text Generation Web UIは誰のためですか?

Text Generation Web UIは、次の人に最適です。

- LLMを扱う研究者および開発者。

- テキスト生成を試したいAI愛好家。

- プライバシーを優先し、LLMをローカルで実行したいユーザー。

役立つリソース:

Text Generation Web UIは、ローカルAIテキスト生成の機能を探索するための強力で汎用性の高いプラットフォームを提供します。使いやすさ、豊富な機能、およびプライバシーへの取り組みにより、大規模言語モデルを自分の条件で操作することに関心のあるすべての人にとって優れた選択肢となります。

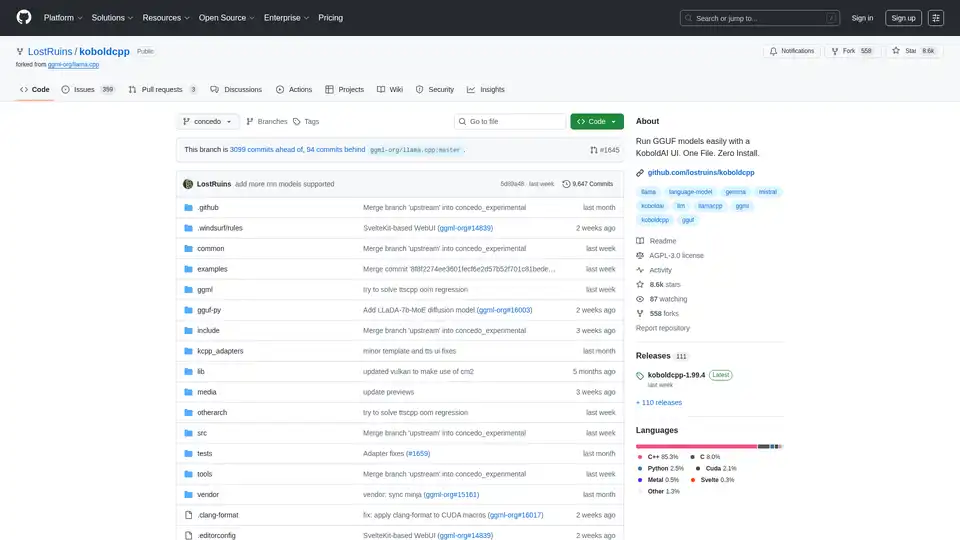

"Text Generation Web UI" のベストな代替ツール

KoboldCpp:KoboldAI UIでAIテキストと画像を生成するためのGGUFモデルを簡単に実行。単一ファイル、インストール不要。CPU/GPU、STT、TTS、Stable Diffusionをサポート。

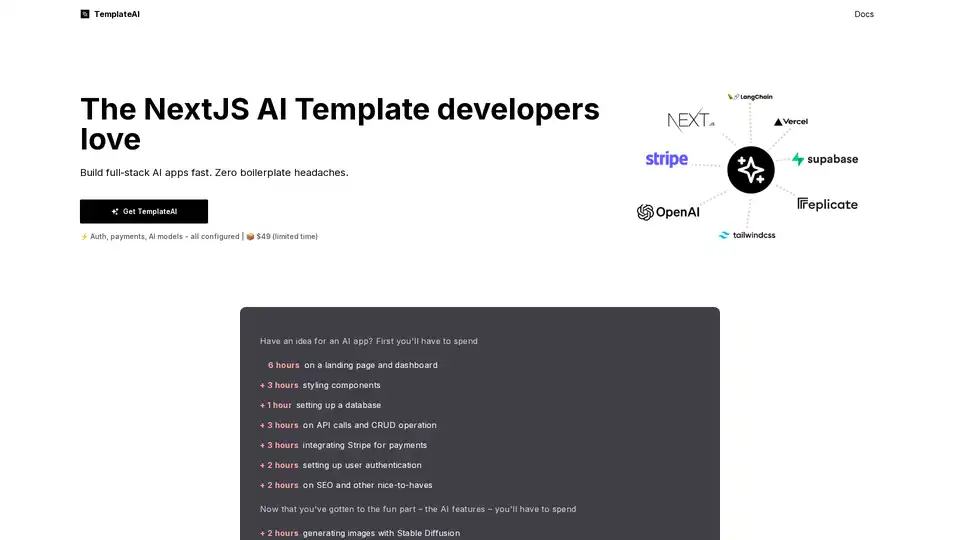

TemplateAI は AI アプリ向けの主要 NextJS テンプレートで、Supabase 認証、Stripe 支払い、OpenAI/Claude 統合、迅速なフルスタック開発のための準備済み AI コンポーネントを備えています。

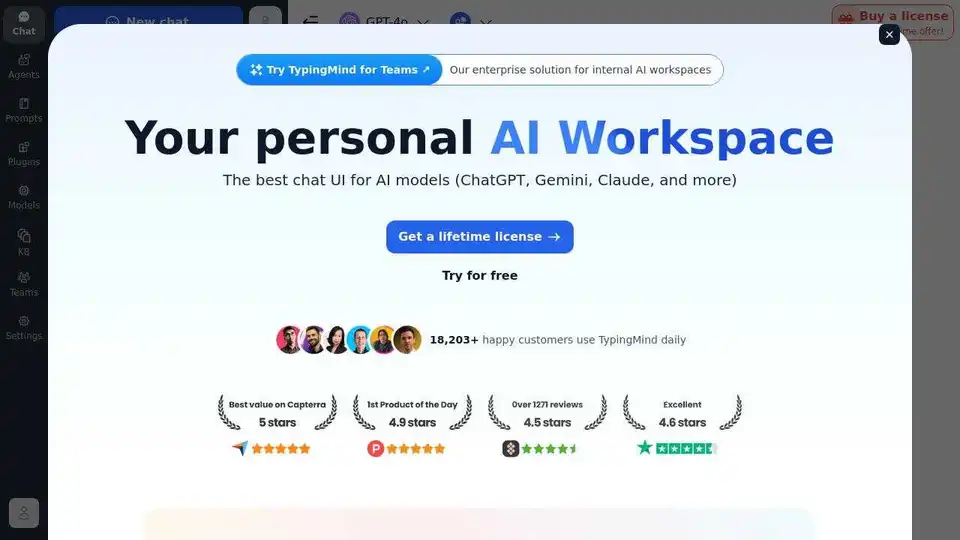

TypingMindは、GPT-4、Gemini、ClaudeなどのLLMをサポートするAIチャットUIです。APIキーを使用して、使用した分だけ支払います。すべてのAIモデルに最適なチャットLLMフロントエンドUI。