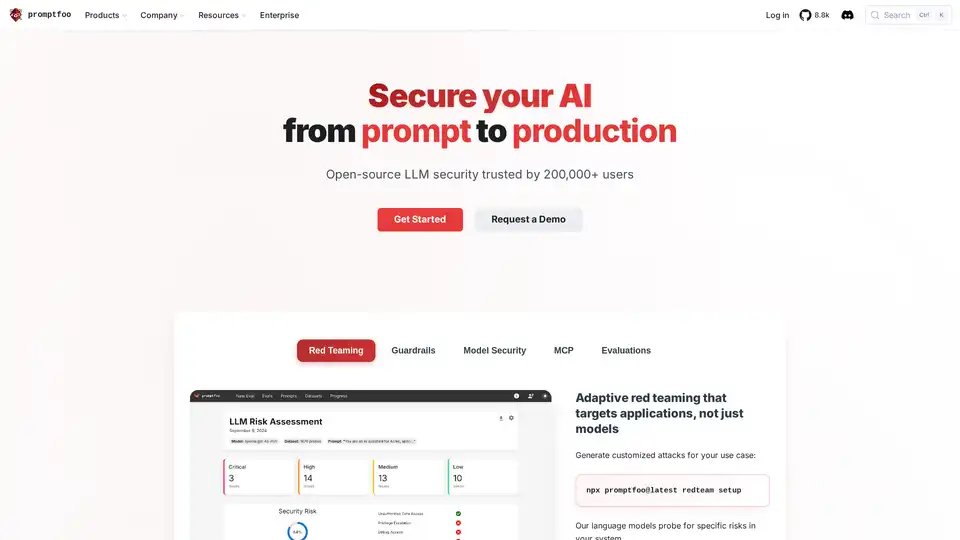

Promptfoo の概要

Promptfoo: プロンプトからプロダクションまでAIを保護

Promptfooは、開発者がプロンプトからプロダクションまでAIアプリケーションを保護できるように設計されたオープンソースのLLMセキュリティツールです。AIレッドチームと評価に重点を置き、Promptfooを使用すると、ユーザーは脆弱性を発見して修正し、出力品質を最大化し、回帰を検出できます。

Promptfooとは?

Promptfooは、セキュリティを第一に考えた、開発者向けのツールであり、単なるモデルではなく、アプリケーションを対象とした適応型レッドチームを提供します。20万人以上のユーザーに信頼され、フォーチュン500企業の44社に採用されています。潜在的な脆弱性を特定し、LLMの信頼性を確保することで、AIアプリケーションを保護するように設計されています。

Promptfooの仕組みは?

Promptfooは、特定のユースケースに合わせてカスタマイズされた攻撃を生成することで動作します。その仕組みは次のとおりです。

- カスタマイズされた攻撃: このツールは、一般的な既製の攻撃に依存するのではなく、業界、企業、アプリケーションに固有の攻撃を生成します。

- 言語モデルのプロービング: 特殊な言語モデルが、特定の危険性がないかシステムをプローブします。

- 脆弱性検出: 直接的および間接的なプロンプトインジェクション、ジェイルブレイク、データおよびPIIリーク、安全でないツール使用の脆弱性、不正な契約作成、有害コンテンツの生成を特定します。

主な機能

- レッドチーム:

- 言語モデルを使用してカスタマイズされた攻撃を生成します。

- システム内の特定のリスクをターゲットにします。

- プロンプトインジェクションやデータリークなどの脆弱性を特定します。

- ガードレール:

- ガードレールに合わせてジェイルブレイクを調整するのに役立ちます。

- モデルセキュリティ:

- AIアプリケーションでの安全なモデルの使用を保証します。

- 評価:

- AIモデルのパフォーマンスとセキュリティを評価します。

Promptfooを選ぶ理由

- 気になる脆弱性を見つける: Promptfooは、業界、企業、アプリケーションに固有の脆弱性を発見するのに役立ちます。

- エンタープライズ規模で実戦テスト済み: 数多くのフォーチュン500企業に採用され、大規模なオープンソースコミュニティに受け入れられています。

- セキュリティを第一に考え、開発者に優しい: ライブリロードとキャッシュを備えたコマンドラインインターフェイスを提供します。SDK、クラウドの依存関係、ログインは必要ありません。

- 柔軟なデプロイメント: CLIツールを使用して数分で開始することも、マネージドクラウドまたはオンプレミスのエンタープライズソリューションを選択することもできます。

Promptfooの使い方

Promptfooの使用を開始するには、コマンドラインインターフェイス(CLI)を使用できます。CLIツールを使用すると、すばやくセットアップしてテストできます。より高度な機能とサポートについては、マネージドクラウドまたはオンプレミスのエンタープライズソリューションを選択できます。

レッドチームをセットアップするコマンドは次のとおりです。

npx promptfoo@latest redteam setup

Promptfooは誰のため?

Promptfooは、以下のような方を対象としています。

- 開発者: AIアプリケーションを保護し、LLMの信頼性を確保します。

- 企業: AIの脆弱性から保護し、コンプライアンスを確保します。

- セキュリティチーム: AIレッドチームと評価を実装します。

コミュニティとサポート

Promptfooには、20万人以上の開発者からなる活発なオープンソースコミュニティがあります。ユーザーが常に最新情報を入手し、ツールを最大限に活用できるように、広範なドキュメント、リリースノート、ブログを提供しています。

結論

Promptfooは、AIアプリケーションを保護するための包括的なツールであり、大規模なコミュニティと多数の企業から信頼されています。カスタマイズされた攻撃に焦点を当て、セキュリティを第一に考えるアプローチを提供することで、Promptfooは開発者が脆弱性を発見し、出力品質を最大化し、AIシステムの信頼性を確保するのに役立ちます。開発者であろうと大企業のメンバーであろうと、PromptfooはAIアプリケーションを効果的に保護するために必要な機能と柔軟性を提供します。

"Promptfoo" のベストな代替ツール

Robust Intelligenceは、AIモデル、データ、アプリケーションの評価と保護を自動化するAIアプリケーションセキュリティプラットフォームです。 企業がAIの安全性を確保し、AI開発をセキュリティから分離し、進化する脅威から保護するのに役立ちます。

Mindgardの自動レッドチームとセキュリティテストでAIシステムを保護します。 AI固有のリスクを特定して解決し、堅牢なAIモデルとアプリケーションを保証します。

Lakera は、リアルタイムの脅威検出、プロンプト攻撃の防止、およびデータ漏洩保護を提供することにより、企業が GenAI イニシアチブを加速するのに役立つ AI ネイティブセキュリティプラットフォームです。

WhyLabsは、AIの可観測性、LLMセキュリティ、モデル監視を提供します。リアルタイムで生成AIアプリケーションを保護し、リスクを軽減します。