Mindgard の概要

Mindgard:AIの自動レッドチームとセキュリティテスト

Mindgardとは?

Mindgardは、組織がAIシステムを新たな脅威から保護するのに役立つAIセキュリティテストソリューションです。従来のアプリケーションセキュリティツールでは、AIに関連する独自のリスクに対処できないため、Mindgardは必要な保護レイヤーとなります。

Mindgardの仕組み

MindgardのAI向け攻撃的セキュリティソリューションは、自動化されたレッドチームを利用して、実行時にのみ検出可能なAI固有のリスクを特定し、解決します。既存のCI/CD自動化およびSDLCのすべての段階に統合されます。MindgardをAIシステムに接続するには、モデル統合のための推論またはAPIエンドポイントのみが必要です。このプラットフォームは、生成AI、LLM、NLP、オーディオ、画像、マルチモーダルシステムなど、幅広いAIモデルをサポートしています。

Mindgardの重要性

AIの導入と使用は、従来のセキュリティツールでは対処できない新たなリスクをもたらします。多くのAI製品は十分なセキュリティなしに発売され、組織が脆弱な状態になっています。Gartnerの調査によると、AIシステムを導入している企業の29%が既にセキュリティ侵害を報告していますが、AIリスクを可視化できている内部監査担当者はわずか10%です。

主な機能と利点

- 自動化されたレッドチーム: AIシステムに対する攻撃をシミュレートして、手動による介入なしに脆弱性を特定します。

- AI固有のリスクの特定: ジェイルブレイク、抽出、回避、反転、ポイズニング、プロンプトインジェクションなど、AI固有のリスクを特定し、解決します。

- 継続的なセキュリティテスト: AI SDLC全体で継続的なセキュリティテストを提供します。

- 既存のシステムとの統合: 既存のレポートおよびSIEMシステムと統合されます。

- 広範なカバレッジ: OpenAI、Claude、BardなどのLLMを含む、さまざまなAIモデルとガードレールで動作します。

ユースケース

- AIシステムの保護: 従来のアプリケーションセキュリティツールでは対処できない新たな脅威からAIシステムを保護します。

- AIの脆弱性の特定: AIの脆弱性を発見して軽減し、開発者が安全で信頼できるシステムを構築できるようにします。

- 継続的なセキュリティ保証: AIライフサイクル全体で継続的なセキュリティテストと自動化されたAIレッドチームを提供します。

Mindgardが明らかにするリスクの種類

Mindgardは、以下を含むさまざまなAIセキュリティリスクを特定します。

- ジェイルブレイク: AIシステムに意図しないアクションを実行させるために入力を操作します。

- 抽出: センシティブな情報を公開するためにAIモデルを再構築します。

- 回避: AIモデルを欺いて誤った出力を生成させるために入力を変更します。

- 反転: トレーニングデータを明らかにするためにモデルをリバースエンジニアリングします。

- ポイズニング: モデルの動作を操作するためにトレーニングデータを改ざんします。

- プロンプトインジェクション: AIシステムを欺いて意図しない応答を生成させるために悪意のある入力を挿入します。

受賞歴と評価

- SC Awards Europe 2025でBest AI SolutionおよびBest New Companyを受賞。

- TechCrunch、Sifted、その他の出版物で特集。

よくある質問

- Mindgardが他のAIセキュリティ企業と異なる点は何ですか? Mindgardは、AIセキュリティにおける10年以上にわたる厳格な研究を誇り、最新の進歩と資格のある人材へのアクセスを保証します。

- Mindgardはさまざまな種類のAIモデルを処理できますか? はい、Mindgardはニューラルネットワークに依存せず、幅広いAIモデルをサポートしています。

- Mindgardはどのようにデータセキュリティとプライバシーを確保していますか? Mindgardは、AIコンポーネントのテストに独自のプラットフォームを使用するなど、安全なソフトウェア開発と運用に関する業界のベストプラクティスに従っています。当社はGDPRに準拠しており、2025年初頭にISO 27001認証を取得する予定です。

- Mindgardは現在使用しているLLMで動作しますか? はい、もちろんです。Mindgardは、ChatGPTのような人気のあるモデルを含む、AI、生成AI、およびLLMを保護するように設計されています。

- どのような種類の組織がMindgardを使用していますか? Mindgardは、金融サービス、ヘルスケア、製造、サイバーセキュリティなどの分野を含む、多様な組織にサービスを提供しています。

- 従来のAppSecツールがAIモデルで機能しないのはなぜですか? AIの導入と使用は、従来のツールでは対処できない新たなリスクをもたらします。LLMプロンプトインジェクションやジェイルブレイクなどの多くの新しいリスクは、AIシステムの確率的で不透明な性質を利用しており、これらは実行時にのみ明らかになります。これらのリスクを保護するには、根本的に新しいアプローチが必要です。

結論

Mindgardは、組織がAIシステムを新たな脅威から保護するのに役立つ包括的なAIセキュリティテストソリューションです。自動化されたレッドチーム機能、AI固有のリスクの特定、継続的なセキュリティテストにより、Mindgardは開発者が安全で信頼できるAIシステムを構築できるようにします。MindgardをAI SDLCに統合することで、組織はAIモデルとアプリケーションが安全かつ確実に動作することを保証できます。

"Mindgard" のベストな代替ツール

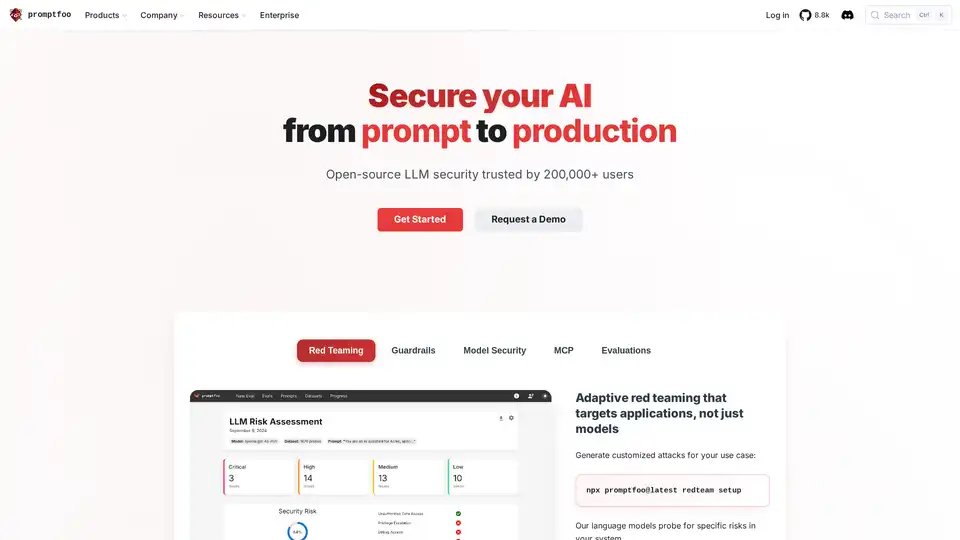

Promptfoo は、20 万人以上の開発者が AI レッドチーミングと評価に使用するオープンソースの LLM セキュリティツールです。AI アプリケーションの脆弱性の発見、出力品質の最大化、回帰の捕捉に役立ちます。

Autoblocks AIは、動的なテストケースの生成やSMEに合わせた評価指標などの機能を備え、特にハイリスクな業界において、チームが信頼性の高いAIアプリケーションを構築、テスト、展開できるようにするプラットフォームです。

Autoblocks AI は、シームレスなコラボレーション、正確な評価、合理化されたワークフローのためのツールを使用して、信頼性の高い AI アプリケーションを構築、テスト、デプロイするのに役立ちます。自信を持って AI ソリューションを提供します。

Hamming AIは、AI音声エージェントの自動テスト、通話分析、ガバナンスを提供します。通話をシミュレートし、会話を監査し、回帰を簡単に検出します。