ZETIC.MLange

Vue d'ensemble de ZETIC.MLange

ZETIC.ai : Créez des applications d’IA sur l’appareil à coût zéro

Qu’est-ce que ZETIC.ai ?

ZETIC.ai propose une plateforme, principalement par le biais de son service appelé ZETIC.MLange, qui permet aux développeurs de créer et de déployer des applications d’IA directement sur les appareils sans avoir à s’appuyer sur des serveurs GPU. Cette approche vise à réduire les coûts associés aux services d’IA et à améliorer la sécurité des données en tirant parti de l’IA sans serveur.

Principales fonctionnalités et avantages de ZETIC.MLange

- Réduction des coûts: En exécutant des modèles d’IA sur l’appareil, ZETIC.MLange réduit ou élimine considérablement le besoin de serveurs GPU coûteux, ce qui entraîne des économies substantielles.

- Sécurité améliorée: Le traitement des données sur l’appareil garantit que les informations sensibles restent sécurisées et privées, évitant ainsi les risques potentiels associés aux solutions d’IA basées sur le cloud.

- Optimisation des performances: ZETIC.MLange exploite l’utilisation de NPU (Neural Processing Unit) pour obtenir des performances d’exécution plus rapides sans sacrifier la précision. Il prétend être jusqu’à 60 fois plus rapide que les solutions basées sur le processeur.

- Pipeline automatisé: La plateforme offre un pipeline automatisé qui facilite la mise en œuvre des bibliothèques de modèles d’IA sur l’appareil. Il transforme les modèles d’IA en bibliothèques logicielles prêtes à l’emploi alimentées par NPU en environ 6 heures.

- Compatibilité étendue des appareils: ZETIC.ai évalue ses solutions sur plus de 200 appareils périphériques, garantissant ainsi une large compatibilité et des performances optimisées sur diverses plateformes matérielles.

Comment fonctionne ZETIC.MLange ?

ZETIC.MLange automatise le processus de conversion et d’optimisation des modèles d’IA pour qu’ils s’exécutent efficacement sur les appareils cibles. Cela comprend :

- Téléchargement du modèle: Les utilisateurs téléchargent leurs modèles d’IA existants sur la plateforme.

- Transformation automatisée: La plateforme transforme ensuite le modèle en une bibliothèque logicielle d’IA prête à l’emploi alimentée par NPU, optimisée pour l’appareil cible.

- Déploiement: Le modèle optimisé peut ensuite être déployé directement sur l’appareil, ce qui permet le traitement de l’IA sur l’appareil.

À qui s’adresse ZETIC.MLange ?

ZETIC.MLange est conçu pour :

- Les entreprises fournissant des services d’IA qui souhaitent réduire les coûts d’infrastructure.

- Les développeurs à la recherche de solutions d’IA sécurisées et privées.

- Les organisations cherchant à optimiser les performances de l’IA sur les appareils périphériques.

Pourquoi ZETIC.MLange est-il important ?

À mesure que l’IA se généralise, le besoin de solutions de déploiement efficaces et rentables se fait de plus en plus sentir. ZETIC.MLange répond à ce besoin en permettant le traitement de l’IA sur l’appareil, ce qui offre de nombreux avantages, notamment une réduction des coûts, une sécurité renforcée et des performances améliorées.

Comment démarrer avec ZETIC.MLange ?

Pour commencer à utiliser ZETIC.MLange, vous pouvez :

- Préparez votre modèle d’IA.

- Exécutez le service ZETIC.MLange.

- Déployez le modèle optimisé sur votre appareil cible.

Aucune information de paiement n’est requise pour commencer à utiliser le service.

Outils de Recherche et de Papiers en IA Outils d'Apprentissage Machine et Profond Jeux de Données et API d'IA Entraînement et Déploiement de Modèles IA

Meilleurs outils alternatifs à "ZETIC.MLange"

Activez l'inférence LLM efficace avec llama.cpp, une bibliothèque C/C++ optimisée pour divers matériels, prenant en charge la quantification, CUDA et les modèles GGUF. Idéal pour un déploiement local et cloud.

Qualcomm AI Hub est une plateforme pour l'IA sur l'appareil, offrant des modèles d'IA optimisés et des outils pour déployer et valider les performances sur les appareils Qualcomm. Il prend en charge différents environnements d'exécution et fournit un écosystème pour les solutions ML de bout en bout.

Mirai est une plateforme d'IA sur l'appareil permettant aux développeurs de déployer une IA haute performance directement dans leurs applications avec une latence nulle, une confidentialité totale des données et aucun coût d'inférence. Il offre un moteur d'inférence rapide et un routage intelligent pour des performances optimisées.

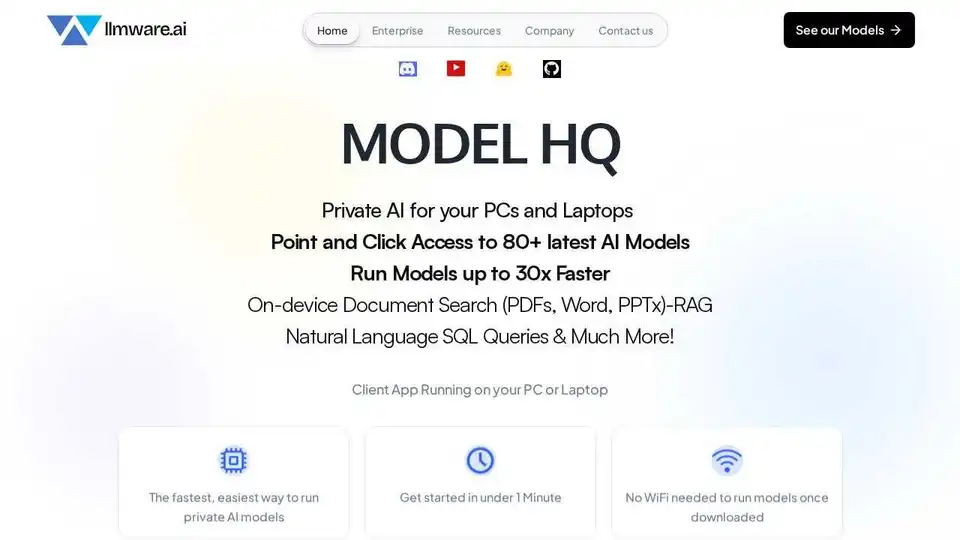

LLMWare AI : outils d'IA pionniers pour les secteurs de la finance, du droit et de la réglementation dans le cloud privé. Solution de bout en bout des LLM au framework RAG.