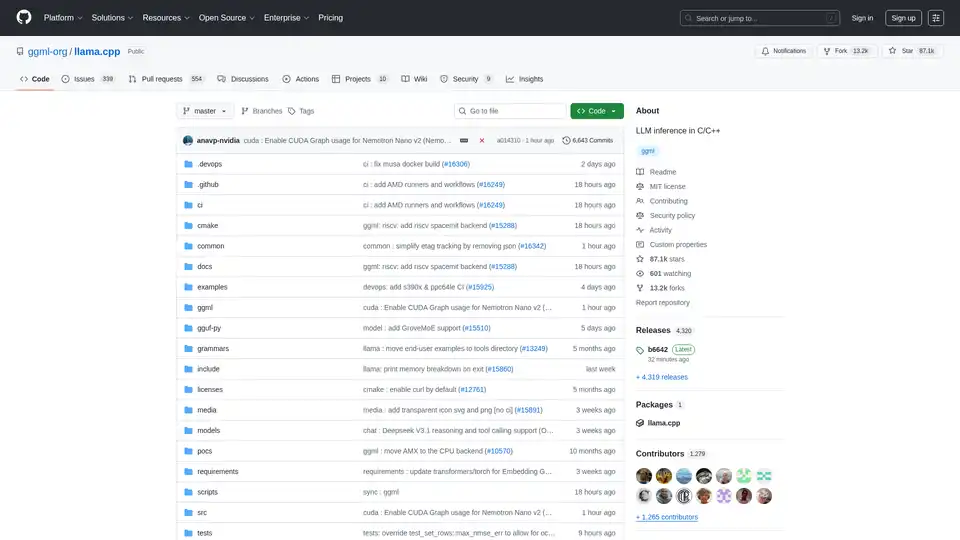

llama.cpp

Vue d'ensemble de llama.cpp

llama.cpp : Votre bibliothèque incontournable pour l’inférence LLM en C/C++

lama.cpp est une bibliothèque open source puissante conçue pour permettre une inférence efficace des grands modèles linguistiques (LLM) à l’aide de C/C++. Optimisée pour un large éventail de matériels, des machines locales aux déploiements cloud, elle se distingue par sa configuration minimale et ses performances de pointe.

Qu’est-ce que llama.cpp ?

lama.cpp est un projet axé sur l’exécution de l’inférence LLM en C/C++. Il est conçu pour offrir d’excellentes performances sur diverses configurations matérielles avec un minimum de dépendances.

Principales caractéristiques et avantages

- Implémentation C/C++ simple: Élimine les dépendances externes, ce qui simplifie le déploiement.

- Optimisation Apple Silicon: Tire parti des frameworks ARM NEON, Accelerate et Metal pour des performances optimales sur les appareils Apple.

- Prise en charge de l’architecture x86: Inclut la prise en charge d’AVX, d’AVX2, d’AVX512 et d’AMX pour des performances optimisées sur les processeurs x86.

- Quantification: Prend en charge la quantification d’entiers de 1,5 bit à 8 bits, ce qui réduit l’utilisation de la mémoire et accélère l’inférence.

- Accélération du GPU: Les noyaux CUDA personnalisés offrent une exécution LLM efficace sur les GPU NVIDIA. Prend également en charge les GPU AMD via HIP et les GPU Moore Threads via MUSA.

- Inférence CPU+GPU hybride: Facilite l’utilisation de modèles plus grands que la VRAM disponible en répartissant la charge de travail entre le CPU et le GPU.

- Plusieurs backends: Prend en charge Metal, BLAS, BLIS, SYCL, MUSA, CUDA, HIP, Vulkan, CANN, OpenCL, IBM zDNN et WebGPU (en cours).

Comment fonctionne llama.cpp ?

lama.cpp fonctionne en implémentant l’inférence LLM directement en C/C++. Cette approche réduit la surcharge et permet un contrôle précis des ressources matérielles. La bibliothèque est conçue pour être modulaire, avec différents backends optimisés pour diverses plateformes matérielles. Elle utilise des techniques telles que la quantification pour réduire l’empreinte mémoire des modèles, ce qui permet d’exécuter des modèles volumineux sur des appareils aux ressources limitées.

Comment utiliser llama.cpp ?

Installation:

- À l’aide de gestionnaires de paquets: Installez via brew, nix ou winget.

- Docker: Utilisez les images Docker fournies.

- Binaires précompilés: Téléchargez les binaires à partir de la page des versions.

- Compiler à partir de la source: Clonez le référentiel et suivez le guide de compilation.

Obtention de modèles:

- Téléchargez les modèles GGUF à partir de Hugging Face ou d’autres sites d’hébergement de modèles.

- Convertissez les modèles au format GGUF à l’aide des scripts Python fournis.

Exécution de l’inférence:

- Utilisez l’outil

llama-clipour l’expérimentation. - Déployez un serveur HTTP local à l’aide de

llama-serverpour la compatibilité avec l’API OpenAI.

- Utilisez l’outil

Exemples de commandes :

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

À qui s’adresse llama.cpp ?

lama.cpp est idéale pour :

- Les développeurs: Mise en œuvre d’applications alimentées par LLM avec C/C++.

- Les chercheurs: Expérimentation avec des LLM sur diverses plateformes matérielles.

- Les amateurs: Exécution de LLM sur des ordinateurs et des appareils personnels.

- Les organisations: Déploiement de LLM dans des environnements de production avec une surcharge minimale.

Applications pratiques de llama.cpp

lama.cpp peut être utilisée dans divers scénarios, notamment :

- Inférence LLM locale: Exécutez des modèles sur des ordinateurs personnels sans dépendre des services cloud.

- Informatique de périphérie: Déployez des LLM sur des appareils périphériques pour les applications à faible latence.

- Applications mobiles: Intégrez les LLM dans les applications mobiles pour le traitement sur l’appareil.

- Solutions d’IA personnalisées: Créez des solutions d’IA personnalisées adaptées à des environnements matériels et logiciels spécifiques.

Pourquoi choisir llama.cpp ?

lama.cpp offre une combinaison unique de performances, de flexibilité et de facilité d’utilisation, ce qui en fait un excellent choix pour l’inférence LLM. Ses principaux avantages sont les suivants :

- Performances optimisées: Conçue pour des performances optimales sur un large éventail de matériels.

- Dépendances minimales: Simplifie le déploiement et réduit le risque de conflits.

- Prise en charge de la quantification: Permet l’utilisation de modèles volumineux sur des appareils aux ressources limitées.

- Communauté active: Bénéficie d’un développement continu et du soutien de la communauté.

- Outils polyvalents: Inclut des outils tels que

llama-cli,llama-server,llama-perplexityetllama-benchpour divers cas d’utilisation.

Backends pris en charge

lama.cpp prend en charge plusieurs backends, ciblant un large éventail d’appareils :

| Backend | Target Devices |

|---|---|

| Metal | Apple Silicon |

| BLAS | All |

| BLIS | All |

| SYCL | Intel and Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | All (In Progress) |

| RPC | All |

Comment contribuer à llama.cpp

Les contributions à llama.cpp sont les bienvenues ! Vous pouvez contribuer en :

- Ouvrant des demandes d’extraction avec des corrections de bogues ou de nouvelles fonctionnalités.

- Collaborant sur les problèmes et les projets existants.

- Aidant à gérer les problèmes, les RP et les projets.

- Améliorant la documentation et les exemples.

Qu’est-ce que GGUF ?

GGUF est un format de fichier requis par llama.cpp pour le stockage des modèles. Les modèles dans d’autres formats de données peuvent être convertis en GGUF à l’aide des scripts Python convert_*.py dans le référentiel.

Conclusion

lama.cpp est une bibliothèque polyvalente et puissante qui rend l’inférence LLM accessible à un large public. Que vous soyez développeur, chercheur ou amateur, llama.cpp fournit les outils et la flexibilité dont vous avez besoin pour exploiter la puissance des LLM sur le matériel de votre choix. Grâce à son accent sur les performances, la facilité d’utilisation et le soutien de la communauté, llama.cpp est appelée à demeurer un acteur clé dans le paysage en évolution rapide de l’inférence de l’IA.

Pour plus d’informations, consultez le référentiel llama.cpp GitHub.

Assistant de Programmation par IA Complétion Automatique de Code Révision et Optimisation du Code par IA Développement Low-Code et No-Code par IA

Meilleurs outils alternatifs à "llama.cpp"

Explorez Qwen3 Coder, le modèle de génération de code IA avancé d'Alibaba Cloud. Découvrez ses fonctionnalités, benchmarks de performance et comment utiliser cet outil open-source puissant pour le développement.

xTuring est une bibliothèque open source qui permet aux utilisateurs de personnaliser et d'ajuster finement les Modèles de Langage Large (LLMs) de manière efficace, en se concentrant sur la simplicité, l'optimisation des ressources et la flexibilité pour la personnalisation de l'IA.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.