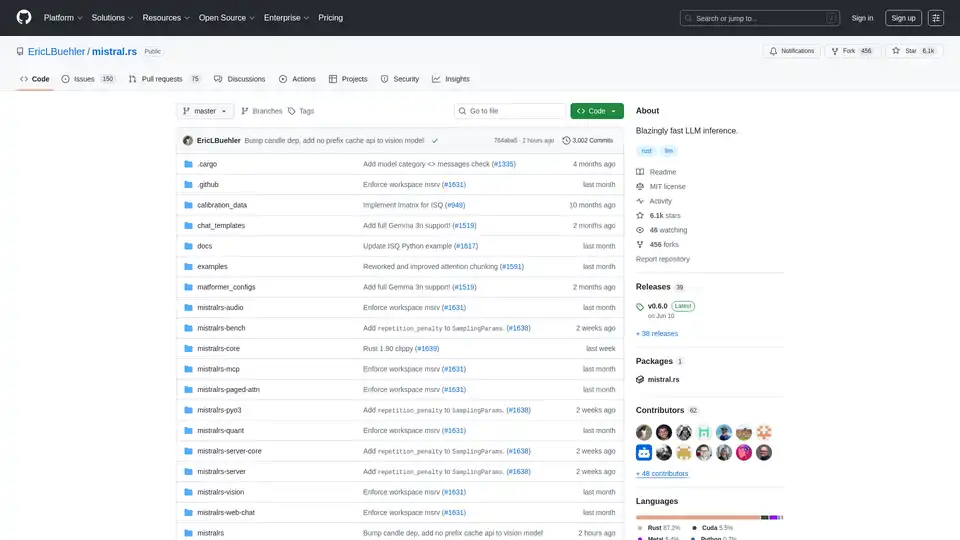

mistral.rs

Vue d'ensemble de mistral.rs

Qu'est-ce que mistral.rs ?

Mistral.rs est un moteur d'inférence de modèles de langage de grande taille (LLM) multiplateforme, incroyablement rapide, écrit en Rust. Il est conçu pour offrir des performances et une flexibilité élevées sur diverses plateformes et configurations matérielles. Prenant en charge les flux de travail multimodaux, mistral.rs gère le texte, la vision, la génération d'images et la parole.

Principales caractéristiques et avantages

- Flux de travail multimodal: Prend en charge le texte↔texte, le texte+vision↔texte, le texte+vision+audio↔texte, le texte→parole, le texte→image.

- API: Offre des API Rust, Python et serveur HTTP OpenAI (avec Chat Completions, API Responses) pour une intégration facile dans différents environnements.

- Client MCP: Se connecte automatiquement aux outils et services externes, tels que les systèmes de fichiers, la recherche web, les bases de données et autres API.

- Performance: Utilise des technologies telles que ISQ (quantification sur place), PagedAttention et FlashAttention pour des performances optimisées.

- Facilité d'utilisation: Inclut des fonctionnalités telles que le mappage automatique des appareils (multi-GPU, CPU), les modèles de chat et la détection automatique des tokenizer.

- Flexibilité: Prend en charge les adaptateurs LoRA & X-LoRA avec fusion de poids, AnyMoE pour la création de modèles MoE sur n'importe quel modèle de base et la quantification personnalisable.

Comment fonctionne mistral.rs ?

Mistral.rs exploite plusieurs techniques clés pour atteindre ses hautes performances :

- Quantification sur place (ISQ): Réduit l'empreinte mémoire et améliore la vitesse d'inférence en quantifiant les poids du modèle.

- PagedAttention & FlashAttention: Optimise l'utilisation de la mémoire et l'efficacité computationnelle pendant les mécanismes d'attention.

- Mappage automatique des appareils: Distribue automatiquement le modèle sur les ressources matérielles disponibles, y compris plusieurs GPU et CPU.

- MCP (Model Context Protocol): Permet une intégration transparente avec les outils et services externes en fournissant un protocole standardisé pour les appels d'outils.

Comment utiliser mistral.rs ?

Installation: Suivez les instructions d'installation fournies dans la documentation officielle. Cela implique généralement l'installation de Rust et le clonage du dépôt mistral.rs.

Acquisition du modèle: Obtenez le modèle LLM souhaité. Mistral.rs prend en charge divers formats de modèles, notamment les modèles Hugging Face, GGUF et GGML.

Utilisation de l'API: Utilisez les API Rust, Python ou serveur HTTP compatible OpenAI pour interagir avec le moteur d'inférence. Des exemples et une documentation sont disponibles pour chaque API.

- API Python:

pip install mistralrs - API Rust:

Ajoutez

mistralrs = { git = "https://github.com/EricLBuehler/mistral.rs.git" }à votreCargo.toml.

- API Python:

Exécutez le serveur: Lancez le mistralrs-server avec les options de configuration appropriées. Cela peut impliquer de spécifier le chemin du modèle, la méthode de quantification et d'autres paramètres.

./mistralrs-server --port 1234 run -m microsoft/Phi-3.5-MoE-instruct

Cas d'utilisation

Mistral.rs convient à une large gamme d'applications, notamment :

- Chatbots et IA conversationnelle: Alimentez des chatbots interactifs et attrayants avec une inférence à haute performance.

- Génération de texte: Générez du texte réaliste et cohérent à des fins diverses, telles que la création de contenu et la synthèse.

- Analyse d'images et de vidéos: Traitez et analysez les données visuelles avec des capacités de vision intégrées.

- Reconnaissance et synthèse vocales: Activez les interactions vocales avec la prise en charge du traitement audio.

- Appels d'outils et automatisation: Intégrez-vous à des outils et services externes pour les flux de travail automatisés.

À qui s'adresse mistral.rs ?

Mistral.rs est conçu pour :

- Les développeurs: Qui ont besoin d'un moteur d'inférence LLM rapide et flexible pour leurs applications.

- Les chercheurs: Qui explorent de nouveaux modèles et techniques de traitement du langage naturel.

- Les organisations: Qui ont besoin de capacités d'IA à haute performance pour leurs produits et services.

Pourquoi choisir mistral.rs ?

- Performance: Offre des vitesses d'inférence incroyablement rapides grâce à des techniques telles que ISQ, PagedAttention et FlashAttention.

- Flexibilité: Prend en charge une large gamme de modèles, de méthodes de quantification et de configurations matérielles.

- Facilité d'utilisation: Fournit des API simples et des options de configuration automatique pour une intégration facile.

- Extensibilité: Permet l'intégration avec des outils et services externes via le protocole MCP.

Accélérateurs pris en charge

Mistral.rs prend en charge une variété d'accélérateurs :

- GPU NVIDIA (CUDA) : Utilisez les indicateurs de fonctionnalité

cuda,flash-attnetcudnn. - GPU Apple Silicon (Metal) : Utilisez l'indicateur de fonctionnalité

metal. - CPU (Intel) : Utilisez l'indicateur de fonctionnalité

mkl. - CPU (Apple Accelerate) : Utilisez l'indicateur de fonctionnalité

accelerate. - CPU générique (ARM/AVX) : Activé par défaut.

Pour activer les fonctionnalités, transmettez-les à Cargo :

cargo build --release --features "cuda flash-attn cudnn"

Communauté et support

Conclusion

Mistral.rs se distingue comme un moteur d'inférence LLM puissant et polyvalent, offrant des performances ultra-rapides, une flexibilité étendue et des capacités d'intégration transparentes. Sa nature multiplateforme et sa prise en charge des flux de travail multimodaux en font un excellent choix pour les développeurs, les chercheurs et les organisations qui cherchent à exploiter la puissance des grands modèles de langage dans une variété d'applications. En tirant parti de ses fonctionnalités avancées et de ses API, les utilisateurs peuvent créer des solutions d'IA innovantes et percutantes en toute simplicité.

Pour ceux qui cherchent à optimiser leur infrastructure d'IA et à libérer tout le potentiel des LLM, mistral.rs fournit une solution robuste et efficace qui est bien adaptée aux environnements de recherche et de production.

Assistant de Programmation par IA Complétion Automatique de Code Révision et Optimisation du Code par IA Développement Low-Code et No-Code par IA

Meilleurs outils alternatifs à "mistral.rs"

Spice.ai est un moteur d'inférence de données et d'IA open source pour créer des applications d'IA avec la fédération de requêtes SQL, l'accélération, la recherche et la récupération basées sur les données d'entreprise.

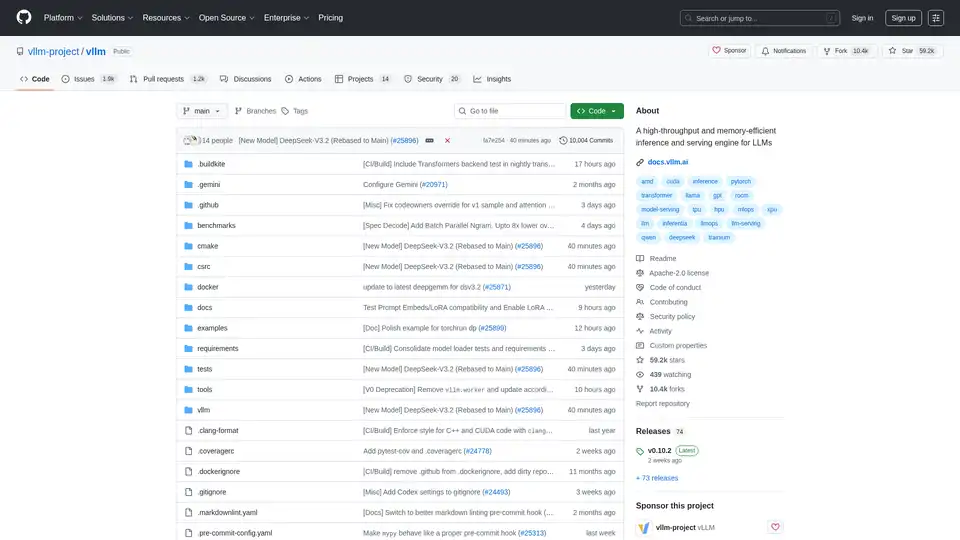

vLLM est un moteur d'inférence et de service à haut débit et à faible consommation de mémoire pour les LLM, doté de PagedAttention et d'un traitement par lots continu pour des performances optimisées.

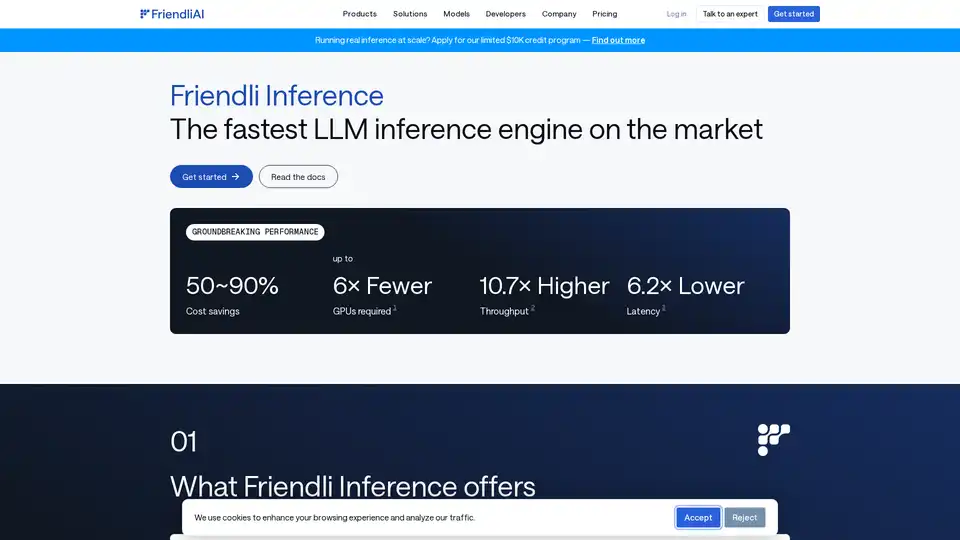

Friendli Inference est le moteur d'inférence LLM le plus rapide, optimisé pour la vitesse et la rentabilité, réduisant les coûts GPU de 50 à 90 % tout en offrant un débit élevé et une faible latence.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.