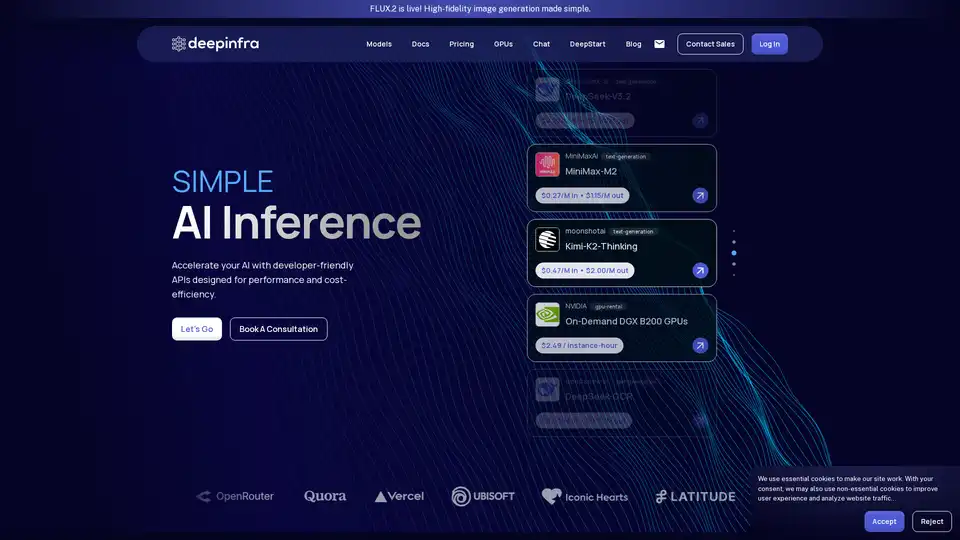

Deep Infra

Vue d'ensemble de Deep Infra

Qu'est-ce que Deep Infra ?

Deep Infra est une plateforme puissante spécialisée dans l'inférence IA pour les modèles de machine learning, offrant un accès économique, rapide, simple et fiable à plus de 100 modèles de deep learning prêts pour la production. Que vous exécutiez des modèles de langage large (LLMs) comme DeepSeek-V3.2 ou des outils OCR spécialisés, les API conviviales pour les développeurs de Deep Infra facilitent l'intégration d'IA haute performance dans vos applications sans la gestion d'infrastructure. Construite sur du hardware de pointe optimisé pour l'inférence dans des centres de données sécurisés basés aux États-Unis, elle supporte l'échelle à des trillions de tokens tout en priorisant l'efficacité des coûts, la confidentialité et les performances.

Idéale pour les startups et les entreprises, Deep Infra élimine les contrats à long terme et les frais cachés avec sa tarification pay-as-you-go, vous ne payez que ce que vous utilisez. Avec les certifications SOC 2 et ISO 27001, plus une politique stricte de rétention zéro, vos données restent privées et sécurisées.

Fonctionnalités clés de Deep Infra

Deep Infra se distingue dans le paysage encombré de l'infrastructure machine learning avec ces capacités principales :

Vaste bibliothèque de modèles : Accédez à plus de 100 modèles dans des catégories comme la génération de texte, la reconnaissance vocale automatique, la synthèse vocale et l'OCR. Modèles phares incluent :

- DeepSeek-V3.2 : LLM efficace avec attention éparse pour le raisonnement en contexte long.

- MiniMax-M2 : Modèle compact de 10B paramètres pour les tâches de codage et agentiques.

- Série Qwen3 : Modèles scalables pour le suivi d'instructions et les modes de pensée.

- Spécialistes OCR comme DeepSeek-OCR, olmOCR-2-7B et PaddleOCR-VL pour l'analyse de documents.

Tarification économique : Taux ultra-bas, p. ex. 0,03 $/M entrée pour DeepSeek-OCR, 0,049 $/M pour gpt-oss-120b. Tarification en cache réduit encore les coûts pour les requêtes répétées.

Performances scalables : Gère des trillions de tokens avec des métriques comme 0 ms temps-au-premier-token (en démos live) et exaFLOPS de calcul. Supporte jusqu'à 256k de longueur de contexte.

Location de GPU : GPU NVIDIA DGX B200 à la demande à 2,49 $/heure d'instance pour charges de travail personnalisées.

Sécurité & Conformité : Zéro rétention entrée/sortie, SOC 2 Type II, certifié ISO 27001.

Personnalisation : Inférence adaptée pour priorités latence, débit ou échelle, avec support pratique.

| Exemple de Modèle | Type | Tarification (entrée/sortie par 1M tokens) | Longueur de Contexte |

|---|---|---|---|

| DeepSeek-V3.2 | text-generation | 0,27 \(/ 0,40\) | 160k |

| gpt-oss-120b | text-generation | 0,049 \(/ 0,20\) | 128k |

| DeepSeek-OCR | text-generation | 0,03 \(/ 0,10\) | 8k |

| DGX B200 GPUs | gpu-rental | 2,49 $/heure | N/A |

Comment fonctionne Deep Infra ?

Démarrer avec Deep Infra est simple :

Inscription et Accès API : Créez un compte gratuit, obtenez votre clé API et intégrez via des endpoints RESTful simples—aucune configuration complexe requise.

Sélectionner des Modèles : Choisissez dans le catalogue (p. ex. via dashboard ou docs) supportant des fournisseurs comme DeepSeek-AI, OpenAI, Qwen et MoonshotAI.

Exécuter l'Inférence : Envoyez des prompts via appels API. Des modèles comme DeepSeek-V3.1-Terminus supportent des modes de raisonnement configurables (pensant/non-pensant) et l'utilisation d'outils pour workflows agentiques.

Scaler & Surveiller : Métriques live suivent tokens/sec, TTFT, RPS et dépenses. Hébergez vos propres modèles sur leurs serveurs pour la confidentialité.

Optimiser : Exploitez des optimisations comme la quantification FP4/FP8, attention éparse (p. ex. DSA dans DeepSeek-V3.2) et architectures MoE pour l'efficacité.

L'infrastructure propriétaire de la plateforme assure une faible latence et une haute fiabilité, surpassant les fournisseurs cloud génériques pour l'inférence deep learning.

Cas d'Usage et Valeur Pratique

Deep Infra excelle dans les applications IA réelles :

Développeurs & Startups : Prototypage rapide de chatbots, agents de code ou générateurs de contenu avec des LLMs abordables.

Entreprises : Déploiements à échelle de production pour OCR dans le traitement de documents (p. ex. PDFs avec tableaux/graphiques via PaddleOCR-VL), analyse financière ou agents personnalisés.

Chercheurs : Expérimentez avec des modèles de pointe comme Kimi-K2-Thinking (performance médaille d'or IMO) sans coûts hardware.

Workflows Agentiques : Modèles comme DeepSeek-V3.1 supportent l'appel d'outils, la synthèse de code et le raisonnement en contexte long pour systèmes autonomes.

Les utilisateurs rapportent 10x d'économies de coûts vs. concurrents, avec un scaling fluide—parfait pour gérer les pics de charge dans les apps SaaS ou traitement par lots.

Pour Qui est Deep Infra ?

Ingénieurs IA/ML : Besoin d'hébergement de modèles fiable et d'API.

Équipes Produit : Construisant des fonctionnalités IA sans surcharge infra.

Innovateurs Sensibles aux Coûts : Startups optimisant le burn rate sur tâches high-compute.

Orgs Focalisées sur la Conformité : Gérant des données sensibles avec garanties de rétention zéro.

Pourquoi Choisir Deep Infra Plutôt que les Alternatives ?

Contrairement aux hyperscalers avec minimums élevés ou douleurs d'auto-hébergement, Deep Infra combine la facilité OpenAI avec 50-80% de coûts inférieurs. Pas de vendor lock-in, accessibilité globale et mises à jour actives de modèles (p. ex. FLUX.2 pour images). Soutenu par des métriques réelles et succès utilisateurs en benchmarks codage (LiveCodeBench), raisonnement (GPQA) et usage d'outils (Tau2).

Prêt à accélérer ? Réservez une consultation ou plongez dans les docs pour une infrastructure IA scalable dès aujourd'hui. Deep Infra propulse la prochaine vague d'IA efficace et de grade production.

Outils de Recherche et de Papiers en IA Outils d'Apprentissage Machine et Profond Jeux de Données et API d'IA Entraînement et Déploiement de Modèles IA

Meilleurs outils alternatifs à "Deep Infra"

Awan LLM fournit une plateforme d'API d'inférence LLM illimitée, sans restriction et rentable. Il permet aux utilisateurs et aux développeurs d'accéder à de puissants modèles LLM sans limitations de jetons, idéal pour les agents d'IA, les jeux de rôle, le traitement des données et la complétion de code.

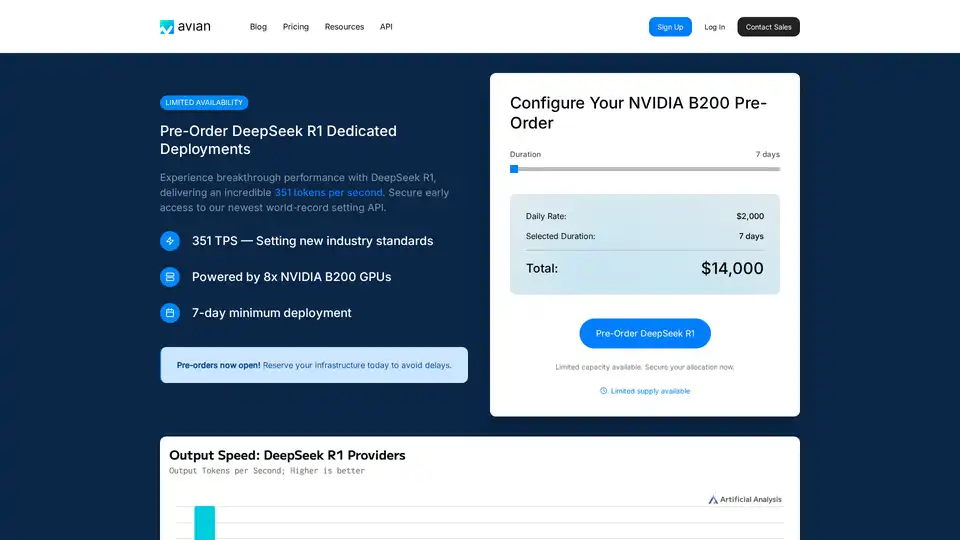

Avian API offre l’inférence d’IA la plus rapide pour les LLM open source, atteignant 351 TPS sur DeepSeek R1. Déployez n’importe quel LLM HuggingFace à une vitesse 3 à 10 fois supérieure grâce à une API compatible OpenAI. Performances et confidentialité de niveau entreprise.

Le service d'inférence Nebius AI Studio propose des modèles open source hébergés pour des résultats plus rapides, moins chers et plus précis que les API propriétaires. Évoluez sans MLOps, idéal pour RAG et les charges de production.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.