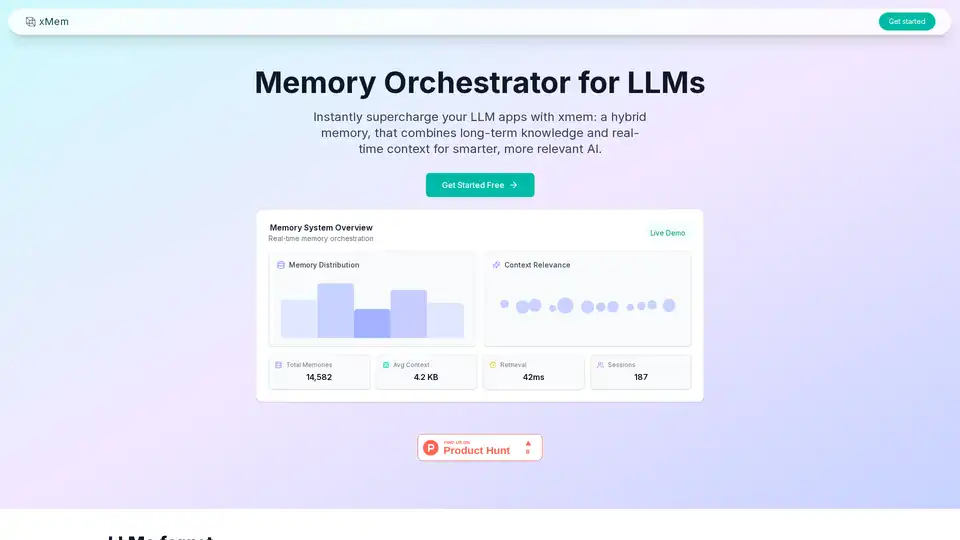

xMem

Descripción general de xMem

¿Qué es xMem?

xMem es un sistema de memoria híbrido diseñado para Modelos de Lenguaje Grande (LLMs). Combina conocimiento a largo plazo y contexto en tiempo real para mejorar la relevancia y precisión de las interacciones con IA. xMem garantiza que los LLMs retengan contexto y conocimiento entre sesiones, haciendo que cada interacción sea más inteligente y relevante.

Características Clave de xMem

- Memoria a Largo Plazo: Almacena y recupera conocimiento, notas y documentos con búsqueda vectorial.

- Memoria de Sesión: Realiza un seguimiento de chats recientes, instrucciones y contexto para actualización y personalización.

- Orquestación RAG: Ensambla automáticamente el mejor contexto para cada llamada LLM sin ajuste manual.

- Grafo de Conocimiento: Visualiza conexiones entre conceptos, hechos y contexto del usuario en tiempo real.

- Open-Source First: Funciona con cualquier LLM de código abierto (Llama, Mistral, etc.) y base de datos vectorial.

- Integración Sin Esfuerzo: API y panel de control fáciles para una integración y monitoreo sin problemas.

¿Cómo Funciona xMem?

xMem orquestra tanto la memoria persistente como la de sesión para cada llamada LLM. Esto garantiza que tu IA siempre sea relevante, precisa y actualizada. El sistema utiliza bases de datos vectoriales como Qdrant, ChromaDB y Pinecone para búsqueda y recuperación semántica, e integra proveedores de LLM como Llama.cpp, Ollama y OpenAI.

¿Por Qué Elegir xMem?

- Nunca Pierdas Conocimiento: La memoria persistente garantiza que el conocimiento y contexto del usuario siempre estén disponibles.

- Mejora la Precisión de LLM: El contexto orquestado hace que cada respuesta LLM sea más relevante y precisa.

- Open-Source First: Compatible con cualquier LLM y base de datos vectorial de código abierto.

- Integración Sin Esfuerzo: API y panel de control fáciles para una integración y monitoreo sin problemas.

¿Para Quién es xMem?

xMem es ideal para desarrolladores y organizaciones que buscan mejorar sus aplicaciones LLM con gestión avanzada de memoria. Es particularmente útil para aplicaciones que requieren retención de conocimiento a largo plazo y gestión de contexto en tiempo real, como asistentes de IA, chatbots y sistemas de gestión de conocimiento.

La Mejor Forma de Usar xMem

Para comenzar con xMem, puedes integrarlo en tus aplicaciones LLM existentes utilizando la API y el panel de control proporcionados. El sistema está diseñado para ser fácil de usar y requiere un ajuste manual mínimo, lo que lo convierte en una herramienta poderosa para mejorar las interacciones con IA.

Gestión de Tareas y Proyectos con IA Resumido y Lectura de Documentos con IA Búsqueda Inteligente con IA Análisis de Datos con IA Flujo de Trabajo Automatizado

Mejores herramientas alternativas a "xMem"

Falcon LLM es una familia de modelos de lenguaje grandes generativos de código abierto de TII, con modelos como Falcon 3, Falcon-H1 y Falcon Arabic para aplicaciones de IA multilingües y multimodales que se ejecutan eficientemente en dispositivos cotidianos.

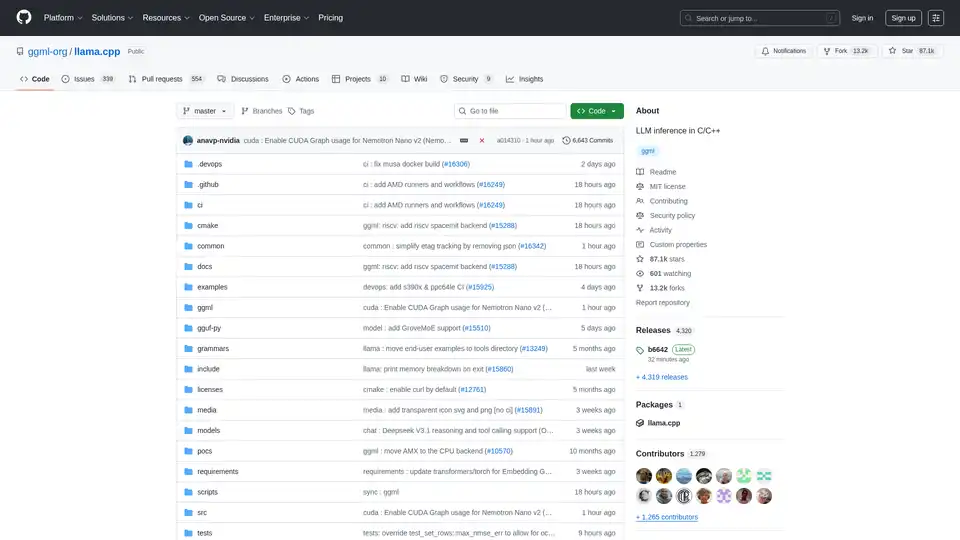

Habilite la inferencia LLM eficiente con llama.cpp, una biblioteca C/C++ optimizada para diversos hardware, que admite cuantificación, CUDA y modelos GGUF. Ideal para implementación local y en la nube.

Crea personas de IA con Personal AI, entrénalas con tus datos y escala tu fuerza laboral de forma segura. Aumenta la eficiencia y optimiza los flujos de trabajo con compañeros de equipo de IA.

BotDistrikt es una plataforma de chatbot centrada en la experiencia del usuario para startups y empresas. Cree chatbots impulsados por IA y orientados a la personalidad sin necesidad de código. Califique clientes potenciales, automatice encuestas y mejore la participación del cliente.