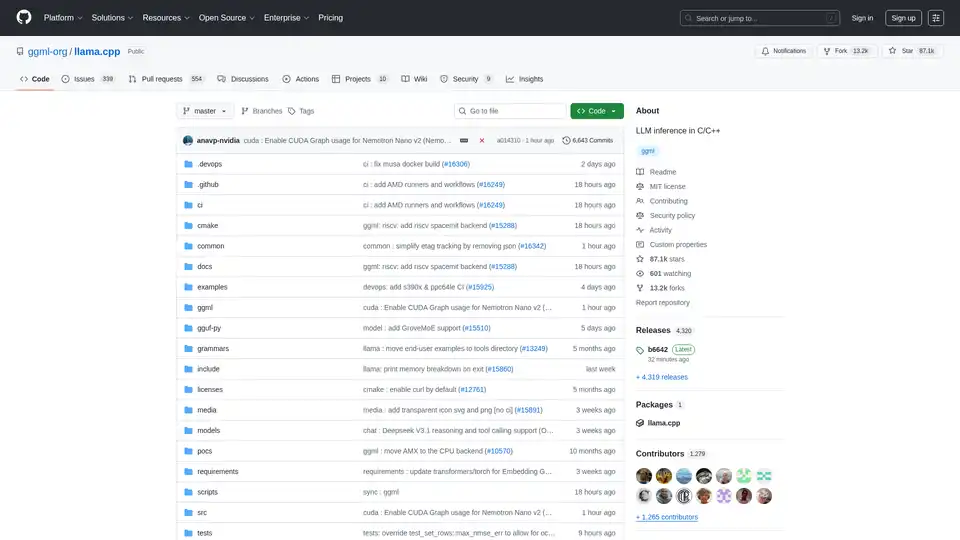

llama.cpp

Descripción general de llama.cpp

llama.cpp: Tu biblioteca de referencia para la inferencia de LLM en C/C++

lama.cpp es una biblioteca de código abierto potente, diseñada para permitir la inferencia eficiente de modelos de lenguaje grandes (LLM) utilizando C/C++. Optimizada para una amplia gama de hardware, desde máquinas locales hasta implementaciones en la nube, destaca por su configuración mínima y su rendimiento de última generación.

¿Qué es llama.cpp?

lama.cpp es un proyecto centrado en realizar la inferencia de LLM en C/C++. Está diseñado para proporcionar un rendimiento excelente en diversas configuraciones de hardware con dependencias mínimas.

Características y ventajas principales

- Implementación en C/C++ puro: Elimina dependencias externas, simplificando la implementación.

- Optimización de Apple Silicon: Aprovecha los frameworks ARM NEON, Accelerate y Metal para obtener el máximo rendimiento en dispositivos Apple.

- Soporte de arquitectura x86: Incluye soporte AVX, AVX2, AVX512 y AMX para un rendimiento optimizado en CPUs x86.

- Cuantificación: Soporta la cuantificación de enteros de 1.5 bits a 8 bits, reduciendo el uso de memoria y acelerando la inferencia.

- Aceleración de GPU: Los kernels CUDA personalizados proporcionan una ejecución eficiente de LLM en GPUs NVIDIA. También es compatible con las GPUs AMD a través de HIP y con las GPUs Moore Threads a través de MUSA.

- Inferencia híbrida CPU+GPU: Facilita el uso de modelos más grandes que la VRAM disponible distribuyendo la carga de trabajo entre la CPU y la GPU.

- Múltiples backends: Soporta Metal, BLAS, BLIS, SYCL, MUSA, CUDA, HIP, Vulkan, CANN, OpenCL, IBM zDNN y WebGPU (en progreso).

¿Cómo funciona llama.cpp?

lama.cpp funciona implementando la inferencia de LLM directamente en C/C++. Este enfoque reduce la sobrecarga y permite un control preciso sobre los recursos de hardware. La biblioteca está diseñada para ser modular, con diferentes backends optimizados para varias plataformas de hardware. Utiliza técnicas como la cuantificación para reducir la huella de memoria de los modelos, lo que permite ejecutar modelos grandes en dispositivos con recursos limitados.

¿Cómo utilizar llama.cpp?

Instalación:

- Usando administradores de paquetes: Instalar a través de brew, nix o winget.

- Docker: Utilizar las imágenes Docker proporcionadas.

- Binarios precompilados: Descargar los binarios de la página de releases.

- Compilar desde el código fuente: Clonar el repositorio y seguir la guía de compilación.

Obtención de modelos:

- Descargar modelos GGUF de Hugging Face u otros sitios de alojamiento de modelos.

- Convertir modelos al formato GGUF utilizando los scripts de Python proporcionados.

Ejecución de la inferencia:

- Utilizar la herramienta

llama-clipara la experimentación. - Implementar un servidor HTTP local utilizando

llama-serverpara la compatibilidad con la API de OpenAI.

- Utilizar la herramienta

Comandos de ejemplo:

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

¿Para quién es llama.cpp?

lama.cpp es ideal para:

- Desarrolladores: Implementación de aplicaciones impulsadas por LLM con C/C++.

- Investigadores: Experimentación con LLMs en varias plataformas de hardware.

- Aficionados: Ejecución de LLMs en ordenadores y dispositivos personales.

- Organizaciones: Implementación de LLMs en entornos de producción con una sobrecarga mínima.

Aplicaciones prácticas de llama.cpp

lama.cpp se puede utilizar en varios escenarios, incluyendo:

- Inferencia de LLM local: Ejecutar modelos en ordenadores personales sin depender de los servicios en la nube.

- Edge Computing: Implementar LLMs en dispositivos edge para aplicaciones de baja latencia.

- Aplicaciones móviles: Integrar LLMs en aplicaciones móviles para el procesamiento en el dispositivo.

- Soluciones de IA personalizadas: Construir soluciones de IA personalizadas adaptadas a entornos de hardware y software específicos.

¿Por qué elegir llama.cpp?

lama.cpp proporciona una combinación única de rendimiento, flexibilidad y facilidad de uso, lo que la convierte en una excelente opción para la inferencia de LLM. Sus principales ventajas incluyen:

- Rendimiento optimizado: Diseñada para un rendimiento máximo en una amplia gama de hardware.

- Dependencias mínimas: Simplifica la implementación y reduce el riesgo de conflictos.

- Soporte de cuantificación: Permite el uso de modelos grandes en dispositivos con recursos limitados.

- Comunidad activa: Se beneficia del desarrollo continuo y del soporte de la comunidad.

- Herramientas versátiles: incluye herramientas como

llama-cli,llama-server,llama-perplexityyllama-benchpara varios casos de uso.

Backends soportados

lama.cpp soporta múltiples backends, dirigidos a una amplia gama de dispositivos:

| Backend | Target Devices |

|---|---|

| Metal | Apple Silicon |

| BLAS | All |

| BLIS | All |

| SYCL | Intel and Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | All (In Progress) |

| RPC | All |

Cómo contribuir a llama.cpp

¡Las contribuciones a llama.cpp son bienvenidas! Puedes contribuir mediante:

- Abrir pull requests con correcciones de errores o nuevas funcionalidades.

- Colaborar en problemas y proyectos existentes.

- Ayudar a gestionar problemas, PRs y proyectos.

- Mejorar la documentación y los ejemplos.

¿Qué es GGUF?

GGUF es un formato de archivo requerido por llama.cpp para almacenar modelos. Los modelos en otros formatos de datos pueden convertirse a GGUF utilizando los scripts de Python convert_*.py en el repositorio.

Conclusión

lama.cpp es una biblioteca versátil y potente que hace que la inferencia de LLM sea accesible a un público amplio. Tanto si eres desarrollador, investigador o aficionado, llama.cpp te proporciona las herramientas y la flexibilidad que necesitas para aprovechar la potencia de los LLM en el hardware que elijas. Con su enfoque en el rendimiento, la facilidad de uso y el soporte de la comunidad, llama.cpp está preparada para seguir siendo un actor clave en el panorama de la inferencia de IA, que evoluciona rápidamente.

Para obtener más información, visita el repositorio de llama.cpp en GitHub.

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "llama.cpp"

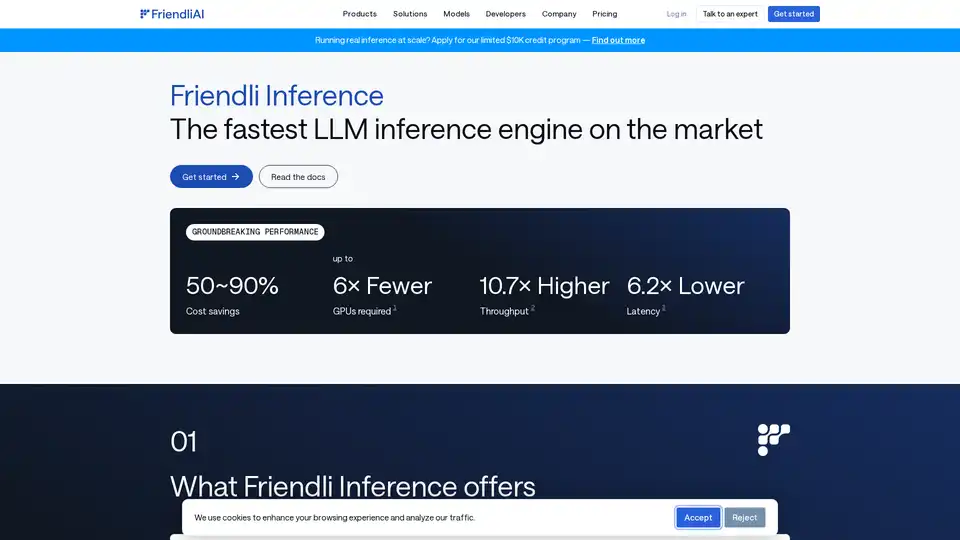

Friendli Inference es el motor de inferencia LLM más rápido, optimizado para la velocidad y la rentabilidad, reduciendo los costos de GPU en un 50-90% al tiempo que ofrece un alto rendimiento y baja latencia.

Plataforma de IA ultrarrápida para desarrolladores. Implementa, ajusta y ejecuta más de 200 LLMs y modelos multimodales optimizados con APIs simples - SiliconFlow.

xTuring es una biblioteca de código abierto que permite a los usuarios personalizar y ajustar finamente Modelos de Lenguaje Grandes (LLMs) de manera eficiente, enfocándose en simplicidad, optimización de recursos y flexibilidad para personalización de IA.