Prompt Token Counter for OpenAI Models

Descripción general de Prompt Token Counter for OpenAI Models

Contador de Tokens de Prompt: Una Herramienta Simple para la Estimación de Tokens del Modelo OpenAI

¿Qué es el Contador de Tokens de Prompt?

El Contador de Tokens de Prompt es una herramienta en línea diseñada para ayudar a los usuarios a estimar el número de tokens que consumirán sus prompts al usar modelos de OpenAI como GPT-3.5, GPT-4 y otros. Comprender el uso de tokens es crucial para mantenerse dentro de los límites del modelo y administrar los costos de manera efectiva.

¿Cómo funciona el Contador de Tokens de Prompt?

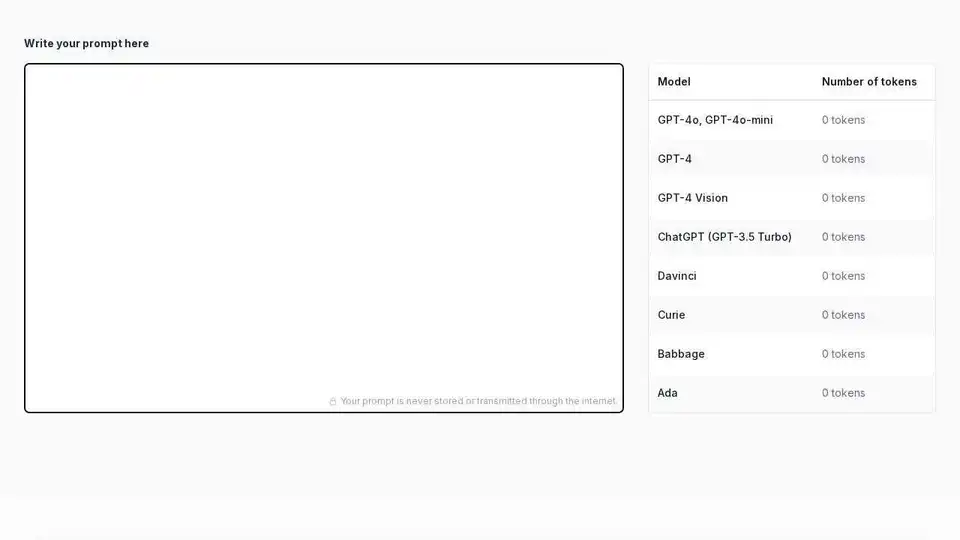

Simplemente escribe o pega tu prompt en el área de texto proporcionada. La herramienta calcula y muestra instantáneamente el recuento de tokens para varios modelos de OpenAI, incluidos GPT-4o, GPT-4, ChatGPT (GPT-3.5 Turbo), Davinci, Curie, Babbage y Ada. El contador se actualiza en tiempo real a medida que escribes, proporcionando retroalimentación inmediata sobre el uso de tokens.

¿Por qué es importante el Contador de Tokens de Prompt?

- Mantente dentro de los límites del modelo: Los modelos de OpenAI tienen límites en la cantidad de tokens que pueden procesar en una sola interacción. Exceder estos límites puede resultar en errores o salidas truncadas.

- Control de costos: OpenAI cobra según el uso de tokens. Estimar el recuento de tokens te ayuda a administrar los costos y evitar gastos inesperados.

- Ingeniería de prompts eficiente: Comprender los recuentos de tokens te permite crear prompts concisos y efectivos que maximicen las capacidades del modelo sin exceder los límites.

Características Clave:

- Conteo de tokens en tiempo real: El recuento de tokens se actualiza instantáneamente a medida que escribes, proporcionando retroalimentación inmediata.

- Soporte para múltiples modelos de OpenAI: La herramienta es compatible con una amplia gama de modelos de OpenAI, incluidos los últimos GPT-4o, GPT-4, ChatGPT y modelos más antiguos como Davinci y Ada.

- Enfoque en la privacidad: Tus prompts nunca se almacenan ni se transmiten a través de Internet, lo que garantiza tu privacidad.

Cómo usar el Contador de Tokens de Prompt:

- Visita el sitio web del Contador de Tokens de Prompt.

- Escribe o pega tu prompt en el área de texto.

- Observa el recuento de tokens para el modelo OpenAI deseado.

- Ajusta tu prompt según sea necesario para mantenerte dentro de los límites de tokens.

Entendiendo los Tokens:

En el procesamiento del lenguaje natural, un token es la unidad de texto más pequeña que procesa un modelo. Los tokens pueden ser palabras, caracteres o subpalabras, según el método de tokenización utilizado. Diferentes modelos podrían tokenizar el mismo texto de manera ligeramente diferente.

¿Qué es un Prompt?

Un prompt es la entrada que proporcionas a un modelo de lenguaje para iniciar una tarea o generar una respuesta. Un prompt bien elaborado es claro, conciso e incluye toda la información necesaria para obtener el resultado deseado del modelo. Establece el contexto para la salida subsiguiente del modelo. Por ejemplo, proporcionar al modelo "Escribe un poema corto sobre el océano" es un prompt. La calidad y la especificidad de tu prompt influyen en gran medida en el resultado generado.

Mantenerse Dentro de los Límites de Tokens:

Mantenerse dentro de los límites de tokens es crucial por varias razones:

- Prevención de errores: Exceder los límites de tokens puede causar errores o respuestas incompletas del modelo.

- Administración de costos: OpenAI cobra según el uso de tokens, por lo que mantenerse dentro de los límites ayuda a controlar los gastos.

- Optimización del rendimiento: Los prompts más cortos y enfocados a veces pueden producir mejores resultados que los largos y divagantes.

Al usar el Contador de Tokens de Prompt, puedes asegurarte de que tus prompts estén optimizados para el costo y el rendimiento al usar modelos de OpenAI.

Mejores herramientas alternativas a "Prompt Token Counter for OpenAI Models"

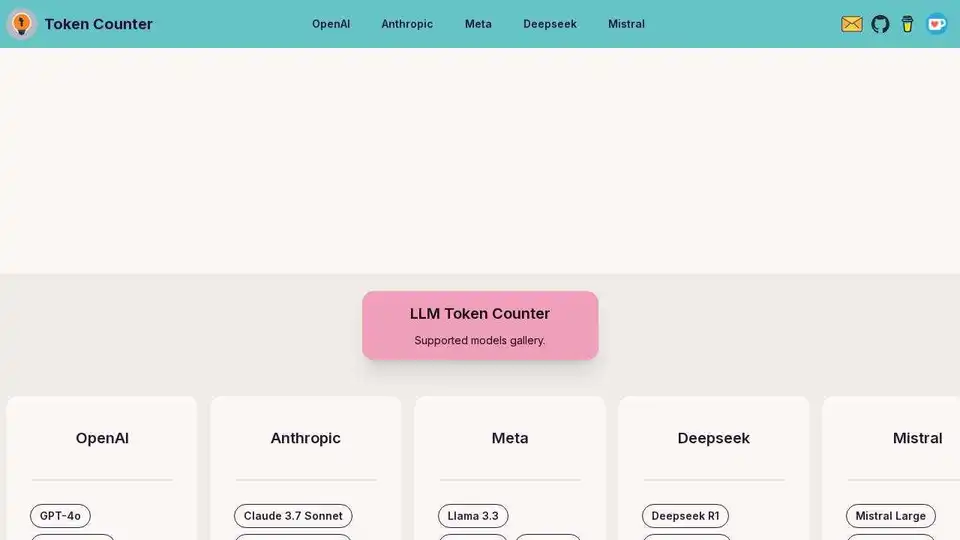

LLM Token Counter es una herramienta basada en el navegador para calcular tokens en prompts para LLMs populares como GPT-4, Claude-3 y Llama-3. Garantiza privacidad y velocidad mediante procesamiento del lado del cliente.

AskCodi es una plataforma API impulsada por IA que simplifica el desarrollo de código al proporcionar acceso a múltiples modelos de IA como GPT-4, Claude y Gemini a través de una única interfaz. Agilice su flujo de trabajo y cree aplicaciones más inteligentes.

16x Prompt es una herramienta de codificación de IA para gestionar el contexto del código, personalizar los prompts y enviar funciones más rápido con integraciones de API LLM. Ideal para desarrolladores que buscan una codificación eficiente asistida por IA.

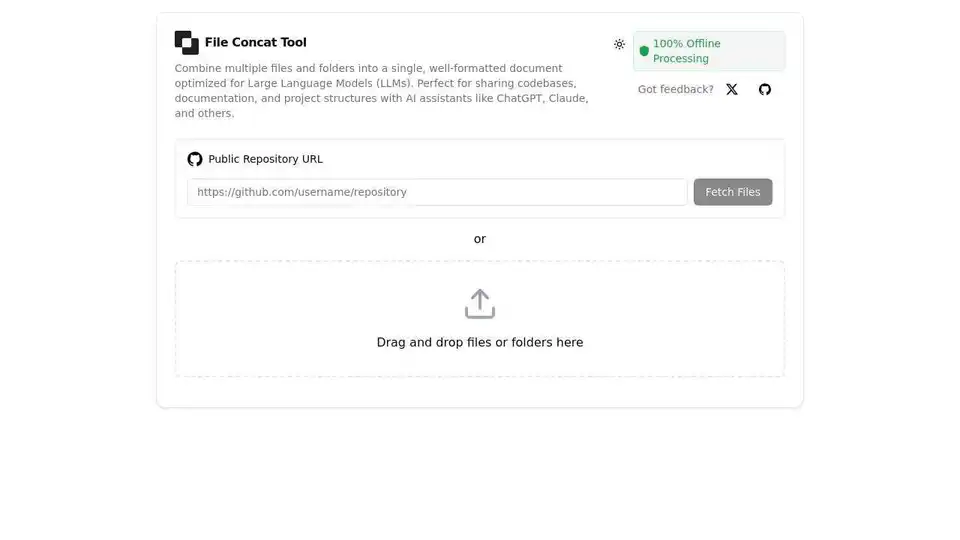

FileConcat es una herramienta en línea gratuita que combina múltiples archivos y carpetas en un solo documento bien formateado, optimizado para asistentes de IA como ChatGPT, Claude y otros LLM. Ofrece procesamiento offline 100% seguro, interfaz de arrastrar y soltar e integración con GitHub.