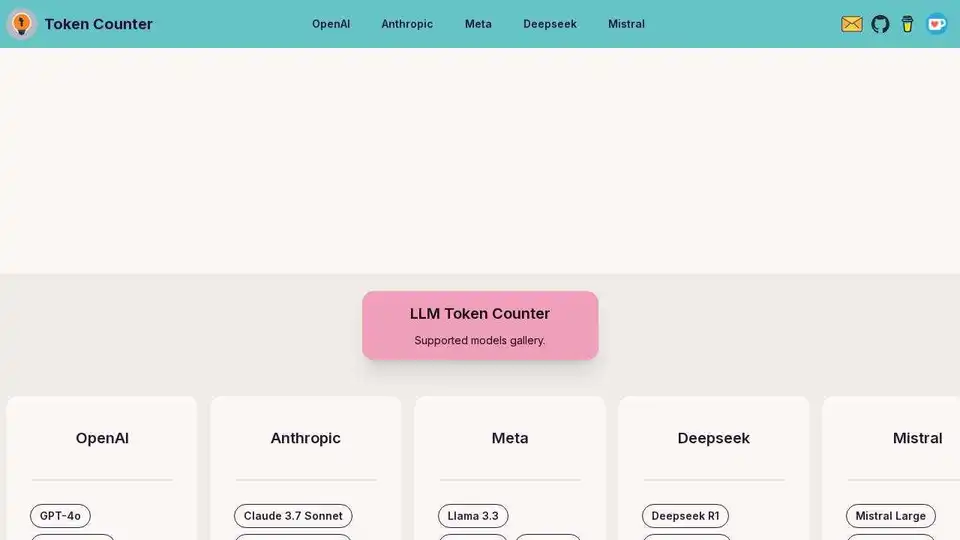

LLM Token Counter

Descripción general de LLM Token Counter

¿Qué es LLM Token Counter?

LLM Token Counter es una herramienta especializada diseñada para ayudar a los usuarios a gestionar los límites de tokens para una amplia gama de modelos de lenguaje populares (LLMs), incluyendo GPT-4, Claude-3, Llama-3 y muchos otros. Proporciona una forma fluida y eficiente de garantizar que tus indicaciones se mantengan dentro de los límites de tokens de estos modelos, evitando salidas inesperadas o indeseables.

Características Principales

- Soporte para Múltiples Modelos: Admite una amplia variedad de LLMs, incluyendo modelos de OpenAI, Anthropic, Meta, Deepseek, Mistral y Qwen.

- Procesamiento Basado en Navegador: Utiliza Transformers.js, una implementación en JavaScript de la biblioteca Transformers de Hugging Face, para realizar cálculos de tokens directamente en tu navegador.

- Privacidad y Seguridad: Garantiza que tus indicaciones permanezcan seguras y confidenciales al realizar todos los cálculos en el lado del cliente, sin transmitir datos a servidores externos.

- Rápido y Eficiente: Gracias a la eficiente implementación en Rust de la biblioteca Transformers, los cálculos de tokens son notablemente rápidos.

¿Cómo Funciona LLM Token Counter?

LLM Token Counter funciona cargando los tokenizadores directamente en tu navegador. Este procesamiento en el lado del cliente garantiza que tus datos permanezcan privados y seguros. La herramienta aprovecha el poder de Transformers.js para proporcionar recuentos de tokens rápidos y precisos para tus indicaciones.

¿Por Qué Elegir LLM Token Counter?

- Privacidad: Tus indicaciones nunca se envían a un servidor, garantizando una confidencialidad completa.

- Velocidad: La herramienta está optimizada para cálculos rápidos de tokens, lo que la hace ideal para uso en tiempo real.

- Soporte Integral: Se actualiza continuamente para admitir los últimos y más populares LLMs.

¿Para Quién es LLM Token Counter?

LLM Token Counter es ideal para desarrolladores, investigadores y cualquier persona que trabaje con modelos de lenguaje grandes. Es particularmente útil para aquellos que necesitan gestionar los límites de tokens de manera eficiente y garantizar que sus indicaciones estén dentro de las restricciones especificadas de varios LLMs.

La Mejor Forma de Usar LLM Token Counter

Para aprovechar al máximo LLM Token Counter, simplemente ingresa tu indicación en la herramienta. El recuento de tokens se calculará al instante, permitiéndote ajustar tu indicación según sea necesario para mantenerte dentro de los límites de tokens de tu LLM elegido. Esto garantiza que puedas aprovechar todo el potencial de la tecnología de IA generativa sin encontrar problemas relacionados con los tokens.

Mejores herramientas alternativas a "LLM Token Counter"

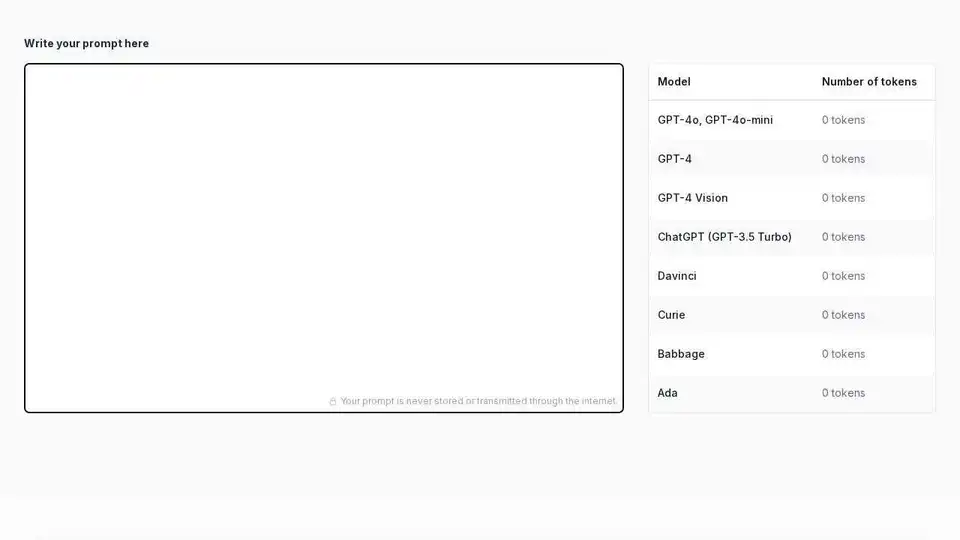

Token Counter: Cuenta tokens, estima costos para cualquier modelo de IA. Optimiza prompts, gestiona el presupuesto, maximiza la eficiencia en las interacciones de IA.

16x Prompt es una herramienta de codificación de IA para gestionar el contexto del código, personalizar los prompts y enviar funciones más rápido con integraciones de API LLM. Ideal para desarrolladores que buscan una codificación eficiente asistida por IA.

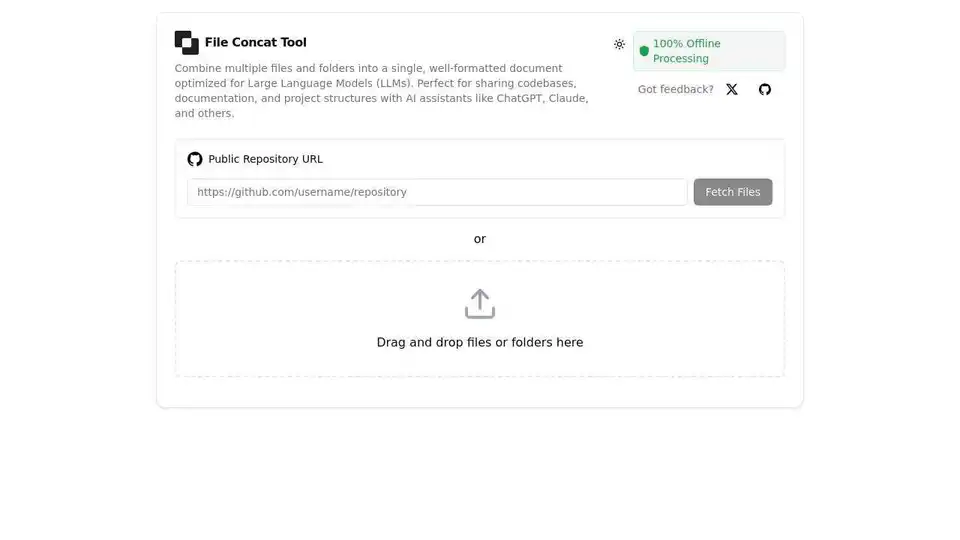

FileConcat es una herramienta en línea gratuita que combina múltiples archivos y carpetas en un solo documento bien formateado, optimizado para asistentes de IA como ChatGPT, Claude y otros LLM. Ofrece procesamiento offline 100% seguro, interfaz de arrastrar y soltar e integración con GitHub.

Calcula el uso de tokens para modelos OpenAI con este Contador de Tokens de Prompt en línea. Asegura que tus prompts se ajusten a los límites del modelo para interacciones de IA rentables.