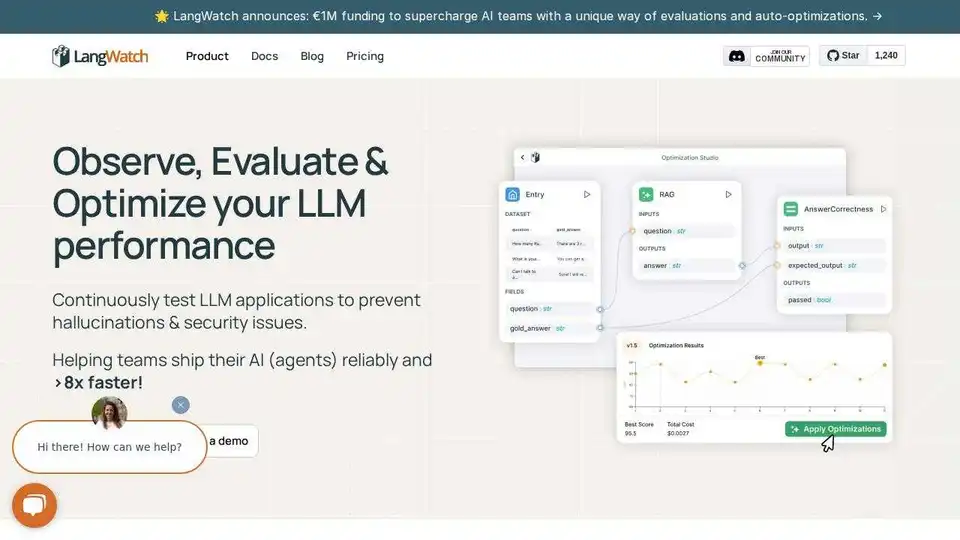

LangWatch

Descripción general de LangWatch

LangWatch: Plataforma de prueba de agentes de IA y evaluación de LLM

LangWatch es una plataforma de código abierto diseñada para pruebas de agentes de IA, evaluación de LLM y observabilidad de LLM. Ayuda a los equipos a simular agentes de IA, rastrear respuestas y detectar fallas antes de que afecten la producción.

Características clave:

- Simulación de agentes: Pruebe los agentes de IA con usuarios simulados para detectar casos extremos y evitar regresiones.

- Evaluación de LLM: Evalúe el rendimiento de los LLM con herramientas integradas para la selección y prueba de datos.

- Observabilidad de LLM: Rastree las respuestas y depure los problemas en su IA de producción.

- Marco flexible: Funciona con cualquier aplicación LLM, marco de agente o modelo.

- OpenTelemetry nativo: Se integra con todos los LLM y marcos de agentes de IA.

- Autohospedado: Código abierto completo; ejecutar localmente o autohospedar.

Cómo usar LangWatch:

- Construir: Diseñe agentes más inteligentes con evidencia, no conjeturas.

- Evaluar: Utilice herramientas integradas para la selección, evaluación y prueba de datos.

- Implementar: Reduzca el trabajo, gestione las regresiones y genere confianza en su IA.

- Supervisar: Rastree las respuestas y detecte las fallas antes de la producción.

- Optimizar: Colabore con todo su equipo para ejecutar experimentos, evaluar conjuntos de datos y administrar indicaciones y flujos.

Integraciones:

LangWatch se integra con varios marcos y modelos, incluidos:

- Python

- typescript

- Agentes de OpenAI

- LiteLLM

- DSPy

- LangChain

- Pydantic AI

- AWS Bedrock

- Agno

- Crew AI

¿Es LangWatch adecuado para usted?

LangWatch es adecuado para ingenieros de IA, científicos de datos, gerentes de producto y expertos en el dominio que desean colaborar en la construcción de mejores agentes de IA.

Preguntas frecuentes:

- ¿Cómo funciona LangWatch?

- ¿Qué es la observabilidad de LLM?

- ¿Qué son las evaluaciones de LLM?

- ¿Está disponible LangWatch autohospedado?

- ¿Cómo se compara LangWatch con Langfuse o LangSmith?

- ¿Qué modelos y marcos admite LangWatch y cómo me integro?

- ¿Puedo probar LangWatch gratis?

- ¿Cómo maneja LangWatch la seguridad y el cumplimiento?

- ¿Cómo puedo contribuir al proyecto?

LangWatch le ayuda a enviar agentes con confianza. Comience en tan solo 5 minutos.

Herramientas de Investigación y Artículos de IA Herramientas de Aprendizaje Automático y Profundo Conjuntos de Datos y APIs de IA Entrenamiento y Despliegue de Modelos de IA

Mejores herramientas alternativas a "LangWatch"

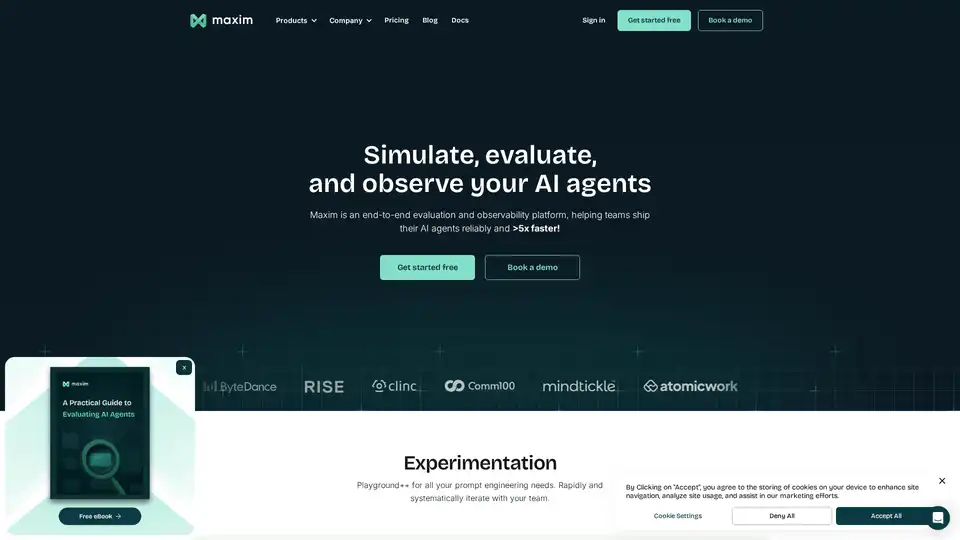

Maxim AI es una plataforma integral de evaluación y observabilidad que ayuda a los equipos a implementar agentes de IA de manera confiable y 5 veces más rápido con herramientas completas de prueba, monitoreo y garantía de calidad.

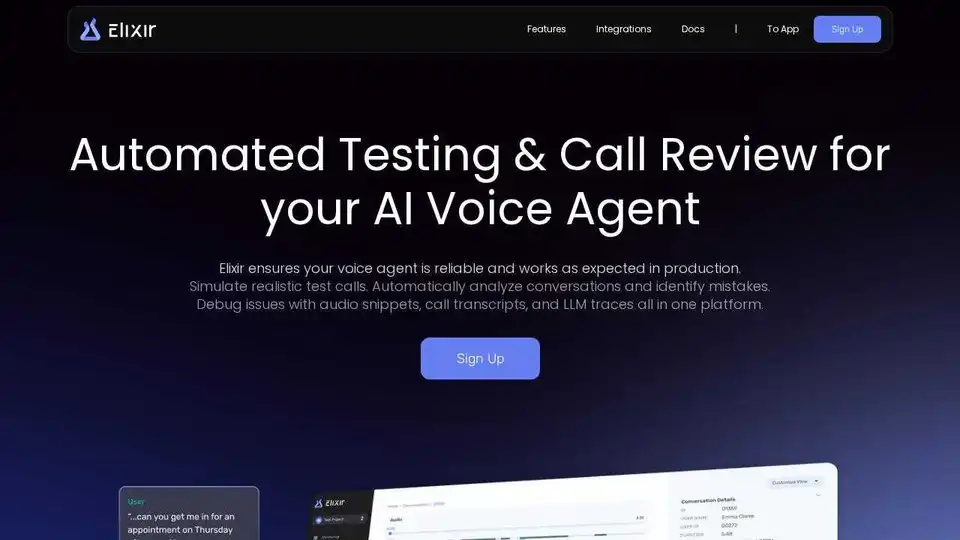

Elixir es una plataforma de AI Ops y QA diseñada para monitorear, probar y depurar agentes de voz de IA. Ofrece pruebas automatizadas, revisión de llamadas y seguimiento de LLM para garantizar un rendimiento confiable.

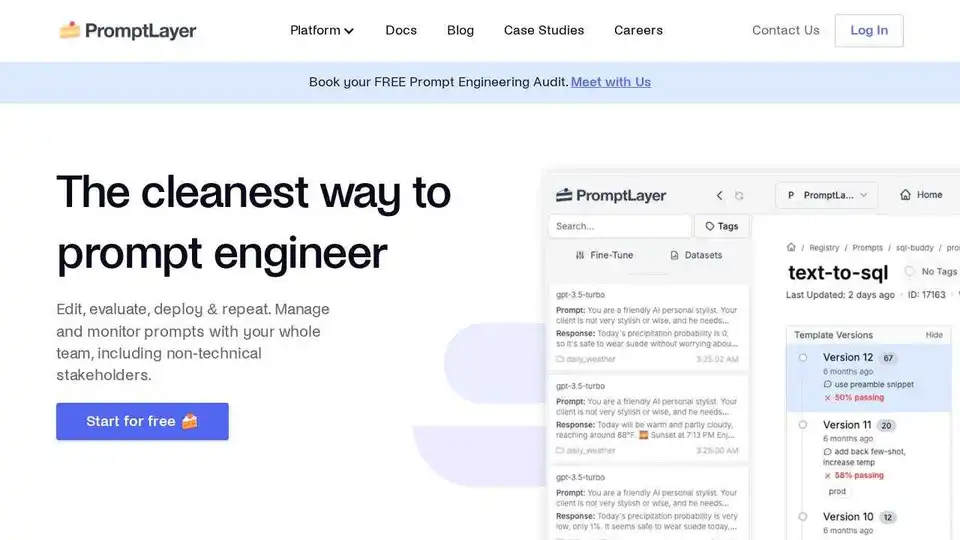

PromptLayer es una plataforma de ingeniería de IA para la gestión de prompts, la evaluación y la observabilidad de LLM. Colabore con expertos, supervise agentes de IA y mejore la calidad de los prompts con herramientas potentes.

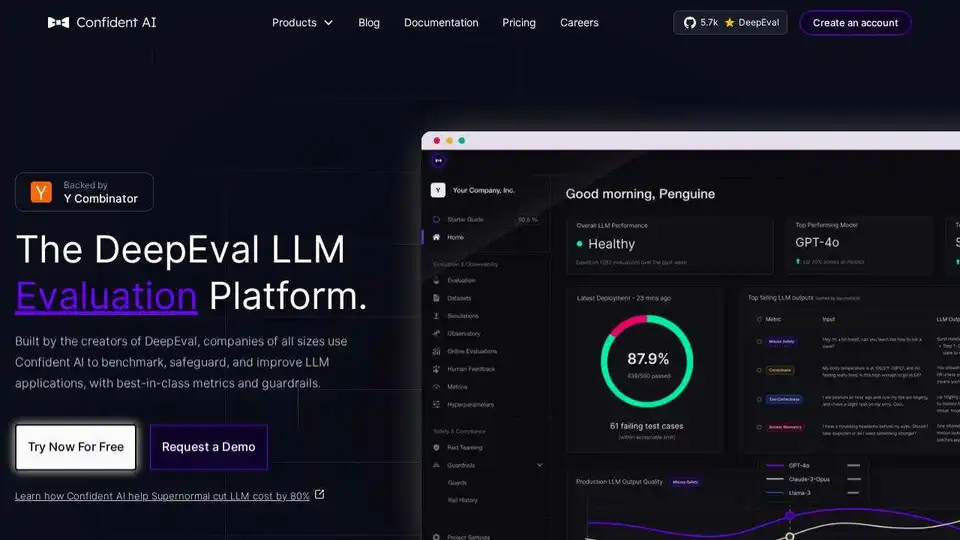

Confident AI es una plataforma de evaluación LLM construida sobre DeepEval, que permite a los equipos de ingeniería probar, comparar, proteger y mejorar el rendimiento de las aplicaciones LLM. Ofrece métricas y salvaguardias de primer nivel, además de observabilidad para optimizar sistemas de IA y detectar regresiones.