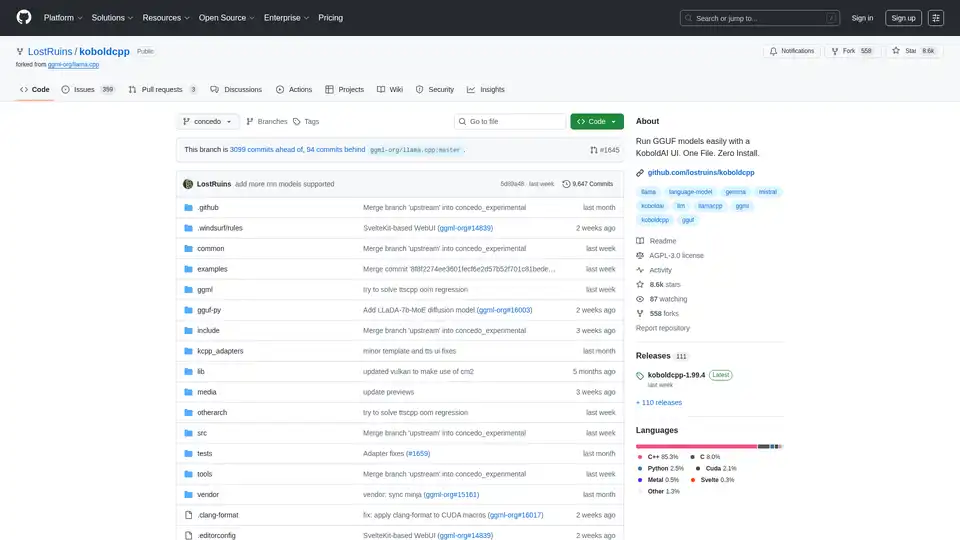

KoboldCpp

Descripción general de KoboldCpp

KoboldCpp: Tu solución todo en uno para la generación de texto e imágenes con IA

¿Qué es KoboldCpp? KoboldCpp es un software de IA versátil y fácil de usar diseñado para la generación de texto e imágenes. Inspirado en el KoboldAI original, simplifica el proceso de ejecución de modelos GGML y GGUF, ofreciendo un único ejecutable autocontenido sin necesidad de instalación.

Características clave

- Ejecutable de un solo archivo: No se necesita instalación ni dependencias externas.

- Soporte de CPU y GPU: Se ejecuta eficientemente tanto en CPU como en GPU, con opciones para descarga completa o parcial.

- Generación de texto LLM: Compatible con todos los modelos GGML y GGUF, lo que garantiza la compatibilidad con versiones anteriores.

- Generación de imágenes: Admite Stable Diffusion 1.5, SDXL, SD3 y Flux para generar imágenes de alta calidad.

- Voz a texto: Integra Whisper para el reconocimiento de voz.

- Texto a voz: Compatible con OuteTTS, Kokoro, Parler y Dia para la generación de voz.

- Endpoints de API: Proporciona endpoints de API compatibles para servicios web populares como KoboldCppApi, OpenAiApi, OllamaApi y más.

- UI incluida: Incluye KoboldAI Lite UI con herramientas de edición, formatos de guardado, memoria, información mundial, nota del autor, personajes y escenarios.

- Múltiples modos y temas: Ofrece modos de chat, aventura, instrucción y redactor de historias, junto con varios temas de UI.

- Soporte de formato de datos: Admite tarjetas de personaje de Tavern, archivos de guardado JSON e historias persistentes.

- Características adicionales: Incluye nuevos samplers, soporte de regex, búsqueda web, RAG a través de TextDB y reconocimiento/visión de imágenes.

- Multiplataforma: Binarios listos para usar para Windows, MacOS y Linux, con soporte para Colab, Docker, Android (a través de Termux) y Raspberry Pi.

¿Cómo funciona KoboldCpp?

KoboldCpp aprovecha el poder de llama.cpp y stable-diffusion.cpp para proporcionar una experiencia de IA perfecta. Funciona de la siguiente manera:

- Cargando modelos GGML o GGUF para la generación de texto.

- Utilizando modelos de Stable Diffusion para la generación de imágenes.

- Empleando Whisper para el reconocimiento de voz y varios motores TTS para la generación de voz.

- Proporcionando endpoints de API para la integración con otros servicios.

Cómo usar KoboldCpp

- Descargar: Obtenga el último ejecutable de Koboldcpp para su sistema operativo desde la página oficial de lanzamientos.

- Ejecutar: Simplemente ejecute el archivo descargado. No se requiere instalación.

- Cargar un modelo: Obtenga un modelo GGUF de fuentes como Hugging Face. Los principiantes pueden encontrar

L3-8B-Stheno-v3.2,Tiefighter 13BoGemma-3-27B Abliteratedadecuados. - Conectar: De forma predeterminada, puede acceder a KoboldCpp a través de

http://localhost:5001.

Uso en Windows

- Descargue el archivo

koboldcpp.exe. - Ejecute el ejecutable para iniciar la GUI.

- Cargue un modelo GGUF y conéctese al servidor local.

Uso en Linux

- Descargue el binario

koboldcpp-linux-x64. - Haga que el archivo sea ejecutable con

chmod +x koboldcpp-linux-x64. - Ejecute el binario usando

./koboldcpp-linux-x64.

Uso en MacOS

- Descargue el binario de MacOS.

- Establezca el archivo como ejecutable usando

chmod +x koboldcpp-mac-arm64. - Ejecute el binario con

./koboldcpp-mac-arm64.

Ejecutar en Colab

KoboldCpp ofrece un cuaderno Colab GPU oficial para una fácil configuración y uso.

Ejecutar en RunPod

KoboldCpp se puede implementar en GPU en la nube de RunPod para un rendimiento escalable.

Optimización del rendimiento

- Aceleración de GPU: Use los flags

--usecuda(Nvidia) o--usevulkan(Cualquier GPU). - Descarga de capas de GPU: Emplee

--gpulayerspara descargar capas de modelo a VRAM. - Tamaño del contexto: Aumente el tamaño del contexto con

--contextsize. - Compatibilidad con CPU: Use

--noavx2para CPU más antiguas.

¿Para quién es KoboldCpp?

KoboldCpp es ideal para:

- Entusiastas de la IA que desean una solución simple y todo en uno para la generación de texto e imágenes.

- Desarrolladores que buscan endpoints de API para integrar capacidades de IA en sus aplicaciones.

- Creativos que buscan herramientas para mejorar sus procesos de narración, juegos de rol y creación de contenido.

¿Por qué elegir KoboldCpp?

KoboldCpp destaca por su:

- Facilidad de uso

- Conjunto de características completo

- Compatibilidad multiplataforma

- Opciones de optimización de rendimiento

Recursos adicionales

- Modelos: Encuentre modelos de texto GGUF en Hugging Face y modelos de imagen en CivitAI.

- Documentación: Consulte la documentación de la API de KoboldAI para obtener detalles sobre los endpoints.

- Comunidad: Únase al servidor de Discord de KoboldAI para obtener soporte y debates.

KoboldCpp simplifica la generación de texto e imágenes impulsada por IA, haciéndola accesible a una amplia gama de usuarios. Ya sea que esté generando historias, creando imágenes o integrando la IA en sus proyectos, KoboldCpp ofrece una solución robusta y fácil de usar. Al admitir varias plataformas y proporcionar opciones de optimización, garantiza una experiencia de IA fluida y eficiente. Considere explorar KoboldCpp para su próximo proyecto de IA.

Generación de Artículos con IA Pulido de Texto con IA Asistencia en Escritura con IA Generación de Artículos y Reportes Generación de Noticias y Blogs Escritura de Correos Electrónicos y Negocios

Mejores herramientas alternativas a "KoboldCpp"

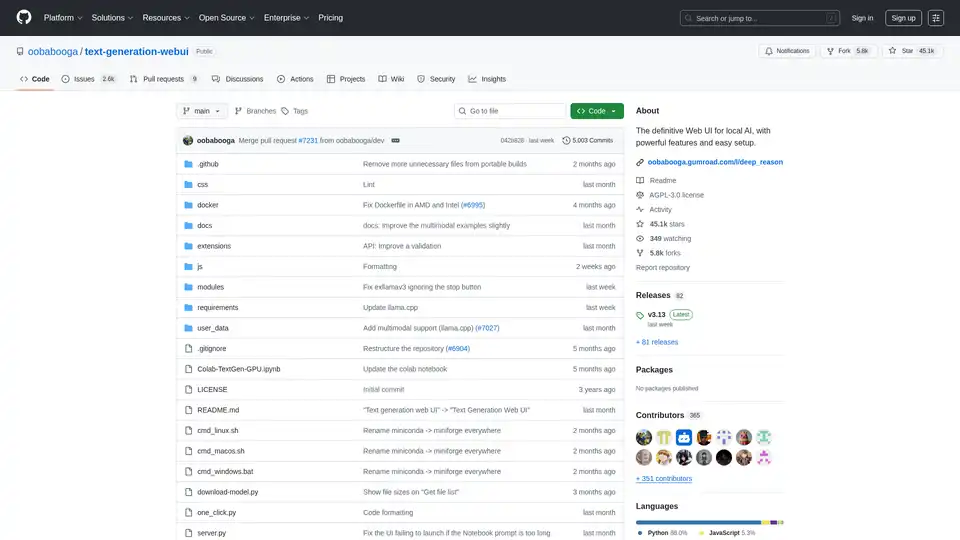

Text Generation Web UI es una interfaz web Gradio potente y fácil de usar para modelos de lenguaje grandes de IA local. Admite múltiples backends, extensiones y ofrece privacidad sin conexión.

AI Actions mejora la app Shortcuts de Apple con integraciones de IA potentes como GPT-4o, Claude y DALL·E, usando tus propias claves API para automatización segura y personalizable en iOS y macOS.

RecurseChat: Una aplicación de IA personal que te permite hablar con IA local, sin conexión y chatear con archivos PDF y markdown.

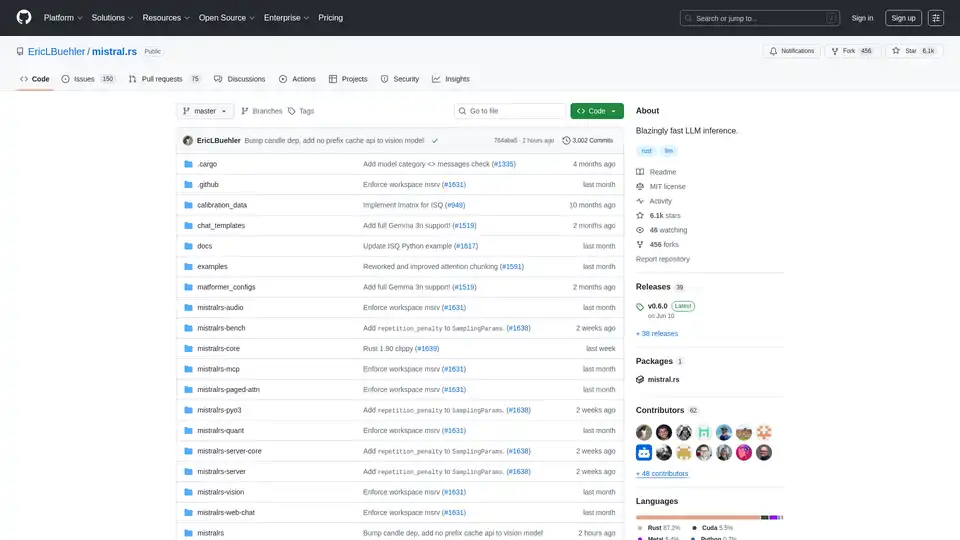

mistral.rs es un motor de inferencia LLM increíblemente rápido escrito en Rust, que admite flujos de trabajo multimodales y cuantización. Ofrece API de Rust, Python y servidor HTTP compatible con OpenAI.