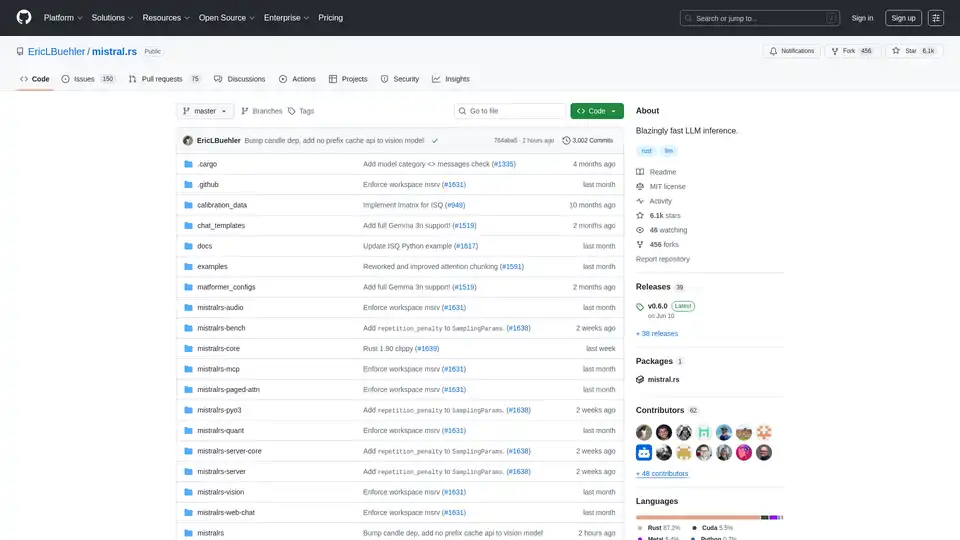

mistral.rs

Descripción general de mistral.rs

¿Qué es mistral.rs?

Mistral.rs es un motor de inferencia de Modelos de Lenguaje Grande (LLM) multiplataforma y ultrarrápido escrito en Rust. Está diseñado para proporcionar alto rendimiento y flexibilidad en diversas plataformas y configuraciones de hardware. Al admitir flujos de trabajo multimodales, mistral.rs gestiona texto, visión, generación de imágenes y voz.

Características y ventajas principales

- Flujo de trabajo multimodal: Admite texto↔texto, texto+visión↔texto, texto+visión+audio↔texto, texto→voz, texto→imagen.

- APIs: Ofrece APIs de Rust, Python y servidor HTTP OpenAI (con Chat Completions, Responses API) para una fácil integración en diferentes entornos.

- Cliente MCP: Conéctese a herramientas y servicios externos automáticamente, como sistemas de archivos, búsqueda web, bases de datos y otras APIs.

- Rendimiento: Utiliza tecnologías como ISQ (cuantificación in situ), PagedAttention y FlashAttention para un rendimiento optimizado.

- Facilidad de uso: Incluye características como la asignación automática de dispositivos (multi-GPU, CPU), plantillas de chat y detección automática de tokenizadores.

- Flexibilidad: Admite adaptadores LoRA & X-LoRA con fusión de pesos, AnyMoE para crear modelos MoE en cualquier modelo base y cuantificación personalizable.

¿Cómo funciona mistral.rs?

Mistral.rs aprovecha varias técnicas clave para lograr su alto rendimiento:

- Cuantificación in situ (ISQ): Reduce el espacio de memoria y mejora la velocidad de inferencia mediante la cuantificación de los pesos del modelo.

- PagedAttention y FlashAttention: Optimiza el uso de la memoria y la eficiencia computacional durante los mecanismos de atención.

- Asignación automática de dispositivos: Distribuye automáticamente el modelo entre los recursos de hardware disponibles, incluidas varias GPU y CPU.

- MCP (Protocolo de contexto del modelo): Permite una integración perfecta con herramientas y servicios externos al proporcionar un protocolo estandarizado para las llamadas a herramientas.

¿Cómo usar mistral.rs?

Instalación: Siga las instrucciones de instalación que se proporcionan en la documentación oficial. Esto normalmente implica la instalación de Rust y la clonación del repositorio mistral.rs.

Adquisición del modelo: Obtenga el modelo LLM deseado. Mistral.rs admite varios formatos de modelo, incluidos los modelos Hugging Face, GGUF y GGML.

Uso de la API: Utilice las API de Rust, Python o el servidor HTTP compatible con OpenAI para interactuar con el motor de inferencia. Los ejemplos y la documentación están disponibles para cada API.

- API de Python:

pip install mistralrs - API de Rust:

Añada

mistralrs = { git = "https://github.com/EricLBuehler/mistral.rs.git" }a suCargo.toml.

- API de Python:

Ejecute el servidor: Inicie el mistralrs-server con las opciones de configuración apropiadas. Esto puede implicar la especificación de la ruta del modelo, el método de cuantificación y otros parámetros.

./mistralrs-server --port 1234 run -m microsoft/Phi-3.5-MoE-instruct

Casos de uso

Mistral.rs es adecuado para una amplia gama de aplicaciones, entre las que se incluyen:

- Chatbots e IA conversacional: Potencie chatbots interactivos y atractivos con inferencia de alto rendimiento.

- Generación de texto: Genere texto realista y coherente para diversos fines, como la creación y el resumen de contenidos.

- Análisis de imágenes y vídeos: Procese y analice datos visuales con capacidades de visión integradas.

- Reconocimiento y síntesis de voz: Permita las interacciones basadas en la voz con soporte para el procesamiento de audio.

- Llamadas a herramientas y automatización: Intégrese con herramientas y servicios externos para flujos de trabajo automatizados.

¿Para quién es mistral.rs?

Mistral.rs está diseñado para:

- Desarrolladores: Que necesitan un motor de inferencia LLM rápido y flexible para sus aplicaciones.

- Investigadores: Que están explorando nuevos modelos y técnicas en el procesamiento del lenguaje natural.

- Organizaciones: Que requieren capacidades de IA de alto rendimiento para sus productos y servicios.

¿Por qué elegir mistral.rs?

- Rendimiento: Ofrece velocidades de inferencia ultrarrápidas a través de técnicas como ISQ, PagedAttention y FlashAttention.

- Flexibilidad: Admite una amplia gama de modelos, métodos de cuantificación y configuraciones de hardware.

- Facilidad de uso: Proporciona APIs sencillas y opciones de configuración automática para una fácil integración.

- Extensibilidad: Permite la integración con herramientas y servicios externos a través del protocolo MCP.

Aceleradores compatibles

Mistral.rs admite una variedad de aceleradores:

- GPU NVIDIA (CUDA): Utilice los indicadores de características

cuda,flash-attnycudnn. - GPU Apple Silicon (Metal): Utilice el indicador de característica

metal. - CPU (Intel): Utilice el indicador de característica

mkl. - CPU (Apple Accelerate): Utilice el indicador de característica

accelerate. - CPU genérica (ARM/AVX): Activada por defecto.

Para activar funciones, páselas a Cargo:

cargo build --release --features "cuda flash-attn cudnn"

Comunidad y soporte

Conclusión

Mistral.rs destaca como un motor de inferencia LLM potente y versátil, que ofrece un rendimiento ultrarrápido, una amplia flexibilidad y capacidades de integración perfectas. Su naturaleza multiplataforma y su compatibilidad con flujos de trabajo multimodales lo convierten en una excelente opción para desarrolladores, investigadores y organizaciones que buscan aprovechar el poder de los modelos de lenguaje grandes en una variedad de aplicaciones. Al aprovechar sus características avanzadas y APIs, los usuarios pueden crear soluciones de IA innovadoras e impactantes con facilidad.

Para aquellos que buscan optimizar su infraestructura de IA y desbloquear todo el potencial de los LLM, mistral.rs proporciona una solución robusta y eficiente que es muy adecuada tanto para entornos de investigación como de producción.

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "mistral.rs"

Spice.ai es un motor de inferencia de datos e IA de código abierto para construir aplicaciones de IA con federación de consultas SQL, aceleración, búsqueda y recuperación basadas en datos empresariales.

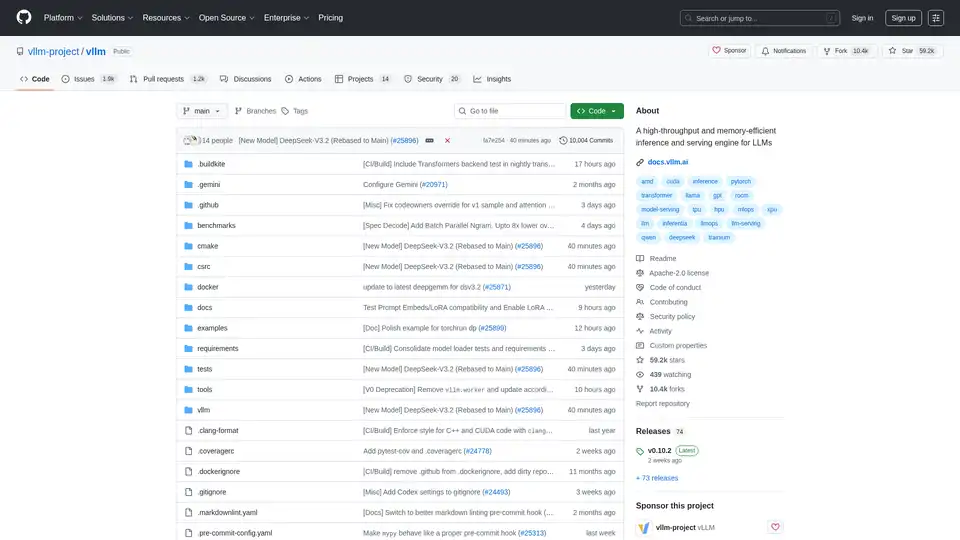

vLLM es un motor de inferencia y servicio de alto rendimiento y eficiencia de memoria para LLM, que presenta PagedAttention y procesamiento por lotes continuo para un rendimiento optimizado.

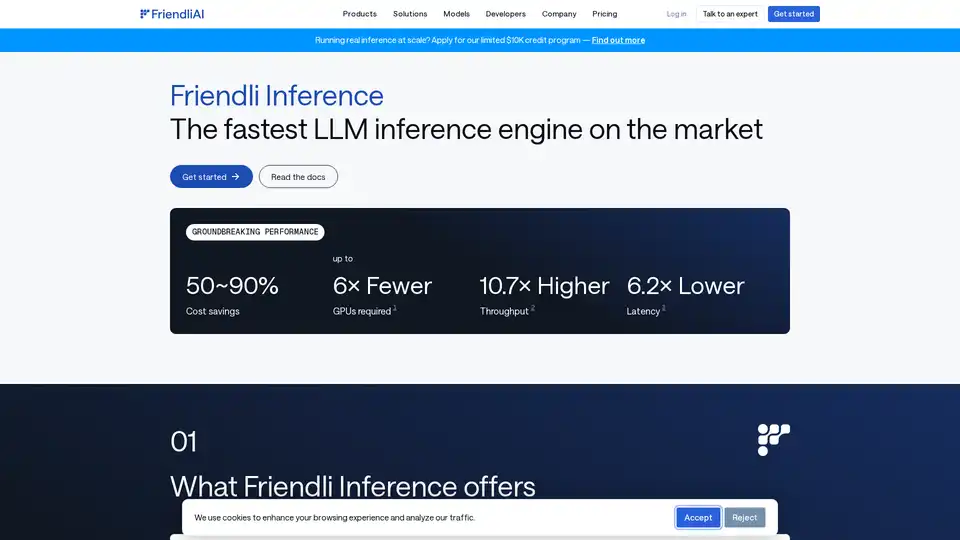

Friendli Inference es el motor de inferencia LLM más rápido, optimizado para la velocidad y la rentabilidad, reduciendo los costos de GPU en un 50-90% al tiempo que ofrece un alto rendimiento y baja latencia.

Plataforma de IA ultrarrápida para desarrolladores. Implementa, ajusta y ejecuta más de 200 LLMs y modelos multimodales optimizados con APIs simples - SiliconFlow.