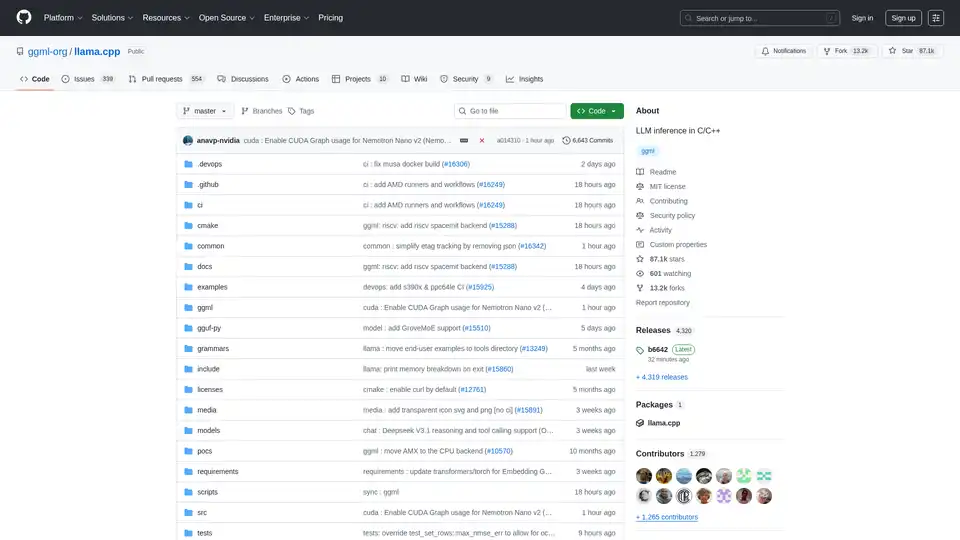

llama.cpp

Übersicht von llama.cpp

llama.cpp: Ihre Go-To-Bibliothek für LLM-Inferenz in C/C++

lama.cpp ist eine leistungsstarke Open-Source-Bibliothek, die entwickelt wurde, um effiziente Large Language Model (LLM)-Inferenz mit C/C++ zu ermöglichen. Optimiert für eine breite Palette von Hardware, von lokalen Rechnern bis hin zu Cloud-Bereitstellungen, zeichnet sie sich durch minimale Einrichtung und modernste Leistung aus.

Was ist llama.cpp?

lama.cpp ist ein Projekt, das sich auf die Durchführung von LLM-Inferenz in C/C++ konzentriert. Es wurde entwickelt, um eine ausgezeichnete Leistung über verschiedene Hardwarekonfigurationen mit minimalen Abhängigkeiten zu bieten.

Hauptmerkmale und Vorteile

- Reine C/C++-Implementierung: Eliminiert externe Abhängigkeiten und vereinfacht die Bereitstellung.

- Apple Silicon Optimierung: Nutzt ARM NEON, Accelerate und Metal Frameworks für höchste Leistung auf Apple Geräten.

- x86 Architektur Unterstützung: Beinhaltet AVX-, AVX2-, AVX512- und AMX-Unterstützung für optimierte Leistung auf x86-CPUs.

- Quantisierung: Unterstützt 1,5-Bit- bis 8-Bit-Integer-Quantisierung, wodurch die Speichernutzung reduziert und die Inferenz beschleunigt wird.

- GPU-Beschleunigung: Benutzerdefinierte CUDA-Kernel ermöglichen eine effiziente LLM-Ausführung auf NVIDIA-GPUs. Unterstützt auch AMD-GPUs über HIP und Moore Threads GPUs über MUSA.

- Hybride CPU+GPU-Inferenz: Ermöglicht die Verwendung von Modellen, die größer als der verfügbare VRAM sind, indem die Arbeitslast zwischen CPU und GPU verteilt wird.

- Mehrere Backends: Unterstützt Metal, BLAS, BLIS, SYCL, MUSA, CUDA, HIP, Vulkan, CANN, OpenCL, IBM zDNN und WebGPU (in Arbeit).

Wie funktioniert llama.cpp?

lama.cpp funktioniert, indem LLM-Inferenz direkt in C/C++ implementiert wird. Dieser Ansatz reduziert den Overhead und ermöglicht eine feinkörnige Kontrolle über die Hardwareressourcen. Die Bibliothek ist modular aufgebaut, mit verschiedenen Backends, die für verschiedene Hardwareplattformen optimiert sind. Sie verwendet Techniken wie die Quantisierung, um den Speicherbedarf von Modellen zu reduzieren, wodurch es möglich wird, große Modelle auf ressourcenbeschränkten Geräten auszuführen.

Wie verwende ich llama.cpp?

Installation:

- Verwendung von Paketmanagern: Installation über brew, nix oder winget.

- Docker: Verwenden Sie die bereitgestellten Docker-Images.

- Vorgefertigte Binärdateien: Laden Sie Binärdateien von der Releases-Seite herunter.

- Aus Quelle erstellen: Klonen Sie das Repository und folgen Sie der Build-Anleitung.

Modelle beziehen:

- Laden Sie GGUF-Modelle von Hugging Face oder anderen Modell-Hosting-Sites herunter.

- Konvertieren Sie Modelle mit den bereitgestellten Python-Skripten in das GGUF-Format.

Inferenz ausführen:

- Verwenden Sie das Tool

llama-clifür Experimente. - Stellen Sie einen lokalen HTTP-Server mit

llama-serverfür OpenAI-API-Kompatibilität bereit.

- Verwenden Sie das Tool

Beispielbefehle:

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

Für wen ist llama.cpp gedacht?

lama.cpp ist ideal für:

- Entwickler: Implementierung von LLM-gestützten Anwendungen mit C/C++.

- Forscher: Experimentieren mit LLMs auf verschiedenen Hardwareplattformen.

- Hobbyisten: Ausführen von LLMs auf persönlichen Computern und Geräten.

- Organisationen: Bereitstellung von LLMs in Produktionsumgebungen mit minimalem Overhead.

Praktische Anwendungen von llama.cpp

lama.cpp kann in verschiedenen Szenarien eingesetzt werden, darunter:

- Lokale LLM-Inferenz: Ausführen von Modellen auf persönlichen Computern, ohne auf Cloud-Dienste angewiesen zu sein.

- Edge Computing: Bereitstellung von LLMs auf Edge-Geräten für Anwendungen mit niedriger Latenz.

- Mobile Anwendungen: Integration von LLMs in mobile Apps für die Verarbeitung auf dem Gerät.

- Benutzerdefinierte KI-Lösungen: Erstellen von benutzerdefinierten KI-Lösungen, die auf spezifische Hardware- und Softwareumgebungen zugeschnitten sind.

Warum llama.cpp wählen?

lama.cpp bietet eine einzigartige Kombination aus Leistung, Flexibilität und Benutzerfreundlichkeit, was es zu einer ausgezeichneten Wahl für LLM-Inferenz macht. Zu den wichtigsten Vorteilen gehören:

- Optimierte Leistung: Entwickelt für höchste Leistung auf einer breiten Palette von Hardware.

- Minimale Abhängigkeiten: Vereinfacht die Bereitstellung und reduziert das Risiko von Konflikten.

- Quantisierungsunterstützung: Ermöglicht die Verwendung großer Modelle auf ressourcenbeschränkten Geräten.

- Aktive Community: Profitiert von fortlaufender Entwicklung und Community-Support.

- Vielseitige Werkzeuge: Enthält Tools wie

llama-cli,llama-server,llama-perplexityundllama-benchfür verschiedene Anwendungsfälle.

Unterstützte Backends

lama.cpp unterstützt mehrere Backends, die auf eine breite Palette von Geräten abzielen:

| Backend | Zielgeräte |

|---|---|

| Metal | Apple Silicon |

| BLAS | Alle |

| BLIS | Alle |

| SYCL | Intel und Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | Alle (In Arbeit) |

| RPC | Alle |

Wie kann man zu llama.cpp beitragen?

Beiträge zu llama.cpp sind willkommen! Sie können beitragen durch:

- Öffnen von Pull-Requests mit Fehlerbehebungen oder neuen Funktionen.

- Zusammenarbeit an bestehenden Problemen und Projekten.

- Hilfe bei der Verwaltung von Problemen, PRs und Projekten.

- Verbesserung der Dokumentation und Beispiele.

Was ist GGUF?

GGUF ist ein von llama.cpp benötigtes Dateiformat zum Speichern von Modellen. Modelle in anderen Datenformaten können mit den convert_*.py Python-Skripten im Repository in GGUF konvertiert werden.

Fazit

lama.cpp ist eine vielseitige und leistungsstarke Bibliothek, die LLM-Inferenz einem breiten Publikum zugänglich macht. Egal, ob Sie Entwickler, Forscher oder Hobbyist sind, llama.cpp bietet die Tools und die Flexibilität, die Sie benötigen, um die Leistung von LLMs auf Ihrer Hardware Ihrer Wahl zu nutzen. Mit seinem Fokus auf Leistung, Benutzerfreundlichkeit und Community-Support ist llama.cpp bereit, ein wichtiger Akteur in der sich schnell entwickelnden Landschaft der KI-Inferenz zu bleiben.

Für weitere Informationen besuchen Sie das llama.cpp GitHub Repository.

KI-Programmierassistent Automatische Codevervollständigung KI-Code-Überprüfung und -Optimierung KI-gesteuerte Low-Code- und No-Code-Entwicklung

Beste Alternativwerkzeuge zu "llama.cpp"

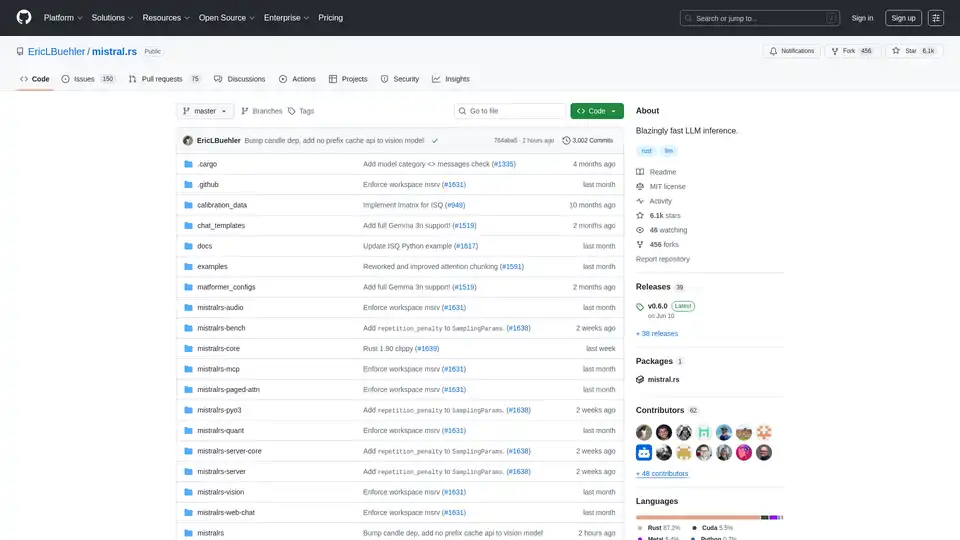

mistral.rs ist eine blitzschnelle LLM-Inferenz-Engine, geschrieben in Rust, die multimodale Workflows und Quantisierung unterstützt. Bietet Rust-, Python- und OpenAI-kompatible HTTP-Server-APIs.

Awan LLM bietet eine uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform mit unbegrenzten Token, ideal für Entwickler und Power-User. Verarbeiten Sie Daten, vervollständigen Sie Code und erstellen Sie KI-Agenten ohne Token-Limits.

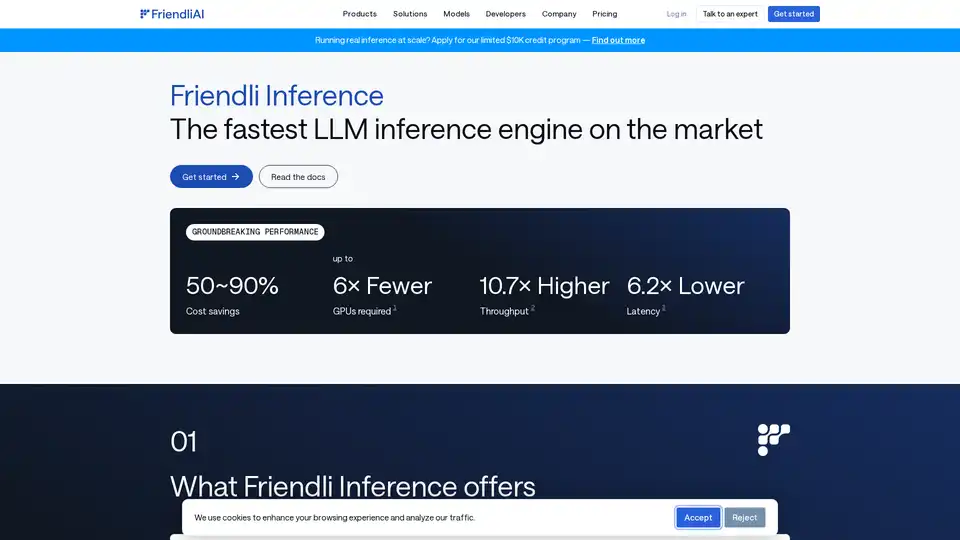

Friendli Inference ist die schnellste LLM-Inferenz-Engine, optimiert für Geschwindigkeit und Kosteneffizienz, die GPU-Kosten um 50-90 % senkt und gleichzeitig einen hohen Durchsatz und eine geringe Latenz bietet.