Avian API 概述

Avian API:开源 LLM 的最快 AI 推理

Avian API 是一个为开源大型语言模型 (LLM)(如 Llama)提供最快 AI 推理的平台。它允许用户以比行业平均水平快 3-10 倍的速度部署和运行来自 Hugging Face 的 LLM。借助 Avian,用户可以体验生产级的 AI 推理,没有速率限制,可以利用无服务器架构或部署来自 Hugging Face 的任何 LLM。

什么是 Avian API?

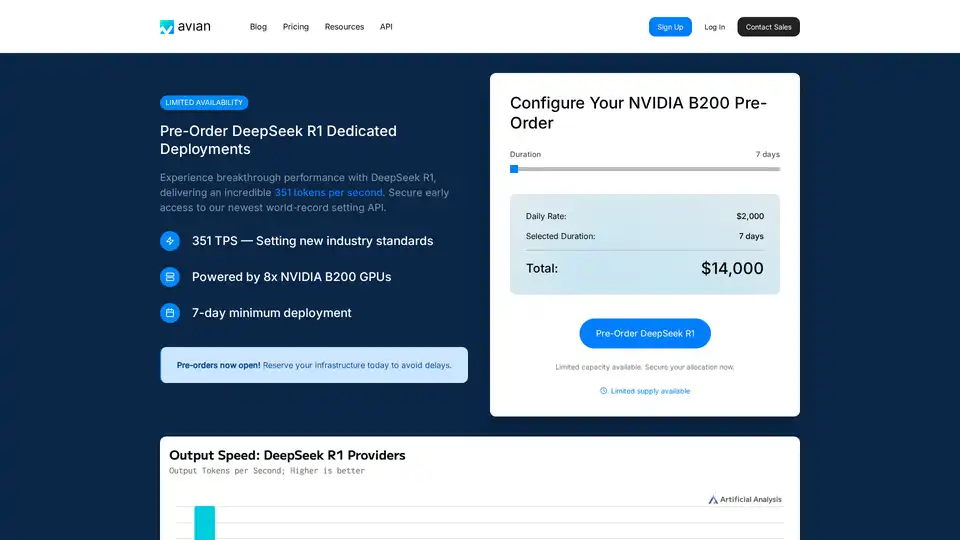

Avian API 旨在提供高性能 AI 推理,专注于速度、隐私和易用性。它以提供行业领先的推理速度而著称,尤其是在 DeepSeek R1 等模型上,它实现了每秒 351 个 token (TPS)。这种性能由优化的 NVIDIA B200 架构提供支持,为 AI 推理领域树立了新标准。

Avian API 如何工作?

Avian API 通过利用优化的基础设施和专有技术来加速推理过程。主要功能包括:

- 高速推理: 在 DeepSeek R1 等模型上实现高达 351 TPS。

- Hugging Face 集成: 允许以最少的配置部署任何 Hugging Face 模型。

- 自动优化和扩展: 自动优化和扩展模型,以确保持续的性能。

- OpenAI 兼容的 API 端点: 提供一个易于使用的 API 端点,与 OpenAI 兼容,简化了集成到现有工作流程中。

- 企业级性能和隐私: 构建在安全的、通过 SOC/2 认证的 Microsoft Azure 基础设施上,没有数据存储。

主要特性和优势

- 最快的推理速度: Avian API 提供无与伦比的推理速度,使其成为需要实时响应的应用程序的理想选择。

- 易于集成: 凭借其 OpenAI 兼容的 API,Avian 可以轻松集成到现有项目中,只需最少的代码更改。

- 经济高效: 通过优化资源利用率,Avian 有助于降低与 AI 推理相关的成本。

- 隐私和安全: Avian 通过其 SOC/2 合规性和私有托管选项,确保数据隐私和安全。

如何使用 Avian API

使用 Avian API 涉及几个简单的步骤:

- 注册: 在 Avian.io 平台上创建一个帐户。

- 获取您的 API 密钥: 从仪表板获取您的唯一 API 密钥。

- 选择模型: 从 Hugging Face 选择您喜欢的开源模型,或使用 DeepSeek R1 以获得最佳性能。

- 集成 API: 使用提供的代码片段将 Avian API 集成到您的应用程序中。

这是一个使用 Avian API 的示例代码片段:

from openai import OpenAI

import os

client = OpenAI(

base_url="https://api.avian.io/v1",

api_key=os.environ.get("AVIAN_API_KEY")

)

response = client.chat.completions.create(

model="DeepSeek-R1",

messages=[

{

"role": "user",

"content": "What is machine learning?"

}

],

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="")

此代码片段演示了如何使用 Avian API 从 DeepSeek-R1 模型生成响应。只需更改 base_url 并使用您的 API 密钥即可开始。

为什么选择 Avian API?

Avian API 因其专注于速度、安全性和易用性而脱颖而出。与其他推理解决方案相比,Avian 提供:

- 卓越的性能: 在 DeepSeek R1 上实现 351 TPS,比 Together、Fireworks 和 Amazon 等竞争对手快得多。

- 简化的部署: 任何 Hugging Face 模型的一行代码集成。

- 企业级安全性: SOC/2 合规性和用于聊天的隐私模式。

Avian API 适合谁?

Avian API 非常适合:

- 企业: 需要高性能、安全且可扩展的 AI 推理的企业。

- 开发者: 寻求易于使用的 API 以将 AI 集成到其应用程序中的开发者。

- 研究人员: 需要快速且可靠的推理来支持其 AI 模型的研究人员。

结论

Avian API 为开源 LLM 提供最快的 AI 推理,使其成为任何希望在其项目中利用 AI 力量的人的必备工具。凭借其高速性能、易于集成和企业级安全性,Avian API 正在为 AI 推理领域树立新标准。无论您是从 Hugging Face 部署模型还是利用优化的 NVIDIA B200 架构,Avian API 都能提供无与伦比的速度和效率。

"Avian API"的最佳替代工具

Nebius AI Studio Inference Service 提供托管开源模型,实现比专有 API 更快、更便宜、更准确的推理结果。无需 MLOps,即可无缝扩展,适用于 RAG 和生产工作负载。

Nexa SDK 实现了 LLM、多模态、ASR 和 TTS 模型的快速、私密的设备上 AI 推理。通过 NPU、GPU 和 CPU 在移动设备、PC、汽车和 IoT 设备上实现生产就绪的性能。

Release.ai简化了AI模型部署,具有低于100毫秒的延迟、企业级安全性以及无缝可扩展性。在几分钟内部署生产就绪的AI模型,并通过实时监控优化性能。