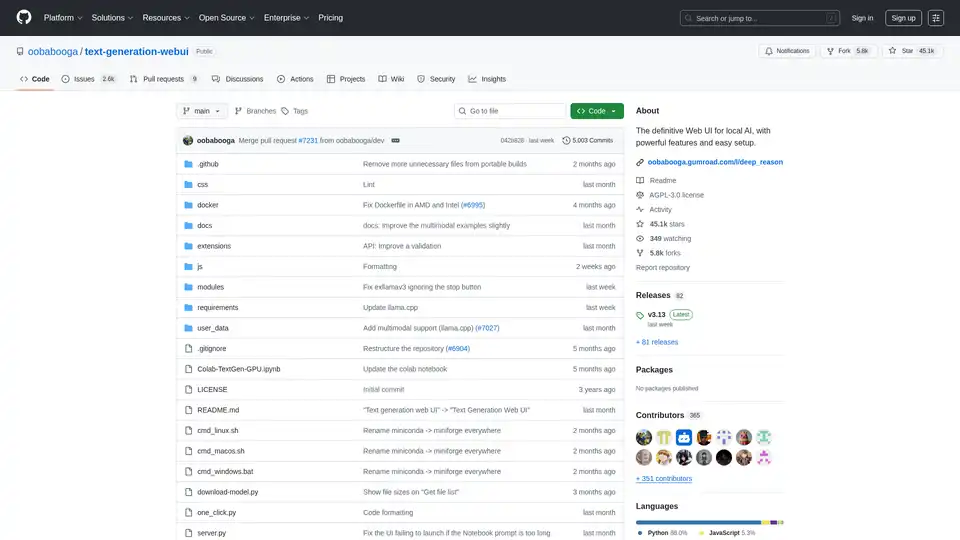

Text Generation Web UI

Visão geral de Text Generation Web UI

Interface Web de Geração de Texto: A Interface Web Definitiva para IA Local

O que é a Interface Web de Geração de Texto?

A Interface Web de Geração de Texto, também conhecida como oobabooga/text-generation-webui, é uma interface web Gradio amigável e rica em recursos, projetada para interagir com Grandes Modelos de Linguagem (LLMs) localmente. Ela fornece um conjunto abrangente de ferramentas e funcionalidades para aproveitar o poder da geração de texto por IA em sua própria máquina, garantindo privacidade e controle.

Como funciona a Interface Web de Geração de Texto?

Esta interface web atua como uma ponte entre você e vários backends de geração de texto locais. Ela suporta múltiplos backends como llama.cpp, Transformers, ExLlamaV3, ExLlamaV2 e TensorRT-LLM. A UI permite que você:

- Selecione seu backend preferido: Escolha o backend que melhor se adapta aos seus requisitos de hardware e modelo.

- Carregue e gerencie modelos: Carregue facilmente diferentes LLMs e alterne entre eles sem reiniciar o aplicativo.

- Configure parâmetros de geração: Ajuste o processo de geração de texto com vários parâmetros de amostragem e opções de geração.

- Interaja com o modelo: Use a interface de chat intuitiva ou a aba de notebook de forma livre para interagir com o modelo.

Por que escolher a Interface Web de Geração de Texto?

- Privacidade: Todo o processamento é feito localmente, garantindo que seus dados permaneçam privados.

- Funcionalidade offline: Nenhuma conexão com a internet é necessária, permitindo que você use a ferramenta a qualquer hora, em qualquer lugar.

- Versatilidade: Suporta múltiplos backends e tipos de modelo, proporcionando flexibilidade e customização.

- Extensibilidade: Oferece suporte a extensões para adicionar novos recursos e funcionalidades.

- Facilidade de uso: Interface amigável com temas escuros e claros, realce de sintaxe e renderização LaTeX.

Principais Recursos:

- Suporte a Múltiplos Backends: Integra-se perfeitamente com

llama.cpp,Transformers,ExLlamaV3,ExLlamaV2eTensorRT-LLM. - Fácil Configuração: Oferece builds portáteis para Windows/Linux/macOS, que não exigem configuração, e um instalador de um clique para um ambiente autocontido.

- Offline e Privado: Opera 100% offline sem telemetria, recursos externos ou solicitações de atualização remota.

- Anexos de Arquivo: Permite o upload de arquivos de texto, documentos PDF e arquivos .docx para discutir seu conteúdo com a IA.

- Visão (Modelos Multimodais): Suporta anexar imagens a mensagens para compreensão visual (tutorial).

- Pesquisa na Web: Pode opcionalmente pesquisar na internet com consultas geradas por LLM para adicionar contexto às conversas.

- UI Estética: Apresenta uma interface de usuário limpa e atraente com temas escuros e claros.

- Realce de Sintaxe e Renderização LaTeX: Fornece realce de sintaxe para blocos de código e renderização LaTeX para expressões matemáticas.

- Modos de Instrução e Chat: Inclui o modo de instrução para seguir instruções e modos de chat para interagir com personagens customizados.

- Formatação Automática de Prompts: Usa templates Jinja2 para formatação automática de prompts.

- Edição de Mensagens e Ramificação de Conversas: Permite editar mensagens, navegar entre versões e ramificar conversas.

- Múltiplos Parâmetros de Amostragem: Oferece controle sofisticado sobre a geração de texto com vários parâmetros de amostragem e opções de geração.

- Troca de Modelo: Permite alternar entre diferentes modelos na UI sem reiniciar.

- Camadas de GPU Automáticas: Configura automaticamente camadas de GPU para modelos GGUF em GPUs NVIDIA.

- Geração de Texto de Forma Livre: Fornece uma aba de Notebook para geração de texto de forma livre sem limitações de turnos de chat.

- API Compatível com OpenAI: Inclui uma API compatível com OpenAI com endpoints Chat e Completions, incluindo suporte para tool-calling.

- Suporte a Extensões: Suporta inúmeras extensões built-in e contribuídas por usuários.

Como Instalar a Interface Web de Geração de Texto:

- Builds Portáteis (Recomendado para Início Rápido): * Baixe o build portátil da página de releases.

- Descompacte o arquivo baixado.

- Execute o executável.

- Instalação Portátil Manual com venv: ```bash git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv

On Windows:

venv\Scripts\activate

On macOS/Linux:

source venv/bin/activate

pip install -r requirements/portable/requirements.txt --upgrade

python server.py --portable --api --auto-launch

deactivate

```

3. Instalador de Um Clique (Para usuários avançados): * Clone o repositório ou baixe o código fonte.

* Execute o script de inicialização para seu SO (start_windows.bat, start_linux.sh ou start_macos.sh).

* Selecione seu fornecedor de GPU quando solicitado.

* Após a instalação, abra http://127.0.0.1:7860 no seu navegador.

Download de Modelos:

Os modelos devem ser colocados na pasta text-generation-webui/user_data/models. Os modelos GGUF devem ser colocados diretamente nesta pasta, enquanto outros tipos de modelo devem ser colocados em uma subpasta.

Exemplo:

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

Você também pode usar a UI para baixar modelos automaticamente do Hugging Face ou usar a ferramenta de linha de comando:

python download-model.py organization/model

Execute python download-model.py --help para ver todas as opções.

Para quem é a Interface Web de Geração de Texto?

A Interface Web de Geração de Texto é ideal para:

- Pesquisadores e desenvolvedores que trabalham com LLMs.

- Entusiastas de IA que querem experimentar a geração de texto.

- Usuários que priorizam a privacidade e querem executar LLMs localmente.

Recursos Úteis:

A Interface Web de Geração de Texto fornece uma plataforma poderosa e versátil para explorar as capacidades da geração de texto por IA local. Sua facilidade de uso, extensos recursos e compromisso com a privacidade a tornam uma excelente escolha para qualquer pessoa interessada em trabalhar com Grandes Modelos de Linguagem em seus próprios termos.

Assistente de Programação com IA Complementação Automática de Código Revisão e Otimização de Código com IA Desenvolvimento Low-Code e No-Code com IA

Melhores ferramentas alternativas para "Text Generation Web UI"

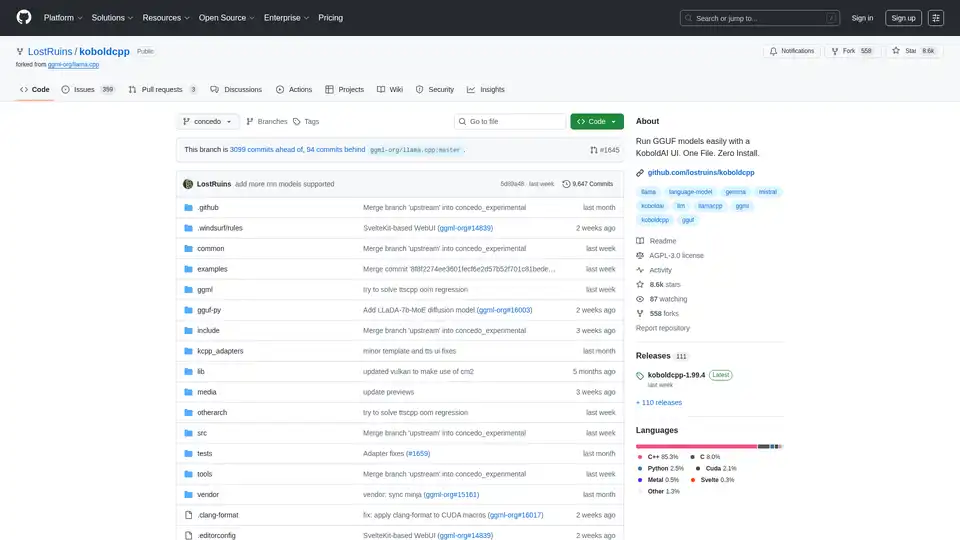

KoboldCpp: Execute modelos GGUF facilmente para geração de texto e imagem com IA usando uma interface KoboldAI. Arquivo único, instalação zero. Suporta CPU/GPU, STT, TTS e Stable Diffusion.

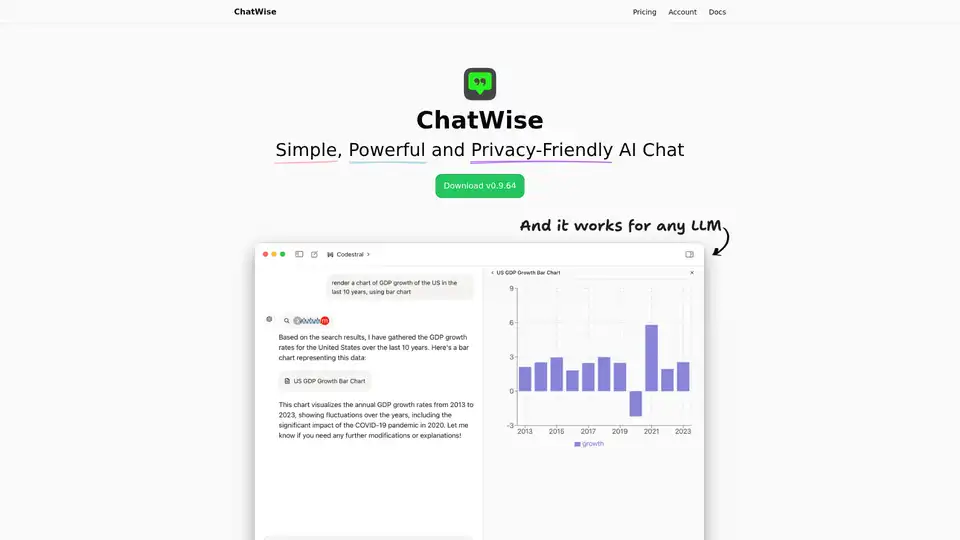

ChatWise é um chatbot de IA para desktop de alto desempenho e focado em privacidade, suportando GPT-4, Claude, Gemini, Llama e mais. Recursos incluem armazenamento local de dados, chats multimodais (áudio, PDF, imagens), pesquisa web, integração de chaves API e renderização de artefatos.

TypingMind é uma interface de usuário de chat AI que suporta GPT-4, Gemini, Claude e outros LLMs. Use suas chaves de API e pague apenas pelo que você usa. Melhor interface de usuário frontend LLM de chat para todos os modelos de IA.