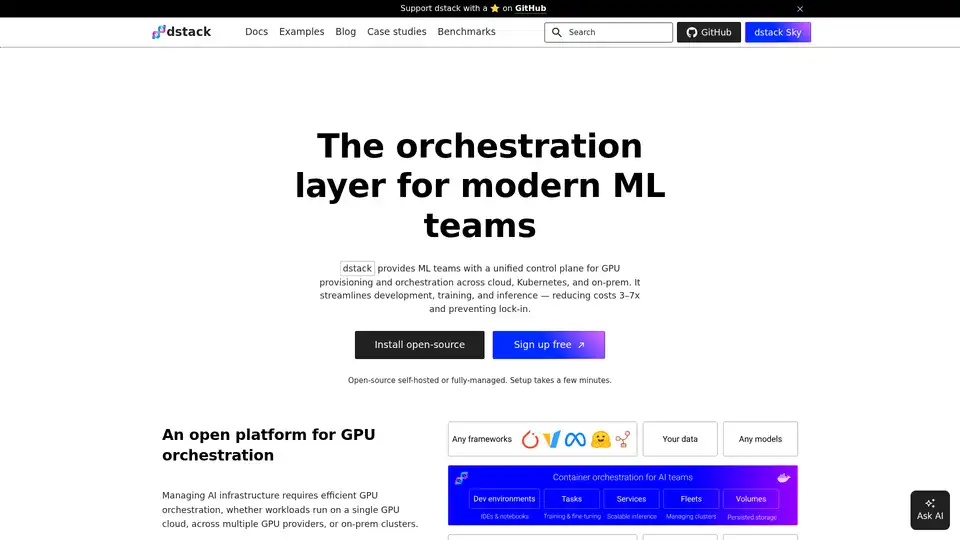

dstack

Visão geral de dstack

O que é dstack?

dstack é um mecanismo de orquestração de contêineres de AI de código aberto projetado para otimizar os processos de desenvolvimento, treinamento e inferência para equipes de aprendizado de máquina (ML). Ele oferece um plano de controle unificado para provisionamento e orquestração de GPU em vários ambientes, incluindo nuvem, Kubernetes e infraestrutura local. Ao reduzir custos e evitar o bloqueio de fornecedores, o dstack capacita as equipes de ML a se concentrarem em pesquisa e desenvolvimento, em vez de gerenciamento de infraestrutura.

Como funciona o dstack?

dstack opera como uma camada de orquestração que simplifica o gerenciamento da infraestrutura de AI. Ele se integra nativamente com as principais nuvens de GPU, automatizando o provisionamento de cluster e a orquestração de carga de trabalho. Ele também oferece suporte a Kubernetes e frotas SSH para conexão a clusters locais. As principais funcionalidades incluem:

- Orquestração de GPU: Gerencia eficientemente os recursos de GPU em diferentes ambientes.

- Ambientes de desenvolvimento: Permite fácil conexão de IDEs de desktop a GPUs poderosas na nuvem ou locais.

- Endpoints de serviço escaláveis: Facilita a implantação de modelos como endpoints seguros, com escalonamento automático e compatíveis com OpenAI.

dstack é compatível com qualquer hardware, ferramentas de código aberto e frameworks, oferecendo flexibilidade e evitando o bloqueio de fornecedores.

Principais recursos do dstack

- Plano de controle unificado: Fornece uma única interface para gerenciar recursos de GPU em diferentes ambientes.

- Integração nativa com nuvens de GPU: Automatiza o provisionamento de cluster e a orquestração de carga de trabalho com os principais provedores de nuvem de GPU.

- Suporte a Kubernetes e frotas SSH: Conecta-se a clusters locais usando Kubernetes ou frotas SSH.

- Ambientes de desenvolvimento: Simplifica o loop de desenvolvimento, permitindo a conexão com GPUs na nuvem ou locais.

- Endpoints de serviço escaláveis: Implanta modelos como endpoints seguros, com escalonamento automático, compatíveis com OpenAI.

- Tarefas de nó único e distribuídas: Suporta experimentos de instância única e treinamento distribuído em vários nós.

Por que escolher dstack?

dstack oferece vários benefícios atraentes para equipes de ML:

- Redução de custos: Reduz os custos de infraestrutura em 3 a 7 vezes por meio da utilização eficiente de recursos.

- Prevenção de bloqueio de fornecedores: Funciona com qualquer hardware, ferramentas de código aberto e frameworks.

- Gerenciamento simplificado de infraestrutura: Automatiza o provisionamento de cluster e a orquestração de carga de trabalho.

- Fluxo de trabalho de desenvolvimento aprimorado: Simplifica o loop de desenvolvimento com ambientes de desenvolvimento fáceis de usar.

De acordo com depoimentos de usuários:

- Wah Loon Keng, Sr. AI Engineer @Electronic Arts: "Com o dstack, os pesquisadores de AI da EA podem iniciar e dimensionar experimentos sem tocar na infraestrutura."

- Aleksandr Movchan, ML Engineer @Mobius Labs: "Graças ao dstack, minha equipe pode acessar rapidamente GPUs acessíveis e otimizar nossos fluxos de trabalho, desde testes e desenvolvimento até a implantação de aplicativos em grande escala."

Como usar dstack?

- Instalação: Instale o dstack via

uv tool install "dstack[all]". - Configuração: Configure backends ou frotas SSH.

- Adição de equipe: Adicione sua equipe ao ambiente dstack.

dstack pode ser implantado em qualquer lugar com a imagem Docker dstackai/dstack.

Para quem é o dstack?

dstack é ideal para:

- Equipes de ML que buscam otimizar a utilização de recursos de GPU.

- Organizações que buscam reduzir os custos de infraestrutura.

- Pesquisadores de AI que exigem ambientes escaláveis e flexíveis para experimentação.

- Engenheiros que visam otimizar seu fluxo de trabalho de desenvolvimento de ML.

Qual é a melhor maneira de orquestrar contêineres de AI?

dstack se destaca como uma solução de primeira linha para orquestração de contêineres de AI, oferecendo uma abordagem perfeita, eficiente e econômica para gerenciar recursos de GPU em diversos ambientes. Sua compatibilidade com Kubernetes, frotas SSH e integração nativa com as principais nuvens de GPU o torna uma escolha versátil para qualquer equipe de ML que busca melhorar a produtividade e reduzir os custos gerais de infraestrutura.

Assistente de Programação com IA Complementação Automática de Código Revisão e Otimização de Código com IA Desenvolvimento Low-Code e No-Code com IA

Melhores ferramentas alternativas para "dstack"

Juice permite GPU sobre IP, permitindo que você conecte em rede e agrupe suas GPUs com software para cargas de trabalho de IA e gráficos.

GreetAI oferece agentes de voz alimentados por IA para triagem eficiente de candidatos, treinamento de equipes e avaliação de desempenho em contratação, saúde e educação.

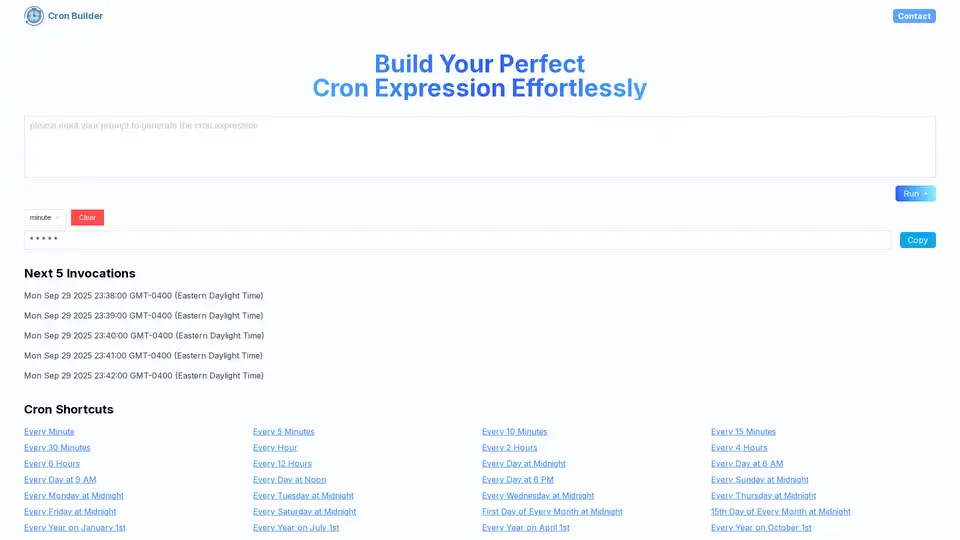

Cron AI Builder é uma ferramenta online que ajuda os usuários a gerar expressões cron facilmente usando descrições em linguagem natural e tecnologia de IA para automação de agendamento de tarefas.

Flyte orquestra fluxos de trabalho de IA/ML duráveis, flexíveis e nativos do Kubernetes. Com a confiança de mais de 3.000 equipes para a criação e implantação de pipelines escaláveis.