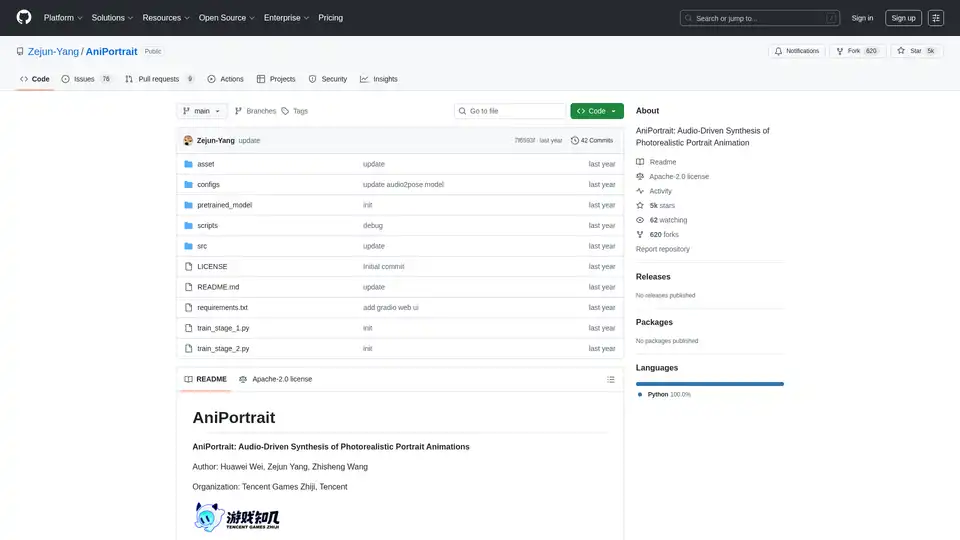

AniPortrait

Visão geral de AniPortrait

O que é AniPortrait?

AniPortrait é um framework open-source inovador projetado para síntese de animações de retratos fotorrealistas impulsionadas por áudio. Desenvolvido por Huawei Wei, Zejun Yang e Zhisheng Wang da Tencent Games Zhiji e Tencent, esta ferramenta aproveita técnicas avançadas de IA para criar retratos animados de alta qualidade a partir de uma única imagem de referência e entradas de áudio ou vídeo. Seja animando um retrato estático com áudio de fala ou recriando expressões faciais de um vídeo fonte, AniPortrait entrega resultados realistas que capturam nuances sutis como sincronização labial e movimentos de cabeça. Ideal para criadores de conteúdo, desenvolvedores de jogos e pesquisadores em visão computacional, ele se destaca no reino das ferramentas de geração de vídeo com IA ao focar em animações específicas de retratos.

Lançado no GitHub sob a licença Apache-2.0, AniPortrait acumulou mais de 5.000 estrelas, refletindo sua popularidade na comunidade de IA. O projeto enfatiza a acessibilidade, com modelos pré-treinados, guias detalhados de instalação e até uma interface web Gradio para testes fáceis.

Como AniPortrait Funciona?

Em seu núcleo, AniPortrait emprega um pipeline de múltiplas etapas que integra modelos de difusão, processamento de áudio e estimativa de poses para gerar animações. O framework se baseia em modelos estabelecidos como Stable Diffusion V1.5 e wav2vec2 para extração de características, garantindo um manuseio robusto da sincronização áudio-visual.

Componentes Chave e Fluxo de Trabalho

- Processamento de Entrada: Comece com uma imagem de retrato de referência. No modo impulsionado por áudio, entradas de áudio são processadas usando wav2vec2-base-960h para extrair características de fala. Em modos de vídeo, vídeos fonte são convertidos em sequências de poses via extração de pontos chave.

- Geração de Poses: O modelo audio2pose gera sequências de poses de cabeça (ex.: pose_temp.npy) a partir do áudio, permitindo controle sobre orientações faciais. Para recriação facial, uma estratégia de retargeting de poses mapeia movimentos do vídeo fonte para a imagem de referência, suportando diferenças substanciais de poses.

- Síntese de Animação: Utiliza UNet de desruído, UNet de referência e módulos de movimento para sintetizar frames. O guia de poses garante alinhamento, enquanto interpolação de frames opcional acelera a inferência.

- Refinamento de Saída: Gera vídeos em resoluções como 512x512, com opções de aceleração usando film_net_fp16.pt para reduzir o tempo de processamento.

Essa abordagem modular permite animações auto-dirigidas (usando poses predefinidas), recriação facial (transferindo expressões) e síntese totalmente impulsionada por áudio, tornando-o versátil para vários cenários de animação de retratos com IA.

Recursos Principais do AniPortrait

AniPortrait oferece uma gama de recursos poderosos adaptados para animação realista de retratos:

- Animação de Retratos Impulsionada por Áudio: Sincroniza movimentos labiais e expressões com entradas de áudio, perfeito para dublagem ou avatares virtuais.

- Recriação Facial: Transfere performances faciais de um vídeo fonte para um retrato alvo, ideal para aplicações éticas semelhantes a deepfake em mídia.

- Controle e Retargeting de Poses: Estratégias atualizadas lidam com diversas poses de cabeça, incluindo geração de arquivos de poses personalizados para controle preciso.

- Saída de Alta Resolução: Produz vídeos fotorrealistas com suporte para sequências mais longas (até 300 frames ou mais).

- Opções de Aceleração: Interpolação de frames e modelos FP16 aceleram a inferência sem sacrificar qualidade.

- Interface Web Gradio: Uma interface amigável para demos rápidas, também hospedada no Hugging Face Spaces para acesso online.

- Modelos Pré-Treinados: Inclui pesos para audio2mesh, audio2pose e componentes de difusão, baixáveis de fontes como Wisemodel.

Esses recursos tornam AniPortrait uma ferramenta essencial para síntese de vídeo impulsionada por IA, superando ferramentas básicas ao focar na fidelidade de retratos e coerência áudio-visual.

Instalação e Configuração

Começar é direto para usuários com Python >=3.10 e CUDA 11.7:

- Clone o repositório:

git clone https://github.com/Zejun-Yang/AniPortrait. - Instale dependências:

pip install -r requirements.txt. - Baixe pesos pré-treinados para

./pretrained_weights/, incluindo componentes Stable Diffusion, wav2vec2 e modelos personalizados comodenoising_unet.ptheaudio2pose.pt. - Organize arquivos conforme a estrutura de diretórios no README.

Para treinamento, prepare datasets como VFHQ ou CelebV-HQ extraindo pontos chave e executando scripts de pré-processamento. O treinamento ocorre em duas etapas usando Accelerate para processamento distribuído.

Como Usar AniPortrait?

Modos de Inferência

AniPortrait suporta três modos principais via scripts de linha de comando:

Animação Auto-Dirigida:

python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512 -accPersonalize com imagens de referência ou vídeos de poses. Converta vídeos em poses usando

python -m scripts.vid2pose --video_path input.mp4.Recriação Facial:

python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512 -accEdite o YAML para incluir vídeos fonte e referências.

Síntese Impulsionada por Áudio:

python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512 -accAdicione áudios e imagens à config. Ative audio2pose removendo pose_temp para geração automática de poses.

Para controle de pose de cabeça, gere poses de referência com python -m scripts.generate_ref_pose.

Demo Web

Inicie a interface Gradio: python -m scripts.app. Ou experimente a versão online no Hugging Face Spaces.

Usuários podem experimentar com vídeos de amostra como 'cxk.mp4' ou 'jijin.mp4' para ver a sincronização de áudio em ação, obtidos de plataformas como Bilibili.

Treinamento do AniPortrait do Zero

Usuários avançados podem treinar modelos personalizados:

- Preparação de Dados: Baixe datasets, pré-processe com

python -m scripts.preprocess_datasete atualize caminhos JSON. - Etapa 1:

accelerate launch train_stage_1.py --config ./configs/train/stage1.yaml. - Etapa 2: Baixe pesos do módulo de movimento, especifique checkpoints da Etapa 1 e execute

accelerate launch train_stage_2.py --config ./configs/train/stage2.yaml.

Esse processo ajusta finamente em dados específicos de retratos, aprimorando a generalização para tarefas de animação com IA.

Por Que Escolher AniPortrait?

Em um campo lotado de ferramentas de IA para geração de vídeo, AniPortrait se destaca devido ao seu foco especializado em retratos fotorrealistas. Diferente de modelos de propósito geral, ele lida com sincronização áudio-labial e expressões sutis com precisão, reduzindo artefatos em animações faciais. A natureza open-source permite customização, e atualizações recentes — como o lançamento de audio2pose em abril de 2024 e módulos de aceleração — o mantêm na vanguarda. Reconhecimentos da comunidade a projetos como EMO e AnimateAnyone destacam suas raízes colaborativas, garantindo desempenho confiável.

O valor prático inclui prototipagem mais rápida para influenciadores virtuais, vídeos educacionais ou assets de jogos. Com disponibilidade do paper no arXiv (eprint 2403.17694), ele serve pesquisadores explorando síntese áudio-visual em visão computacional.

Para Quem é AniPortrait?

- Criadores de Conteúdo e Cineastas: Para dublagem rápida ou transferências de expressões em vídeos de formato curto.

- Desenvolvedores de Jogos em Estúdios como Tencent: Integrando retratos animados em mídias interativas.

- Pesquisadores de IA: Experimentando com animação baseada em difusão e retargeting de poses.

- Hobbyistas e Educadores: Usando a interface web para ensinar conceitos de IA sem configuração pesada.

Se você está buscando a melhor maneira de criar animações de retratos impulsionadas por áudio, o equilíbrio do AniPortrait em qualidade, velocidade e acessibilidade o torna uma escolha principal.

Aplicações Potenciais e Casos de Uso

- Avatares Virtuais: Anime personagens digitais com fala sincronizada para mídias sociais ou metaversos.

- Ferramentas Educacionais: Gere vídeos de cabeças falantes para palestras ou tutoriais.

- Produção de Mídia: Recriação facial ética para recriações históricas ou anúncios.

- Prototipagem de Pesquisa: Benchmark de modelos áudio-para-vídeo em papers de CV.

Demonstrações incluem clipes auto-dirigidos como 'solo.mp4' e exemplos de áudio como 'kara.mp4', exibindo integração perfeita.

Para solução de problemas, verifique as 76 issues abertas no GitHub ou contribua via pull requests. No geral, AniPortrait capacita usuários a empurrar limites na animação de retratos com IA com resultados confiáveis e de alta fidelidade.

Melhores ferramentas alternativas para "AniPortrait"

Lip Sync AI transforma fotos estáticas em vídeos falantes usando tecnologia avançada de sincronização labial com IA. Envie uma foto e um arquivo de áudio para gerar vídeos realistas com sincronização labial e expressões naturais.

Plexigen AI: O melhor gerador de vídeo AI com som. Crie vídeos profissionais a partir de texto e imagens. Geração de vídeo AI de alta qualidade, vários formatos, renderização rápida.

ClipGen é uma ferramenta alimentada por IA que transforma podcasts em clipes de vídeo curtos virais instantaneamente. Faça upload de áudio/vídeo ou URL do YouTube, deixe seu algoritmo analisar e selecionar os melhores clipes, adicione legendas e otimize para plataformas sociais como TikTok, Instagram e LinkedIn, tudo em menos de 20 minutos, grátis.

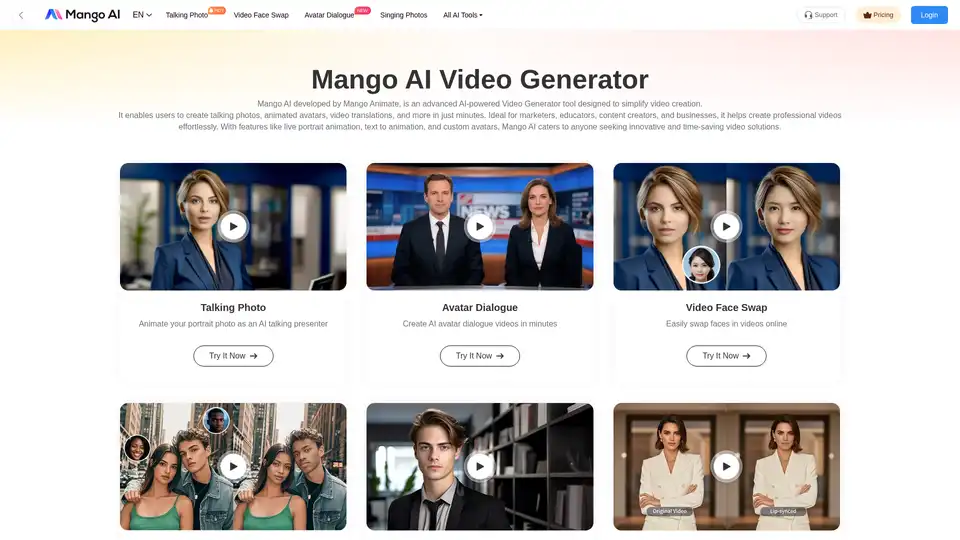

Mango AI é um gerador de vídeo com tecnologia de IA que cria fotos falantes, avatares e trocas de rosto sem esforço. Ideal para profissionais de marketing, educadores e criadores de conteúdo.