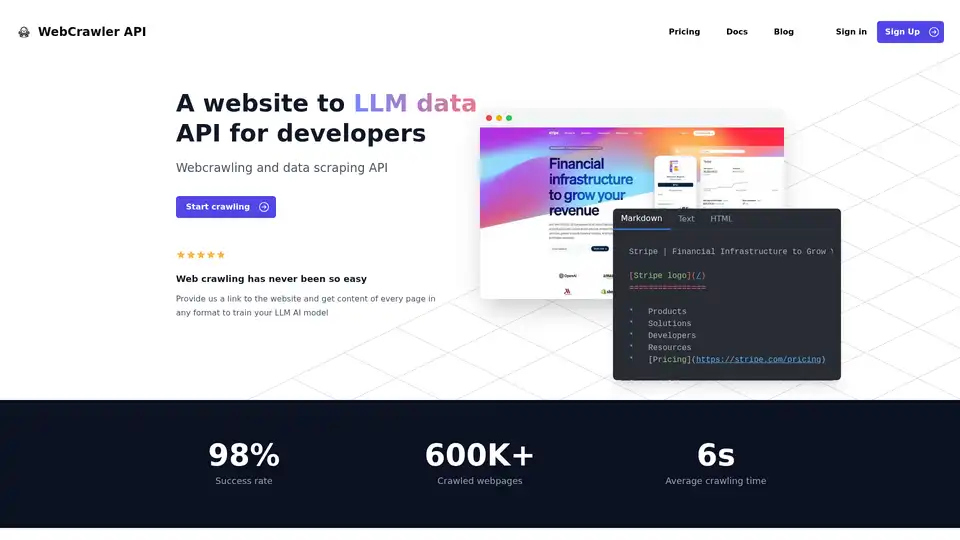

WebCrawler API 개요

WebCrawler API: AI를 위한 간편한 웹 크롤링 및 데이터 추출

WebCrawler API란 무엇인가요? 이는 특히 대규모 언어 모델(LLM) 및 기타 AI 애플리케이션을 훈련하기 위해 웹사이트에서 데이터를 추출하는 프로세스를 간소화하도록 설계된 강력한 도구입니다. 웹 크롤링의 복잡성을 처리하여 데이터 활용에 집중할 수 있도록 합니다.

주요 기능:

- 간편한 통합: NodeJS, Python, PHP 또는 .NET을 사용하여 몇 줄의 코드로 WebCrawlerAPI를 통합합니다.

- 다양한 출력 형식: 필요에 따라 Markdown, 텍스트 또는 HTML 형식으로 콘텐츠를 수신합니다.

- 높은 성공률: 98%의 성공률을 자랑하는 WebCrawlerAPI는 봇 방지 차단, CAPTCHA 및 IP 차단과 같은 일반적인 크롤링 문제를 극복합니다.

- 포괄적인 링크 처리: 내부 링크를 관리하고, 중복을 제거하고, URL을 정리합니다.

- JS 렌더링: JavaScript가 많은 웹사이트를 처리하기 위해 Puppeteer 및 Playwright를 안정적인 방식으로 사용합니다.

- 확장 가능한 인프라: 수백만 개의 크롤링된 페이지를 안정적으로 관리하고 저장합니다.

- 자동 데이터 정리: 복잡한 구문 분석 규칙을 사용하여 HTML을 깨끗한 텍스트 또는 Markdown으로 변환합니다.

- 프록시 관리: 무제한 프록시 사용이 포함되어 있으므로 IP 제한에 대해 걱정할 필요가 없습니다.

WebCrawler API는 어떻게 작동합니까?

WebCrawler API는 다음과 같은 웹 크롤링의 어려움을 추상화합니다.

- 링크 처리: 내부 링크를 관리하고, 중복을 제거하고, URL을 정리합니다.

- JS 렌더링: JavaScript가 많은 웹사이트를 렌더링하여 동적 콘텐츠를 추출합니다.

- 봇 방지 차단: CAPTCHA, IP 차단 및 속도 제한을 우회합니다.

- 저장: 대량의 크롤링된 데이터를 관리하고 저장합니다.

- 확장: 서로 다른 서버에서 여러 크롤러를 처리합니다.

- 데이터 정리: HTML을 깨끗한 텍스트 또는 Markdown으로 변환합니다.

WebCrawlerAPI는 이러한 기본 복잡성을 처리함으로써 추출된 데이터를 AI 프로젝트에 활용하는 데 집중할 수 있도록 합니다.

WebCrawler API 사용 방법

- 계정에 가입하고 API 액세스 키를 얻습니다.

- 선호하는 프로그래밍 언어를 선택하십시오: NodeJS, Python, PHP 또는 .NET.

- WebCrawlerAPI 클라이언트를 코드에 통합합니다.

- 대상 URL과 원하는 출력 형식(Markdown, 텍스트 또는 HTML)을 지정합니다.

- 크롤링을 시작하고 추출된 콘텐츠를 검색합니다.

NodeJS를 사용한 예:

// npm i webcrawlerapi-js

import webcrawlerapi from "webcrawlerapi-js";

async function main() {

const client = new webcrawlerapi.WebcrawlerClient(

"YOUR API ACCESS KEY HERE",

)

const syncJob = await client.crawl({

"items_limit": 10,

"url": "https://stripe.com/",

"scrape_type": "markdown"

}

)

console.log(syncJob);

}

main().catch(console.error);

WebCrawler API를 선택하는 이유

- 핵심 비즈니스에 집중: 복잡한 웹 크롤링 인프라를 관리하는 데 시간과 리소스를 낭비하지 마십시오.

- 정리되고 구조화된 데이터에 액세스: AI 훈련을 위해 즉시 사용할 수 있는 원하는 형식으로 데이터를 수신합니다.

- 데이터 추출 노력을 확장: 인프라 제한에 대해 걱정하지 않고 수백만 페이지를 처리합니다.

- 비용 효율적인 가격: 성공적인 요청에 대해서만 비용을 지불하고 구독료는 없습니다.

WebCrawler API는 누구를 위한 것입니까?

WebCrawler API는 다음에 적합합니다.

- AI 및 머신 러닝 엔지니어: 모델을 훈련하기 위해 대규모 데이터 세트가 필요합니다.

- 데이터 과학자: 분석 및 연구를 위해 웹사이트에서 데이터를 추출해야 합니다.

- 기업: 경쟁사를 모니터링하고, 시장 동향을 추적하고, 고객 통찰력을 수집해야 합니다.

가격

WebCrawlerAPI는 구독료 없이 간단한 사용량 기반 가격을 제공합니다. 성공적인 요청에 대해서만 비용을 지불합니다. 크롤링할 페이지 수에 따라 월별 비용을 예측할 수 있는 비용 계산기를 사용할 수 있습니다.

FAQ

- WebcrawlerAPI란 무엇입니까? WebcrawlerAPI는 프록시, 재시도 및 헤드리스 브라우저를 처리하여 높은 성공률로 웹사이트에서 콘텐츠를 추출할 수 있는 API입니다.

- 특정 페이지 또는 웹사이트 전체만 크롤링할 수 있습니까? 요청할 때 특정 페이지 또는 웹사이트 전체를 크롤링할지 여부를 지정할 수 있습니다.

- 크롤링된 데이터를 RAG에서 사용하거나 자체 AI 모델을 훈련할 수 있습니까? 예, 크롤링된 데이터는 검색 증강 생성(RAG) 시스템에서 사용하거나 자체 AI 모델을 훈련하는 데 사용할 수 있습니다.

- WebcrawlerAPI를 사용하려면 구독료를 지불해야 합니까? 아니요, 구독료는 없습니다. 성공적인 요청에 대해서만 비용을 지불합니다.

- 구매하기 전에 WebcrawlerAPI를 사용해 볼 수 있습니까? 평가판 옵션에 대해 문의하려면 그들에게 연락하십시오.

- 통합에 대한 도움이 필요한 경우 어떻게 해야 합니까? 이메일 지원이 제공됩니다.

WebCrawlerAPI를 사용하여 AI 훈련을 위한 웹사이트 데이터를 추출하는 가장 좋은 방법

WebCrawlerAPI는 웹사이트 데이터를 추출하기 위한 간소화된 솔루션을 제공하여 웹 크롤링의 복잡성을 간소화하고 AI 모델 훈련 및 데이터 분석에 집중할 수 있도록 합니다. 높은 성공률, 다양한 출력 형식 및 효율적인 데이터 정리 기능을 통해 AI 엔지니어, 데이터 과학자 및 기업이 웹에서 가치 있는 통찰력을 효과적으로 수집할 수 있습니다.

"WebCrawler API"의 최고의 대체 도구

Firecrawl은 AI 애플리케이션을 위해 설계된 선도적인 웹 크롤링, 스크래핑 및 검색 API입니다. 웹사이트를 깨끗하고 구조화된 LLM 준비 데이터로 변환하여 프록시나 복잡함 없이 신뢰할 수 있는 웹 추출로 AI 에이전트를 대규모로 강화합니다.

Skrape.ai를 사용하여 모든 웹 사이트를 깨끗하고 구조화된 데이터로 변환하십시오. AI 기반 API는 AI 교육을 위해 선호하는 형식으로 데이터를 추출합니다.

Olostep은 AI 및 연구 에이전트를 위한 웹 데이터 API입니다. 실시간으로 모든 웹사이트에서 구조화된 웹 데이터를 추출하고 웹 연구 워크플로우를 자동화할 수 있습니다. 사용 사례로는 AI 데이터, 스프레드시트 확장, 잠재 고객 생성 등이 있습니다.

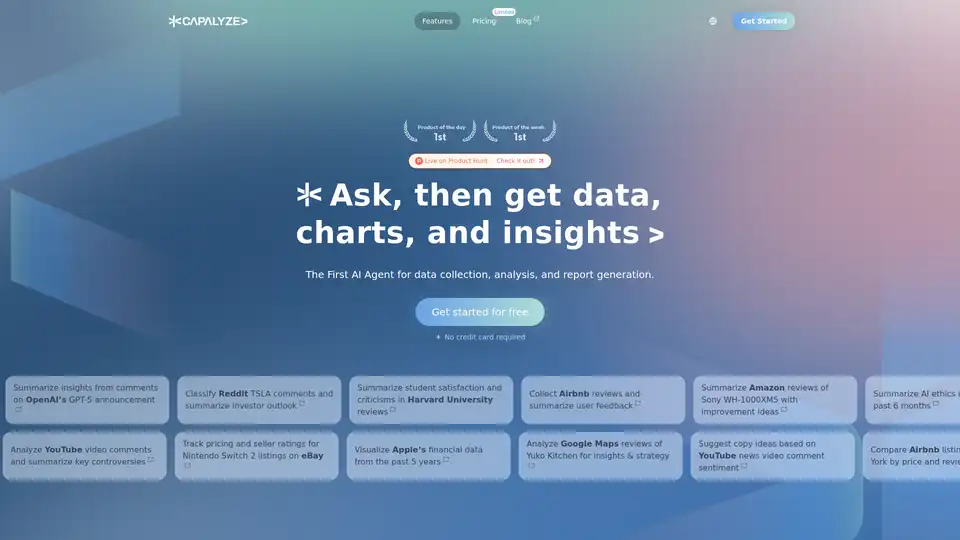

Capalyze는 다중 소스 통합과 웹 데이터 크롤링을 통해 비즈니스에 인사이트를 제공하여 더 스마트한 의사 결정을 촉진하는 데이터 분석 도구입니다.