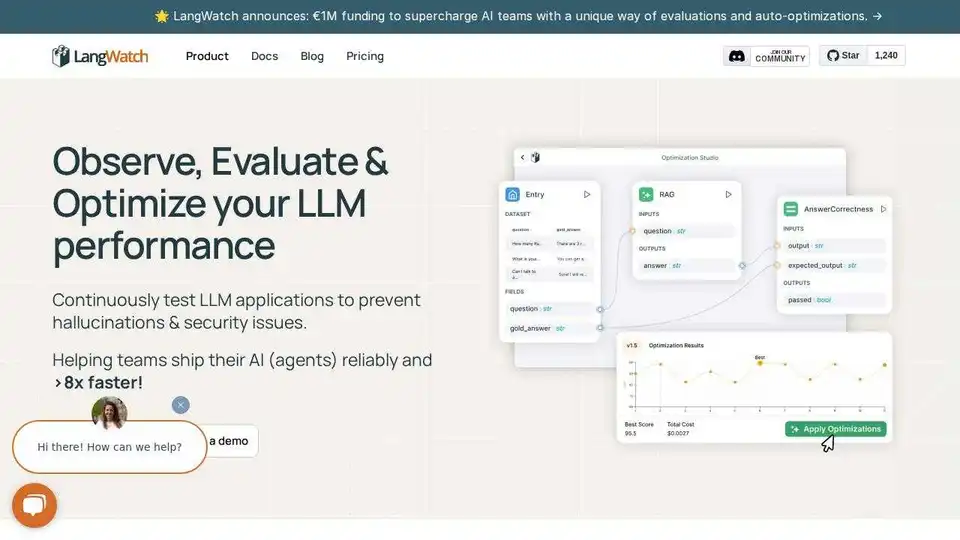

LangWatch 개요

LangWatch: AI 에이전트 테스트 및 LLM 평가 플랫폼

LangWatch는 AI 에이전트 테스트, LLM 평가 및 LLM 관찰 가능성을 위해 설계된 오픈 소스 플랫폼입니다. 팀이 AI 에이전트를 시뮬레이션하고, 응답을 추적하고, 생산에 영향을 미치기 전에 오류를 포착하는 데 도움이 됩니다.

주요 기능:

- 에이전트 시뮬레이션: 시뮬레이션된 사용자로 AI 에이전트를 테스트하여 에지 케이스를 포착하고 회귀를 방지합니다.

- LLM 평가: 데이터 선택 및 테스트를 위한 내장 도구를 사용하여 LLM의 성능을 평가합니다.

- LLM 관찰 가능성: 응답을 추적하고 프로덕션 AI에서 문제를 디버그합니다.

- 프레임워크 유연성: 모든 LLM 앱, 에이전트 프레임워크 또는 모델에서 작동합니다.

- OpenTelemetry 네이티브: 모든 LLM 및 AI 에이전트 프레임워크와 통합됩니다.

- 자체 호스팅: 완전한 오픈 소스; 로컬로 실행하거나 자체 호스팅합니다.

LangWatch 사용 방법:

- 빌드: 추측이 아닌 증거로 더 스마트한 에이전트를 설계합니다.

- 평가: 데이터 선택, 평가 및 테스트를 위한 내장 도구를 사용합니다.

- 배포: 재작업을 줄이고, 회귀를 관리하고, AI에 대한 신뢰를 구축합니다.

- 모니터링: 응답을 추적하고 생산에 영향을 미치기 전에 오류를 포착합니다.

- 최적화: 전체 팀과 협력하여 실험을 실행하고, 데이터 세트를 평가하고, 프롬프트와 흐름을 관리합니다.

통합:

LangWatch는 다음을 포함한 다양한 프레임워크 및 모델과 통합됩니다.

- Python

- Typescript

- OpenAI 에이전트

- LiteLLM

- DSPy

- LangChain

- Pydantic AI

- AWS Bedrock

- Agno

- Crew AI

LangWatch가 적합한가요?

LangWatch는 더 나은 AI 에이전트 구축에 협력하려는 AI 엔지니어, 데이터 과학자, 제품 관리자 및 도메인 전문가에게 적합합니다.

자주 묻는 질문:

- LangWatch는 어떻게 작동합니까?

- LLM 관찰 가능성이란 무엇입니까?

- LLM 평가란 무엇입니까?

- LangWatch 자체 호스팅을 사용할 수 있습니까?

- LangWatch는 Langfuse 또는 LangSmith와 비교하여 어떻습니까?

- LangWatch는 어떤 모델과 프레임워크를 지원하며 어떻게 통합할 수 있습니까?

- LangWatch를 무료로 사용해 볼 수 있습니까?

- LangWatch는 보안 및 규정 준수를 어떻게 처리합니까?

- 프로젝트에 어떻게 기여할 수 있습니까?

LangWatch는 자신감 있게 에이전트를 배송하는 데 도움이 됩니다. 단 5분 만에 시작하십시오.

"LangWatch"의 최고의 대체 도구

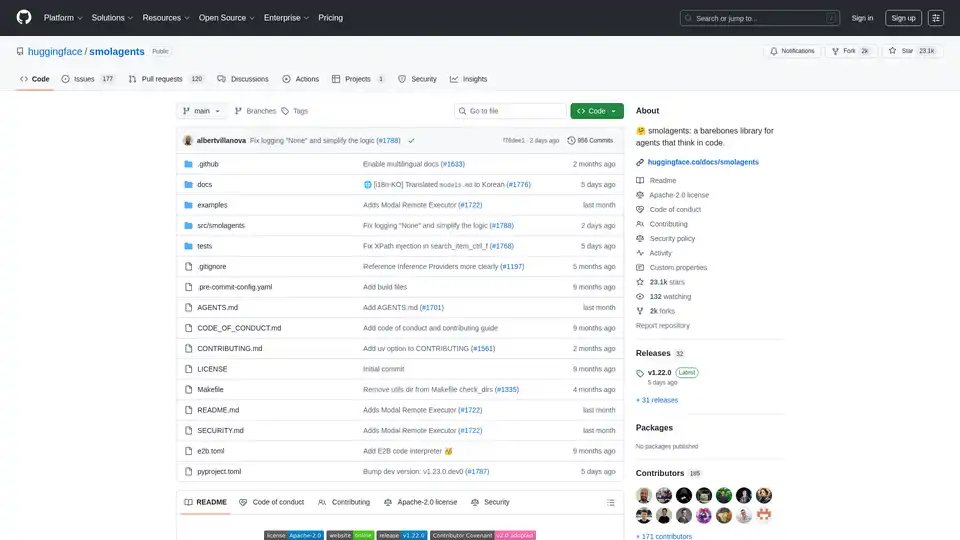

smolagents는 코드로 추론하고 행동하는 AI 에이전트를 생성하기 위한 미니멀리즘 Python 라이브러리입니다. LLM-agnostic 모델, 보안 샌드박스, Hugging Face Hub와의 원활한 통합을 지원하여 효율적인 코드 기반 에이전트 워크플로를 제공합니다.

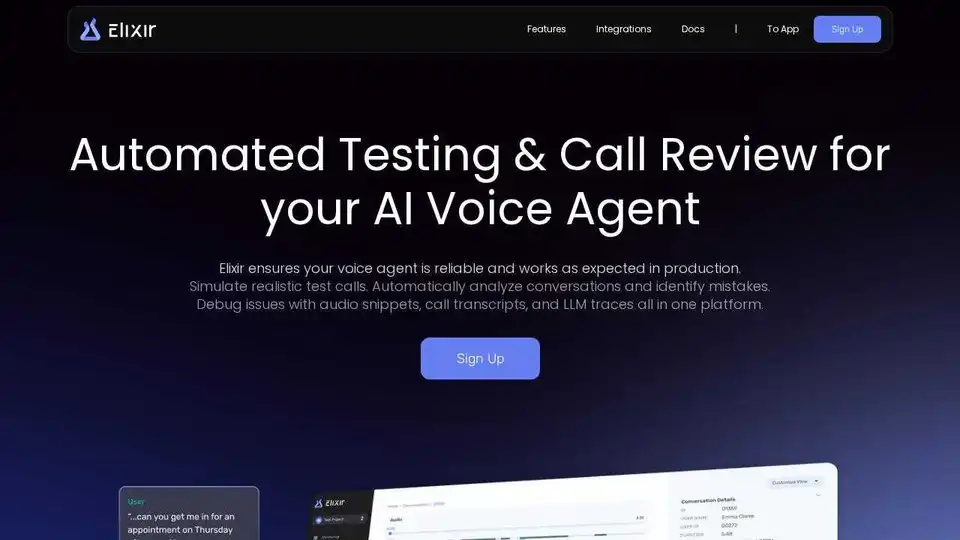

Elixir는 AI 음성 에이전트를 모니터링, 테스트 및 디버깅하도록 설계된 AI Ops 및 QA 플랫폼입니다. 안정적인 성능을 보장하기 위해 자동화된 테스트, 통화 검토 및 LLM 추적을 제공합니다.

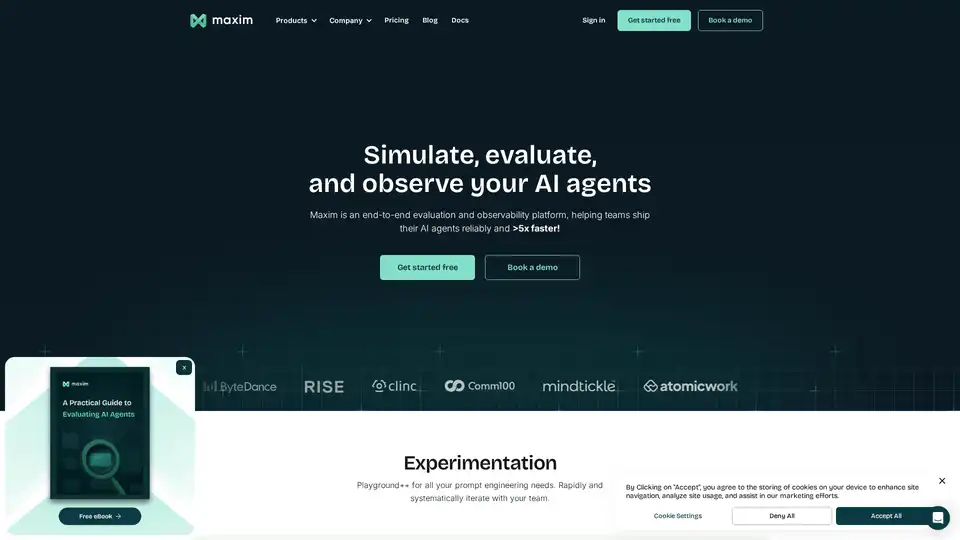

Maxim AI는 포괄적인 테스트, 모니터링 및 품질 보증 도구를 갖춘 end-to-end 평가 및 관찰 가능성 플랫폼으로, 팀이 AI 에이전트를 안정적으로 5배 더 빠르게 출시할 수 있도록 지원합니다.

HoneyHive는 LLM 애플리케이션을 구축하는 팀을 위한 AI 평가, 테스트 및 관찰 가능성 도구를 제공합니다. 통합 LLMOps 플랫폼을 제공합니다.