Avian API 개요

Avian API: 오픈 소스 LLM을 위한 가장 빠른 AI 추론

Avian API는 Llama와 같은 오픈 소스 Large Language Models (LLM)를 위한 가장 빠른 AI 추론을 제공하는 플랫폼입니다. 사용자는 Hugging Face에서 LLM을 업계 평균보다 3-10배 빠른 속도로 배포하고 실행할 수 있습니다. Avian을 사용하면 속도 제한 없이 프로덕션급 AI 추론을 경험하고, 서버리스 아키텍처를 활용하거나 Hugging Face에서 LLM을 배포할 수 있습니다.

Avian API란 무엇입니까?

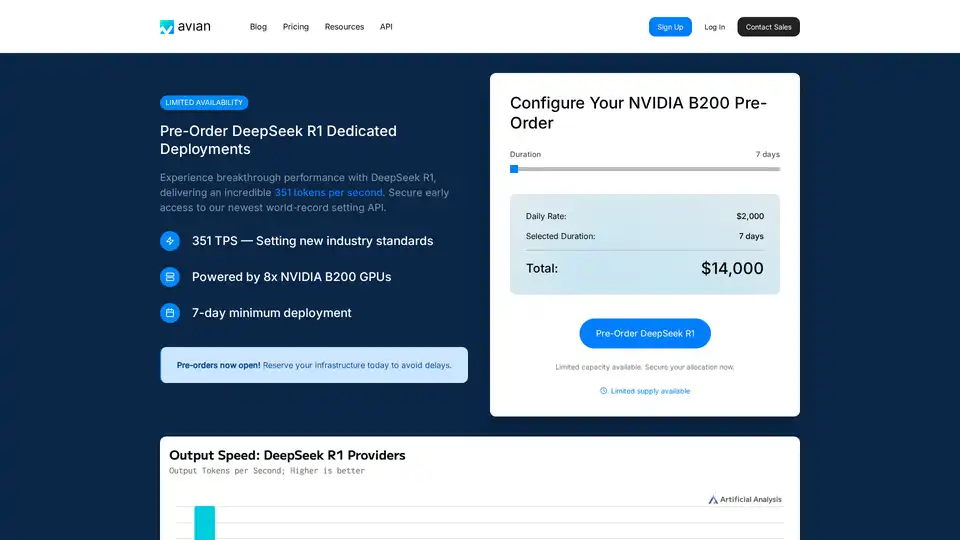

Avian API는 속도, 개인 정보 보호 및 사용 편의성에 중점을 두고 고성능 AI 추론을 제공하도록 설계되었습니다. 특히 DeepSeek R1과 같은 모델에서 **초당 351 토큰 (TPS)**을 달성하여 업계 최고의 추론 속도를 제공하는 것으로 두각을 나타냅니다. 이 성능은 최적화된 NVIDIA B200 아키텍처에 의해 구동되어 AI 추론 환경에서 새로운 표준을 설정합니다.

Avian API는 어떻게 작동합니까?

Avian API는 최적화된 인프라와 독점 기술을 활용하여 추론 프로세스를 가속화합니다. 주요 기능은 다음과 같습니다.

- 고속 추론: DeepSeek R1과 같은 모델에서 최대 351 TPS 달성.

- Hugging Face 통합: 최소한의 구성으로 모든 Hugging Face 모델을 배포할 수 있습니다.

- 자동 최적화 및 확장: 모델을 자동으로 최적화하고 확장하여 일관된 성능을 보장합니다.

- OpenAI 호환 API 엔드포인트: OpenAI와 호환되는 사용하기 쉬운 API 엔드포인트를 제공하여 기존 워크플로에 통합을 간소화합니다.

- 엔터프라이즈급 성능 및 개인 정보 보호: 데이터 저장 없이 안전한 SOC/2 승인 Microsoft Azure 인프라를 기반으로 구축되었습니다.

주요 기능 및 이점

- 가장 빠른 추론 속도: Avian API는 타의 추종을 불허하는 추론 속도를 제공하므로 실시간 응답이 필요한 애플리케이션에 이상적입니다.

- 쉬운 통합: OpenAI 호환 API를 통해 Avian은 최소한의 코드 변경으로 기존 프로젝트에 쉽게 통합할 수 있습니다.

- 비용 효율적: Avian은 리소스 활용률을 최적화하여 AI 추론과 관련된 비용을 절감하는 데 도움이 됩니다.

- 개인 정보 보호 및 보안: Avian은 SOC/2 규정 준수 및 개인 호스팅 옵션을 통해 데이터 개인 정보 보호 및 보안을 보장합니다.

Avian API 사용 방법

Avian API를 사용하는 방법은 몇 가지 간단한 단계로 이루어집니다.

- 가입: Avian.io 플랫폼에서 계정을 만듭니다.

- API 키 가져오기: 대시보드에서 고유한 API 키를 가져옵니다.

- 모델 선택: Hugging Face에서 선호하는 오픈 소스 모델을 선택하거나 최적의 성능을 위해 DeepSeek R1을 사용합니다.

- API 통합: 제공된 코드 스니펫을 사용하여 Avian API를 애플리케이션에 통합합니다.

다음은 Avian API를 사용하는 예제 코드 스니펫입니다.

from openai import OpenAI

import os

client = OpenAI(

base_url="https://api.avian.io/v1",

api_key=os.environ.get("AVIAN_API_KEY")

)

response = client.chat.completions.create(

model="DeepSeek-R1",

messages=[

{

"role": "user",

"content": "What is machine learning?"

}

],

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="")

이 코드 스니펫은 Avian API를 사용하여 DeepSeek-R1 모델에서 응답을 생성하는 방법을 보여줍니다. base_url을 변경하고 API 키를 사용하여 시작하기만 하면 됩니다.

Avian API를 선택하는 이유는 무엇입니까?

Avian API는 속도, 보안 및 사용 편의성에 중점을 두고 있기 때문에 두드러집니다. 다른 추론 솔루션과 비교하여 Avian은 다음을 제공합니다.

- 우수한 성능: DeepSeek R1에서 351 TPS를 달성하여 Together, Fireworks 및 Amazon과 같은 경쟁사보다 훨씬 빠릅니다.

- 간소화된 배포: 모든 Hugging Face 모델에 대한 한 줄 코드 통합.

- 엔터프라이즈급 보안: SOC/2 규정 준수 및 채팅을 위한 개인 정보 보호 모드.

Avian API는 누구를 위한 것입니까?

Avian API는 다음에 이상적입니다.

- 엔터프라이즈: 고성능, 안전하고 확장 가능한 AI 추론이 필요한 기업.

- 개발자: AI를 애플리케이션에 통합하기 위한 사용하기 쉬운 API를 찾는 개발자.

- 연구원: AI 모델에 대한 빠르고 안정적인 추론이 필요한 연구원.

결론

Avian API는 오픈 소스 LLM을 위한 가장 빠른 AI 추론을 제공하므로 프로젝트에서 AI의 힘을 활용하려는 모든 사람에게 필수적인 도구입니다. 고속 성능, 쉬운 통합 및 엔터프라이즈급 보안을 통해 Avian API는 AI 추론 환경에서 새로운 표준을 설정하고 있습니다. Hugging Face에서 모델을 배포하든 최적화된 NVIDIA B200 아키텍처를 활용하든 Avian API는 타의 추종을 불허하는 속도와 효율성을 제공합니다.

"Avian API"의 최고의 대체 도구

Nebius AI Studio Inference Service는 호스팅된 오픈소스 모델을 제공하여 독점 API보다 더 빠르고 저렴하며 정확한 추론 결과를 제공합니다. MLOps 없이 원활하게 확장 가능하며, RAG 및 생산 워크로드에 이상적입니다。

Release.ai는 100ms 미만의 대기 시간, 엔터프라이즈급 보안 및 원활한 확장성을 통해 AI 모델 배포를 간소화합니다. 몇 분 안에 프로덕션 준비가 완료된 AI 모델을 배포하고 실시간 모니터링을 통해 성능을 최적화하십시오.

Nexa SDK는 LLM, 멀티모달, ASR 및 TTS 모델에 대해 빠르고 개인 정보 보호가 가능한 장치 내 AI 추론을 가능하게 합니다. NPU, GPU 및 CPU를 통해 모바일, PC, 자동차 및 IoT 장치에 프로덕션 준비 성능으로 배포하십시오.

DeepSeek-v3는 MoE 아키텍처를 기반으로 한 AI 모델로, 광범위한 교육과 다국어 지원을 통해 안정적이고 빠른 AI 솔루션을 제공합니다.