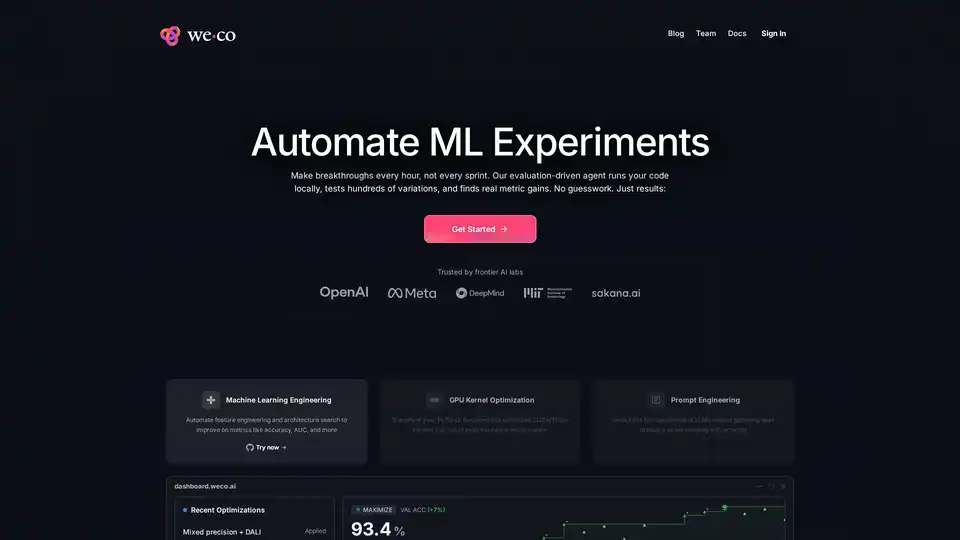

Weco AI の概要

Weco AIとは?

Weco AIは、AIDE MLテクノロジーを使用してML実験を自動化する高度な機械学習最適化プラットフォームです。この革新的なシステムは、大規模言語モデル駆動のエージェントを採用し、評価主導の実験を通じて機械学習パイプラインを体系的に最適化します。

Weco AIの仕組み

プラットフォームは高度な3段階プロセスで動作します:

1. ローカル評価システム

Weco AIは独自のインフラストラクチャ上でコードをローカル実行し、データプライバシーを確保しながらML環境の完全な制御を維持します。システムはシンプルなコマンドラインインターフェースを通じて評価スクリプトに接続します。

2. 自動化実験

AIDE MLエージェントを使用して、Wecoは数百のコードバリエーションを体系的にテストします:

- アーキテクチャ変更(モデル構造変更)

- ハイパーパラメータ最適化(学習率、バッチサイズ)

- データ拡張技術(CutMix、RandAugment)

- パフォーマンス最適化(混合精度、CUDAカーネル)

- トレーニング方法論の改善(スケジューラ変更、正則化技術)

3. メトリック駆動最適化

システムは指定されたメトリック(精度、AUC、スループットなど)に対してパフォーマンスを継続的に評価し、実証結果に基づいてソリューションを進化させ、成功したバリエーションのツリー検索を作成します。

コア機能と能力

🚀 自動化MLエンジニアリング

- 特徴量エンジニアリング自動化:特徴量変換を体系的に探索・実装

- アーキテクチャ検索:様々なモデルアーキテクチャと構成をテスト

- ハイパーパラメータ最適化:最適なパラメータ組み合わせを自動探索

⚡ GPUカーネル最適化

- CUDA/Tritonカーネル生成:PyTorch関数を最適化されたGPUカーネルに変換

- ハードウェアパフォーマンス最大化:ピークハードウェア使用率を達成

- 混合精度実装:FP16/FP32混合トレーニングを自動実装

🤖 プロンプトエンジニアリング自動化

- LLM最適化:プロンプトバリエーションを自動実験

- 体系的テスト:数百のプロンプト組み合わせを評価

- パフォーマンス追跡:LLM出力品質を測定・比較

実用的な応用とユースケース

Weco AIは複数のMLシナリオで優れた性能を発揮します:

研究開発

- 学術研究:実験の自動化によりML研究を加速

- 産業界R&D:製品開発サイクルを迅速化

- ベンチマーク最適化:標準化ベンチマークでの性能向上

生産MLシステム

- モデル性能改善:生産モデルの精度と効率性向上

- インフラストラクチャ最適化:より良いリソース活用による計算コスト削減

- デプロイメント準備:生産環境向けに最適化されたモデルを確保

専門最適化タスク

- コンピュータビジョンモデル:CNN、トランスフォーマーなどの視覚アーキテクチャを最適化

- NLPシステム:言語モデルの性能と効率性を改善

- 強化学習:RLアルゴリズムと環境を最適化

技術的実装

プラットフォームは複数のプログラミング言語とフレームワークをサポート:

- 主要言語:Python(PyTorch、TensorFlow、JAX)

- 追加サポート:C++、Rust、JavaScript

- フレームワーク互換性:主要MLフレームワークとカスタム実装に対応

- ハードウェア柔軟性:様々なGPUアーキテクチャをサポート(NVIDIA、AMD、Apple Silicon)

性能と結果

Weco AIは様々なベンチマークで顕著な改善を実証:

- CIFAR-10検証:ベースライン比+7%精度向上達成

- ResNet-18最適化:混合精度とDALI実装により2.3倍高速化

- OpenAI MLE-Bench:次善の自律エージェント比4倍多いメダル獲得

- METR RE-Bench:6時間最適化チャレンジで人間の専門家を凌駕

Weco AIの対象者

ターゲットオーディエンス

- MLエンジニア:ワークフローの自動化と最適化を求める専門家

- AI研究者:実験加速を求める学者・研究者

- データサイエンティスト:効率的なモデル性能改善を求める実践者

- テクノロジー企業:MLオペレーションの拡大を目指す組織

スキル要件

- 中級ML知識:機械学習概念の理解

- プログラミング習熟度:PythonとMLフレームワークへの慣れ

- 実験的マインドセット:自動化実験を受け入れる意思

Weco AIの始め方

プラットフォームは straightforward なオンボーディングプロセスを提供:

- インストール:

pip install weco - 設定:評価スクリプトを指定

- 実行:最適化コマンドを実行

- 監視:ダッシュボードでリアルタイム進捗を確認

平均オンボーディング時間は10分未満で、あらゆる規模のチームにアクセス可能。

Weco AIを選ぶ理由

競争優位性

- プライバシーファーストアプローチ:データがインフラストラクチャ外に出ない

- コスト効率性:より少ない計算リソースでより多くを達成

- 体系的方法論:実証済みAIDE ML研究に基づく

- 実証済み結果:複数ベンチマークでの成功実績

- オープンソース基盤:コアテクノロジーは検査と貢献に開放

代替方案との比較

単発コード生成ツールとは異なり、Weco AIは体系的評価と反復を採用し、推測的変更ではなく測定可能な改善を保証。

価格とアクセシビリティ

Weco AIはクレジットベースの価格システムを使用:

- 無料ティア:20クレジット(約100最適化ステップ)

- 初期利用にクレジットカード不要

- 透明な価格設定:最適化ステップに基づく明確なコスト構造

プラットフォームは、データとインフラストラクチャの制御を維持しながら研究開発サイクルを加速させたいMLチームに優れた価値を提供します。

"Weco AI" のベストな代替ツール

Xanderは、オープンソースのデスクトッププラットフォームで、ノーコードAIモデルトレーニングを可能にします。自然言語でタスクを記述するだけで、テキスト分類、画像分析、LLMファインチューニングの自動化パイプラインを実行し、ローカルマシンでプライバシーとパフォーマンスを確保します。

DeepSeek V3を無料でオンラインでお試しください。登録不要。この強力なオープンソースAIモデルは671Bパラメータを備え、商用利用をサポートし、ブラウザデモまたはGitHubでのローカルインストールで無制限アクセスを提供します。

Float16.Cloudは、高速AI開発のためのサーバーレスGPUを提供します。設定なしでAIモデルを即座に実行、トレーニング、スケーリングできます。H100 GPU、秒単位の課金、Python実行を特徴としています。

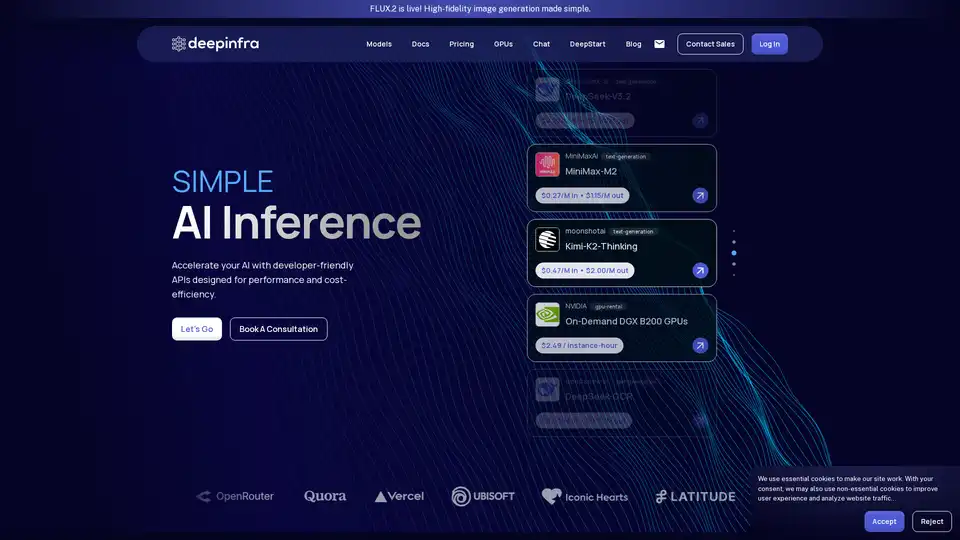

Deep Infra は、低コストでスケーラブルな AI 推論プラットフォームで、DeepSeek-V3.2、Qwen、OCR ツールなどの 100 以上の ML モデルをサポート。開発者向け API、GPU レンタル、データゼロ保持。