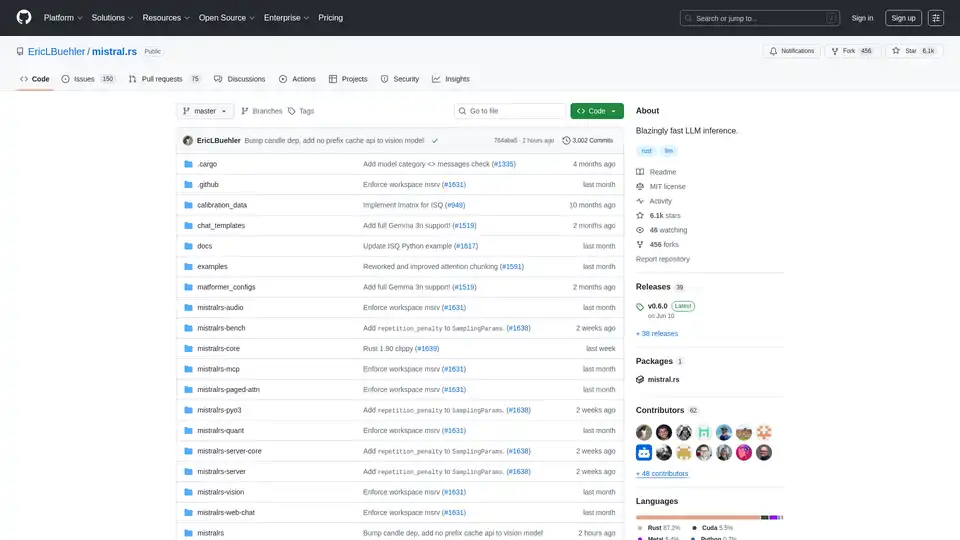

mistral.rs の概要

mistral.rs とは何ですか?

Mistral.rs は、Rust で記述されたクロスプラットフォームで非常に高速な大規模言語モデル (LLM) 推論エンジンです。さまざまなプラットフォームやハードウェア構成で、高いパフォーマンスと柔軟性を提供するように設計されています。マルチモーダルワークフローをサポートし、テキスト、ビジョン、画像生成、音声処理に対応します。

主な機能と利点

- マルチモーダルワークフロー: テキスト↔テキスト、テキスト+ビジョン↔テキスト、テキスト+ビジョン+音声↔テキスト、テキスト→音声、テキスト→画像 をサポート。

- API: Rust、Python、OpenAI HTTP サーバー API (Chat Completions、Responses API 付き) を提供し、さまざまな環境への簡単な統合を実現。

- MCP クライアント: ファイルシステム、ウェブ検索、データベース、その他の API などの外部ツールやサービスに自動的に接続。

- パフォーマンス: ISQ (In-place quantization)、PagedAttention、FlashAttention などのテクノロジーを利用して、パフォーマンスを最適化。

- 使いやすさ: 自動デバイスマッピング (マルチ GPU、CPU)、チャットテンプレート、トークナイザーの自動検出などの機能を搭載。

- 柔軟性: 重みマージングによる LoRA および X-LoRA アダプター、任意のベースモデル上に MoE モデルを作成するための AnyMoE、カスタマイズ可能な量子化をサポート。

mistral.rs の仕組み

Mistral.rs は、いくつかの主要な技術を活用して高いパフォーマンスを実現しています。

- In-place Quantization (ISQ): モデルの重みを量子化することで、メモリフットプリントを削減し、推論速度を向上。

- PagedAttention & FlashAttention: 注意メカニズムにおけるメモリ使用量と計算効率を最適化。

- 自動デバイスマッピング: 複数の GPU や CPU を含む、利用可能なハードウェアリソース全体にモデルを自動的に分散。

- MCP (Model Context Protocol): ツール呼び出しのための標準化されたプロトコルを提供することで、外部ツールやサービスとのシームレスな統合を実現。

mistral.rs の使用方法

インストール: 公式ドキュメントに記載されているインストール手順に従ってください。通常、Rust のインストールと mistral.rs リポジトリのクローン作成が含まれます。

モデルの取得: 必要な LLM モデルを取得します。Mistral.rs は、Hugging Face モデル、GGUF、GGML など、さまざまなモデル形式をサポートしています。

API の使用: Rust、Python、または OpenAI 互換の HTTP サーバー API を利用して、推論エンジンと対話します。各 API の例とドキュメントが用意されています。

- Python API:

pip install mistralrs - Rust API:

mistralrs = { git = "https://github.com/EricLBuehler/mistral.rs.git" }をCargo.tomlに追加します。

- Python API:

サーバーの実行: 適切な構成オプションを指定して、mistralrs-server を起動します。モデルパス、量子化メソッド、その他のパラメーターの指定が含まれる場合があります。

./mistralrs-server --port 1234 run -m microsoft/Phi-3.5-MoE-instruct

ユースケース

Mistral.rs は、以下を含む幅広いアプリケーションに適しています。

- チャットボットと会話型 AI: 高性能な推論により、インタラクティブで魅力的なチャットボットを実現。

- テキスト生成: コンテンツの作成や要約など、さまざまな目的でリアルで一貫性のあるテキストを生成。

- 画像およびビデオ分析: 統合されたビジョン機能により、視覚データを処理および分析。

- 音声認識と合成: 音声処理のサポートにより、音声ベースのインタラクションを実現。

- ツール呼び出しと自動化: 自動化されたワークフローのために、外部ツールおよびサービスと統合。

mistral.rs は誰のためのものですか?

Mistral.rs は、以下を対象として設計されています。

- 開発者: アプリケーションに高速で柔軟な LLM 推論エンジンを必要とする方。

- 研究者: 自然言語処理における新しいモデルと技術を探索している方。

- 組織: 製品やサービスに高性能な AI 機能を必要とする組織。

mistral.rs を選ぶ理由

- パフォーマンス: ISQ、PagedAttention、FlashAttention などの技術により、非常に高速な推論速度を実現。

- 柔軟性: 幅広いモデル、量子化メソッド、およびハードウェア構成をサポート。

- 使いやすさ: 簡単な API と自動構成オプションを提供し、簡単に統合可能。

- 拡張性: MCP プロトコルを介した外部ツールおよびサービスとの統合が可能。

サポートされているアクセラレーター

Mistral.rs は、さまざまなアクセラレーターをサポートしています。

- NVIDIA GPU (CUDA):

cuda、flash-attn、およびcudnnのフィーチャーフラグを使用。 - Apple Silicon GPU (Metal):

metalのフィーチャーフラグを使用。 - CPU (Intel):

mklのフィーチャーフラグを使用。 - CPU (Apple Accelerate):

accelerateのフィーチャーフラグを使用。 - 汎用 CPU (ARM/AVX): デフォルトで有効。

機能を有効にするには、Cargo に渡します。

cargo build --release --features "cuda flash-attn cudnn"

コミュニティとサポート

結論

Mistral.rs は、非常に高速なパフォーマンス、広範な柔軟性、シームレスな統合機能を提供する、強力で汎用性の高い LLM 推論エンジンとして際立っています。そのクロスプラットフォームな性質とマルチモーダルワークフローのサポートにより、さまざまなアプリケーションで大規模言語モデルの力を活用しようとしている開発者、研究者、組織にとって優れた選択肢となっています。高度な機能と API を活用することで、ユーザーは革新的でインパクトのある AI ソリューションを簡単に作成できます。

AI インフラストラクチャを最適化し、LLM の可能性を最大限に引き出したいと考えている人にとって、mistral.rs は、研究環境と本番環境の両方に適した堅牢で効率的なソリューションを提供します。

"mistral.rs" のベストな代替ツール

Spice.ai は、エンタープライズデータに基づいた SQL クエリフェデレーション、アクセラレーション、検索、および取得を使用して AI アプリを構築するためのオープンソースのデータおよび AI 推論エンジンです。

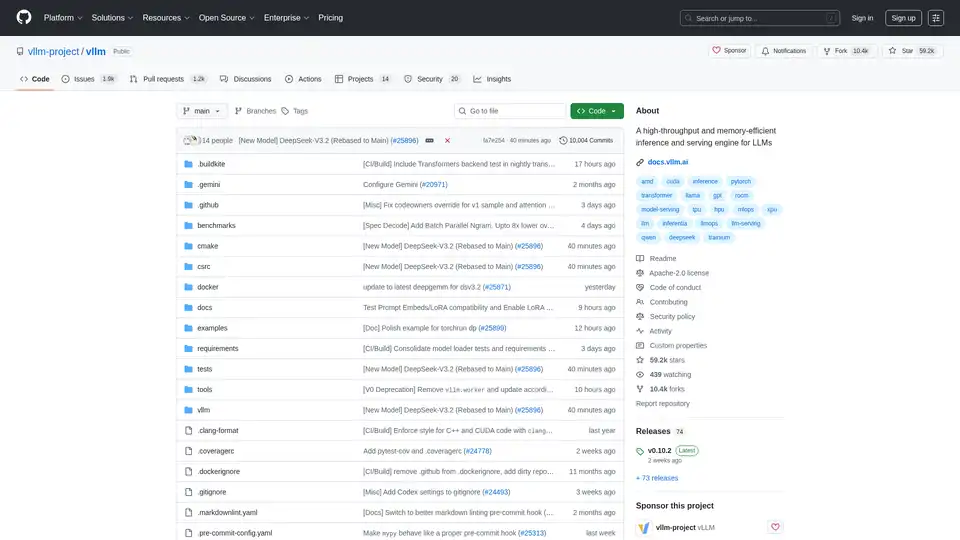

vLLMは、LLM のための高スループットかつメモリ効率の良い推論およびサービングエンジンであり、最適化されたパフォーマンスのためにPagedAttentionと継続的なバッチ処理を備えています。

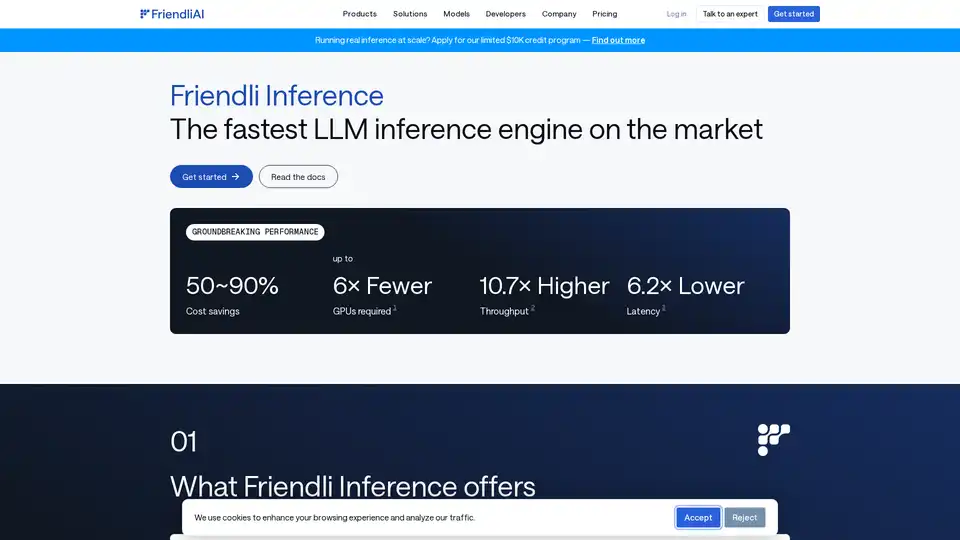

Friendli Inference は、最速の LLM 推論エンジンであり、速度とコスト効率が最適化されており、高スループットと低レイテンシーを実現しながら、GPU コストを 50 ~ 90% 削減します。

開発者向けの超高速AIプラットフォーム。シンプルなAPIで200以上の最適化されたLLMとマルチモーダルモデルをデプロイ、ファインチューニング、実行 - SiliconFlow。