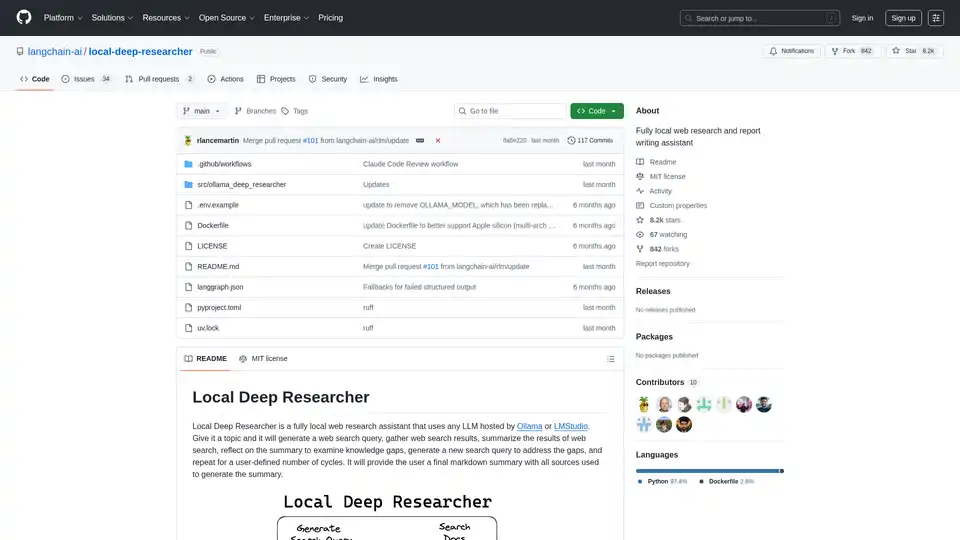

Local Deep Researcher の概要

Local Deep Researcher とは?

Local Deep Researcher は、ユーザーのマシン上で完全にローカルに動作する革新的なオープンソースのウェブ研究アシスタントです。この強力なツールは、Ollama または LMStudio を通じて大規模言語モデル (LLM) を活用し、包括的なウェブ研究を行い、適切なソース引用付きの詳細なレポートを生成します。

Local Deep Researcher の仕組み

システムは、インテリジェントな反復研究プロセスに従います:

研究サイクルプロセス:

- クエリ生成:ユーザー提供のトピックに基づき、ローカル LLM が最適化されたウェブ検索クエリを生成

- ソース取得:構成された検索ツール (DuckDuckGo、SearXNG、Tavily、または Perplexity) を使用して関連するオンラインソースを取得

- コンテンツ要約:LLM がウェブ検索結果の調査結果を分析し要約

- ギャップ分析:システムが要約を振り返り、知識のギャップと欠落情報を特定

- 反復的な洗練:特定されたギャップを解決するための新しい検索クエリを生成し、プロセスを繰り返す

- 最終レポート生成:複数回のサイクル(ユーザーにより設定可能)後に、すべてのソースが適切に引用された包括的な Markdown レポートを作成

コア機能と能力

- 完全にローカル動作:すべての処理がローカルで発生し、データプライバシーとセキュリティを確保

- 複数 LLM 対応:Ollama または LMStudio でホストされた任意の LLM と互換

- 柔軟な検索統合:DuckDuckGo(デフォルト)、SearXNG、Tavily、Perplexity 検索 API をサポート

- 設定可能な研究深度:ユーザーが研究サイクル数(デフォルト:3 イテレーション)を設定可能

- 構造化出力:適切なソース引用付きのよくフォーマットされた Markdown レポートを生成

- 視覚的なワークフロー監視:LangGraph Studio と統合し、リアルタイムプロセス視覚化

技術要件とセットアップ

サポートプラットフォーム:

- macOS(推奨)

- Windows

- Docker 経由の Linux

必要なコンポーネント:

- Python 3.11+

- ローカル LLM ホスティングのための Ollama または LMStudio

- プレミアム検索サービスのオプション API キー

インストールと構成

クイックセットアッププロセス:

- GitHub からリポジトリをクローン

- .env ファイルで環境変数を構成

- 好みの LLM プロバイダーを選択(Ollama または LMStudio)

- 検索 API 構成を選択

- LangGraph Studio を通じて起動

Docker デプロイ: プロジェクトにはコンテナ化デプロイのための Docker サポートが含まれていますが、Ollama は適切なネットワーク構成で別途実行する必要があります。

モデル互換性の考慮事項

システムは構造化 JSON 出力を生成できる LLM を必要とします。一部のモデル、例えば DeepSeek R1 (7B および 1.5B) は JSON モードに制限がある場合がありますが、アシスタントにはこれらのケースを処理するためのフォールバックメカニズムが含まれています。

誰が Local Deep Researcher を使用すべきか?

理想的なユーザーには:

- 研究者と学者 が包括的な文献レビューを必要とする場合

- コンテンツクリエイター が十分に研究された背景情報を必要とする場合

- 学生 が研究論文や課題に取り組む場合

- ジャーナリスト が調査研究を行う場合

- ビジネスプロフェッショナル が市場研究と競争分析を必要とする場合

- プライバシーを重視するユーザー がクラウドベースのソリューションよりローカル処理を好む場合

実用的アプリケーションとユースケース

- 学術研究:文献レビューを実施し、論文のためのソースを集める

- 市場分析:競合他社と業界トレンドを研究

- コンテンツ研究:ブログ投稿、記事、レポートのための情報を集める

- デューデリジェンス:適切なソースドキュメントでトピックを徹底的に調査

- 学習と教育:自動化された研究支援でトピックを深く探求

なぜ Local Deep Researcher を選ぶか?

主な利点:

- 完全なプライバシー:研究トピックとデータはローカルマシンを離れない

- コスト効果:基本検索機能に API 費用なし

- カスタマイズ可能:特定のニーズに合わせて研究深度とソースを調整

- 透明性:研究プロセスと使用ソースへの完全な可視性

- オープンソース:コミュニティ主導の開発と継続的な改善

最適な結果を得るために

最適なパフォーマンスのために:

- 可能であれば、より大きく能力の高い LLM モデルを使用

- 特定のニーズに適した検索 API を構成

- トピックの複雑さに基づいて研究サイクル数を調整

- 重要な研究では重要なソースを手動でレビューし検証

Local Deep Researcher は、ローカル AI 駆動研究ツールの重要な進歩を表し、大規模言語モデルの力を実用的なウェブ研究能力と組み合わせ、完全なデータプライバシーと制御を維持します。

"Local Deep Researcher" のベストな代替ツール

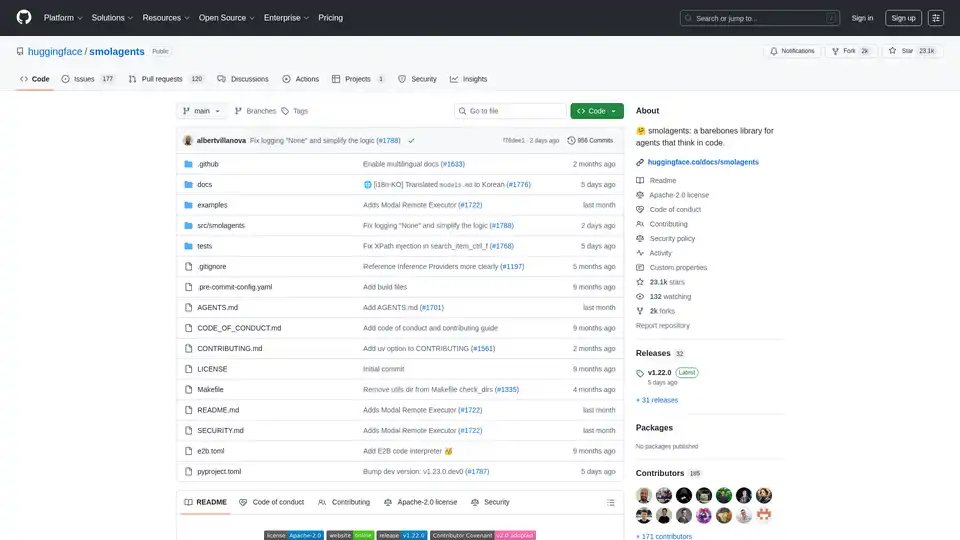

smolagents は、コードを通じて推論し行動する AI エージェントを作成するためのミニマリスト Python ライブラリです。LLM 無関係のモデル、安全なサンドボックス、Hugging Face Hub とのシームレスな統合をサポートし、高効率のコードベースのエージェントワークフローを実現します。

EnConvo は、macOS 用の AI エージェントランチャーであり、即時アクセスとワークフローの自動化により生産性に革命をもたらします。 150 以上の組み込みツール、MCP サポート、AI エージェントモードを備えています。

BrainSoupでワークフローを変革!自然言語でカスタムAIエージェントを作成し、タスクを処理し、プロセスを自動化します。データでAIを強化し、プライバシーとセキュリティを優先します。

MyReportは、レポートやエッセイのデータ収集、執筆、引用を自動化し、時間を節約し、完全で十分に文書化されたドキュメントを迅速に生成します。