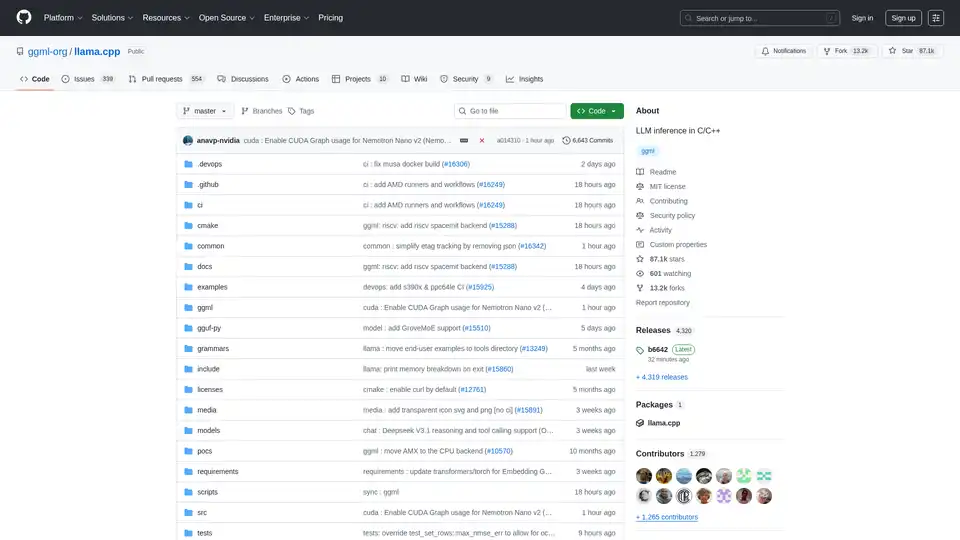

llama.cpp の概要

llama.cpp: C/C++ での LLM 推論のための頼りになるライブラリ

lama.cpp は、C/C++ を使用して効率的な大規模言語モデル (LLM) 推論を可能にするように設計された、強力なオープンソースライブラリです。ローカルマシンからクラウド展開まで、幅広いハードウェア向けに最適化されており、最小限のセットアップと最先端のパフォーマンスで際立っています。

llama.cpp とは?

lama.cpp は、C/C++ で LLM 推論を実行することに重点を置いたプロジェクトです。最小限の依存関係で、多様なハードウェア構成にわたって優れたパフォーマンスを提供するように設計されています。

主な機能と利点

- プレーンな C/C++ 実装: 外部依存関係を排除し、展開を簡素化します。

- Apple Silicon の最適化: Apple デバイスで最高のパフォーマンスを実現するために、ARM NEON、Accelerate、および Metal フレームワークを活用します。

- x86 アーキテクチャのサポート: x86 CPU で最適化されたパフォーマンスを実現するために、AVX、AVX2、AVX512、および AMX のサポートが含まれています。

- 量子化: メモリ使用量を削減し、推論を加速する 1.5 ビットから 8 ビットの整数量子化をサポートします。

- GPU アクセラレーション: カスタム CUDA カーネルは、NVIDIA GPU 上で効率的な LLM 実行を提供します。また、HIP 経由で AMD GPU、MUSA 経由で Moore Threads GPU もサポートします。

- ハイブリッド CPU+GPU 推論: CPU と GPU の間でワークロードを分散することにより、利用可能な VRAM よりも大きなモデルの使用を容易にします。

- 複数のバックエンド: Metal、BLAS、BLIS、SYCL、MUSA、CUDA、HIP、Vulkan、CANN、OpenCL、IBM zDNN、および WebGPU (開発中) をサポートします。

llama.cpp はどのように動作しますか?

lama.cpp は、LLM 推論を C/C++ で直接実装することによって動作します。このアプローチにより、オーバーヘッドが削減され、ハードウェアリソースをきめ細かく制御できます。このライブラリはモジュール式になるように設計されており、さまざまなハードウェアプラットフォーム向けに最適化されたさまざまなバックエンドがあります。量子化などの手法を使用してモデルのメモリフットプリントを削減し、リソースが制約されたデバイスで大規模なモデルを実行できるようにします。

llama.cpp の使用方法

インストール:

- パッケージマネージャーの使用: brew、nix、または winget 経由でインストールします。

- Docker: 提供されている Docker イメージを使用します。

- ビルド済みのバイナリ: リリースページからバイナリをダウンロードします。

- ソースからビルド: リポジトリをクローンし、ビルドガイドに従います。

モデルの取得:

- Hugging Face またはその他のモデルホスティングサイトから GGUF モデルをダウンロードします。

- 提供されている Python スクリプトを使用して、モデルを GGUF 形式に変換します。

推論の実行:

- 実験には

llama-cliツールを使用します。 - OpenAI API の互換性のために、

llama-serverを使用してローカル HTTP サーバーを展開します。

- 実験には

コマンド例:

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

llama.cpp は誰のためのものですか?

lama.cpp は以下に最適です。

- 開発者: C/C++ を使用して LLM を搭載したアプリケーションを実装します。

- 研究者: さまざまなハードウェアプラットフォームで LLM を試します。

- 愛好家: 個人的なコンピューターやデバイスで LLM を実行します。

- 組織: 最小限のオーバーヘッドで本番環境に LLM を展開します。

llama.cpp の実践的なアプリケーション

lama.cpp は、次のようなさまざまなシナリオで使用できます。

- ローカル LLM 推論: クラウドサービスに依存せずに、個人のコンピューターでモデルを実行します。

- エッジコンピューティング: 低遅延アプリケーションのために、エッジデバイスに LLM を展開します。

- モバイルアプリケーション: デバイス上での処理のために、LLM をモバイルアプリに統合します。

- カスタム AI ソリューション: 特定のハードウェアおよびソフトウェア環境に合わせて調整されたカスタム AI ソリューションを構築します。

llama.cpp を選択する理由

lama.cpp は、パフォーマンス、柔軟性、使いやすさの独自の組み合わせを提供し、LLM 推論に最適な選択肢となっています。主な利点は次のとおりです。

- 最適化されたパフォーマンス: 幅広いハードウェアで最高のパフォーマンスを実現するように設計されています。

- 最小限の依存関係: 展開を簡素化し、競合のリスクを軽減します。

- 量子化のサポート: リソースが制約されたデバイスで大規模なモデルを使用できます。

- 活発なコミュニティ: 継続的な開発とコミュニティサポートの恩恵を受けます。

- 多用途のツール: さまざまなユースケースに対応する

llama-cli、llama-server、llama-perplexity、llama-benchなどのツールが含まれています。

サポートされているバックエンド

lama.cpp は、幅広いデバイスを対象とした複数のバックエンドをサポートしています。

| バックエンド | ターゲットデバイス |

|---|---|

| Metal | Apple Silicon |

| BLAS | すべて |

| BLIS | すべて |

| SYCL | Intel および Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | すべて (開発中) |

| RPC | すべて |

llama.cpp への貢献方法

lama.cpp への貢献は大歓迎です。次の方法で貢献できます。

- バグ修正または新機能を含むプルリクエストを開きます。

- 既存の課題やプロジェクトで共同作業を行います。

- 課題、PR、およびプロジェクトの管理を支援します。

- ドキュメントとサンプルを改善します。

GGUF とは?

GGUF は、モデルを保存するために llama.cpp が必要とするファイル形式です。リポジトリ内の convert_*.py Python スクリプトを使用して、他のデータ形式のモデルを GGUF に変換できます。

結論

lama.cpp は、多用途で強力なライブラリであり、幅広いユーザーが LLM 推論にアクセスできるようにします。開発者、研究者、または愛好家であるかどうかにかかわらず、llama.cpp は、選択したハードウェアで LLM の力を活用するために必要なツールと柔軟性を提供します。パフォーマンス、使いやすさ、およびコミュニティサポートに重点を置いている llama.cpp は、急速に進化する AI 推論の状況において、重要なプレーヤーであり続けるでしょう。

詳細については、llama.cpp GitHub リポジトリ を参照してください。

"llama.cpp" のベストな代替ツール

Lampi AIは、金融専門家向けのAIエージェントを提供し、複雑な金融ワークフローを構造化された高品質の分析に数分で変換します。M&A、投資銀行、プライベートエクイティ、および法律部門に最適です。

Awan LLM は、無制限、無制限、費用対効果の高い LLM 推論 API プラットフォームを提供します。ユーザーと開発者は、トークンの制限なしに強力な LLM モデルにアクセスでき、AI エージェント、ロールプレイ、データ処理、コード補完に最適です。

Awan LLMは、無制限のトークンを備えた、無制限で費用対効果の高いLLM推論APIプラットフォームを提供し、開発者やパワーユーザーに最適です。 トークン制限なしで、データの処理、コードの完成、AIエージェントの構築が可能です。