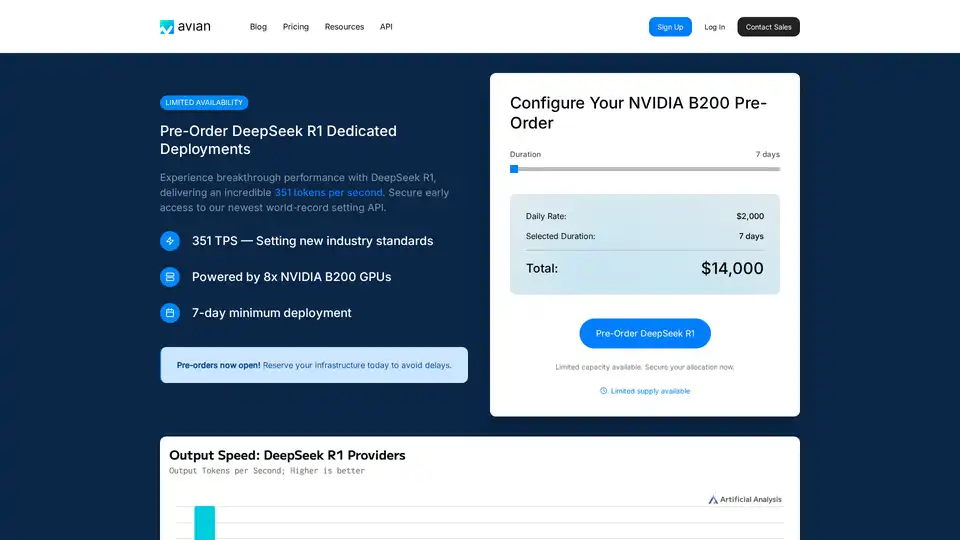

Avian API の概要

Avian API: オープンソース LLM 向けの最速 AI 推論

Avian API は、Llama のようなオープンソースの Large Language Models (LLM) 向けに最速の AI 推論を提供するプラットフォームです。Hugging Face からの LLM を、業界平均より 3〜10 倍速くデプロイおよび実行できます。Avian を使用すると、レート制限なしで本番環境グレードの AI 推論を体験したり、サーバーレスアーキテクチャを活用したり、Hugging Face から任意の LLM をデプロイしたりできます。

Avian API とは?

Avian API は、高速性、プライバシー、使いやすさに重点を置いて、高性能な AI 推論を提供するように設計されています。特に DeepSeek R1 のようなモデルでは、毎秒 351 トークン (TPS) を達成し、業界をリードする推論速度を提供することで際立っています。このパフォーマンスは、最適化された NVIDIA B200 アーキテクチャによって実現され、AI 推論の分野で新たな標準を確立しています。

Avian API の仕組み

Avian API は、最適化されたインフラストラクチャと独自の技術を活用して、推論プロセスを加速します。主な機能は次のとおりです。

- 高速推論: DeepSeek R1 のようなモデルで最大 351 TPS を達成。

- Hugging Face 統合: 最小限の構成で任意の Hugging Face モデルのデプロイが可能。

- 自動最適化とスケーリング: モデルを自動的に最適化およびスケーリングして、一貫したパフォーマンスを確保。

- OpenAI 互換の API エンドポイント: OpenAI と互換性のある使いやすい API エンドポイントを提供し、既存のワークフローへの統合を簡素化。

- エンタープライズグレードのパフォーマンスとプライバシー: 安全な SOC/2 承認済みの Microsoft Azure インフラストラクチャ上に構築され、データストレージは不要。

主な機能と利点

- 最速の推論速度: Avian API は比類のない推論速度を提供し、リアルタイム応答を必要とするアプリケーションに最適。

- 簡単な統合: OpenAI 互換の API により、Avian は最小限のコード変更で既存のプロジェクトに簡単に統合可能。

- 費用対効果: リソースの使用率を最適化することで、Avian は AI 推論に関連するコストを削減するのに役立ちます。

- プライバシーとセキュリティ: Avian は、SOC/2 準拠とプライベートホスティングオプションにより、データプライバシーとセキュリティを確保。

Avian API の使用方法

Avian API の使用には、いくつかの簡単な手順が含まれます。

- サインアップ: Avian.io プラットフォームでアカウントを作成します。

- API キーの取得: ダッシュボードから一意の API キーを取得します。

- モデルの選択: Hugging Face からお好みのオープンソースモデルを選択するか、DeepSeek R1 を使用して最適なパフォーマンスを実現します。

- API の統合: 提供されたコードスニペットを使用して、Avian API をアプリケーションに統合します。

Avian API を使用するためのコードスニペットの例を次に示します。

from openai import OpenAI

import os

client = OpenAI(

base_url="https://api.avian.io/v1",

api_key=os.environ.get("AVIAN_API_KEY")

)

response = client.chat.completions.create(

model="DeepSeek-R1",

messages=[

{

"role": "user",

"content": "What is machine learning?"

}

],

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="")

このコードスニペットは、Avian API を使用して DeepSeek-R1 モデルから応答を生成する方法を示しています。base_url を変更し、API キーを使用して開始するだけです。

Avian API を選ぶ理由

Avian API は、速度、セキュリティ、使いやすさに重点を置いているため、際立っています。他の推論ソリューションと比較して、Avian は次のものを提供します。

- 優れたパフォーマンス: DeepSeek R1 で 351 TPS を達成し、Together、Fireworks、Amazon などの競合他社よりも大幅に高速。

- 簡素化されたデプロイ: 任意の Hugging Face モデルの 1 行のコード統合。

- エンタープライズグレードのセキュリティ: SOC/2 準拠およびチャットのプライバシーモード。

Avian API は誰のためのものですか?

Avian API は以下に最適です。

- エンタープライズ: 高性能、安全、スケーラブルな AI 推論を必要とする企業。

- 開発者: AI をアプリケーションに統合するための使いやすい API を探している開発者。

- 研究者: AI モデルの研究に高速で信頼性の高い推論を必要とする研究者。

結論

Avian API は、オープンソース LLM 向けの最速の AI 推論を提供し、プロジェクトで AI の力を活用したい人にとって不可欠なツールとなっています。高速なパフォーマンス、簡単な統合、エンタープライズグレードのセキュリティにより、Avian API は AI 推論の分野で新たな標準を打ち立てています。Hugging Face からモデルをデプロイする場合でも、最適化された NVIDIA B200 アーキテクチャを活用する場合でも、Avian API は比類のない速度と効率を提供します。

"Avian API" のベストな代替ツール

Release.aiは、100ミリ秒未満のレイテンシ、エンタープライズグレードのセキュリティ、シームレスなスケーラビリティにより、AIモデルのデプロイを簡素化します。数分で本番環境に対応できるAIモデルをデプロイし、リアルタイム監視でパフォーマンスを最適化します。

Nexa SDK は、LLM、マルチモーダル、ASR および TTS モデルの高速かつプライベートなデバイス上 AI 推論を可能にします。NPU、GPU、CPU を介して、モバイル、PC、自動車、IoT デバイスに本番環境対応のパフォーマンスでデプロイ。

DeepSeek-v3は、MoEアーキテクチャに基づくAIモデルであり、広範なトレーニングと多言語サポートにより、安定した高速なAIソリューションを提供します。

Unsloth AI は、gpt-oss や Llama などの LLM にオープンソースの微調整と強化学習を提供し、トレーニングを 30 倍高速化し、メモリ使用量を削減することで、AI トレーニングをアクセスしやすく効率的にします。