Text Generation Web UI

Vue d'ensemble de Text Generation Web UI

Interface Web de Génération de Texte : L'Interface Web Ultime pour l'IA Locale

Qu'est-ce que l'Interface Web de Génération de Texte ?

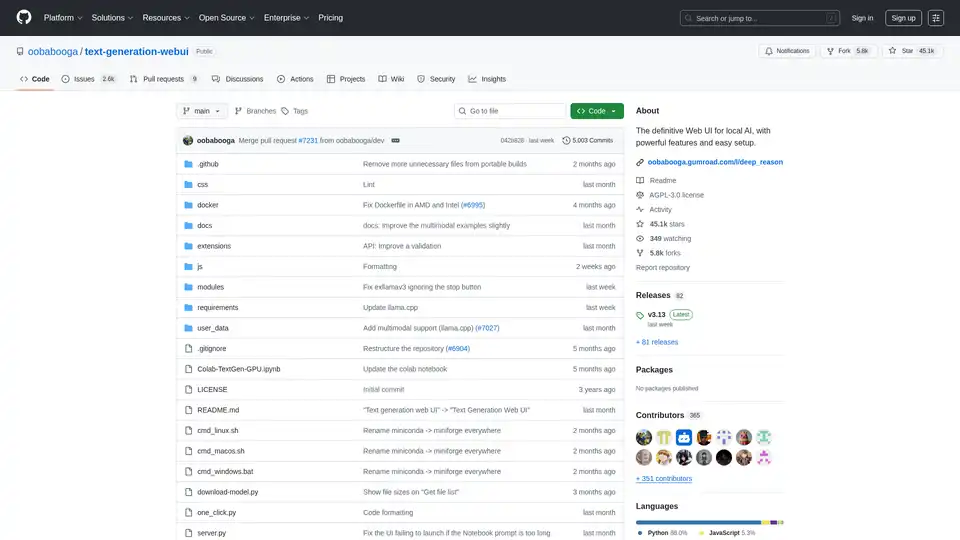

L'Interface Web de Génération de Texte, également connue sous le nom de oobabooga/text-generation-webui, est une interface web Gradio conviviale et riche en fonctionnalités, conçue pour interagir avec les Grands Modèles de Langue (LLM) localement. Elle fournit un ensemble complet d'outils et de fonctionnalités pour exploiter la puissance de la génération de texte par IA sur votre propre machine, garantissant la confidentialité et le contrôle.

Comment fonctionne l'Interface Web de Génération de Texte ?

Cette interface web sert de pont entre vous et divers backends de génération de texte locaux. Elle prend en charge plusieurs backends tels que llama.cpp, Transformers, ExLlamaV3, ExLlamaV2 et TensorRT-LLM. L'interface utilisateur vous permet de :

- Sélectionner votre backend préféré: Choisissez le backend qui convient le mieux à votre matériel et aux exigences de votre modèle.

- Charger et gérer des modèles: Chargez facilement différents LLM et basculez entre eux sans redémarrer l'application.

- Configurer les paramètres de génération: Affinez le processus de génération de texte avec divers paramètres d'échantillonnage et options de génération.

- Interagir avec le modèle: Utilisez l'interface de chat intuitive ou l'onglet de bloc-notes à format libre pour interagir avec le modèle.

Pourquoi choisir l'Interface Web de Génération de Texte ?

- Confidentialité: Tout le traitement est effectué localement, garantissant que vos données restent privées.

- Fonctionnalité hors ligne: Aucune connexion Internet n'est requise, vous permettant d'utiliser l'outil à tout moment, n'importe où.

- Polyvalence: Prend en charge plusieurs backends et types de modèles, offrant flexibilité et personnalisation.

- Extensibilité: Offre une prise en charge des extensions pour l'ajout de nouvelles fonctionnalités.

- Facilité d'utilisation: Interface conviviale avec des thèmes sombres et clairs, la coloration syntaxique et le rendu LaTeX.

Principales Caractéristiques :

- Prise en Charge de Plusieurs Backends: S'intègre parfaitement avec

llama.cpp,Transformers,ExLlamaV3,ExLlamaV2etTensorRT-LLM. - Configuration Facile: Offre des versions portables pour Windows/Linux/macOS, ne nécessitant aucune configuration, et un programme d'installation en un clic pour un environnement autonome.

- Hors Ligne et Privé: Fonctionne à 100 % hors ligne, sans télémétrie, ressources externes ou demandes de mise à jour à distance.

- Pièces Jointes: Permet de télécharger des fichiers texte, des documents PDF et des fichiers .docx pour discuter de leur contenu avec l'IA.

- Vision (Modèles Multimodaux): Prend en charge la fixation d'images aux messages pour la compréhension visuelle (tutoriel).

- Recherche Web: Peut éventuellement effectuer des recherches sur Internet avec des requêtes générées par LLM pour ajouter du contexte aux conversations.

- Interface Utilisateur Esthétique: Présente une interface utilisateur propre et attrayante avec des thèmes sombres et clairs.

- Coloration Syntaxique et Rendu LaTeX: Fournit une coloration syntaxique pour les blocs de code et un rendu LaTeX pour les expressions mathématiques.

- Modes Instruction et Chat: Comprend un mode d'instruction pour le suivi des instructions et des modes de chat pour interagir avec des personnages personnalisés.

- Formatage Automatique des Prompts: Utilise des modèles Jinja2 pour le formatage automatique des prompts.

- Édition des Messages et Ramification des Conversations: Permet de modifier les messages, de naviguer entre les versions et de ramifier les conversations.

- Paramètres d'Échantillonnage Multiples: Offre un contrôle sophistiqué sur la génération de texte avec divers paramètres d'échantillonnage et options de génération.

- Changement de Modèle: Permet de basculer entre différents modèles dans l'interface utilisateur sans redémarrer.

- Couches GPU Automatiques: Configure automatiquement les couches GPU pour les modèles GGUF sur les GPU NVIDIA.

- Génération de Texte Libre: Fournit un onglet Bloc-notes pour la génération de texte libre sans limitations de tours de chat.

- API Compatible OpenAI: Inclut une API compatible OpenAI avec des points de terminaison Chat et Complétions, y compris la prise en charge de l'appel d'outils.

- Prise en Charge des Extensions: Prend en charge de nombreuses extensions intégrées et contribuées par les utilisateurs.

Comment Installer l'Interface Web de Génération de Texte :

- **Versions Portables (Recommandé pour un Démarrage Rapide) 😗* * Téléchargez la version portable depuis la page des versions.

- Dézippez le fichier téléchargé.

- Exécutez l'exécutable.

- **Installation Portable Manuelle avec venv 😗* ```bash git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv

On Windows:

venv\Scripts\activate

On macOS/Linux:

source venv/bin/activate

pip install -r requirements/portable/requirements.txt --upgrade

python server.py --portable --api --auto-launch

deactivate

```

3. **Programme d'Installation en un Clic (Pour les utilisateurs avancés) 😗* * Clonez le dépôt ou téléchargez le code source.

* Exécutez le script de démarrage pour votre système d'exploitation (start_windows.bat, start_linux.sh ou start_macos.sh).

* Sélectionnez votre fournisseur de GPU lorsque vous y êtes invité.

* Après l'installation, ouvrez http://127.0.0.1:7860 dans votre navigateur.

Téléchargement de Modèles :

Les modèles doivent être placés dans le dossier text-generation-webui/user_data/models. Les modèles GGUF doivent être placés directement dans ce dossier, tandis que les autres types de modèles doivent être placés dans un sous-dossier.

Exemple :

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

Vous pouvez également utiliser l'interface utilisateur pour télécharger automatiquement des modèles depuis Hugging Face ou utiliser l'outil en ligne de commande :

python download-model.py organization/model

Exécutez python download-model.py --help pour voir toutes les options.

À Qui s'Adresse l'Interface Web de Génération de Texte ?

L'Interface Web de Génération de Texte est idéale pour :

- Les chercheurs et développeurs travaillant avec des LLM.

- Les passionnés d'IA qui souhaitent expérimenter la génération de texte.

- Les utilisateurs qui privilégient la confidentialité et souhaitent exécuter des LLM localement.

Ressources Utiles :

L'Interface Web de Génération de Texte fournit une plateforme puissante et polyvalente pour explorer les capacités de la génération de texte par IA locale. Sa facilité d'utilisation, ses nombreuses fonctionnalités et son engagement en faveur de la confidentialité en font un excellent choix pour toute personne intéressée à travailler avec les Grands Modèles de Langue à ses propres conditions.

Assistant de Programmation par IA Complétion Automatique de Code Révision et Optimisation du Code par IA Développement Low-Code et No-Code par IA

Meilleurs outils alternatifs à "Text Generation Web UI"

L'Écrivain de Blog AI de Bloggr.AI vous aide à générer rapidement des articles de blog optimisés SEO et sans plagiat—gratuit avec voix de marque, plans et intégration de liens.

Transformez votre flux de travail avec BrainSoup ! Créez des agents IA personnalisés pour gérer les tâches et automatiser les processus via un langage naturel. Améliorez l'IA avec vos données tout en priorisant la confidentialité et la sécurité.

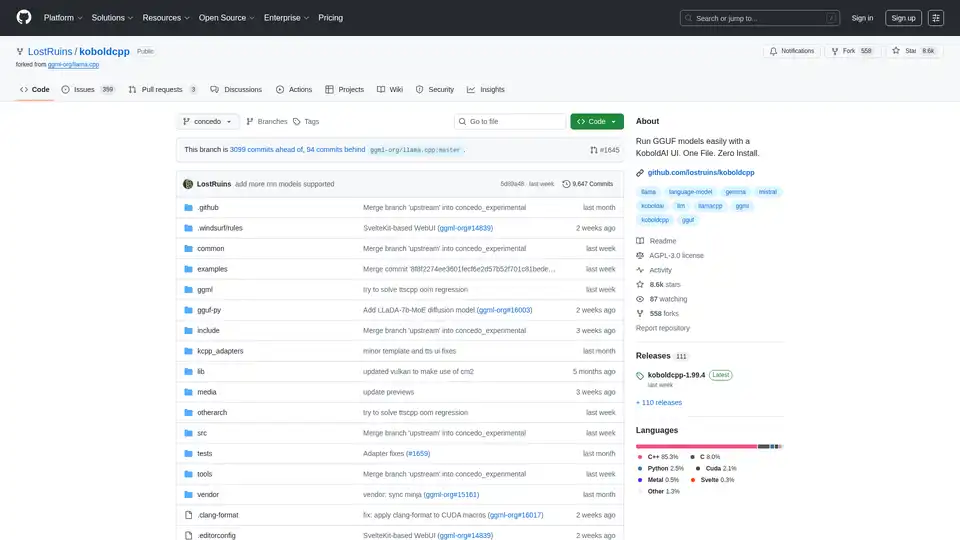

KoboldCpp : Exécutez facilement des modèles GGUF pour la génération de texte et d'images IA avec une interface utilisateur KoboldAI. Fichier unique, installation zéro. Prend en charge CPU/GPU, STT, TTS et Stable Diffusion.