FILM Frame Interpolation

Vue d'ensemble de FILM Frame Interpolation

Qu'est-ce que l'Interpolation de Trames FILM ?

FILM, acronyme de Frame Interpolation for Large Motion, est un réseau neuronal de pointe développé par Google Research pour générer des trames intermédiaires fluides dans les vidéos, en particulier celles impliquant des mouvements importants de scène. Contrairement aux méthodes traditionnelles qui s'appuient sur des réseaux pré-entraînés pour l'estimation de flux optique ou de profondeur, FILM adopte une approche unifiée à réseau unique. Cela la rend efficace et puissante pour créer des interpolations de haute qualité directement à partir de triplets de trames lors de l'entraînement. Lancée en tant qu'implémentation open-source TensorFlow 2, elle est accessible aux développeurs et chercheurs souhaitant améliorer la fluidité des vidéos sans configurations complexes.

Le modèle se distingue par sa capacité à gérer les grands mouvements de scène—pensez à des objets en mouvement rapide ou des panoramas dynamiques de caméra—où les techniques d'interpolation conventionnelles échouent souvent, produisant des artefacts ou du flou. En partageant les poids de convolution à travers des extracteurs de caractéristiques multi-échelles, FILM atteint des scores de référence de pointe tout en gardant l'architecture légère et entraînable à partir d'entrées basiques.

Comment fonctionne FILM ?

Au cœur de FILM, le traitement de deux trames d'entrée (frame1 et frame2) permet de prédire des trames intermédiaires aux timestamps spécifiés. Le processus commence par une étape d'extraction de caractéristiques multi-échelles, où des couches convolutives analysent les entrées à différentes résolutions pour capturer à la fois des détails fins et des motifs de mouvement plus larges. Ces caractéristiques sont ensuite fusionnées et affinées à travers une série d'opérations de suréchantillonnage et de mélange pour générer la trame de sortie ou la séquence vidéo.

Clé de son innovation est l'évitement des dépendances externes. L'interpolation de trames traditionnelle pourrait calculer des correspondances au niveau des pixels en utilisant le flux optique, mais FILM les apprend implicitement au sein de son réseau. Lors de l'inférence, vous contrôlez la profondeur d'interpolation avec le paramètre 'times_to_interpolate' : réglez sur 1 pour une seule trame médiane (à t=0.5), ou plus élevé (jusqu'à 8) pour une vidéo complète avec exponentiellement plus de trames (2^times_to_interpolate + 1 total, à 30 FPS). Cette invocation récursive assure des transitions fluides, même dans des scénarios difficiles comme les occlusions ou les déformations rapides.

Le rapport technique sous-jacent de 2022 détaille comment le modèle a été entraîné sur des ensembles de données vidéo diversifiés, optimisant pour une qualité perceptive plutôt qu'une précision pixel-par-pixel. Cela aboutit à des sorties visuellement plaisantes qui imitent la perception humaine, le rendant idéal pour des applications au-delà de la synthèse brute.

Comment utiliser l'Interpolation de Trames FILM ?

Commencer avec FILM est simple, grâce à son déploiement sur des plateformes comme Replicate pour l'accès API ou son dépôt GitHub pour des exécutions locales.

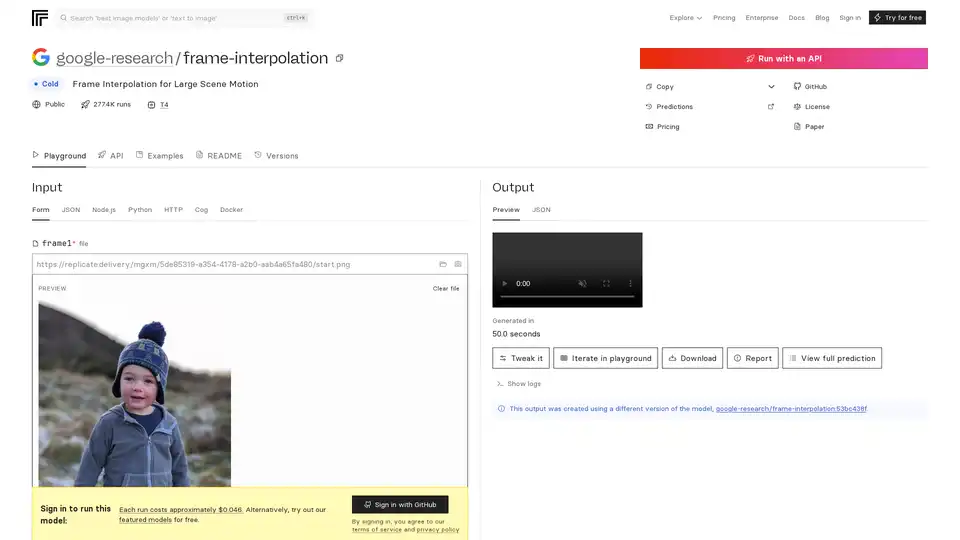

Via l'API Replicate : Téléchargez deux fichiers image en tant que frame1 et frame2. Ajustez 'times_to_interpolate' (par défaut 1) pour définir la complexité de sortie. Les prédictions s'exécutent sur des GPU Nvidia T4, se terminant généralement en moins de 4 minutes, avec des coûts autour de 0,046 $ par exécution (environ 21 exécutions par dollar). Les sorties incluent des images d'aperçu, des vidéos téléchargeables ou des métadonnées JSON. Aucun identifiant requis pour les essais gratuits sur les modèles phares, mais la connexion GitHub débloque l'accès complet.

Configuration Locale avec Docker : Clonez le dépôt GitHub à https://github.com/google-research/frame-interpolation. Utilisez Docker pour un isolement d'environnement facile—téléchargez l'image et exécutez les prédictions via ligne de commande ou intégrez dans des scripts Python/Node.js. Le framework Cog supporte des entrées personnalisées, le rendant extensible pour le traitement par lots.

Exigences d'Entrée : Les trames doivent être des images séquentielles (p. ex., JPEG/PNG). Pour l'interpolation vidéo, traitez les paires de manière récursive. La capture webcam est supportée pour des tests rapides.

Des exemples sur Replicate mettent en scène des utilisations réelles, comme interpolar des séquences sportives ou animées, démontrant des résultats sans artefacts.

Pourquoi choisir FILM pour vos projets ?

FILM excelle là où d'autres outils peinent, offrant une gestion supérieure des grands mouvements sans la surcharge computationnelle des pipelines multi-modèles. Les scores de référence du papier ECCV 2022 soulignent son avantage sur les concurrents en métriques comme PSNR et SSIM d'interpolation. Il est open-source sous une licence permissive, favorisant les contributions communautaires—des forks et modèles liés comme zsxkib/film-frame-interpolation-for-large-motion l'adaptent pour des tâches vidéo spécifiques.

L'efficacité coût est un autre atout : exécutions locales gratuites versus prédictions cloud abordables. De plus, ses démos YouTube et le papier fournissent une validation transparente, bâtissant la confiance pour un usage en production. Si vous traitez des vidéos à basse FPS saccadées de drones ou de caméras d'action, FILM les transforme en expériences cinématographiques sans effort.

À qui s'adresse l'Interpolation de Trames FILM ?

Cet outil cible les passionnés d'AI, les monteurs vidéo et les praticiens en machine learning axés sur la vision par ordinateur.

Développeurs et Chercheurs : Idéal pour expérimenter avec l'interpolation neuronale dans des papiers ou prototypes, surtout dans des domaines comme la compression vidéo ou l'animation.

Créateurs de Contenu : Les cinéastes et YouTubers peuvent augmenter les taux de trames pour une lecture plus fluide, améliorant les vidéos mobiles ou web sans matériel coûteux.

Professionnels de l'Industrie : Dans le gaming (p. ex., boosting de taux de trames pour des animations plus fluides) ou la surveillance (interpolant des footage clairsemés), l'efficacité de FILM brille. Il n'est pas adapté aux applications en temps réel en raison des temps de prédiction mais parfait pour l'amélioration hors ligne.

Des modèles liés sur Replicate, comme pollinations/rife-video-interpolation ou zsxkib/st-mfnet, complètent FILM en offrant des workflows vidéo-à-vidéo, mais le focus de FILM sur les grands mouvements lui donne un avantage niche.

Valeur Pratique et Cas d'Usage

La vraie puissance de FILM réside dans sa polyvalence. En éducation, il aide à créer des analyses en slow-motion pour des démos de physique. Pour le marketing, interpolez des prises de produits pour montrer des rotations fluides. Les retours d'utilisateurs sur GitHub louent sa facilité à gérer les occlusions, courantes dans les footage réels.

Considérez un cas : Un vidéaste de faune avec des clips 15 FPS d'une caméra portable instable. En utilisant FILM, ils génèrent des sorties 30 FPS, préservant les détails dans les mouvements rapides des animaux—transformant les footage bruts en reels professionnels.

Les schémas de tarification sont transparents : Le modèle pay-per-run de Replicate s'adapte à l'usage, tandis que l'auto-hébergement élimine les coûts récurrents. Pour les FAQs, consultez le README pour le dépannage des entrées ou différences de version (p. ex., la version actuelle utilise google-research/frame-interpolation:53bc438f).

En résumé, FILM incarne l'engagement de Google envers une AI accessible pour l'amélioration des médias. Que vous optimisiez des workflows ou repoussiez les limites de la recherche, c'est un choix fiable pour une interpolation de trames supérieure. Plongez dans le dépôt GitHub ou le playground Replicate pour le voir en action—vos vidéos ne seront plus jamais les mêmes.

Génération de Vidéo par IA Édition de Vidéo par IA Capture de Mouvement et Animation par IA Humain Virtuel et Avatar Numérique par IA Génération de Vidéo 3D

Meilleurs outils alternatifs à "FILM Frame Interpolation"

PDF Pals est une application native pour Mac qui vous permet de discuter avec n'importe quel PDF instantanément en utilisant l'IA, sans limites de taille de fichier. Profitez d'un OCR rapide, d'un stockage local pour la confidentialité et d'un support pour les API OpenAI. Parfait pour les chercheurs, développeurs et professionnels analysant des documents.

MakeMyAnime est une plateforme alimentée par l'IA pour créer rapidement des animations d'anime. Elle propose des outils de conception de personnages, de génération d'images, de synchronisation labiale et d'interpolation vidéo, rendant l'animation accessible et efficace pour les créateurs.

Améliorez vos vidéos avec Topaz Video, un logiciel basé sur l'IA pour la mise à l'échelle, la réduction du bruit, la stabilisation et le lissage des séquences. Approuvé par les professionnels de la création pour des résultats de qualité cinéma.

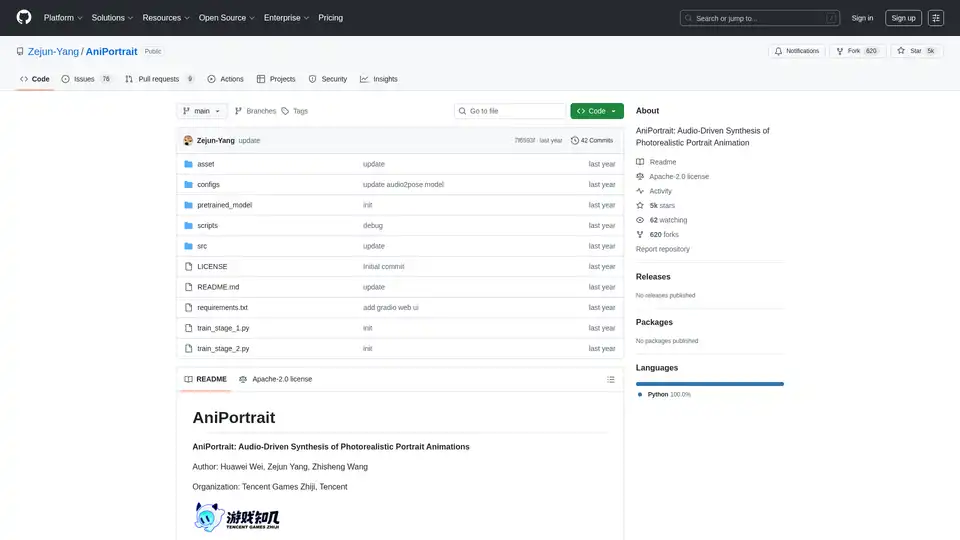

AniPortrait est un framework IA open-source pour générer des animations de portrait photoréalistes pilotées par audio ou vidéo. Il prend en charge les modes auto-conduits, reenactment facial et audio pour une synthèse vidéo de haute qualité.