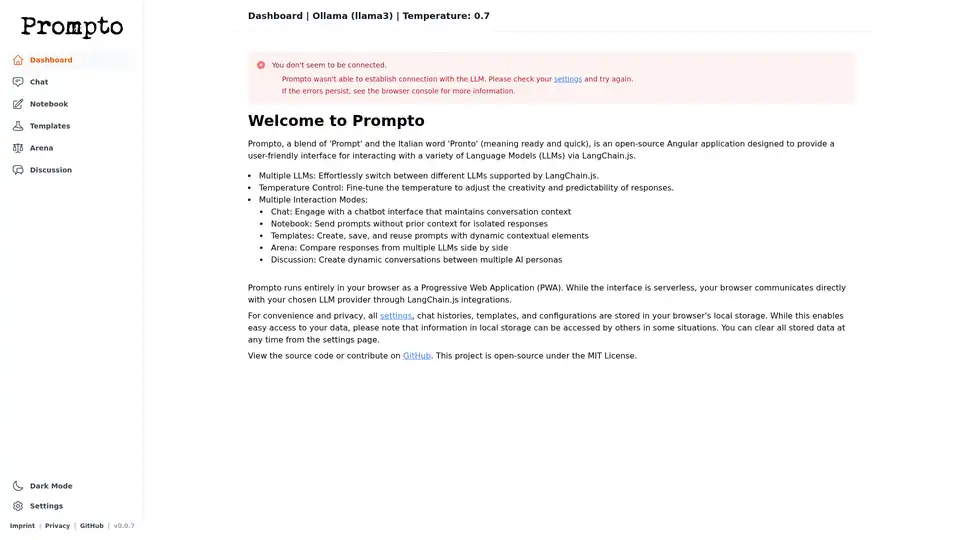

Prompto

Descripción general de Prompto

¿Qué es Prompto?

Prompto es una aplicación web de código abierto diseñada para que la interacción con los Modelos de Lenguaje (LLM) sea simple y eficiente. El nombre en sí es una mezcla de 'Prompt' (instrucción) y la palabra italiana 'Pronto' (que significa listo y rápido), destacando su enfoque en la interacción rápida y fácil con LLM. Utiliza LangChain.js para proporcionar una interfaz fácil de usar para interactuar con varios LLM.

¿Cómo funciona Prompto?

Prompto funciona como una Aplicación Web Progresiva (PWA) que se ejecuta completamente en su navegador. Es una interfaz sin servidor que se comunica directamente con su proveedor de LLM elegido a través de las integraciones de LangChain.js. Aquí hay un desglose:

- Operación del lado del cliente: La aplicación se ejecuta dentro de su navegador, lo que garantiza la privacidad y reduce las dependencias del lado del servidor.

- Integración de LangChain.js: Utiliza LangChain.js para conectarse e interactuar con diferentes LLM.

- Almacenamiento local: Todas las configuraciones, historiales de chat, plantillas y configuraciones se almacenan en el almacenamiento local de su navegador para mayor comodidad y acceso rápido. Sin embargo, tenga en cuenta que otros pueden acceder a los datos del almacenamiento local en determinadas situaciones, así que tenga cuidado con la información confidencial. Puede borrar estos datos desde la página de configuración.

Características clave de Prompto

Prompto ofrece una gama de características diseñadas para optimizar sus interacciones con LLM:

- Soporte para múltiples LLM: Cambie fácilmente entre diferentes LLM compatibles con LangChain.js.

- Control de temperatura: Ajuste la configuración de temperatura para ajustar la creatividad y la predictibilidad de las respuestas de LLM. Una temperatura más baja da como resultado respuestas más predecibles y enfocadas, mientras que una temperatura más alta conduce a salidas más creativas y variadas.

- Múltiples modos de interacción:

- Chat: Participe en interacciones conversacionales con un chatbot que mantiene el contexto en múltiples turnos. Ideal para tareas que requieren un diálogo continuo.

- Notebook: Envíe indicaciones sin ningún contexto previo. Este modo es útil para consultas aisladas donde necesita una respuesta nueva cada vez.

- Templates: Cree, guarde y reutilice indicaciones con elementos contextuales dinámicos. Esta característica le permite crear indicaciones reutilizables para obtener resultados consistentes.

- Arena: Compare las respuestas de múltiples LLM lado a lado, lo que le ayudará a elegir el mejor modelo para una tarea específica. Esta característica es excelente para evaluar el rendimiento de diferentes modelos.

- Discussion: Cree conversaciones dinámicas entre múltiples personajes de IA, lo que le permite simular interacciones complejas y explorar diferentes perspectivas. Esta es una forma innovadora de explorar las capacidades de los LLM.

Cómo usar Prompto

- Acceda a Prompto: Como es una PWA, puede acceder a ella a través de su navegador web.

- Configure los ajustes de LLM: Configure Prompto para conectarse a su proveedor de LLM preferido a través de LangChain.js.

- Seleccione el modo de interacción: Elija entre Chat, Notebook, Templates, Arena o Discussion, según sus necesidades.

- Empiece a solicitar: Introduzca sus indicaciones y empiece a interactuar con el LLM.

- Administre la configuración: Personalice la configuración de la aplicación, incluyendo la temperatura y las preferencias de almacenamiento de datos.

¿Por qué elegir Prompto?

Prompto simplifica el proceso de interacción con LLM, haciéndolo accesible a un público más amplio. Aquí está por qué es una herramienta valiosa:

- Interfaz fácil de usar: Prompto ofrece una interfaz limpia e intuitiva, lo que facilita su uso incluso para aquellos que no tienen un amplio conocimiento técnico.

- Funcionalidad versátil: Con soporte para múltiples LLM, control de temperatura y diversos modos de interacción, Prompto se adapta a una amplia gama de casos de uso.

- Centrado en la privacidad: Al ejecutarse completamente en el navegador y almacenar los datos localmente, Prompto prioriza la privacidad del usuario.

- Código abierto: Al ser un proyecto de código abierto, Prompto se beneficia de las contribuciones de la comunidad y la mejora continua.

¿Para quién es Prompto?

Prompto es una herramienta valiosa para:

- Desarrolladores: Experimentar con diferentes LLM y técnicas de ingeniería de prompts.

- Investigadores: Comparar el rendimiento de varios LLM.

- Creadores de contenido: Generar contenido creativo y explorar la colaboración impulsada por la IA.

- Cualquier persona interesada en explorar las capacidades de los LLM en un entorno fácil de usar.

Empezando

Para empezar a usar Prompto, simplemente visite la aplicación web y siga las instrucciones de configuración. También puede contribuir al proyecto o ver el código fuente en GitHub. El proyecto es de código abierto bajo la Licencia MIT, invitando a las contribuciones de la comunidad y al desarrollo posterior.

Nota sobre el almacenamiento local

Mientras que el almacenamiento local ofrece comodidad, tenga en cuenta las implicaciones de seguridad. Otros pueden acceder a los datos almacenados en el almacenamiento local en algunas situaciones. Para información sensible, considere usar métodos de almacenamiento más seguros.

Gestión de Tareas y Proyectos con IA Resumido y Lectura de Documentos con IA Búsqueda Inteligente con IA Análisis de Datos con IA Flujo de Trabajo Automatizado

Mejores herramientas alternativas a "Prompto"

Trainkore: Una plataforma de prompting y RAG para automatizar prompts, el cambio de modelo y la evaluación. Ahorra un 85% en los costes de LLM.

Parea AI es la plataforma definitiva de experimentación y anotación humana para equipos de IA, que permite una evaluación fluida de LLM, pruebas de prompts y despliegue en producción para construir aplicaciones de IA confiables.

Tavily es un motor de búsqueda en tiempo real para agentes de IA y flujos de trabajo RAG, que ofrece API rápidas y seguras para la búsqueda web y la extracción de contenido. Con la confianza de más de 700.000 desarrolladores.

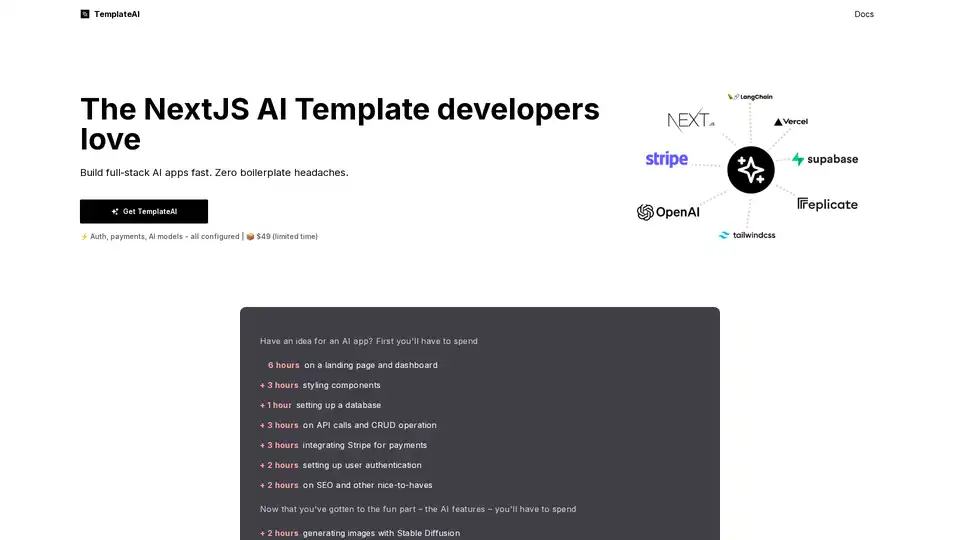

TemplateAI es la plantilla NextJS líder para apps de IA, con autenticación Supabase, pagos Stripe, integración OpenAI/Claude y componentes AI listos para usar en desarrollo full-stack rápido.