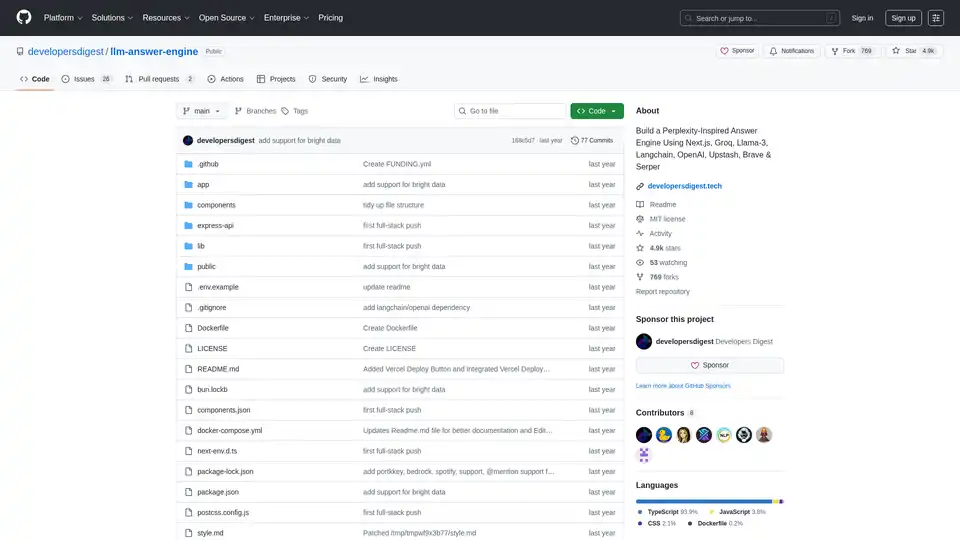

llm-answer-engine

Descripción general de llm-answer-engine

Motor de respuestas LLM: construye tu propio sistema de preguntas y respuestas impulsado por AI

Este proyecto de código abierto, llm-answer-engine, proporciona el código y las instrucciones para construir un sofisticado motor de respuestas AI inspirado en Perplexity. Aprovecha tecnologías de vanguardia como Groq, Mixtral de Mistral AI, Langchain.JS, Brave Search, Serper API y OpenAI para ofrecer respuestas completas a las consultas de los usuarios, con fuentes, imágenes, vídeos y preguntas de seguimiento.

¿Qué es llm-answer-engine?

llm-answer-engine es un punto de partida para los desarrolladores interesados en explorar el procesamiento del lenguaje natural y las tecnologías de búsqueda. Te permite crear un sistema que responda eficientemente a las preguntas mediante:

- Recuperar información relevante de diversas fuentes.

- Generar respuestas concisas e informativas.

- Proporcionar evidencia de apoyo y medios relacionados.

- Sugerir preguntas de seguimiento para guiar la exploración posterior.

¿Cómo funciona llm-answer-engine?

El motor utiliza una combinación de tecnologías para procesar las consultas de los usuarios y generar respuestas relevantes:

- Comprensión de consultas: Tecnologías como Groq y Mixtral se utilizan para procesar y comprender la pregunta del usuario.

- Recuperación de información:

- Brave Search: Se utiliza un motor de búsqueda centrado en la privacidad para encontrar contenido e imágenes relevantes.

- Serper API: Se utiliza para obtener resultados de vídeo e imagen relevantes basados en la consulta del usuario.

- Cheerio: Se utiliza para el análisis HTML, lo que permite la extracción de contenido de páginas web.

- Procesamiento de texto:

- Langchain.JS: Una biblioteca de JavaScript centrada en operaciones de texto, como la división de texto y las incrustaciones.

- OpenAI Embeddings: Se utiliza para crear representaciones vectoriales de fragmentos de texto.

- Componentes opcionales:

- Ollama: Se utiliza para la inferencia y las incrustaciones de transmisión.

- Upstash Redis Rate Limiting: Se utiliza para configurar la limitación de velocidad para la aplicación.

- Upstash Semantic Cache: Se utiliza para almacenar en caché los datos para obtener tiempos de respuesta más rápidos.

Características y tecnologías clave:

- Next.js: Un marco de React para la creación de aplicaciones web estáticas y renderizadas en el servidor, que proporciona una base sólida para la interfaz de usuario.

- Tailwind CSS: Un marco CSS de utilidad primero para la creación rápida de interfaces de usuario personalizadas, lo que permite una personalización y un estilo eficientes.

- Vercel AI SDK: Una biblioteca para la creación de texto de transmisión y interfaces de usuario de chat impulsadas por AI, que mejora la experiencia del usuario con comentarios en tiempo real.

- Soporte de llamada de función (Beta): Amplía la funcionalidad con integraciones para Mapas y ubicaciones (Serper Locations API), Compras (Serper Shopping API), Datos bursátiles de TradingView y Spotify.

- Soporte de Ollama (parcialmente compatible): Ofrece compatibilidad con Ollama para la transmisión de respuestas de texto e incrustaciones, lo que permite la ejecución de modelos locales.

¿Cómo utilizar llm-answer-engine?

Para empezar a utilizar llm-answer-engine, sigue estos pasos:

- Requisitos previos:

- Obtén las claves API de OpenAI, Groq, Brave Search y Serper.

- Asegúrate de que Node.js y npm (o bun) estén instalados.

- (Opcional) Instala Docker y Docker Compose para la implementación en contenedores.

- Instalación:

git clone https://github.com/developersdigest/llm-answer-engine.git

cd llm-answer-engine

3. **Configuración**: * **Docker**: Edita el archivo `docker-compose.yml` y añade tus claves API. * **No Docker**: Crea un archivo `.env` en la raíz de tu proyecto y añade tus claves API. 4. **Ejecuta el servidor**: * **Docker**:bash

docker compose up -d

* **No Docker**:bash

npm install # or bun install

npm run dev # or bun run dev

```

El servidor estará escuchando en el puerto especificado.

¿Por qué elegir llm-answer-engine?

- Inspirado en Perplexity: Proporciona una experiencia de usuario similar a la de un motor de respuestas AI líder.

- Aprovecha tecnologías potentes: Combina lo mejor de lo mejor en PNL, búsqueda y desarrollo web.

- De código abierto y personalizable: Te permite adaptar el motor a tus necesidades específicas.

- Soporte de llamada de función: Amplía la funcionalidad con integraciones para Mapas y ubicaciones, Compras, Datos bursátiles de TradingView y Spotify.

¿Para quién es llm-answer-engine?

Este proyecto es ideal para:

- Desarrolladores interesados en el procesamiento del lenguaje natural y las tecnologías de búsqueda.

- Investigadores que exploran sistemas de preguntas y respuestas.

- Cualquiera que quiera construir su propia base de conocimiento impulsada por AI.

Hoja de ruta:

La hoja de ruta del proyecto incluye características interesantes como:

- Carga de documentos + RAG para la búsqueda/recuperación de documentos.

- Un componente de configuración para permitir a los usuarios seleccionar el modelo, el modelo de incrustaciones y otros parámetros desde la interfaz de usuario.

- Añadir soporte para preguntas de seguimiento al usar Ollama

Contribución:

¡Las contribuciones son bienvenidas! Bifurca el repositorio, realiza tus cambios y envía una solicitud de extracción.

Este proyecto está licenciado bajo la Licencia MIT.

Construye tu propio motor de respuestas impulsado por AI y explora las posibilidades del procesamiento del lenguaje natural con llm-answer-engine!

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "llm-answer-engine"

Airweave es una herramienta de código abierto que centraliza datos de varias aplicaciones y bases de datos, lo que permite que los agentes de IA proporcionen respuestas precisas y fundamentadas al instante. ¡Construye agentes de IA más inteligentes hoy!

LangSearch proporciona una API de búsqueda web y una API de clasificación semántica para conectar aplicaciones LLM a un contexto limpio y preciso.

Albus AI es un espacio de trabajo en la nube que crea bases de conocimiento de IA, optimiza documentos y proporciona un motor de IA sin alucinaciones para referencias precisas y mapeo semántico. Organiza automáticamente tus archivos, busca en múltiples formatos y obtén respuestas con referencias.

La plataforma de habilitación de IA de BA Insight proporciona búsqueda empresarial impulsada por IA, conectando a los usuarios con contenido relevante de sistemas dispares, mejorada con comprensión semántica y RAG para IA generativa.