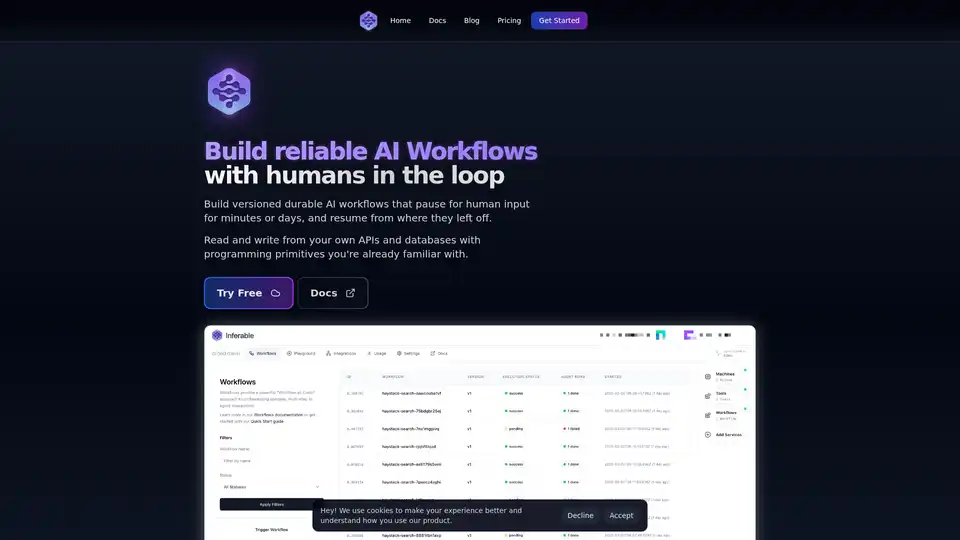

Inferable

Descripción general de Inferable

¿Qué es Inferable?

Inferable es una plataforma de código abierto diseñada para optimizar la creación de agentes de AI, permitiendo a los desarrolladores integrar sus bases de código, APIs y datos existentes sin problemas. Se centra en la construcción de flujos de trabajo de AI fiables, especialmente aquellos que requieren la validación humana en el bucle.

¿Cómo funciona Inferable?

Inferable proporciona un conjunto de primitivas LLM listas para producción que manejan muchas de las complejidades involucradas en la construcción de flujos de trabajo de AI. Las características clave incluyen:

- Versionado de flujos de trabajo: Permite la evolución de flujos de trabajo de larga duración a lo largo del tiempo de una manera compatible con versiones anteriores. Se pueden definir diferentes versiones del mismo flujo de trabajo a medida que cambian los requisitos, asegurando que las ejecuciones en curso continúen utilizando la versión original hasta su finalización.

- Estado gestionado: Inferable gestiona todo el estado requerido para los flujos de trabajo duraderos, eliminando la necesidad de que los desarrolladores aprovisionen y gestionen bases de datos.

- Humano en el bucle: Construye flujos de trabajo de AI que se pausen para la entrada humana durante minutos o días, y se reanuden desde donde lo dejaron.

- Observabilidad: Ofrece observabilidad de extremo a extremo con una consola de desarrollador y la capacidad de conectarse a pilas de observabilidad existentes.

- Ejecución On-Premise: Los flujos de trabajo se ejecutan en la infraestructura del usuario, eliminando la necesidad de un paso de implementación.

- Sin conexiones entrantes: Seguridad mejorada con conexiones solo de salida, asegurando que la infraestructura permanezca segura sin abrir puertos de entrada.

- Código Abierto: Inferable es completamente de código abierto, ofreciendo total transparencia y control sobre la base de código.

Ejemplo de código:

La plataforma utiliza un enfoque simple, impulsado por código:

import { Inferable } from "inferable";

const inferable = new Inferable({

apiSecret: require("./cluster.json").apiKey,

});

const workflow = inferable.workflows.create({

name: "customerDataProcessor",

inputSchema: z.object({

executionId: z.string(),

customerId: z.string(),

}),

});

// Versión inicial del flujo de trabajo

workflow.version(1).define(async (ctx, input) => {

const customerData = await fetchCustomerData(input.customerId);

// Procesa los datos con un análisis simple

const analysis = await ctx.llm.structured({

input: JSON.stringify(customerData),

schema: z.object({

riskLevel: z.enum(["low", "medium", "high"]),

summary: z.string(),

}),

});

return { analysis };

});

// Versión mejorada con un análisis más detallado

workflow.version(2).define(async (ctx, input) => {

const customerData = await fetchCustomerData(input.customerId);

const transactionHistory =

await fetchTransactionHistory(input.customerId);

// Procesa los datos con un análisis más avanzado

const analysis = await ctx.llm.structured({

input: JSON.stringify({ customerData, transactionHistory }),

schema: z.object({

riskLevel: z.enum(["low", "medium", "high"]),

summary: z.string(),

recommendations: z.array(z.string()),

factors: z.array(z.object({

name: z.string(),

impact: z.enum(["positive", "negative", "neutral"]),

weight: z.number(),

})),

}),

});

return {

analysis,

version: 2,

processedAt: new Date().toISOString()

};

});

Este ejemplo demuestra cómo definir y versionar un flujo de trabajo para procesar datos de clientes utilizando análisis basados en LLM.

¿Por qué elegir Inferable?

- Flexibilidad: Funciona con primitivas de programación existentes para el flujo de control, sin invertir el modelo de programación.

- Control: Control total sobre los datos y el cómputo mediante el auto-hospedaje en su propia infraestructura.

- Transparencia: Benefíciese de la total transparencia y control sobre la base de código debido a su naturaleza de código abierto.

- Seguridad mejorada: Infraestructura segura con conexiones solo de salida.

¿Para quién es Inferable?

Inferable es ideal para startups y scale-ups que buscan construir flujos de trabajo fiables impulsados por AI con validación humana en el bucle. Es particularmente útil para aquellos que necesitan:

- Automatizar procesos complejos con AI.

- Mantener el control sobre sus datos e infraestructura.

- Asegurar el cumplimiento de las regulaciones de privacidad de datos.

¿La mejor manera de empezar con Inferable?

- Explorar la documentación: Hay documentación completa disponible para guiarle a través de la configuración y el uso.

- Guía de auto-hospedaje: Proporciona instrucciones para implementar Inferable en su propia infraestructura.

- Repositorio de GitHub: Acceda al código base completo de código abierto.

Inferable ofrece una manera de implementar flujos de trabajo de AI que son versionados, duraderos y observables, con el beneficio añadido de la supervisión humana, lo que lo convierte en una herramienta valiosa para las empresas que buscan aprovechar la AI en sus operaciones.

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "Inferable"

Agent TARS es un agente de IA multimodal de código abierto que integra sin problemas operaciones de navegador, líneas de comandos y sistemas de archivos para una automatización de flujos de trabajo mejorada. Experimenta interpretación visual avanzada y razonamiento sofisticado para un manejo eficiente de tareas.

Con TacoTranslate, puedes llevar tu aplicación React a nuevos mercados con i18n automático. Traduce desde y hacia más de 75 idiomas. Funciona genial con Next.js.

Langdock es una plataforma de IA todo en uno diseñada para empresas, que ofrece chat de IA, asistentes, integraciones y automatización de flujo de trabajo. Permite a los empleados y desarrolladores aprovechar la IA de manera efectiva.

Neural Newsletters es un potente motor que te ayuda a crear y publicar boletines atractivos adaptados a las preferencias e intereses de tu audiencia en minutos.