Avian API

Descripción general de Avian API

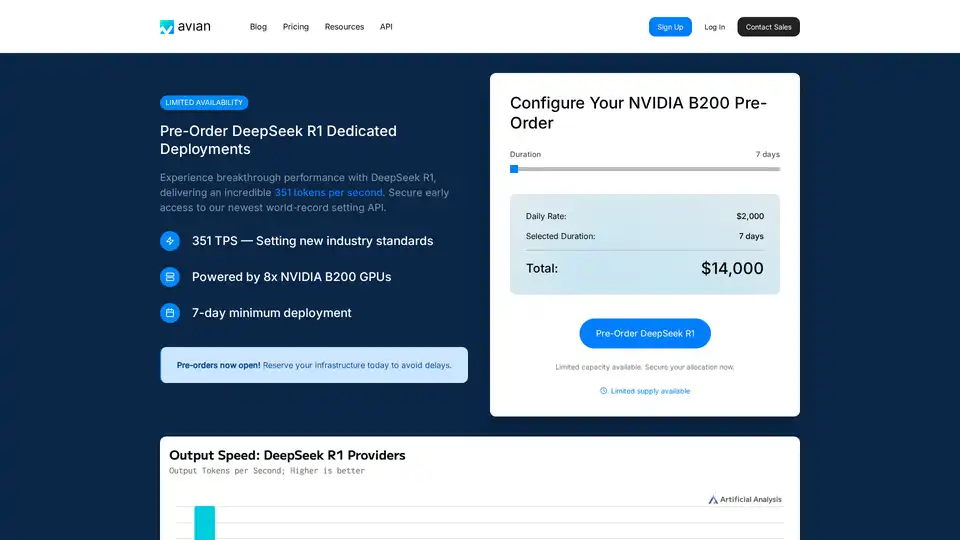

Avian API: La inferencia de AI más rápida para LLM de código abierto

Avian API es una plataforma que proporciona la inferencia de AI más rápida para Modelos de Lenguaje Grandes (LLM) de código abierto como Llama. Permite a los usuarios implementar y ejecutar LLM desde Hugging Face a velocidades 3-10 veces más rápidas que los promedios de la industria. Con Avian, los usuarios pueden experimentar la inferencia de AI de grado de producción sin límites de velocidad, aprovechando la arquitectura sin servidor o implementando cualquier LLM desde Hugging Face.

¿Qué es Avian API?

Avian API está diseñado para proporcionar una inferencia de AI de alto rendimiento, centrándose en la velocidad, la privacidad y la facilidad de uso. Destaca por ofrecer velocidades de inferencia líderes en la industria, particularmente en modelos como DeepSeek R1, donde alcanza 351 tokens por segundo (TPS). Este rendimiento está impulsado por la arquitectura NVIDIA B200 optimizada, estableciendo nuevos estándares en el panorama de la inferencia de AI.

¿Cómo funciona Avian API?

Avian API funciona aprovechando la infraestructura optimizada y las técnicas patentadas para acelerar el proceso de inferencia. Las características clave incluyen:

- Inferencia de alta velocidad: Alcanza hasta 351 TPS en modelos como DeepSeek R1.

- Integración de Hugging Face: Permite la implementación de cualquier modelo de Hugging Face con una configuración mínima.

- Optimización y escalado automáticos: Optimiza y escala automáticamente los modelos para garantizar un rendimiento constante.

- Punto de conexión API compatible con OpenAI: Proporciona un punto de conexión API fácil de usar compatible con OpenAI, lo que simplifica la integración en los flujos de trabajo existentes.

- Rendimiento y privacidad de nivel empresarial: Construido sobre una infraestructura segura de Microsoft Azure aprobada por SOC/2 sin almacenamiento de datos.

Características y beneficios clave

- Velocidades de inferencia más rápidas: Avian API ofrece una velocidad de inferencia inigualable, lo que lo hace ideal para aplicaciones que requieren respuestas en tiempo real.

- Fácil integración: Con su API compatible con OpenAI, Avian se puede integrar fácilmente en proyectos existentes con cambios mínimos en el código.

- Rentable: Al optimizar la utilización de los recursos, Avian ayuda a reducir los costos asociados con la inferencia de AI.

- Privacidad y seguridad: Avian garantiza la privacidad y seguridad de los datos con su cumplimiento de SOC/2 y opciones de alojamiento privado.

Cómo usar Avian API

El uso de Avian API implica algunos pasos simples:

- Registrarse: Cree una cuenta en la plataforma Avian.io.

- Obtenga su clave API: Obtenga su clave API única del panel de control.

- Seleccionar modelo: Elija su modelo de código abierto preferido de Hugging Face o use DeepSeek R1 para un rendimiento óptimo.

- Integrar API: Use el fragmento de código proporcionado para integrar la API de Avian en su aplicación.

Aquí hay un ejemplo de fragmento de código para usar la API de Avian:

from openai import OpenAI

import os

client = OpenAI(

base_url="https://api.avian.io/v1",

api_key=os.environ.get("AVIAN_API_KEY")

)

response = client.chat.completions.create(

model="DeepSeek-R1",

messages=[

{

"role": "user",

"content": "What is machine learning?"

}

],

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="")

Este fragmento de código demuestra cómo usar la API de Avian para generar una respuesta del modelo DeepSeek-R1. Simplemente cambie la base_url y use su clave API para comenzar.

¿Por qué elegir Avian API?

Avian API destaca por su enfoque en la velocidad, la seguridad y la facilidad de uso. En comparación con otras soluciones de inferencia, Avian ofrece:

- Rendimiento superior: Alcanza 351 TPS en DeepSeek R1, significativamente más rápido que competidores como Together, Fireworks y Amazon.

- Implementación simplificada: Integración de código de una línea para cualquier modelo de Hugging Face.

- Seguridad de nivel empresarial: Cumplimiento de SOC/2 y modo de privacidad para chats.

¿Para quién es Avian API?

Avian API es ideal para:

- Empresas: Empresas que requieren una inferencia de AI escalable, segura y de alto rendimiento.

- Desarrolladores: Desarrolladores que buscan una API fácil de usar para integrar AI en sus aplicaciones.

- Investigadores: Investigadores que necesitan una inferencia rápida y confiable para sus modelos de AI.

Conclusión

Avian API proporciona la inferencia de AI más rápida para LLM de código abierto, lo que la convierte en una herramienta esencial para cualquiera que busque aprovechar el poder de la AI en sus proyectos. Con su rendimiento de alta velocidad, fácil integración y seguridad de nivel empresarial, Avian API está estableciendo nuevos estándares en el panorama de la inferencia de AI. Ya sea que esté implementando modelos desde Hugging Face o aprovechando la arquitectura NVIDIA B200 optimizada, Avian API ofrece una velocidad y eficiencia inigualables.

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "Avian API"

Nexa SDK permite una inferencia de IA rápida y privada en el dispositivo para modelos LLM, multimodales, ASR y TTS. Implemente en dispositivos móviles, PC, automotrices e IoT con un rendimiento listo para producción en NPU, GPU y CPU.

DeepSeek-v3 es un modelo de IA basado en la arquitectura MoE, que proporciona soluciones de IA estables y rápidas con una amplia capacitación y soporte para múltiples idiomas.

Unsloth AI ofrece ajuste fino de código abierto y aprendizaje por refuerzo para LLM como gpt-oss y Llama, con un entrenamiento 30 veces más rápido y un uso reducido de memoria, lo que hace que el entrenamiento de IA sea accesible y eficiente.

Vivgrid es una plataforma de infraestructura de agentes de IA que ayuda a los desarrolladores a construir, observar, evaluar e implementar agentes de IA con protecciones de seguridad e inferencia de baja latencia. Es compatible con GPT-5, Gemini 2.5 Pro y DeepSeek-V3.