Mindgard

Übersicht von Mindgard

Mindgard: Automatisierte AI Red Teaming & Sicherheitsprüfung

Was ist Mindgard?

Mindgard ist eine AI-Sicherheitsprüfungslösung, die Organisationen dabei unterstützt, ihre AI-Systeme vor neuen Bedrohungen zu schützen. Traditionelle Anwendungssicherheitstools können die einzigartigen Risiken, die mit AI verbunden sind, nicht bewältigen, was Mindgard zu einer notwendigen Schutzschicht macht.

Wie funktioniert Mindgard?

Die Offensive Security for AI-Lösung von Mindgard verwendet automatisiertes Red Teaming, um AI-spezifische Risiken zu identifizieren und zu beheben, die nur während der Laufzeit erkennbar sind. Es integriert sich in die bestehende CI/CD-Automatisierung und alle Phasen des SDLC. Um Mindgard mit Ihrem AI-System zu verbinden, benötigen Sie lediglich einen Inferenz- oder API-Endpunkt für die Modellintegration. Die Plattform unterstützt eine breite Palette von AI-Modellen, darunter Generative AI, LLMs, NLP, Audio-, Bild- und multimodale Systeme.

Warum ist Mindgard wichtig?

Der Einsatz und die Verwendung von AI bergen neue Risiken, die mit herkömmlichen Sicherheitstools nicht bewältigt werden können. Viele AI-Produkte werden ohne ausreichende Sicherheit auf den Markt gebracht, wodurch Unternehmen anfällig werden. Gartner-Studien zeigen, dass 29 % der Unternehmen mit AI-Systemen bereits Sicherheitsverletzungen gemeldet haben, aber nur 10 % der internen Auditoren haben Einblick in das AI-Risiko.

Hauptmerkmale und Vorteile

- Automatisiertes Red Teaming: Simuliert Angriffe auf AI-Systeme, um Schwachstellen ohne manuelle Eingriffe zu identifizieren.

- AI-Spezifische Risikoidentifizierung: Identifiziert und behebt AI-spezifische Risiken wie Jailbreaking, Extraktion, Umgehung, Inversion, Vergiftung und Prompt Injection.

- Kontinuierliche Sicherheitsprüfung: Bietet kontinuierliche Sicherheitsprüfung über den gesamten AI SDLC hinweg.

- Integration mit bestehenden Systemen: Lässt sich in bestehende Berichts- und SIEM-Systeme integrieren.

- Umfassende Abdeckung: Funktioniert mit verschiedenen AI-Modellen und Guardrails, einschließlich LLMs wie OpenAI, Claude und Bard.

Anwendungsfälle

- Sicherung von AI-Systemen: Schützt AI-Systeme vor neuen Bedrohungen, die mit herkömmlichen Anwendungssicherheitstools nicht abgewehrt werden können.

- Identifizierung von AI-Schwachstellen: Deckt AI-Schwachstellen auf und behebt sie, sodass Entwickler sichere und vertrauenswürdige Systeme entwickeln können.

- Kontinuierliche Sicherheitsgarantie: Bietet kontinuierliche Sicherheitsprüfungen und automatisiertes AI-Red Teaming über den gesamten AI-Lebenszyklus hinweg.

Welche Arten von Risiken deckt Mindgard auf?

Mindgard identifiziert verschiedene AI-Sicherheitsrisiken, darunter:

- Jailbreaking: Manipulation von Eingaben, um AI-Systeme zu unerwünschten Aktionen zu veranlassen.

- Extraktion: Rekonstruktion von AI-Modellen zur Offenlegung sensibler Informationen.

- Evasion (Umgehung): Veränderung von Eingaben, um AI-Modelle zu falschen Ausgaben zu verleiten.

- Inversion: Reverse Engineering von Modellen, um Trainingsdaten aufzudecken.

- Poisoning (Vergiftung): Manipulation von Trainingsdaten, um das Modellverhalten zu beeinflussen.

- Prompt Injection: Einfügen von bösartigen Eingaben, um AI-Systeme zu unbeabsichtigten Antworten zu verleiten.

Auszeichnungen und Anerkennung

- Gewinner der Auszeichnung „Best AI Solution“ und „Best New Company“ bei den SC Awards Europe 2025.

- Veröffentlicht in TechCrunch, Sifted und anderen Publikationen.

FAQs

- Was unterscheidet Mindgard von anderen AI-Sicherheitsunternehmen? Mindgard verfügt über mehr als 10 Jahre rigoroser Forschung im Bereich der AI-Sicherheit und gewährleistet den Zugriff auf die neuesten Fortschritte und qualifizierte Talente.

- Kann Mindgard verschiedene Arten von AI-Modellen verarbeiten? Ja, Mindgard ist neuronalnetzwerkagnostisch und unterstützt eine breite Palette von AI-Modellen.

- Wie gewährleistet Mindgard Datensicherheit und Datenschutz? Mindgard befolgt die branchenüblichen Best Practices für sichere Softwareentwicklung und -betrieb, einschließlich der Verwendung unserer eigenen Plattform zum Testen von AI-Komponenten. Wir sind GDPR-konform und erwarten die ISO 27001-Zertifizierung Anfang 2025.

- Kann Mindgard mit den LLMs verwendet werden, die ich heute verwende? Absolut. Mindgard wurde entwickelt, um AI, Generative AI und LLMs zu sichern, einschließlich beliebter Modelle wie ChatGPT.

- Welche Arten von Organisationen nutzen Mindgard? Mindgard bedient eine Vielzahl von Organisationen, darunter solche in den Bereichen Finanzdienstleistungen, Gesundheitswesen, Fertigung und Cybersicherheit.

- Warum funktionieren herkömmliche AppSec-Tools nicht für AI-Modelle? Der Einsatz und die Verwendung von AI bergen neue Risiken, die mit herkömmlichen Tools nicht bewältigt werden können. Viele dieser neuen Risiken, wie z. B. LLM Prompt Injection und Jailbreaks, nutzen die probabilistische und undurchsichtige Natur von AI-Systemen aus, die sich erst zur Laufzeit manifestieren. Die Absicherung dieser Risiken erfordert einen grundlegend neuen Ansatz.

Fazit

Mindgard ist eine umfassende AI-Sicherheitsprüfungslösung, die Organisationen dabei unterstützt, ihre AI-Systeme vor neuen Bedrohungen zu schützen. Mit seinen automatisierten Red-Teaming-Funktionen, der AI-spezifischen Risikoidentifizierung und den kontinuierlichen Sicherheitsprüfungen ermöglicht Mindgard Entwicklern, sichere und vertrauenswürdige AI-Systeme zu entwickeln. Durch die Integration von Mindgard in den AI SDLC können Unternehmen sicherstellen, dass ihre AI-Modelle und -Anwendungen sicher und zuverlässig funktionieren.

KI-Aufgaben- und Projektmanagement KI-Dokumentenzusammenfassung und -Lesen KI-Smart-Suche KI-Datenanalyse Automatisierter Arbeitsablauf

Beste Alternativwerkzeuge zu "Mindgard"

Hamming AI bietet automatisierte Tests, Anrufanalyse und Governance für KI-Sprachagenten. Simulieren Sie Anrufe, prüfen Sie Gespräche und erkennen Sie Regressionen mit Leichtigkeit.

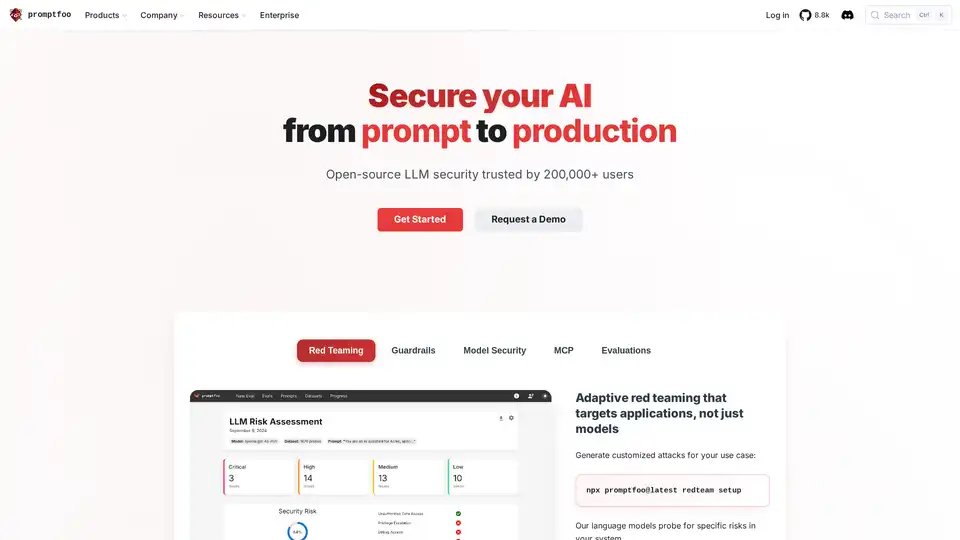

Promptfoo ist ein Open-Source-LLM-Sicherheitstool, das von über 200.000 Entwicklern für AI Red-Teaming und Bewertungen verwendet wird. Es hilft, Schwachstellen zu finden, die Ausgabequalität zu maximieren und Regressionen in KI-Anwendungen abzufangen.

Steigern Sie Ihre Softwarequalität mit den KI-gestützten Qualitätssicherungsdiensten von BugRaptors. Profitieren Sie von KI-gestützten manuellen Tests, KI-gesteuerter Automatisierung und KI-Sicherheitstests.

DataSnack ist eine KI-Sicherheitstestplattform, die reale Cyberbedrohungen simuliert, um potenzielle Zusammenbruchszenarien in Ihren KI-Agenten aufzudecken. Stellen Sie die KI-Sicherheit sicher und verhindern Sie Datenlecks.