Local AI

Übersicht von Local AI

Lokale KI: Ihr privater KI-Spielplatz

Was ist Local AI? Local AI ist eine kostenlose Open-Source-Anwendung, die den Prozess des lokalen Experimentierens mit KI-Modellen vereinfachen soll. Sie ermöglicht es Benutzern, KI-Inferenz offline und privat auszuführen, ohne dass eine GPU erforderlich ist.

Hauptmerkmale von Local AI:

- CPU-Inferencing: Passt sich an verfügbare Threads an und unterstützt GGML-Quantisierung (q4, 5.1, 8, f16).

- Modellverwaltung: Zentralisierter Speicherort zur Verfolgung von KI-Modellen mit fortsetzbaren Downloads und nutzungsbasierter Sortierung.

- Digest-Verifizierung: Gewährleistet die Integrität heruntergeladener Modelle mit BLAKE3- und SHA256-Digest-Compute-Funktionen.

- Inferencing-Server: Starten Sie mit wenigen Klicks einen lokalen Streaming-Server für KI-Inferencing.

Wie funktioniert Local AI?

Local AI nutzt ein Rust-Backend für Speichereffizienz und einen kompakten Footprint (unter 10 MB auf Mac M2, Windows und Linux .deb). Die Anwendung bietet eine benutzerfreundliche Oberfläche für:

- Herunterladen und Verwalten von KI-Modellen aus verschiedenen Quellen.

- Überprüfen der Integrität heruntergeladener Modelle mithilfe kryptografischer Digests.

- Ausführen von Inferenzsitzungen auf der CPU, ohne dass eine GPU erforderlich ist.

- Starten eines lokalen Streaming-Servers für KI-Inferencing.

Wie verwende ich Local AI?

Die Verwendung von Local AI ist denkbar einfach:

- Herunterladen: Laden Sie die Anwendung für Ihr Betriebssystem herunter und installieren Sie sie (.MSI, .EXE, M1/M2, Intel, AppImage, .deb).

- Modellverwaltung: Wählen Sie ein Verzeichnis zum Speichern Ihrer KI-Modelle aus. Local AI verfolgt und verwaltet die Modelle an diesem Speicherort.

- Inferenz: Laden Sie ein Modell und starten Sie mit wenigen Klicks eine Inferenzsitzung. Sie können die integrierte Quick-Inference-UI verwenden oder einen Streaming-Server für komplexere Anwendungen starten.

- Digest-Verifizierung: Überprüfen Sie die Integrität Ihrer heruntergeladenen Modelle mithilfe der BLAKE3- und SHA256-Digest-Compute-Funktion.

Für wen ist Local AI geeignet?

Local AI ist ideal für:

- KI-Enthusiasten: Personen, die daran interessiert sind, mit KI-Modellen zu experimentieren, ohne teure Hardware oder komplexe Setups zu benötigen.

- Datenschutzbewusste Benutzer: Diejenigen, die KI-Inferenz offline und privat ausführen möchten, ohne Daten an externe Server zu senden.

- Entwickler: Die eine einfache und effiziente Möglichkeit zum Testen und Bereitstellen von KI-Modellen lokal benötigen.

Warum Local AI wählen?

- Benutzerfreundlichkeit: Vereinfacht den Prozess des Experimentierens mit KI-Modellen.

- Datenschutz: Führt KI-Inferenz offline und privat aus.

- Effizienz: Verwendet ein Rust-Backend für Speichereffizienz und einen kompakten Footprint.

- Vielseitigkeit: Unterstützt eine Vielzahl von KI-Modellen und Anwendungen.

Kommende Funktionen

Das Local AI-Team arbeitet aktiv an neuen Funktionen, darunter:

- GPU-Inferencing

- Parallele Sitzungen

- Verschachteltes Verzeichnis für die Modellverwaltung

- Benutzerdefiniertes Sortieren und Suchen

- Modell-Explorer und Suche

- Audio-/Bild-Inferencing-Server-Endpunkte

Zusammenfassend ist Local AI ein wertvolles Werkzeug für alle, die lokal mit KI-Modellen experimentieren möchten. Es bietet eine benutzerfreundliche Oberfläche, robuste Funktionen und ein Bekenntnis zu Datenschutz und Effizienz. Wie kann man am besten mit KI-Modellen experimentieren? Mit Local AI ist es einfacher denn je. Probieren Sie es noch heute aus!

KI-Programmierassistent Automatische Codevervollständigung KI-Code-Überprüfung und -Optimierung KI-gesteuerte Low-Code- und No-Code-Entwicklung

Beste Alternativwerkzeuge zu "Local AI"

Experimentieren Sie lokal mit KI-Modellen ohne technische Einrichtung mit local.ai, einer kostenlosen Open-Source-Native-App, die für Offline-KI-Inferenz entwickelt wurde. Keine GPU erforderlich!

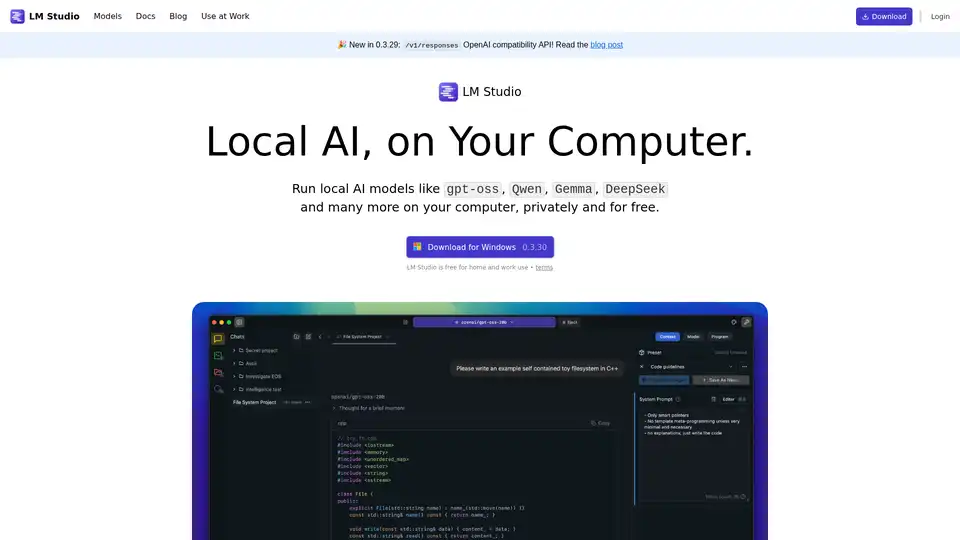

Mit LM Studio können Sie lokale KI-Modelle wie gpt-oss, Qwen, Gemma und DeepSeek privat und kostenlos auf Ihrem Computer ausführen. Es unterstützt Entwicklerressourcen wie JS- und Python-SDKs.

NativeMind ist eine open-source Chrome-Erweiterung, die lokale LLMs wie Ollama ausführt und eine vollständig offline, private ChatGPT-Alternative bietet. Funktionen: kontextbewusster Chat, Agentenmodus, PDF-Analyse, Schreibtools und Übersetzung – alles 100% auf dem Gerät ohne Cloud.