KoboldCpp

Übersicht von KoboldCpp

KoboldCpp: Ihre All-in-One-Lösung für KI-Text- und Bildgenerierung

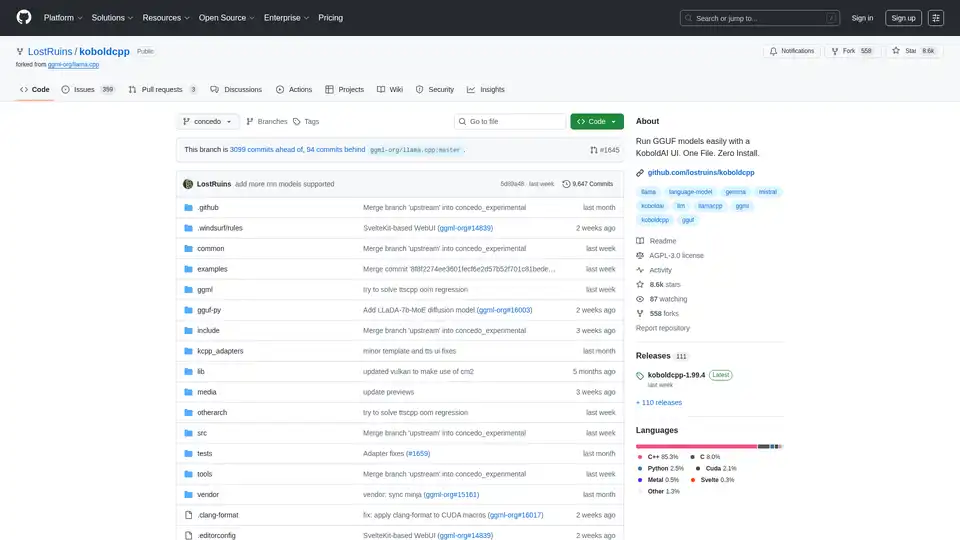

Was ist KoboldCpp? KoboldCpp ist eine vielseitige, benutzerfreundliche KI-Software, die sowohl für die Text- als auch für die Bildgenerierung entwickelt wurde. Inspiriert vom ursprünglichen KoboldAI vereinfacht es das Ausführen von GGML- und GGUF-Modellen und bietet eine einzelne, in sich geschlossene ausführbare Datei, für die keine Installation erforderlich ist.

Hauptmerkmale

- Einzelne ausführbare Datei: Keine Installation oder externe Abhängigkeiten erforderlich.

- CPU- und GPU-Unterstützung: Läuft effizient auf CPU und GPU, mit Optionen für vollständiges oder teilweises Offloading.

- LLM-Textgenerierung: Kompatibel mit allen GGML- und GGUF-Modellen, wodurch Abwärtskompatibilität gewährleistet wird.

- Bildgenerierung: Unterstützt Stable Diffusion 1.5, SDXL, SD3 und Flux für die Generierung hochwertiger Bilder.

- Sprache-zu-Text: Integriert Whisper für Spracherkennung.

- Text-zu-Sprache: Unterstützt OuteTTS, Kokoro, Parler und Dia für die Sprachgenerierung.

- API-Endpunkte: Bietet kompatible API-Endpunkte für beliebte Webdienste wie KoboldCppApi, OpenAiApi, OllamaApi und mehr.

- Gebündelte Benutzeroberfläche: Beinhaltet KoboldAI Lite UI mit Bearbeitungswerkzeugen, Speicherformaten, Speicher, Weltinformationen, Autorennotizen, Charakteren und Szenarien.

- Mehrere Modi und Themes: Bietet Chat-, Abenteuer-, Anleitungs- und Storywriter-Modi sowie verschiedene UI-Themes.

- Datenformatunterstützung: Unterstützt Tavern Character Cards, JSON-Speicherdateien und persistente Geschichten.

- Zusätzliche Funktionen: Enthält neue Sampler, Regex-Unterstützung, Websuche, RAG über TextDB und Bilderkennung/Vision.

- Plattformübergreifend: Nutzungsfertige Binärdateien für Windows, MacOS und Linux, mit Unterstützung für Colab, Docker, Android (über Termux) und Raspberry Pi.

Wie funktioniert KoboldCpp?

KoboldCpp nutzt die Leistungsfähigkeit von llama.cpp und stable-diffusion.cpp, um ein nahtloses KI-Erlebnis zu bieten. Es funktioniert, indem:

- GGML- oder GGUF-Modelle für die Textgenerierung geladen werden.

- Stable Diffusion-Modelle für die Bildgenerierung verwendet werden.

- Whisper für die Spracherkennung und verschiedene TTS-Engines für die Sprachgenerierung verwendet werden.

- API-Endpunkte für die Integration mit anderen Diensten bereitgestellt werden.

So verwenden Sie KoboldCpp

- Herunterladen: Laden Sie die neueste Koboldcpp-Datei für Ihr Betriebssystem von der offiziellen Releases-Seite herunter.

- Ausführen: Führen Sie einfach die heruntergeladene Datei aus. Es ist keine Installation erforderlich.

- Modell laden: Besorgen Sie sich ein GGUF-Modell aus Quellen wie Hugging Face. Anfänger finden möglicherweise

L3-8B-Stheno-v3.2,Tiefighter 13BoderGemma-3-27B Abliteratedgeeignet. - Verbinden: Standardmäßig können Sie über

http://localhost:5001auf KoboldCpp zugreifen.

Windows-Nutzung

- Laden Sie die Datei

koboldcpp.exeherunter. - Führen Sie die ausführbare Datei aus, um die GUI zu starten.

- Laden Sie ein GGUF-Modell und stellen Sie eine Verbindung zum lokalen Server her.

Linux-Nutzung

- Laden Sie die Binärdatei

koboldcpp-linux-x64herunter. - Machen Sie die Datei mit

chmod +x koboldcpp-linux-x64ausführbar. - Führen Sie die Binärdatei mit

./koboldcpp-linux-x64aus.

MacOS-Nutzung

- Laden Sie die MacOS-Binärdatei herunter.

- Setzen Sie die Datei mit

chmod +x koboldcpp-mac-arm64auf ausführbar. - Führen Sie die Binärdatei mit

./koboldcpp-mac-arm64aus.

Ausführen auf Colab

KoboldCpp bietet ein offizielles Colab GPU Notebook für einfache Einrichtung und Verwendung.

Ausführen auf RunPod

KoboldCpp kann auf RunPod Cloud-GPUs für skalierbare Leistung bereitgestellt werden.

Leistungsoptimierung

- GPU-Beschleunigung: Verwenden Sie die Flags

--usecuda(Nvidia) oder--usevulkan(Beliebige GPU). - GPU-Layer-Offloading: Verwenden Sie

--gpulayers, um Modell-Layer in den VRAM auszulagern. - Kontextgröße: Erhöhen Sie die Kontextgröße mit

--contextsize. - CPU-Kompatibilität: Verwenden Sie

--noavx2für ältere CPUs.

Für wen ist KoboldCpp geeignet?

KoboldCpp ist ideal für:

- KI-Enthusiasten, die eine einfache All-in-One-Lösung für die Text- und Bildgenerierung suchen.

- Entwickler, die API-Endpunkte für die Integration von KI-Funktionen in ihre Anwendungen suchen.

- Kreative, die nach Tools suchen, um ihre Storytelling-, Rollenspiel- und Content-Erstellungsprozesse zu verbessern.

Warum KoboldCpp wählen?

KoboldCpp zeichnet sich aus durch:

- Benutzerfreundlichkeit

- Umfassender Funktionsumfang

- Plattformübergreifende Kompatibilität

- Leistungsoptimierungsoptionen

Zusätzliche Ressourcen

- Modelle: Finden Sie GGUF-Textmodelle auf Hugging Face und Bildmodelle auf CivitAI.

- Dokumentation: Lesen Sie die KoboldAI API-Dokumentation für Endpunktdetails.

- Community: Treten Sie dem KoboldAI Discord-Server für Support und Diskussionen bei.

KoboldCpp vereinfacht die KI-gesteuerte Text- und Bildgenerierung und macht sie für ein breites Spektrum von Benutzern zugänglich. Egal, ob Sie Geschichten generieren, Bilder erstellen oder KI in Ihre Projekte integrieren, KoboldCpp bietet eine robuste und benutzerfreundliche Lösung. Durch die Unterstützung verschiedener Plattformen und die Bereitstellung von Optimierungsoptionen gewährleistet es ein reibungsloses und effizientes KI-Erlebnis. Erwägen Sie, KoboldCpp für Ihr nächstes KI-Projekt zu erkunden.

KI-Artikelgenerierung KI-Textveredelung KI-Schreibassistenz Papier- und Berichtserstellung Nachrichten- und Bloggenerierung E-Mail- und Geschäftskommunikation

Beste Alternativwerkzeuge zu "KoboldCpp"

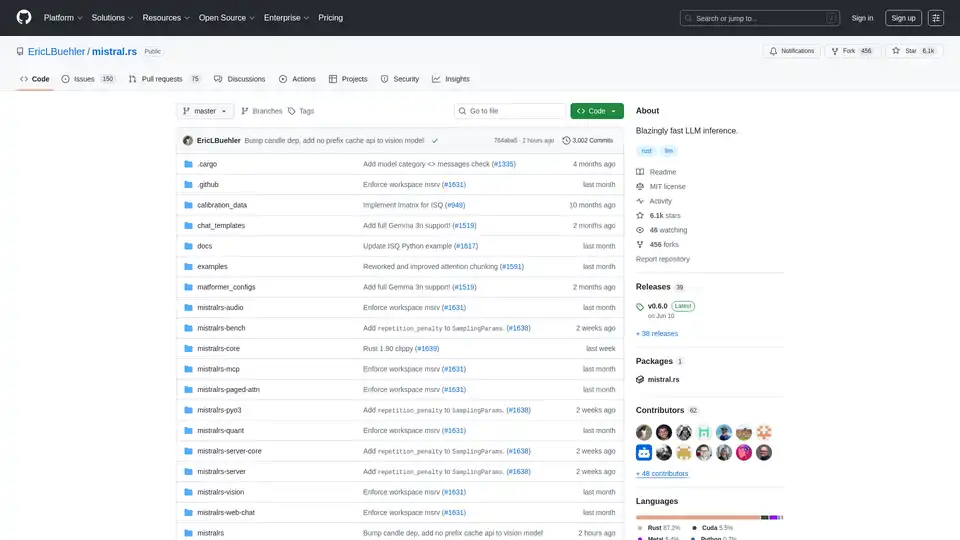

mistral.rs ist eine blitzschnelle LLM-Inferenz-Engine, geschrieben in Rust, die multimodale Workflows und Quantisierung unterstützt. Bietet Rust-, Python- und OpenAI-kompatible HTTP-Server-APIs.

Jynnt vereinfacht Ihre KI-Erfahrung mit über 100 KI-Modellen, organisierten Arbeitsbereichen und Pay-as-you-go-Preisen. Ein KI-Paradies für optimierte Innovation.

Generieren Sie sofort Grafikdesign mit dem Sivi AI Design Generator. Entwerfen Sie KI-Anzeigen, YouTube-Thumbnails, Personal Branding und mehr mit Sivi, der einzigen generativen KI für Grafikdesign.