gpt-prompt-engineer

Übersicht von gpt-prompt-engineer

Was ist gpt-prompt-engineer?

gpt-prompt-engineer ist ein Open-Source-Tool, das entwickelt wurde, um den Prozess des Prompt-Engineerings für große Sprachmodelle (LLMs) wie GPT-4, GPT-3.5-Turbo und Claude 3 zu automatisieren. Es hilft Benutzern, optimale Prompts zu entdecken, indem es mehrere Prompts basierend auf benutzerdefinierten Testfällen generiert, testet und bewertet.

Wie funktioniert gpt-prompt-engineer?

- Prompt-Generierung: Das Tool verwendet LLMs, um eine vielfältige Auswahl an Prompts basierend auf einer bereitgestellten Anwendungsfallbeschreibung und den zugehörigen Testfällen zu generieren.

- Prompt-Testen: Jeder generierte Prompt wird anhand der bereitgestellten Testfälle getestet, um seine Leistung zu bewerten.

- ELO-Bewertungssystem: Ein ELO-Bewertungssystem wird verwendet, um die Prompts basierend auf ihrer Leistung zu bewerten. Jeder Prompt beginnt mit einer anfänglichen ELO-Bewertung, und die Bewertungen werden basierend auf der Leistung des Prompts gegenüber den Testfällen angepasst. Dies ermöglicht es Benutzern, die effektivsten Prompts leicht zu identifizieren.

Hauptmerkmale von gpt-prompt-engineer

- Automatisierte Prompt-Generierung: Generiert automatisch eine Vielzahl potenzieller Prompts basierend auf einem gegebenen Anwendungsfall und Testfällen.

- Prompt-Testen und -Bewertung: Testet systematisch jeden Prompt anhand der Testfälle und bewertet sie mithilfe eines ELO-Bewertungssystems, um die effektivsten zu identifizieren.

- Claude 3 Opus Unterstützung: Eine spezialisierte Version nutzt das Claude 3 Opus Modell von Anthropic voll aus und ermöglicht die automatisierte Testfallgenerierung und mehrere Eingangsvariablen.

- Claude 3 Opus → Haiku Konvertierung: Diese Funktion ermöglicht es Benutzern, Claude 3 Opus zu nutzen, um den latenten Raum zu definieren, und Claude 3 Haiku für eine effiziente Ausgabenerstellung, wodurch Latenz und Kosten reduziert werden.

- Klassifizierungsversion: Diese Version wurde für Klassifizierungsaufgaben entwickelt und bewertet die Korrektheit eines Testfalls, indem sie ihn mit der erwarteten Ausgabe ('true' oder 'false') abgleicht und eine Tabelle mit Bewertungen für jeden Prompt bereitstellt.

- Weights & Biases Logging: Optionales Logging zu Weights & Biases für die Verfolgung von Konfigurationen, System- und Benutzerprompts, Testfällen und finalen ELO-Bewertungen.

- Portkey Integration: Bietet optionale Integration mit Portkey für die Protokollierung und Verfolgung von Prompt-Ketten und ihren Antworten.

Wie verwende ich gpt-prompt-engineer?

- Setup: Öffnen Sie das gewünschte Notebook in Google Colab oder einem lokalen Jupyter Notebook. Wählen Sie zwischen der Standardversion, der Klassifizierungsversion oder der Claude 3 Version, abhängig von Ihrem Anwendungsfall.

- API-Schlüssel-Konfiguration: Fügen Sie Ihren OpenAI API-Schlüssel oder Anthropic API-Schlüssel in der dafür vorgesehenen Zeile im Notebook hinzu.

- Definieren Sie Anwendungsfall und Testfälle: Definieren Sie für die GPT-4 Version Ihren Anwendungsfall und Ihre Testfälle. Der Anwendungsfall ist eine Beschreibung dessen, was die AI tun soll, und Testfälle sind spezifische Prompts, auf die die AI reagieren soll.

- Konfigurieren Sie Eingangsvariablen (für Claude 3 Version): Definieren Sie zusätzlich zur Anwendungsfallbeschreibung Eingangsvariablen, wobei Sie den Variablennamen und seine Beschreibung angeben.

- Generieren Sie optimale Prompts: Rufen Sie die Funktion

generate_optimal_promptmit der Anwendungsfalldescription, den Testfällen und der gewünschten Anzahl von zu generierenden Prompts auf. - Ergebnisse bewerten: Die finalen ELO-Bewertungen werden in einer Tabelle ausgegeben, sortiert in absteigender Reihenfolge. Je höher die Bewertung, desto besser der Prompt. Für die Klassifizierungsversion werden die Bewertungen für jeden Prompt in einer Tabelle ausgegeben.

Für wen ist gpt-prompt-engineer geeignet?

gpt-prompt-engineer ist ideal für:

- AI-Entwickler und Forscher, die Prompts für LLMs optimieren möchten.

- Unternehmen, die die Leistung von AI-gestützten Anwendungen verbessern möchten.

- Personen, die daran interessiert sind, Prompt-Engineering-Techniken zu erforschen.

- Alle, die die Kosten und die Latenz von LLM-basierten Anwendungen senken möchten.

Anwendungsfälle:

- Automatisieren der Generierung von Landingpage-Überschriften.

- Erstellen personalisierter E-Mail-Antworten.

- Optimieren von Prompts für die Inhaltserstellung.

- Aufbau kosteneffizienter AI-Systeme mit Claude 3 Opus und Haiku.

Warum gpt-prompt-engineer wählen?

- Zeitersparnis: Automatisiert den Prompt-Engineering-Prozess und spart so erhebliche Zeit und Mühe.

- Verbesserte Leistung: Hilft, optimale Prompts zu entdecken, die zu einer verbesserten Leistung von LLMs führen.

- Kostenreduzierung: Ermöglicht die Erstellung kosteneffizienter AI-Systeme durch die Nutzung effizienter Modelle wie Claude 3 Haiku.

- Flexibilität: Unterstützt verschiedene LLMs und Anwendungsfälle, einschließlich Klassifizierungsaufgaben.

Lizenz

gpt-prompt-engineer ist MIT-lizenziert.

Projektlink

KI-Programmierassistent Automatische Codevervollständigung KI-Code-Überprüfung und -Optimierung KI-gesteuerte Low-Code- und No-Code-Entwicklung

Beste Alternativwerkzeuge zu "gpt-prompt-engineer"

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

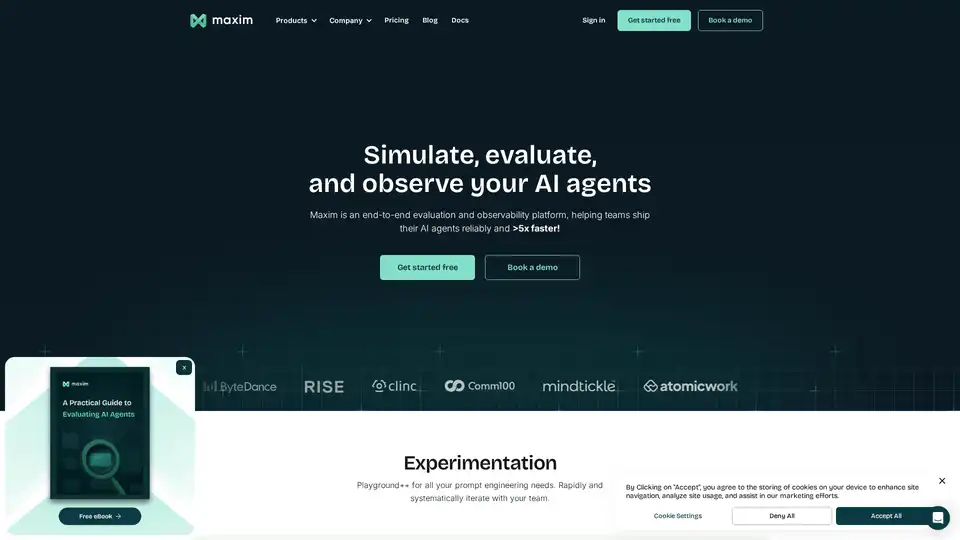

Maxim AI ist eine End-to-End-Bewertungs- und Observability-Plattform, die Teams dabei unterstützt, KI-Agenten zuverlässig und 5-mal schneller bereitzustellen, mit umfassenden Test-, Überwachungs- und Qualitätssicherungswerkzeugen.

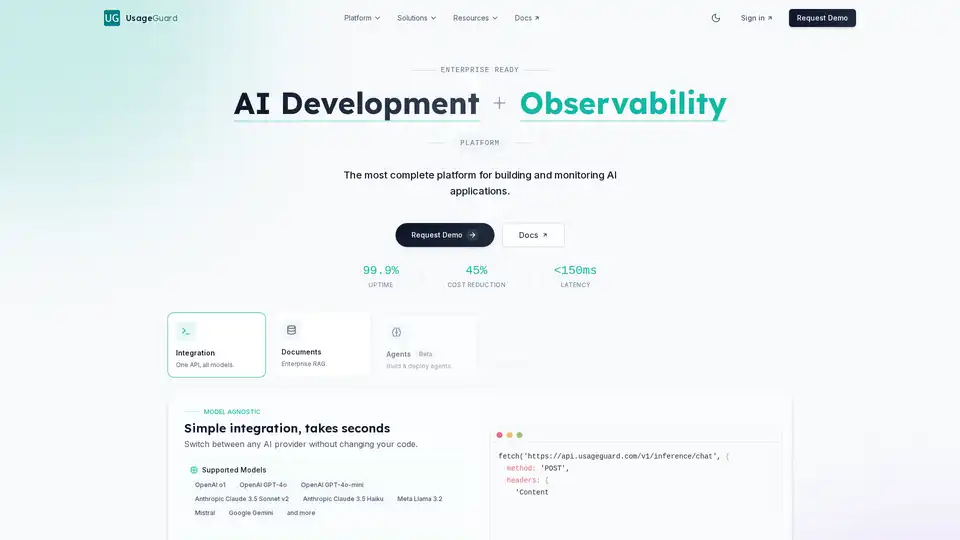

UsageGuard bietet eine einheitliche KI-Plattform für sicheren Zugriff auf LLMs von OpenAI, Anthropic und mehr, mit integrierten Schutzmaßnahmen, Kostoptimierung, Echtzeit-Überwachung und Enterprise-Sicherheit, um die KI-Entwicklung zu vereinfachen.

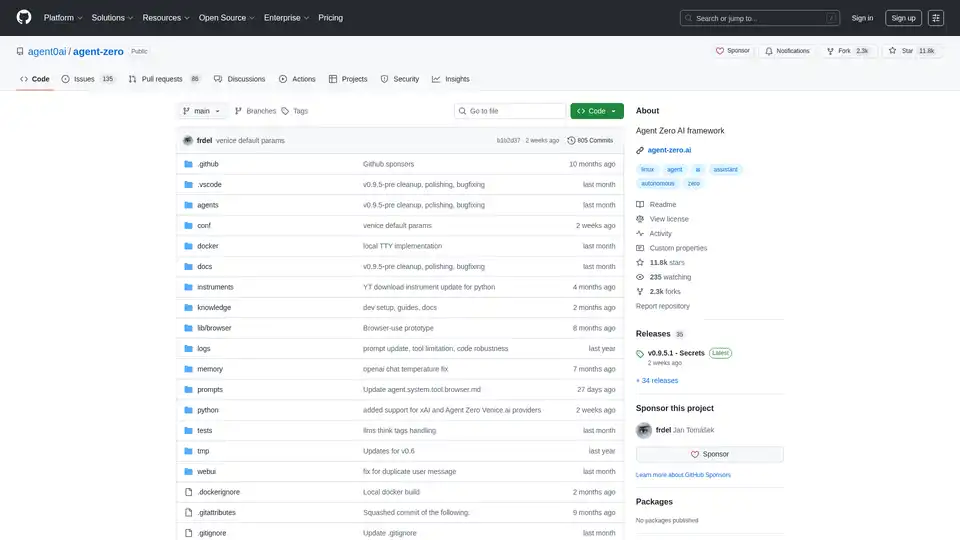

Agent Zero ist ein Open-Source-KI-Framework zum Erstellen autonomer Agenten, die organisch lernen und wachsen. Es verfügt über Multi-Agenten-Kooperation, Code-Ausführung und anpassbare Tools.